- •Основные функции различных частей головного мозга

- •Структура биологического нейрона. Взаимодействие нейронов с центральной нервной системой.

- •Формальный нейрон Мак-Каллока-Питса. Условие возбуждения формального нейрона.

- •Проблема «исключающего или». Способ решения проблемы

- •Обобщенная модель искусственного нейрона. Условие возбуждение нейрона.

- •Функция активации нейронов. Характеристика, основные типы.

- •7.Многослойные персептроны. Структура, решаемые задачи.

- •8. Обучение многослойных нейронных сетей.

- •9.Алгоритм обратного распространения

- •10.Проблемы при обучении нейронной сети

- •11.Задачи аппроксимации функции

- •12. Радиально-базисные сети. Структура, обучение.

- •13. Сеть Хопфилда. Структурирование устойчивости.

- •Область применения:

- •14.Нейронная сеть Кохонена.

- •15.Рекурентные нейронные сети

- •16.Построение нечеткой нейронной сети

- •Нейронные сети в задачах идентификации динамических объектов.

- •Преимущества нейроуправления. Структурные схемы нейросетевых сау.

- •Общая характеристика процедуры проектирования сау.

- •Реализация и применение нейронных сетей на практике.

9.Алгоритм обратного распространения

Особенность-обучение (подстройка весов) ведется послойно начиная с последнего слоя к первому.

1.

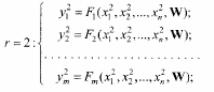

2. для

последнего слоя

для

последнего слоя

3.

4.

Особенность-сложность

определения

.

.

Другие методы:

-модифицированный метод

,

,

инерция

инерция

приращение на каждом шаге с учетом знаний, высчитанных на предыдущих шагах обучения

-быстрый алгоритм обратного распространения

-метод сопряженных градиентов

-обучения на основе Δ-правил

10.Проблемы при обучении нейронной сети

В случае когда КН (количество неизвестных) много больше КУ (количество уравнений), т.е. сеть избыточна сложна возникает эффект переобучения когда в узлах интерполяции погрешность низкая, а в промежутках высокая.

11.Задачи аппроксимации функции

НС часто называют аппроксиматорами. В 1989г. Несколько авторов одновременно доказали что любую непрерывную функцию трех переменных любой степени точности можно реализовать с помощью трехслойной сети, имеющую достаточное кол-во нейронов в скрытом слое.

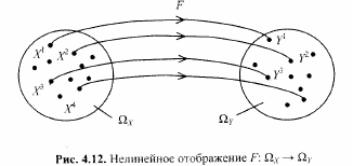

Y=F(X)

Кол-во уравнений(КУ)=R*m

Кол-во неизвестных(КН)=n*n2+n2*m

КУ=< КН ; R<= n*n2+n2*m= n2(n+m)

n2= (R*m)/ (n+m)

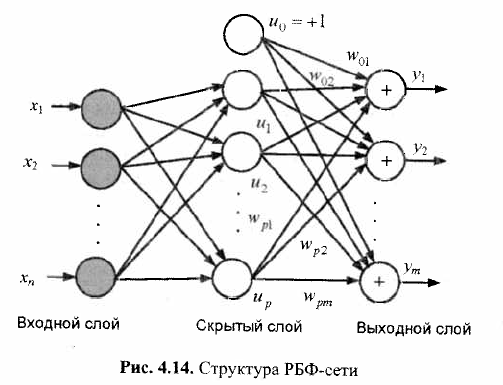

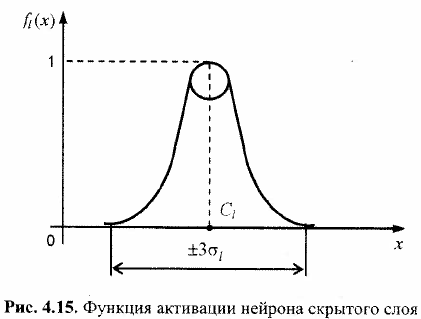

12. Радиально-базисные сети. Структура, обучение.

относятся к многослойным НС прямого распространения; они – универсальные аппроксиматоры, т.е. с их помощью можно сколь угодно точно аппроксимировать любую непрерывную функцию нескольких переменных.

Архитектура РБФ-сети влючает в себя три слоя нейронов. Первый (входной) слой выполняет распределительные функции. Второй (скрытый) слой осуществляет фиксирование нелинейное преобразование вектора входов X=(x1,x2,…,xn)T в новое пространство U=(u1,u2,…,up)T без использования настраиваемых весовых коэффициентов. Выходной сигнал объединяет полученные таким образом выходы нейронов скрытого слоя путем вычисления их линейной взвешенной комбинации.

Выходы

описываются уравнениями

где

X=(x1,x2,…,xn)T

- входной

вектор;

- веса связей, (l=1,2,…p,

i=1,2,…m);

- веса связей, (l=1,2,…p,

i=1,2,…m);

-

смещение по i-му

выходу сети. Функции

-

смещение по i-му

выходу сети. Функции

- это функции активации нейронов скрытого

слоя, определяемые как

- это функции активации нейронов скрытого

слоя, определяемые как

где

где

- норма вектора

- норма вектора

;

;

-

l-й

вектор-эталон, задаваемый в качестве

«центра» l-й

области входных образов

-

l-й

вектор-эталон, задаваемый в качестве

«центра» l-й

области входных образов

- радиальная базисная функция (

- радиальная базисная функция ( )

принимающая максимальное значение при

нулевом значении аргумента и быстро

убывающая при

)

принимающая максимальное значение при

нулевом значении аргумента и быстро

убывающая при

Вид

функции

для l-го

нейрона скрытого слоя:

для l-го

нейрона скрытого слоя:

Поскольку

настраиваемые параметры сети линейно

связаны с выходами

,

то они могут быть найдены методом

наименьших квадратов. При этом

минимизируется суммарная квадратичная

ошибка сети

,

то они могут быть найдены методом

наименьших квадратов. При этом

минимизируется суммарная квадратичная

ошибка сети

,

приходим к системе (p+1)m

линейных уравнений

,

приходим к системе (p+1)m

линейных уравнений

При

малом числе входов ( )

радиально-базисные сети обладают

очевидными преимуществами над

многослойными нейронными сетями,

обеспечивая высокую точность аппроксимации

любой непрерывной вектор-функции Y=F(X)

(исп-ся для решения задач идентификации

и управления). В то же время для больших

значений n

число требуемых базисных функций резко

возрастает, необходимо тщательно

выбирать расположение центров Сl

базисных функций, что требует знания

априорной информации о величине (уровнях)

входных сигналов.

)

радиально-базисные сети обладают

очевидными преимуществами над

многослойными нейронными сетями,

обеспечивая высокую точность аппроксимации

любой непрерывной вектор-функции Y=F(X)

(исп-ся для решения задач идентификации

и управления). В то же время для больших

значений n

число требуемых базисных функций резко

возрастает, необходимо тщательно

выбирать расположение центров Сl

базисных функций, что требует знания

априорной информации о величине (уровнях)

входных сигналов.