- •Введение.

- •История развития, исследования в области ии.

- •Математические основы нл.

- •Выбор функции принадлежности:

- •Нечеткие алгоритмы.

- •Методы нечеткого логического вывода.

- •Методы дефаззификации

- •Методология проектирования экспертных систем.

- •Обобщенная структура основных этапов разработки прототипов эс.

- •Некоторые сведения о мозге.

- •Модель искусственного нейрона.

- •Определение искусственной нейронной сети.

- •Модели нс.

- •Понятие обучения.

- •Процедура обучения.

- •Классификация нейронных сетей

- •Типовые структуры и решаемые задачи

- •Сети Кохонэна Обучение «без учителя»

- •4.1. Традиционный способ

- •4.2. Метод выпуклой комбинации

- •4.3. Модифицированные алгоритмы

- •Основные этапы нейросетевого анализа

- •Генетические алгоритмы

- •Гибридные интеллектуальные системы

4.1. Традиционный способ

Корректируются только веса нейрона-победителя по следующему правилу:

![]()

Где

![]() -

желаемый, а

-

желаемый, а

![]() -

фактический.

-

фактический.

![]() -

определяет скорость обучения.

-

определяет скорость обучения.

Довольно

распространено обучение с “расписанием”,

где

![]() является

функцией от времени и является монотонно

убывающей.

является

функцией от времени и является монотонно

убывающей.

Эффект, получаемый в результате: веса корректируются таким образом, что вектор весов постепенно приближается к входному вектору. Сначала с большой скоростью, потом медленнее и останавливается тогда, когда веса перестают изменяться.

![]()

![]()

Лекция 9.

4.2. Метод выпуклой комбинации

Правильно распределить плотность ядер в соответствии с плотностью входных векторов в n- мерном пространстве признаков.

Шаг 1: всем весам нейронов(координаты ядер кластеров) присваиваются одинаковые начальные значения

![]()

Шаг 2:

обучение производится модифицированными

обучающими векторами

![]() .

Модификация каждого вектора производится

по формуле:

.

Модификация каждого вектора производится

по формуле:

![]()

![]()

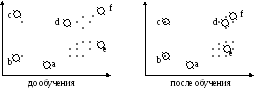

Геометрическая интерпретация первого и второго подходов обучения:

4.1 Традиционный способ

Недостатки:

Существуют нейроны, которые никогда не побеждают

Для группы, в которой существует большое количество объектов,

желательно инициировать несколько ядер кластеров, чтобы внести какие-либо различия в эту группу.

4.2. Метод выпуклой комбинации

Достоинства:

не остается необученных векторов

плотность векторов ядер-кластеров соответствует плотности векторов

обучающего множества.

Недостатки:

Длительность времени обучения увеличена

4.3. Модифицированные алгоритмы

Чувство справедливости:

Его идея: в случае, если какой-либо нейрон побеждает чаще некоторого порога m, значение его на выходе искусственно уменьшают для того, чтобы дать выиграть другим нейронам.

Применяется при построении самоорганизующихся карт Кохонэна.

Корректируются веса не только выигравшего нейрона, но и всех остальных, пропорционально их нормированному выходу.

Алгоритм обучения Хобба(без учителя)

Сущность: если нейроны с обеих сторон синопсиса возбуждаются одновременно и регулярно, то сила этой синоптической связи возрастает.

Алгоритм:

Шаг 1: инициализация случайными малыми значениями.

Шаг 2:

подается на вход текущий вектор

![]()

Шаг 3:

![]()

шаги 2,3 повторяются в цикле до стабилизации весов.

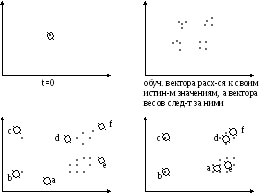

Самоорганизующиеся карты на основе сети Кохонэна

Self-organizing maps (SOM)

Это самоорганизующиеся структуры, основанные на нейросетях Кохонэна, которые представлены в виде двумерной сетки, в узлах которой находятся нейроны.

Карты имеют следующие особенности обучения:

все нейроны будто бы взаимодействуют друг с другом. Величина

взаимодействия определяется расстоянием между нейронами на карте, которое учитывается в алгоритме обучения.

модифицируются при обучении не только веса нейрона- победителя,

но и его соседей.

Для этого выбирается некоторый радиус R, и все соседи нейрона- победителя, попавшие в окружность этого радиуса тоже корректируются, но в меньшей степени.

Сам радиус на первых итерациях обучения очень большой, но со временем уменьшается до нуля. Чем ближе конец обучения, тем точнее определяются нейроны, отвечающие каждому классу образов.

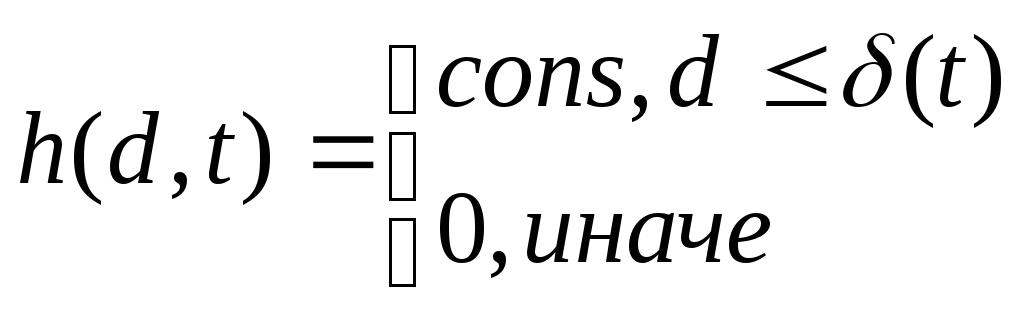

Формула модификации весов:

![]()

![]()

![]() -

функция соседства(невозрастающая

функция времени), разбивается на 2 части:

-

функция соседства(невозрастающая

функция времени), разбивается на 2 части:

собственно функция расстояния.

Функция скорости обучения во времени

![]()

Где d- расстояние между текущим объектом, поданным на вход и нейроном- победителем.

![]() убывающая функция

времени, называемая радиусом обучения

убывающая функция

времени, называемая радиусом обучения

Построение карт

Карт строится столько, сколько признаков(m). Каждая карта имеет определенную раскраску, которая соответствует значениям соответствующего признака объекта. Положение объектов на каждой карте строго фиксировано.

Лекция 10.