- •Введение.

- •История развития, исследования в области ии.

- •Математические основы нл.

- •Выбор функции принадлежности:

- •Нечеткие алгоритмы.

- •Методы нечеткого логического вывода.

- •Методы дефаззификации

- •Методология проектирования экспертных систем.

- •Обобщенная структура основных этапов разработки прототипов эс.

- •Некоторые сведения о мозге.

- •Модель искусственного нейрона.

- •Определение искусственной нейронной сети.

- •Модели нс.

- •Понятие обучения.

- •Процедура обучения.

- •Классификация нейронных сетей

- •Типовые структуры и решаемые задачи

- •Сети Кохонэна Обучение «без учителя»

- •4.1. Традиционный способ

- •4.2. Метод выпуклой комбинации

- •4.3. Модифицированные алгоритмы

- •Основные этапы нейросетевого анализа

- •Генетические алгоритмы

- •Гибридные интеллектуальные системы

Определение искусственной нейронной сети.

Определение:

Искусственная нейронная сеть – множество нейронов соединенных между собой т.о., что: 1) ряд нейронов отмечены, как входные, а некоторые другие как выходные, 2) активационные функции считаются неизменными в работе сети, а веса являются параметрами сети и корректируются.

Смысл работы НС заключается в преобразовании некоторого входного вектора Х в выходной Y требуемый. Причем преобразования регулируется путем корректировки весов.

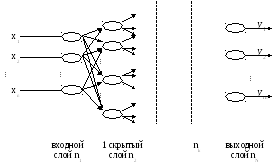

Модели нс.

1. Однослойный персептрон Розенблата

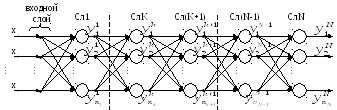

2. Многослойный персептрон

Ujk – выходные сигналы k-го слоя.

Понятие обучения.

Под обучением понимается целенаправленное изменение (подстройка) весовых коэффициентов синаптических связей НС из условий достижения требуемых характеристик сети, т.е. желаемая реакция на входные воздействия.

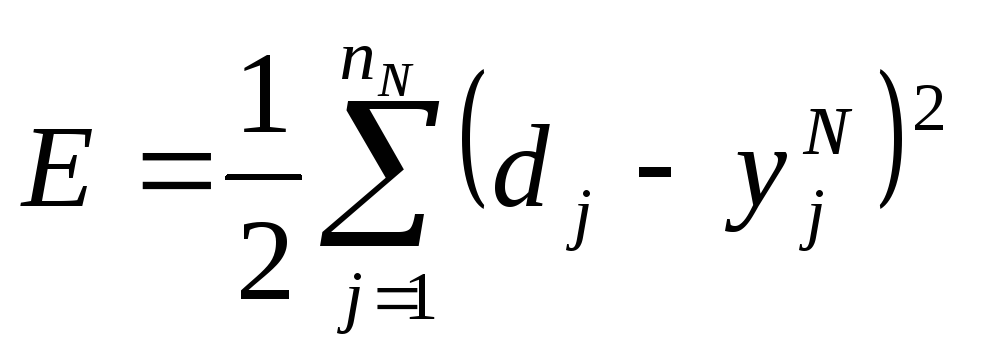

Базовый принцип обучения – это минимизация эмпирической ошибки между желаемым выходом сети и фактической реакцией сети.

Процедура обучения.

1. Создание обучающих выборок (задачник)

Ω = {<x1, D1>, < x2, D2>, …, < xR, DR>}

x – вектор входов;

D – вектор эталонов (желаемых выходов).

2. Осуществляется выбор очередной пары из задачника (xi, Di).

3. Подается xi на вход нейросети.

4. Вычисляется разница между желаемым и фактическим выходом сети:

ε = Di - Yiфакт

5. Производится корректировка Δωijk = f(ε) c тем чтобы ε минимизировать.

6. Шаги 2 – 5 повторяются многократно до тех пор, пока ошибка ε не станет равна некоторой допустимой величине ошибки. В этом случае сеть называется натренированной, и теперь обученная сеть имеет возможность дать правильный ответ при подаче на вход нового вектора х, которого не было ранее в обучающей выборке. Эта способность соответствует свойству обобщения НС.

Лекция 7.

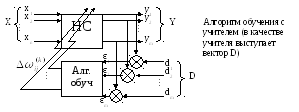

Схема, иллюстрирующая процесс обучения нейросети:

Алгоритм обратного распространения ошибки.

(error back propagation algorithm)

Процедура реализации:

выбор пары

из обучающей выборки

из обучающей выборкиподача X на вход сети Y

считаем ошибку в виде суммарной средней квадратичной ошибки

(1)

(1)

Этот алгоритм реализуется для многослойного персептрона

E

Решаем задачу оптимизации(через градиентный спуск)

![]()

![]()

E=f(y(S(

)))

)))

![]()

Где

![]() количество нейроновk-го

слоя

количество нейроновk-го

слоя

определим ………….для выходного слоя

Классы задач, решаемых нейросетями:

Задача распознавания образов (задача классификации)

Задача кластеризации

Примечание: в нейросетевом базисе используется для сжатия данных, анализа данных, поиска закономерностей

Аппроксимация функций

Постановка задачи:

Формируется набор

экспериментальных данных![]() .

.

![]()

Требуется найти функцию, аппроксимирующую некоторую неизвестную функцию и удовлетворяющую некоторым критериям

Предсказание(прогнозирование)

Дается временной

ряд:![]()

Требуется предсказать

значение у в момент времени (![]() )

)

Оптимизация

Применяется в задачах, поиск решений в которых очень большой