- •Ответы на зачет по из (Питолин)

- •1. Классы задач, решаемые искусственными нейронными сетями

- •2. Биологический нейрон как прототип искусственного нейрона

- •3. Математическая модель искусственного нейрона

- •4. Функция активации. Сигмоидальная функция активации.

- •5. Основные этапы нейросетевого анализа

- •6. Топологии инс

- •7. Многослойные сети. Классификация многослойных инс

- •8. Классификация инс по различным признакам.

- •9 Математическая постановка нейросетевого анализа данных

- •10 Оценка количества нейронов в скрытых слоях инс. Теорема о полотне.

- •11. Общая схема процесса обучения инс.

- •15. Алгоритм обратного распространения ошибки. Общее описание.

- •16. Математическое описание алгоритма обратного распространения ошибки для однослойной сети.

- •17. Математическое описание алгоритма обратного распространения ошибки для двухслойной сети.

- •18. Особенности функционирования алгоритма обратного распространения ошибки.

- •19. Геометрическая интерпретация алгоритма обратного распространения ошибки.

- •20. Переобучение и обобщение.

- •21. Обучение без учителя. Алгоритм Хебба.

- •22. Обучение без учителя. Алгоритм обучения Кохонена.

- •23. Геометрическая интерпретация алгоритма обучения Кохонена.

- •24. Персептроны

- •25. Проблема «исключающее или» и пути ее решения

- •26. Инс встречного распространения. Функционирование сети.

- •27. Инс встречного распространения. Обучение сети.

- •28. Инс Хопфилда.

- •29. Инс Хемминга.

- •30. Классификация и сравнительный анализ пакетов прикладных программ нейросетевого моделирования

- •31. Общие принципы построения нейрокомпьютеров

- •32. Элементная база нейровычислений

16. Математическое описание алгоритма обратного распространения ошибки для однослойной сети.

![]() Выход

(output) сети o=f(net)

определяется функцией активации

сигмоидного типа

Выход

(output) сети o=f(net)

определяется функцией активации

сигмоидного типа

![]() где

xт

= (x1,…xn)

— вектор входных сигналов, wT

= (w1,…wn)

— вектор весов сети, «Т» - символ

транспонирования.

где

xт

= (x1,…xn)

— вектор входных сигналов, wT

= (w1,…wn)

— вектор весов сети, «Т» - символ

транспонирования.

Предположим, что для обучения сети используется выборка

![]()

где уk - значения желаемого (целевого) выхода.

В качестве функции ошибки для k-то образца (k-го элемента обучающей выборки) примем величину, пропорциональную квадрату разности желаемого выхода и выхода сети:

![]()

Соответственно, суммарная функция ошибки по всем элементам выборки:

Ek, и E являются функциями вектора весов сети w. Задача обучения сети сводится в данном случае к подбору такого вектора w, при котором достигается минимум Е. Данную задачу (оптимизации) будем решать градиентным методом, используя соотношение

![]() где

«:=» - оператор присвоения, Ek’-

обозначение вектора-градиента,

где

«:=» - оператор присвоения, Ek’-

обозначение вектора-градиента,

- некоторая константа.

Представляя данный вектор в развернутом виде и учитывая выражение для производной сигмоидной функции, получим:

![]()

Это дает возможность записать алгоритм коррекции вектора весовых коэффициентов сети в форме

![]()

где

![]()

Полученные математические выражения полностью определяют алгоритм обучения рассматриваемой ИНС, который может быть представлен теперь в следующем виде.

1. Задаются некоторые (0 < < 1), Emax и некоторые малые случайные веса wi сети.

2. Задаются k = 1 и Е = 0.

3. Вводится очередная обучающая пара (xk, yk). Производятся обозначения

![]() и

вычисляется величина выхода сети:

и

вычисляется величина выхода сети:

![]()

4. Обновляются (корректируются)веса:

![]()

5. Корректируется (наращивается) значение функции ошибки:

![]()

6. Если k < N, тогда k:=k+1 и переход к шагу 3, в противоположном случае - переход на шаг 7.

7. Завершение цикла обучения. Если Е < Еmах, то окончание всей процедуры обучения. Если Е Еmах тогда начинается новый цикл обучения переходом к шагу 2.

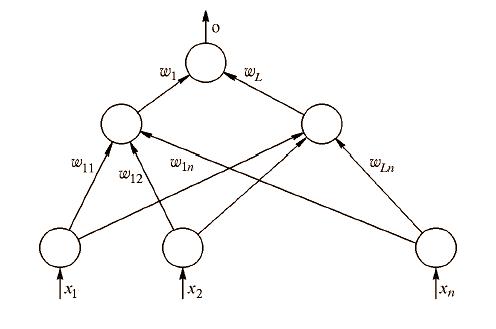

17. Математическое описание алгоритма обратного распространения ошибки для двухслойной сети.

В данном случае функция ошибки зависит от векторов весов скрытого слоя и вектора весов, связанных с выходным нейроном. Выход сети описывается выражением

![]() где

W

- вектор весов выходного нейрона, ok

- вектор выходов нейронов скрытого слоя

с элементами

где

W

- вектор весов выходного нейрона, ok

- вектор выходов нейронов скрытого слоя

с элементами

![]() wi

- обозначает вектор весов, связанных с

i-м

скрытым нейроном.

wi

- обозначает вектор весов, связанных с

i-м

скрытым нейроном.

Правило корректировки весов в рассматриваемой ИНС также основано на минимизации квадратичной функции ошибки градиентным методом на основе выражений:

![]()

где = const - коэффициент скорости обучения (0 < < 1),

Используя правило дифференцирования сложной функции и выражение для производной сигмоидной функции активации, получим:

![]()

![]()

![]()

или в скалярной форме

![]() где

где![]()

Аналогичным образом найдем

![]()

![]()

или в скалярной форме

![]()

Алгоритм обучения может быть представлен в виде следующих шагов.

1. Задаются некоторые (0 < < 1), Еmах и некоторые малые случайные веса wi сети.

2. Задаются k = 1 и Е=0.

3. Вводится очередная обучающая пара (xk, yk). Производятся обозначения

![]() и

вычисляется величина выхода сети:

и

вычисляется величина выхода сети:![]()

где W — вектор весов выходного нейрона, оk – вектор нейронов скрытого слоя с элементами

![]()

wi, - обозначает вектор весов, связанных с i-м скрытым нейроном.

4. Производится корректировка весов выходного нейрона:

![]() где

где

![]()

5. Корректируются веса нейронов скрытого слоя:

![]()

6. Корректируется значение функции ошибки:

![]()

Если k < N, тогда k:= k + 1 и переход к шагу 3, в противоположном случае переход на шаг 8.

7. Завершение цикла обучения. Если Е < Еmах, то окончание всей процедуры обучения. Если Е Еmах, тогда начинается новый цикл обучения переходом к шагу 2.