- •Информационная структура изображения. Основные информационные характеристики

- •Принципы оценки шумов на выходе нескольких преобразовательных звеньев

- •2.1.3. Шумы на выходе диафрагмирующих звеньев и сторонние шумы

- •Изменение отношения сигнал/шум в звене линзового преобразования изображения

- •Шумы и отношение сигнал/шум в звене с фотографическим преобразованием

- •Пространственно-временные модуляторы света

- •Прохождение сигнала и шума через пвмс на базе структуры «фотопроводник – жидкий кристалл»

Информационная структура изображения

Понятие информации применительно к оптике

В настоящее время информационные оценки получили широкое распространение, в том числе и при рассмотрении оптических систем и устройств. Так, записывающие материалы для систем памяти, включая оптические и голографические системы, иногда сравниваются между собой по числу бит информации на квадратный сантиметр [1-3], которые могут быть записаны на данном материале. Формируя изображение и оперируя с ним в дальнейшем, мы фактически производим различные операции по передаче и использованию информации об оптических свойствах объекта. Количественная и качественная оценки способности системы передавать информацию об объекте являются определяющими при принятии решения о целесообразности использования этой системы для решения определенной задачи.

В связи с этим важную роль играет информационная структура изображения, тесно связанная с его оптической структурой. Для того, чтобы иметь возможность в дальнейшем оценивать особенности изображающих систем информационными характеристиками, обратимся к тем понятиям теории информации, которые понадобятся для описания светоинформационных систем, т.е., систем, в которых информация хотя бы на некоторых участках передается, хранится или обрабатывается в световой форме.

Впервые основные положения теории информации были разработаны применительно к теории связи, в которой важную роль играют статистические закономерности, а сигнал меняется только во времени. Для оценки работы линии связи Шенноном [4] была предложена мера неопределенности передачи сообщений. Получение информации о некотором предмете или событии может быть представлено в виде опыта, который может иметь m исходов, причем вероятности появления каждого из m исходов равны соответственно p1, р2, p3....рm. Характеристика неопределенности, имевшей место до проведения опыта, может быть дана с помощью величины

m

H = - рi log pi (1)

i=1

Эту величину, по аналитическому представлению совпадающую с термодинамической энтропией в статистической физике Шеннон назвал энтропией совокупности р1, р2, р3 ...рm и положил в основу количественного определения информации. Она может быть использована для характеристики получения информации в результате осуществления некоторого опыта, вне зависимости от его природы, если только этот опыт имеет т исходов, причем вероятности появления каждого из них равны соответственно р1, р2, р3 ...рm.

Если в результате проведения опыта уменьшается неопределенность исхода при выборе события из набора событий, то результатом этого опыта является получение некоторого количества информации и уменьшение энтропии. Оценим значение энтропии до начала опыта и после его окончания. Пусть Hapr (априорная энтропия) – исходная мера неопределенности (до опыта), а Haps (апостериорная энтропия) – мера неопределенности, оставшаяся после опыта. В таком случае количество информации, полученное в результате опыта, определяется разностью априорной и апостериорной энтропии

I = Hapr – Haps. (2)

Процесс получения информации об объекте, осуществляемый светоинформационной системой, также может быть представлен опытом с некоторой исходной неопределенностью выбора входного изображения, т.е., с априорной энтропией Hapr. Это значит, что мы знаем до опыта об объекте только то, что он может быть одним из серии т1 объектов, с вероятностью появления каждого из них р1, р2, р3 ...рm. Если с помощью светоинформационной системы мы точно установили, какой именно объект был на входе этой системы, то неопределенность после опыта сводится к нулю. Следовательно, получена вся возможная информация об объекте, которая в данном случае равна I = Hapr.

Возможен и случай, когда система окажется неспособной из серии т1 объектов различить т2 объектов (m2 < m1). Тогда результатом опыта является то, что система устанавливает, что исходным не является ни один из т1 – т2 объектов. После опыта сохраняется некоторая неопределенность, но она уменьшается на величину полученной информации.

Если учесть, что вероятности, соответствующие каждому из неразличимых объектов серии т2 равны q1, q2, ..., qm2, то величина апостериорной энтропии

m2

Haps = qj log2qj, (3)

j=1

тогда как количество полученной информации, полученной об объекте в результате действия системы

m1 m2

I = qj log2qj - qj log2qj. (4)

j=1 j=1

Если Нaps = 0, то система передала всю возможную информацию, и, напротив, чем больше Haps, тем менее пригодна система для выполнения поставленной задачи. Но задача тем сложнее, чем больше исходная неопределенность объекта, описываемая величиной Нapr. Таким образом, разность априорной и апостериорной энтропии, или, принимая во внимание соотношение (2), количество передаваемой информации об объекте, характеризует эффективность системы.

Информационная структура изображения. Основные информационные характеристики

Процесс получения информации об объекте, осуществляемый оптической информационной системой (например, ГЗУ), также может быть представлен опытом с некоторой исходной неопределенностью выбора входного изображения, т.е. с априорной энтропией Hapr. Если в выражении для энтропии принять, что вероятности получения каждого j -того уровня отклика на воздействие света равны (р0= р1= р2= ....рm= 1/(m+1)), то для передачи одного элемента изображения можно получить

m

I = pi log2 pi = (m + 1)[1/(m+1)]log2(m+1) = log2(m + 1), (5)

j=1

где m - число различимых градаций (число уровней сверх нулевого).

При наличии только одного уровня, кроме нулевого, мы имеем одну единицу информации, т.е. бит. В том случае, если изображение состоит из многих элементов N, пространственных или спектральных, то при статистической независимости каждого элемента (когда отсутствует корреляция между любой парой элементов изображения),

I = N log2 (m+ 1). (6)

Светоинформационная система включает в себя световое поле между объектом и получателем (или преобразователем света), которое может рассматриваться как набор каналов, по которому информация проходит от объекта к получателю. Эта система может быть описана определенными информационными характеристиками, которые для минимизации потерь информации должны быть согласованы с информационными характеристиками объекта.

Характеристикой, определяющей потенциальные возможности транспортировки информации через систему, является информационная пропускная способность, которая описывает максимально возможный поток информации через систему. Эта величина измеряется в битах в секунду.

Для характеристики способности системы запасать информацию используют такую величину, как информационная емкость системы либо ее какого-либо узла. Она численно равна максимальному количеству информации, которую система одновременно может содержать, и измеряется в битах. Эта характеристика может быть в общем случае описана формулой (6).

Эти величины не всегда однозначно определяют информационные возможности системы [5, 6]. Иногда информация бывает подана на вход системы в такой форме, что система не может вместить весь ее объем, несмотря на то, что информационная емкость системы (по числу бит) позволяет это сделать. В этом случае требуются дополнительные преобразования информации по приведению ее в такую форму, чтобы она компактно укладывалась целиком в информационную емкость системы.

Большое значение имеют связанные с информационной емкостью и информационной пропускной способностью [7] информационные параметры, характеризующие потенциальную плотность сохраняемой или пропускаемой информации. Удельной информационной емкостью, для двухмерной системы, будет являться величина I’ = I / S, где S - площадь записывающего материала в системе. Определенные выше информационные параметры записывающих материалов относятся к аналоговой форме записи и передачи информации. При записи и передаче информации, выраженной в цифровой форме, на каждый бинарный элемент приходится только один отличный от нуля уровень (m=1), (здесь log2(m+1) = 1). Соответственно, информационная емкость численно будет равна числу независимых элементов записи, а пропускная способность - числу пропускаемых в единицу времени данных записи на каждом элементе.

К информационным параметрам также относятся величины, характеризующие энергетические затраты, приходящиеся на запись единицы информации - информационную чувствительность. Информационная чувствительность Gинф представляет собой величину, обратную энергии WI, которую необходимо подать на вход записывающего материала, чтобы получить заданный объем информации I, например, определяемый числом элементов N и число различимых в шумах градаций

Gинф = 1 / WI. (7)

Отметим, что объем воспроизводимой информации не пропорционален затрачиваемой энергии. На одно и то же увеличение информационной емкости требуется каждый раз все большее увеличение затрачиваемой энергии. Поэтому различной оказывается удельная информационная чувствительность

= I / W, (8)

где W - входная энергия, - величина, обратная энергии, приходящейся на единицу информации при заданном объеме информации I. Эта величина выражается в битах на джоуль. Так как поступающая световая энергия может быть выражена числом квантов, то можно использовать такой параметр, как квантовая информационная чувствительность

= I / n, (9)

определяющий величину, обратную числу квантов n, приходящихся на единицу информации (квант на бит).

Информационные процессы в цифровых оптических системах характеризуются несколько иными параметрами, чем в случае аналоговых систем. При достаточно высоком отношении сигнал/шум информационная емкость такой системы определяется числом восстановленных точек со значением сигнала, равным 1 или 0. Например, если изображение представляет собой страницу текста, состоящую из Z строк, с числом знаков р в строке и числом q точек, необходимых для записи одного знака, то при передаче одной страницы приходится Ip = Zpq бит информации. При записи Np страниц на одну пластину общий объем информации возрастает до I = NpZpq . При передаче полутоновых изображений объем информации увеличится на множитель log2(m +1). Оценку объема передаваемой информации, и ее потерь можно, поэтому, начинать с рассмотрения числа элементов (точек, пикселов) и полутонов (градаций) в системе, в том числе голографической.

Прохождение сигнала и шумов через элементарный канал в многозвенной оптической системе

Изменение сигнала и шумов в элементарном канале при прохождении последовательности звеньев системы

Светоинформационную систему можно себе представить как последовательность звеньев с различной физической природой переносчика информации. При этом каждому звену соответствует определенное физическое преобразование сигнала. Часто сигнал на входе и на выходе звена может быть представлен в виде безразмерной величины с некоторым коэффициентом пропорциональности, отражающей энергию носителя информации [155]. При этом сигнал может исчисляться в количестве дискретных физических объектов, относящихся к элементарному каналу передачи информации, в частности, оптический сигнал – в числе фотонов, а электронный сигнал – в числе электронов. Если число таких частиц – переносчиков информации равно , то сигнал можно приравнять этому числу, а энергия, переносимая носителями информации, определяется для случая оптического сигнала как

W = h

В идеальном случае сигнал и шум на входе системы, если шумы имеют чисто квантовую природу, могут быть определены как

Sшвх = Sвх1/2, (11)

а отношение сигнал/шум

Sвх1/2. (12)

Для удобства анализа можно ввести еще два фактора. Коэффициент неидеальности элементарного канала системы может быть определен как

J = Sвх/вых. (13)

Физический смысл этого коэффициента состоит в том, что он определяет, во сколько раз необходимо увеличит сигнал в реальной системе, чтобы получить то же отношение сигнал/шум на выходе, что и в идеальной системе.

Другой фактор, который удобно ввести, характеризует уменьшение отношения сигнал/шум от входа к выходу

вых/вх. (14)

В случае идеальной системы этот коэффициент всегда равен единице, а для реальных систем он меньше единицы. Два введенных выше фактора связаны между собой соотношением

J = 1/2. (15)

Качество элементарного канала реальной системы определяется его степенью приближения к каналу идеальной системы. Оно тем лучше, чем выше и чем меньше J.

Отношение сигнал/шум определяет вероятность различения единицы информации. Если такая вероятность задана, то отношение сигнал/шум фактически определяет объем передаваемой информации в системе наряду с другими ее характеристиками. Поэтому с точки зрения выявления возможности информационной оптимизации системы важно проследить, как меняются сигнал и шум при их прохождении через элементарный канал системы.

Говоря об изменении отношения сигнал/шум при прохождении через систему, отметим одну особенность сигнала. В связи с рассеянием энергии носителя сигнал при пассивном прохождении через звенья системы постоянно ослабляется, и причиной уменьшения отношения сигнал/шум часто является не только рост шумов в системе, но и уменьшение величины сигнала. Однако в действительности этого может и не происходить в связи с постоянным введением энергии в различные звенья системы. При этом вводимая энергия, как правило, не связана с исходной информацией, но позволяет преобразовывать и усиливать сигнал, несущий эту информацию и тем самым способствовать уменьшению потерь информации.

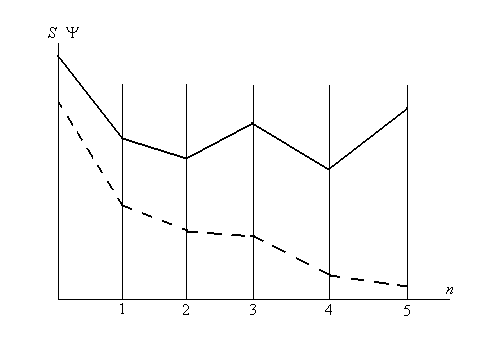

Таким образом, в некоторых звеньях сигнал может существенно возрастать, чередуясь с потерями сигнала в пассивных звеньях или в звеньях с недостаточным количеством вновь вводимой энергии. Изменение сигнала и шума иллюстрируется примером, приведенным на рис. 1, на котором график сигнала для примерной системы построен по числу дискретных частиц, несущих сигнал. Сплошной линией показано изменение сигнала от звена к звену, а прерывистой – отношения сигнал/шум.

Рис. 1. Изменение величины сигнала и отношения сигнал/шум от звена к звену системы

Из графика видно, что сигнал может как возрастать, так и уменьшаться в пределах звена, но отношение сигнал/шум возрастать не может.

Сигнал в каждом звене может изменяться двумя способами. Один из них заключается в том, что исходный сигнал усиливается или ослабляется при некотором преобразовании, и это зависит целиком от исходного сигнала и эффективности звена преобразования. При этом носитель сигнала обычно имеет одну и ту же физическую природу как на входе, так и на выходе звена.

Во втором способе исходный сигнал формирует степень модуляции некоторой физической величины (например, интенсивности светового потока) и при этом модулируемой величине передается информация, которая переносилась модулирующим сигналом. В первом случае сигнал i-го звена определяется выражением

Si = iSi-1, (16)

где i – коэффициент усиления (передачи) i-го звена. Во втором случае

Si = Smo f(Si-1), (17)

где f(Si-1) характеризует величину, определяющую часть потока частиц Smo, пропускаемого модулирующим звеном. В случае, если эта часть пропорциональна Si-1, звено может быть описано также и формулой (16); в противном случае в формуле (16) фактор i должен быть заменен на оператор, описывающий соответствующую функцию передачи.

Отметим, что в ряде случаев сигнал после преобразования не может быть описан через число частиц, а характеризуется определенной размерной физической величиной.

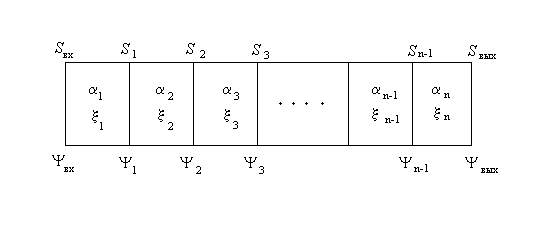

Для удобства рассмотрения изменения отношения сигнал/шум используем представление системы как последовательности звеньев (см. рис. 2).

Рис.2. Последовательность звеньев системы

Припишем каждому звену системы коэффициент усиления (в общем случае – оператор функции преобразования) i, входное и выходное значение сигнала Si-1 и Si, входное и выходное отношение сигнал/шум i-1 и i, а также фактор

i = i/i-1. (18)

Очевидно, что фактор характеризующий всю систему, представляет собой произведение соответствующих факторов всех ее звеньев

n. (19)

Кроме шумов, связанных с квантовой природой сигнала, в различных звеньях могут добавляться и другие шумы, как зависящие от величины сигнала (мультипликативные шумы), так и не зависящие от нее (аддитивные шумы). Уровень и характер шума, возникающего в звеньях зависит от типа звена. Звенья можно классифицировать следующим образом:

Преобразовательные звенья. К этому типу относятся звенья, в которых сигнал преобразуется таким образом, что на выходе звена он модулирует иную физическую величину, чем на входе. Эти звенья могут быть охарактеризованы как коэффициентом усиления (в случае, если сигнал имеет квантовую природу как на входе, так и на выходе), так и функцией передачи (в случае, когда либо входной, либо выходной сигнал модулирует величину, которую невозможно выразить числом частиц). В этих звеньях могут образовываться дополнительные шумы, связанные с флуктуациями коэффициента усиления либо величин, входящих в функцию передачи.

Диафрагмирующие звенья. В этих звеньях часть сигнала по тем или иным причинам отсекается. Здесь шумы уменьшаются вместе с сигналом. Незначительные добавки к шуму вызываются либо краевыми флуктуациями числа частиц, отсекаемых в звене, либо флуктуацией коэффициента поглощения (пропускания) материала, в котором осуществляется диафрагмирование сигнала.

Звенья с значительными аддитивными шумами. К этому типу относятся звенья, соответствующие входным каскадам усилителей в электронной части светоинформационных систем, а также звенья, в которых значительную роль играют фоновые засветки и темновые токи. Одновременно эти звенья по некоторым признакам могут быть отнесены также и к первым двум группам.

Кроме перечисленных типов, видимо, следует отдельно говорить об инерционных звеньях, в которых преобразование сигнала может занимать значительное время. В частности, это относится к звеньям, реализующим операцию накопления (например, в ПЗС-устройствах), а также к звеньям, в которых сигнал проходит через инерционное звено (например, полупроводниковый слой с очень низкой подвижностью носителей, как в некоторых аморфных халькогенидах).