- •1. Огляд історії теорії оптимізації.

- •§2 Способы решения задач на экстремумы

- •2. Деякі старовинні екстремальні задачі.

- •3. Основні етапи розв’язування екстремальних задач.

- •4. Постановка задачі оптимізації та основні поняття.

- •Основні типи задач оптимізації.

- •6. Задача нелінійного програмування (знлп), загальна форма.

- •7. Геометрична інтерпретація задачі нелінійного програмування.

- •8. Приклади екстремальних задач та їх формалізація.

- •9,10. Необхідні і достатні умови одновимірної оптимізації.

- •11. Класифікація методів оптимізації. Классификация методов оптимизации

- •12. Теорема Вейєршрасса.

- •13.Классические методы поиска экстремума функции одной переменной.

- •14. Класичний метод знаходження екстремумів функції однієї змінної.

- •16. Метод знаходження екстремумів функції багатьох змінних: виключення частини змінних Якобі.

- •17. Метод множителей Лагранжа.

- •18 . Опуклі множини та їх властивості.

- •Властивості опуклих множин

- •19. Опуклі функції та їх основні властивості.

- •Властивості опуклих функцій

- •20. Методи оптимізації диференційованих функцій

- •21. Необхідні умови мінімуму в задачах оптимізації.

- •22. Теорема Куна-Таккера.

- •Необхідні умови

- •Умови регулярності

- •Достатні умови

- •23. Двоїстість в задачі опуклого програмування. Приклади.

- •24. Наближені чисельні методи оптимізації.

- •25. Метод деления пополам Метод деления пополам

- •26. Метод золотого сечения

- •27. Метод касательних.

- •Обоснование

- •Алгоритм

- •28. Метод парабол.

- •29. Пошук глобального мінімуму функції однієї змінної в середовище Excel.

- •30. Покоординатний спуск. Введение

- •Метод покоординатного спуска Алгоритм

- •Критерий останова

- •Сходимость метода

- •Числовые примеры

- •31,32. Градієнтні методи.

- •33. Чисельні методи багатовимірної оптимізації: метод Ньютона та його модифікації.

- •34. Чисельні методи багатовимірної оптимізації: методи спряжених напрямів.

- •35. Чисельні методи багатовимірної оптимізації: методи спряжених напрямів.

30. Покоординатний спуск. Введение

Рассмотрим задачу

поиска минимума функции

![]() ,

записываемую в виде:

,

записываемую в виде:

(1)

![]()

В этой статье описан метод покоординатного спуска, решающий поставленную задачу. Также приведена теорема сходимости метода покоординатного спуска.

Метод покоординатного спуска Алгоритм

![]()

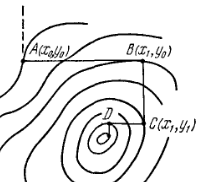

Рис.1 Иллюстрация метода

Вход: функция

![]()

Выход: найденная

точка оптимума

![]()

Инициализация некоторым значением

повторять:

для

фиксируем значения всех переменных кроме

,

получая одномерную функцию

,

получая одномерную функцию

проводим одномерную оптимизацию по переменной , любым методом одномерной оптимизации

если выполен критерий останова (варианты описаны ниже), то возвращаем текущее значение

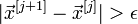

Критерий останова

Критерии остановки процесса приближенного нахождения минимума могут быть основаны на различных соображениях. Некоторые из них:

Здесь

![]() -

значение, полученное после

-

значение, полученное после

![]() -го

шага оптимизации.

-го

шага оптимизации.

![]() -

наперед заданное положительное число.

-

наперед заданное положительное число.

Сходимость метода

Рис.2

Легко убедится, что существуют функции, когда метод координатного спуска не приводит даже в локальный оптимум.

Пусть линии уровня образуют истинный овраг (рис.2), когда спуск по любой координате приводит на <<дно>> оврага, а любое движение по следующей координате (пунктирная линия) ведет на подъем. Никакой дальнейший спуск по координатам в данном случае невозможен, хотя минимум еще не достигнут.

Теорема о сходимости метода покоординатного спуска.

Для простоты

рассмотрим функцию двух переменных

![]() .

Выберем некоторое начальное приближение

.

Выберем некоторое начальное приближение

![]() и

проведем линию уровня через эту точку.

Пусть в области

и

проведем линию уровня через эту точку.

Пусть в области

![]() ,

ограниченной этой линией уровня,

выполняются неравенства, означающий

положительную определенность квадратичной

формы:

,

ограниченной этой линией уровня,

выполняются неравенства, означающий

положительную определенность квадратичной

формы:

![]()

Тогда спуск по координатам сходится к минимуму из данного начального приближения, причем линейно.

Числовые примеры

Для исследования сходимости метода покоординатного спуска была выбрана функция:

![]() .

.

Начальное приближение

- точка (10,10). Использован критерий

останова:

![]()

Для решения одномерных задач оптимизации использован метод золотого сечения.

Метод получил точность 1e-8 за 7 итераций.

Отсюда можно сделать вывод, что метод координатного спуска сходится неплохо на примерах, для которых он применим.

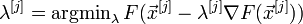

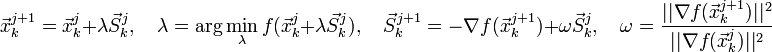

31,32. Градієнтні методи.

2. Градієнтні методи

Основна ідея

методів полягає в тому, щоб йти в напрямку

найшвидшого спуску, а цей напрямок

задається антіградіента

![]() :

:

![]()

де λ [j] вибирається

постійною, в цьому випадку метод може розходитися;

дробовим кроком, тобто довжина кроку в процесі спуску ділиться на деяке число;

порад задля спуском:

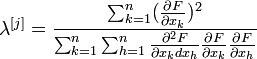

2.1. Метод найшвидшого спуску (метод градієнта)

Вибирають

![]() ,

Де всі похідні обчислюються при

,

Де всі похідні обчислюються при

![]() ,

І зменшують довжину кроку λ [j]

у міру наближення до мінімуму функції

F .

,

І зменшують довжину кроку λ [j]

у міру наближення до мінімуму функції

F .

Для аналітичних функцій F і малих значень f i Тейлоровской розкладання F (λ [j]) дозволяє вибрати оптимальну величину кроку

(5)

(5)

де всі похідні обчислюються при . Параболічна інтерполяція функції F (λ [j]) може виявитися більш зручною.

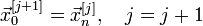

2.1.1. Алгоритм

Задаються початкове наближення і точність розрахунку

Розраховують , Де

Перевіряють умова зупину:

Якщо

,

То j = j + 1 і перехід до кроку 2.

,

То j = j + 1 і перехід до кроку 2.

Інакше

і

зупинка.

і

зупинка.

2.2. Метод покоординатного спуску ( Гаусса-Зейделя)

Покращує попередній

метод за рахунок того, що на черговій

ітерації спуск здійснюється поступово

уздовж кожної з координат, однак тепер

необхідно обчислювати нові

![]() раз

за один крок.

раз

за один крок.

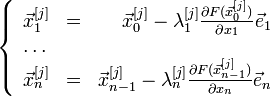

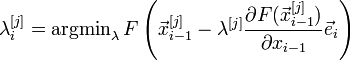

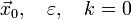

2.2.1. Алгоритм

Задаються початкове наближення і точність розрахунку

Розраховують

,

Де

,

Де

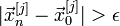

Перевіряють умова зупину:

Якщо

,

То

,

То

і

перехід до кроку 2.

і

перехід до кроку 2.

Інакше

і

зупинка.

і

зупинка.

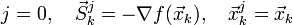

2.3. Метод спряжених градієнтів

Метод спряжених градієнтів грунтується на поняттях прямого методу багатовимірної оптимізації - методу сполучених напрямків.

Застосування методу до квадратичним функцій в визначає мінімум за n кроків.

2.3.1. Алгоритм

Задаються початковим наближенням і похибкою:

Розраховують початкова напрям:

Якщо

або

або

,

То

,

То

і

зупинка.

і

зупинка.

Інакше

якщо (J + 1) <n< i=""> </n<> , То j = j + 1 і перехід до 3;

інакше

і

перехід до 2.

і

перехід до 2.