- •Устройство биологического нейрона и его математическая модель.

- •Детерминированная и стохастическая модели искусственного нейрона

- •Нейрон с сигмоидальной функцией активации

- •Стохастическая модель нейрона

- •Представление знаний.

- •Классы задач, решаемые нс. Примеры.

- •Классификация нс по архитектуре.

- •Однослойные сети прямого распространения

- •Многослойные сети прямого распространения

- •7.3.3.Рекуррентные сети

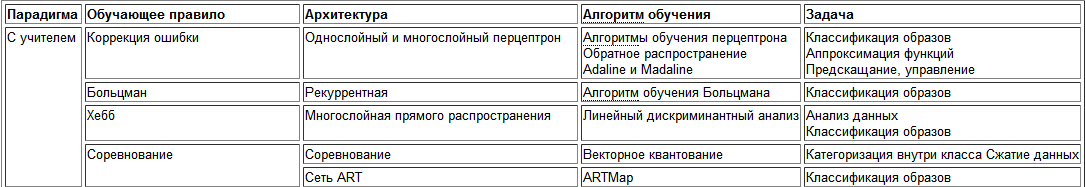

- •Классификация нс по парадигме обучения.

- •Обучение с учителем

- •Обучение без учителя

- •7.Понятие обучающей выборки (вектора)

- •8.Применимость различных активационных функций нейрона

- •1.1.1.1Активационные функции

- •9.Однослойные сети прямого распространения

- •10.Многослойные сети прямого распространения

- •11.Рекуррентные сети

- •12.Парадигмы обучения нс. Обучение с учителем. Применимость, примеры.

- •Обучение с учителем

- •13.Парадигмы обучения нс. Обучение без учителя. Применимость, примеры.

- •14.Парадигмы обучения нс. Смешанное обучение. Применимость, примеры.

- •15.Парадигмы обучения нс. Обучение Хебба. Математическая модель

- •16. Парадигмы обучения нс. Гипотеза ковариации. Математическая модель

- •17.Парадигмы обучения нс. Конкурентное обучение. Математическая модель

- •18.Парадигмы обучения нс. Обучение методом обратного распространения ошибки. Математическая модель

- •19. Парадигмы обучения нс. Обучение Больцмана. Математическая модель

- •20. Персептрон Розенблатта. Алгоритм обучения однослойного персептрона

- •21. Персептрон Розенблатта. Теорема о сходимости и «зацикливании» персептрона.

- •22. Персептрон Розенблатта. Дельта -правило

- •23. Многослойный персептрон. Теорема о двуслойности персептрона

- •24. Самоорганизующиеся карты Кохонена. Алгоритм обучения нс

- •Самоорганизующиеся карты Кохонена. Квантование обучающего вектора.

- •1.2Квантование обучающего вектора (Learning VectorQuantization)

- •Самоорганизующиеся карты Кохонена. Кластеризация

- •Сеть Хопфилда. Архитектура, обучение

- •1.2.1Алгоритм функционирования сети

- •1.2.2Архитектура сети

- •1.2.3Обучение сети

- •28. Сеть Хемминга. Архитектура, обучение

- •1.2.4Алгоритм функционирования сети Хемминга

- •Rbf сети. Архитектура. Применимость.

- •Rbf сети. Алгоритм обучения. Расчет опорных точек, параметра рассеяния и выходной весовой матрицы

- •Rbf сети. Аппроксимация

- •Ассоциативная сеть. Сжатие информации

- •Структура дап

12.Парадигмы обучения нс. Обучение с учителем. Применимость, примеры.

Основной - алгоритм обратного распространения ошибки.

Обучение с учителем

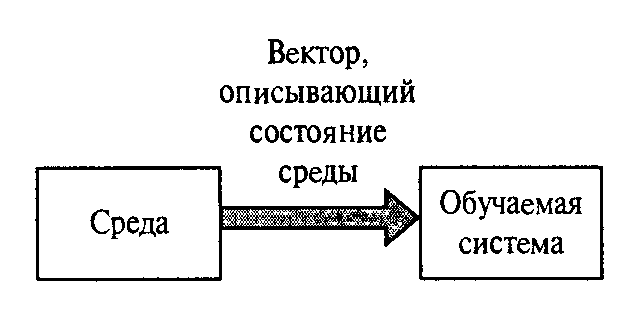

Участие учителя можно рассматривать, как наличие данных об окружающей среде, представленных в виде пар , где - это некоторый входной сигнал, а -

желаемый отклик сети на сигнал . Схема обучения с учителем показана на рис.7.10:

Рис. 7.10 Обучение с учителем

Параметры сети при обучении с учителем корректируются на основании сигнала ошибки , который определяется как разность между желаемым и действительным откликом сети.

Эффективность обучаемой нейронной сети можно оценивать в терминах среднеквадратической ошибки на обучающей выборке (некотором наборе пар ). Для среднеквадратической ошибки можно построить многомерную поверхность ошибки в координатах свободных параметров сети. Фактически, процесс обучения сводится к поиску минимума на поверхности ошибки.

13.Парадигмы обучения нс. Обучение без учителя. Применимость, примеры.

Обучение без учителя (unsupervised) (или обучение на основе самоорганизации (selforganized)) осуществляется без вмешательства внешнеro учителя, или корректора, контролирующеro процесс обучения.

Существует лишь независимая от задачи мера качества (taskindependent measure) представления, которому должна научиться нейронная сеть, и свободные параметры сети оптимизируются по отношению к этой мере. После обучения сети на статистические закономерности входноro сиrнала она способна формировать внутреннее представление кодируемых признаков входных данных и, таким образом, автоматически создавать новые классы. Для обучения без учителя можно воспользоваться правилом конкурентного обучения. Например, можно использовать нейронную сеть, состоящую из двух слоев входноrо и выходноro. Входной слой получает доступные данные. Выходной слой состоит из нейронов, конкурирующих друr с друroм за право отклика на признаки, содержащиеся во входных данных. В простейшем случае нейронная сеть действует по принципу "победитель получает все". При такой стратеrии нейрон с наибольшим суммарным входным сиrналом "побеждает" в соревновании и переходит в активное состояние. При этом все остальные нейроны отключаются.

![]()

Нейронная сеть самообучается. Основные алгоритмы - алгоритмы Хебба и Кохонена.

В процессе обучения существует лишь независимая от задачи мера качества представления. Нейронная сеть, обученная на основании статистических закономерностей во входных данных, способна формировать внутреннее представление признаков и самостоятельно формировать классы входных сигналов.

Процесс обучения, как и в случае обучения с учителем, заключается в подстраивании весов синапсов. Подстройка синапсов может проводиться только на основании информации, доступной в нейроне, то есть его состояния и уже имеющихся весовых коэффициентов.

Рассмотрим сигнальный метод обучения Хебба.

Веса по данному методу изменяются исходя из формулы:

![]()

где

![]() -

выходное значение нейрона

-

выходное значение нейрона

![]() слоя

слоя

![]() ,

,

![]() - выходное значение

- выходное значение

![]() -го

нейрона слоя

-го

нейрона слоя

![]() .

.

![]() -

коэффициент скорости обучения.

- здесь и далее, номер слоя сети. При

обучении данным методом усиливаются

связи между возбужденными нейронами.

-

коэффициент скорости обучения.

- здесь и далее, номер слоя сети. При

обучении данным методом усиливаются

связи между возбужденными нейронами.

Полный алгоритм обучения методами Хебба выглядит следующим образом:

1. При инициализации сети всем весовым коэффициентам присваиваются небольшие случайные значения.

2. На входы подается выбранный случайным образом образ и сигналы возбуждения распространяются по всем слоям согласно принципам прямопоточных сетей.

3. На основании полученных выходных значений нейронов по формулам (1) или (2) происходит коррекция весовых коэффициентов.

4. Цикл с шага 2, пока выходные значения сети не застабилизируются с заданной точностью.