- •2.3.2. Джиттер

- •2.4. Математическая модель канала с замираниями

- •3.4. Избыточность источника

- •3.6. Совместная энтропия двух источников

- •3.7. Скорость передачи и пропускная способность канала связи

- •4.1.2. Представление аналоговых сигналов в дискретной форме

- •4.1.4. Дискретизация полосовых сигналов

- •4.1.5. Дискретизация сигналов в реальных системах

- •4.1.7. Выводы и практические рекомендации

- •4.2. Квантование по уровню

- •4.2.3. Техническая реализация схем квантования по уровню

- •5.4. Алгоритм Лемпеля−Зива−Велча (LZW)

- •6.1. Симметричные криптосистемы

- •6.3. Криптографический протокол

Если объем алфавита источника равен k , а число связанных символов, которые необходимо учитывать при определении вероятности очередного символа, равно порядку источника n , то каждому символу может предше-

ствовать M k n различных сочетаний символов (состояний источника), влияющих на вероятность появления очередного символа xi . А вероятность появления в сообщении любого из k возможных символов определяется условной вероятностью P( xi / xi 1 ,xi 2 ,...,xi n ) с учѐтом предшествующих симво-

лов xi 1 ,xi 2 ,...,xi n , |

т. е. с учѐтом M возможных состояний. Эти состояния |

||||||||||||||||||

обозначим как q1 , q2 , ...,qM . |

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||

Энтропия такого дискретного источника определяется в два этапа. |

|

||||||||||||||||||

1. Вычисляются условные энтропии источника в каждом из M состоя- |

|||||||||||||||||||

ний, считаем эти состояния известными: |

|

|

|

|

|

|

|

|

Р |

||||||||||

|

|

|

|

|

|

|

k |

|

|

|

|

|

|

|

|

|

|

||

для состояния q1: |

H( x / q1 ) P( xi / q1 )log2 ( P( xi / q1 ) ); |

|

|

||||||||||||||||

И |

|

||||||||||||||||||

|

|

|

|

|

|

|

i 1 |

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

k |

|

|

|

|

|

|

|

|

|

|||

для состояния q2 : H( x / q2 ) P( xi / q2 )log2 ( P( xi |

|

|

|

|

|||||||||||||||

/ q2 ) ) ; |

|

|

(3.4) |

||||||||||||||||

|

|

|

|

|

|

|

i 1 |

|

|

|

|

|

У |

|

|

||||

|

|

|

|

|

|

|

|

k |

|

|

|

|

|

|

|||||

|

|

|

|

|

|

|

|

|

|

)log Г( P( x / q |

|

|

|

|

|

||||

для состояния q |

M |

: |

H( x / q |

) P( x / q |

M |

) ). |

|

|

|||||||||||

|

|

|

|

|

M |

i 1 |

i |

M |

|

2 |

i |

|

|

|

|

||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

2. Далее находим энтропию |

|

|

|

H (x) путѐм усреднения по |

|||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

Б |

|

|

|

|

|

|

|

|

всем состояниям q : |

|

|

|

|

|

источника |

|

|

|

|

|

|

|

|

|||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

M |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

к |

|

|

|

|

|

|

|

|

(3.5) |

||

|

|

|

|

|

|

H( x ) P( q j |

)H( x / q j ) . |

|

|

|

|

|

|

||||||

|

|

|

|

|

|

|

|

j 1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

е |

|

|

|

|

|

|

|

|

|

|

||

Окончательно получаем |

т |

|

|

|

|

|

|

|

|

|

|

|

|

||||||

|

|

|

|

|

k |

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

M |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

о |

|

|

|

/ q j )log2 ( P( xi |

/ q j |

) ) . |

|

(3.6) |

|||||||

|

|

H( x ) |

P( q j ) P( xi |

|

|||||||||||||||

|

|

и |

|

j 1 |

|

i 1 |

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

наличии |

корреляционных связей между символами в эргодиче- |

|||||||||||||||||

ском сточнике энтропия уменьшается, |

так как при этом уменьшается не- |

||||||||||||||||||

|

б |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

При |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Б |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

определѐнность выбора символов и в ряде случаев часть символов можно угадать по предыдущим или ближайшим символам.

3.4. Избыточность источника

Как было показано выше, энтропия максимальна при равновероятном появлении элементов сообщения и отсутствии между ними корреляционных связей. При неравномерном распределении вероятности появления символов

34

и при наличии корреляционных связей между символами энтропия уменьшается.

Чем ближе энтропия источника информации к максимальной, тем рациональнее работает источник. Чтобы судить о том, насколько хорошо использует источник свой алфавит, вводят понятие избыточности источника сообщений

g |

Hmax ( x ) H( x ) |

|

log2 |

( k ) H( x ) |

. |

(3.7) |

|

Hmax ( x ) |

log2( k ) |

||||||

|

|

|

|

||||

редавая). Р Однако преднамеренная избыточность в сообщениях иногда использу-

Наличие избыточности приводит к загрузке канала связи передачей лишних символов, которые не несут информации (их можно угадать и не пе-

ется для повышения достоверности передачи информации –Инапример, при помехоустойчивом кодировании в системах передачи информации с исправ-

лением ошибок. Большую избыточность имеет любая устнаяУречь. Например, избыточность русского языка (как и других) – около 50 %. Благодаря избы-

точности облегчается понимание речи при наличии дефектов в произноше- |

||||||||||

|

|

|

|

|

|

|

|

|

Г |

|

нии или при искажениях речевых сигналов в каналах связи. |

|

|||||||||

|

|

|

|

|

|

|

|

|

Б |

|

3.5. Производительность источни |

|

|

||||||||

|

|

|

|

|

|

|

а |

|

||

Производительность |

|

|

|

к |

|

|

||||

|

|

|

|

определяется количеством информа- |

||||||

ции, передаваемой в единицу |

|

|

|

. Измеряется производительность ко- |

||||||

|

|

|

|

времени |

|

|

||||

личеством двоичных единиц информации (бит) в секунду. Если все элементы |

||||||||||

сообщения имеют одинак вую дли ельность , то производительность ис- |

||||||||||

точника равна |

|

|

источника |

|

|

|

|

|||

|

|

|

|

|

|

|

||||

|

|

о |

|

|

|

|

|

|

|

|

|

и |

|

R |

H( x ) |

. |

|

(3.8) |

|||

|

|

|

|

|||||||

|

|

|

|

|

|

|

|

|

||

л |

|

|

|

|

|

|

|

|

||

|

|

|

|

|

|

|

|

|

||

Если |

|

|

|

|

|

|

|

|

|

|

же различные элементы сообщения имеют разную длительность, |

||||||||||

Б |

|

|

|

|

|

|

|

|

|

, рав- |

то в пр ведѐннойб |

формуле надо учитывать среднюю длительность |

|||||||||

ную математическому ожиданию символа: |

|

|

||||||||

|

|

|

|

|

|

k |

|

|

|

|

|

|

|

|

|

i P( i ) . |

|

(3.9) |

|||

|

|

|

|

|

|

i 1 |

|

|

|

|

Однако в последней формуле P( i ) можно заменить на P( xi ) (веро-

ятность i-го элемента сообщения), так как эти вероятности равны. В результате получаем

35

|

|

|

|

|

|

|

|

|

|

k |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

i P( xi ) , |

|

|

(3.10) |

||||

|

|

|

|

|

|

|

|

|

|

i 1 |

|

|

|

|

||

а производительность источника будет равна |

|

|

|

|

||||||||||||

|

|

|

|

|

|

|

|

R |

H( x ) |

. |

|

|

|

(3.11) |

||

|

|

|

|

|

|

|

|

|

|

|

|

|||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Mаксимально возможная производительность дискретного источника |

||||||||||||||||

равна Rmax |

|

Hmax ( x ) |

. |

|

|

|

|

|

|

|

|

|

|

|

Р |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||

|

|

|

|

|

|

|

|

|

|

|

|

|

И |

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

Для двоичного источника, имеющего одинаковую длительность эле- |

||||||||||||||||

ментов сообщения, имеем |

|

|

|

|

|

|

У |

|

||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

Rmax |

1 |

бит/с. |

|

|

|

|

|

|

|

|

|

Г |

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

Б |

|

|

|

При укрупнении алфавита в слова по n символов, имеем |

|

|||||||||||||||

|

|

nlog2 ( 2 ) |

|

1 |

|

|

|

а |

|

|

|

|||||

Rmax |

|

|

|

|

|

|

|

бит/с. |

к |

|

|

|

|

|||

|

|

|

n |

|

|

|

|

е |

|

|

|

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

Таким образом, |

путѐм ув лич ния размерности алфавита увеличить |

|||||||||||||||

|

|

|

|

|

|

|

|

т |

|

|

|

|

|

|

|

|

производительность источника н льзя, так как в этом случае и энтропия, и длительность сообщения одновременно возрастают в одинаковое число раз.

Увеличить производи ельнос ь можно путѐм уменьшения длительности элементов сообщения, днако возможность эта ограничивается полосой пропускания канала связи. Поэтому производительность источника можно

увеличить за счет |

|

экономного использования полосы пропускания, |

|||

|

|

|

|

более |

|

например, путем пр менения сложных многоуровневых сигналов. |

|||||

|

|

|

и |

|

|

|

|

л |

|

|

|

3.6. Совместная энтропия двух источников |

|||||

|

б |

|

|

|

|

Пусть меется два дискретных источника с энтропиями H( x ) и H( y ) |

|||||

и |

|

|

|

|

|

Б |

|

|

|

|

|

и объѐмами алфавитов k и m .

Объединим оба эти источника в один суммарный источник и определим совместную энтропию. Элементарное сообщение на выходе системы содержит элементарное сообщение xi и сообщение y j . Алфавит сложной си-

стемы будет иметь объѐм k m , а энтропия будет равна

36

|

k m |

|

|

|

|

|

|

|

|

|

|

|

H( x, y ) P( xi , y j )log P( xi , y j ) . |

|

|

(3.12) |

|||||||

|

i 1 j 1 |

|

|

|

|

|

|

|

|

|

|

По теореме умножения вероятностей |

|

|

|

|

|

|

|

|

|||

|

P( x, y ) P( x )P( y / x ) P( y )P( x / y ) |

|

|

(3.13) |

|||||||

с учетом этого имеем |

|

|

|

|

|

|

|

|

|

|

|

|

k m |

|

|

|

|

|

|

|

|

|

|

|

H (x, y) P(xi , y j ) log P(xi , y j ) H (x) H ( y / x) |

|

(3.14) |

||||||||

|

i 1 j 1 |

|

|

|

|

|

|

|

|

|

|

|

|

H ( y) H (x / y). |

|

|

Р |

||||||

|

|

|

|

|

|

|

|

|

|||

Здесь |

H( y / x ) P( xi , y j |

)log2 ( P( y j |

|

/ xi |

) ) – условная |

энтропия |

|||||

|

i j |

|

|

|

|

|

|

И |

|

||

|

|

|

|

|

|

|

|

|

|||

источника y |

относительно источника x . Она показывает, какую энтропию |

||||||||||

имеют сообщения y , когда уже известно сообщение |

x . |

У |

|

|

|

||||||

Если источники независимы, |

то P( y / x ) P(Гy ) и H( y / x ) H( y ). В |

||||||||||

этом случае |

H( x, y ) H( x ) H( y ) . |

|

|

Б |

|

|

|

|

|||

|

|

|

|

|

|

|

|

||||

Если источники частично зависимы, то H( x, y ) H( x ) H( y ). |

|

||||||||||

Если источники полностью зависимы ( x |

|

и y cодержат одну и ту же |

|||||||||

|

|

|

а |

|

|

|

|

|

|

||

информацию), то H( y / x ) 0 и H( x, y ) H( x ) |

H( y ). |

|

|

|

|||||||

|

|

к |

|

|

|

|

|

|

|

|

|

|

е |

|

|

|

|

|

|

|

|

|

|

3.7. Скорость передачи и пропускная способность канала связи |

|||||||||||

В дискретной с стеметсвязи при отсутствии помех информация на вы- |

|||||||||||

ходе канала связи полностью совпадает с информацией на его входе, поэтому |

||||||||

|

|

|

|

о |

|

|

|

|

|

|

|

и |

|

|

|

|

|

|

|

л |

|

|

|

|

|

|

скорость передачи нформации численно равна производительности источ- |

||||||||

ника сообщений: |

|

|

|

|

|

|

||

|

б |

|

|

C R( x ) |

H( x ) |

. |

(3.15) |

|

|

|

|

|

|||||

|

|

|

|

|

|

|||

и |

|

|

|

|

|

|||

|

|

|

|

|

|

|

||

При наличии помех часть информации источника теряется и скорость |

||||||||

Б |

|

|

|

|

|

|

|

|

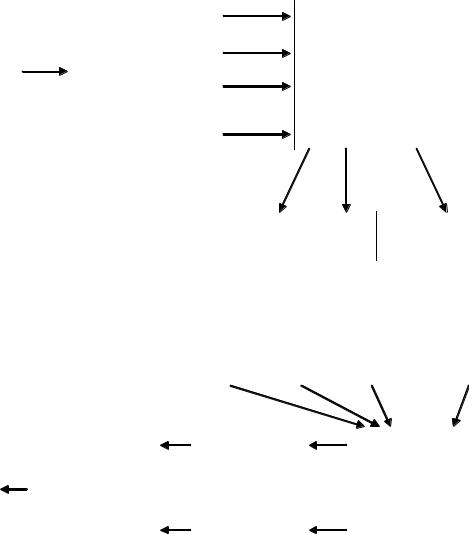

передачи информации оказывается меньшей, чем производительность источника. Одновременно в сообщение на выходе канала добавляется информация о помехах (рис. 3.2). Поэтому при наличии помех необходимо учитывать на выходе канала не всю информацию, сообщаемую источником, а только взаимную информацию.

37

В процессе передачи символы входного алфавита претерпевают искажения и преобразуются в символы выходного алфавита канала связи, которые в общем случае могут не совпадать со входными.

Под взаимной информацией будем понимать приращение знания о входных символах при приеме (получении) выходных символов. Данное приращение характеризуется приращением апостериорной вероятности (ве-

роятности после наблюдения конкретного выходного символа y j ) конкрет-

ного символа входного алфавита xi относительно априорной вероятности

(вероятности, которая была до приема символа выходного алфавита) данного |

|||||||||||||||||||||||||||

символа. |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Р |

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

Передающая |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Приемная |

||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

У |

|

|

|||

|

|

сторона |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Г |

|

|

сторона |

|||||

|

|

|

|

|

|

|

|

|

|

Помеха |

|

|

|

|

И |

||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Б |

|

|

|

|

|

|

||

|

|

Входной |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Выходной |

|

|||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||

|

|

алфавит |

|

|

|

|

|

|

|

+ |

а |

|

|

|

|

алфавит |

|

||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||

|

x1, x2 , ..., xk |

|

|

|

|

|

|

к |

|

|

|

|

y1, y2 , ..., ym |

|

|||||||||||||

|

|

|

|

|

|

|

|

|

|

Канал связи |

|

|

|

|

|

|

|

|

|

|

|||||||

|

|

|

|

|

|

|

о |

|

|

е |

|

|

|

|

|

|

|

|

|

|

|

|

|||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

и |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

Р с. 3.2.тПроцесс передачи информации |

|

|

|

||||||||||||||||||||

|

|

|

л |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

|

В двоичных ед н цах информации данная взаимная информация за- |

||||||||||||||||||||||||||

пишется с едующим образом: |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||

|

|

б |

|

|

|

|

|

|

P(xi |

/ y j ) |

|

|

|

P(xi / |

y j )P( y j ) |

|

|

|

|||||||||

|

|

|

|

I |

log |

|

log |

|

|

|

|

|

|||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||

|

|

|

|

|

y j xi |

2 |

P(xi ) |

|

|

|

2 |

|

P(xi )P( y j ) |

|

|

|

|

|

|||||||||

|

и |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

(3.16) |

|||

Б |

|

|

|

|

|

log2 |

|

|

P(xi , y j ) |

|

|

|

|

I (xi |

) I ( y j |

) I (xi , y j ), |

|

|

|||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||||

|

|

|

|

|

P(x )P( y |

|

) |

|

|

|

|||||||||||||||||

|

|

|

|

|

|

|

|

|

j |

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||

|

|

|

|

|

|

|

|

|

|

i |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

I( xi ) log2( P( xi )), |

|

|

|

|

|

(3.17) |

||||||||||||||

|

|

|

|

|

|

|

I( y j ) log2( P( y j )), |

|

|

|

|

|

(3.18) |

||||||||||||||

38

I( xi , y j ) log2( P( xi , y j )), |

|

|

(3.19) |

|

Взаимная информация обладает свойством симметрии I y |

j |

x |

I x y |

j |

|

i |

i |

||

и характеризует количество информации, которое приносит конкретный символ выходного алфавита y j (принятый символ) относительно конкретно-

го символа входного алфавита xi (переданного символа) и наоборот.

Для того чтобы охарактеризовать процесс передачи информации в целом, осуществим усреднение взаимной информации с учетом вероятностей появления входных и выходных символов.

Пропускной способностью канала связи (канала передачи информации) C называется максимально возможная скорость передачи информации по ка-

|

|

H y x H x y P(xi , y j )I y x P(xi , y j )Ix y |

Р |

|||||||||||||||||

|

|

|

|

|

|

|

|

|

i |

j |

|

|

|

|

|

|

i j |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

P(xi , y j |

|

|

P(xi , y j ) |

|

|

|

|

|

И |

|||||||||

|

|

) log2 |

|

|

|

|

|

H (x) H ( y) |

H (x, y) |

(3.20) |

||||||||||

|

|

P(x )P( y |

|

|||||||||||||||||

|

|

|

i |

|

j |

|

|

|

|

) |

|

|

У |

|

||||||

|

|

|

|

|

|

|

|

|

|

|

i |

|

j |

|

|

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Г |

|

|

|

|

|

|

|

|

|

|

H (x) H (x / y) H ( y) H ( y / x). |

|

|

|

||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Б |

|

|

|

Таким образом, информационная производительность канала связи с |

||||||||||||||||||||

шумами определяется следующим образом: |

|

|

|

|

||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

а |

|

|

|

||||

|

|

|

|

|

|

H y x |

|

1 |

|

|

к |

|

|

|

|

|||||

R(x, y) |

|

|

H (x) H (x / y) R(x) R(x / y) |

|

||||||||||||||||

|

|

|

|

|||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

е |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

тR( y) R( y / x), |

|

|

|

|

(3.21) |

||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||

|

|

|

|

|

|

|

о |

|

|

|

|

|

|

|

|

|

|

|||

где R( x ) |

1 |

H |

|

|

( x ) g |

– |

производительность источника; |

R( x / y ) – |

||||||||||||

|

|

|

||||||||||||||||||

|

|

|

maxи |

|

|

|

|

|

|

|

|

|

|

|

|

|||||

|

|

л |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||

«ненадѐжность» канала, (потери) в единицу времени; R( y) – энтропия вы- |

||||||||||||||||||||

ходного сообщения в единицу времени; |

R( y / x) R(n) – энтропия помех |

|||||||||||||||||||

(шума) в ед н цу времени; g – избыточность источника. |

|

|

||||||||||||||||||

и |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Б |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

налу |

|

C max R( x, y ) . |

(3.22) |

Таким образом, пропускная способность канала связи равна максимальной производительности источника на входе канала, полностью согла-

39

сованного с характеристиками этого канала, за вычетом потерь информации в канале из-за помех.

Для бинарного канала с шумами пропускная способность равна

C max R( x, y ) max R( y ) R( y / x ) . |

(3.23) |

В случае бинарного канала связи размерность выходного алфавита равна 2, следовательно, максимальная производительность канала связи на выходе равна

|

|

|

|

|

|

|

max R( y ) |

1 |

|

|

|

2 |

1 |

|

|

|

|

Р |

||||||||||

|

|

|

|

|

|

|

|

log |

2 |

|

, |

|

|

|

|

(3.24) |

||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

И |

|

||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

и, следовательно, пропускная способность канала запишется следующим об- |

||||||||||||||||||||||||||||

разом: |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Г |

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

C |

|

1 |

|

|

|

|

|

|

|

Б |

У |

|

(3.25) |

||||||||

|

|

|

|

|

|

|

|

max 1 H( y / x ) . |

|

|

|

|

||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Определим условную энтропию |

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

к |

|

|

|

|

|

|

|

|

|

|

||||

H( y / x ) |

|

2 |

2 |

P( x |

, y |

|

е |

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||

|

|

|

|

|

|

|

i |

|

|

j |

|

2 |

|

|

j |

|

i |

|

|

|

|

|

|

|

|

|||

|

|

|

|

i 1 j 1 |

|

т |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||

P( x1 )P( y1 |

|

|

|

/ x1 )) P( x1 )P( y2 / x1 )log2 ( P( y2 / x1 )) |

||||||||||||||||||||||||

/ x1 )log |

2 ( P( y1 |

|||||||||||||||||||||||||||

|

|

|

|

|

|

о |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||

P( x2 |

)P( y1 |

/ x2 |

)log2 |

( P( y1 / x2 )) P( x2 )P( y2 / x2 )log2 ( P( y2 / x2 )) |

||||||||||||||||||||||||

|

л |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||

б |

|

|

|

|

|

(1 |

P |

) P( x |

) P |

log |

|

( P |

) |

|

|

|

|

|||||||||||

P( x |

|

) 1иP log |

2 |

2 |

|

|

|

|

||||||||||||||||||||

и |

1 |

|

|

e |

|

|

|

|

e |

|

1 |

|

e |

|

|

|

e |

|

|

|

|

|

||||||

|

) Pe log2 ( Pe ) P( x2 ) 1 Pe log2 (1 Pe ) |

|

|

|

|

|||||||||||||||||||||||

P( x2 |

|

|

|

|

||||||||||||||||||||||||

Б |

|

log2( Pe ) 1 Pe log2(1 Pe ), |

|

|

|

|

|

|

|

|

|

|

|

|||||||||||||||

Pe |

|

|

|

|

|

|

|

|

|

|

(3.26) |

|||||||||||||||||

где Pe – вероятность ошибочного приема.

Таким образом, пропускная способность бинарного канала с шумами

равна

C |

1 |

1 H |

|

|

1 |

1 P log |

|

( P |

) (1 P )log |

|

(1 P ) |

, |

(3.27) |

|

e |

|

2 |

2 |

|||||||||

|

|

|

|

|

e |

e |

e |

e |

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

40

где He – энтропия ошибок при приеме.

В канале без помех пропускная способность равна производительности источника.

Для эффективного использования пропускной способности канала необходимо его согласование с источником информации на входе. Такое согласование возможно как для каналов связи без помех, так и для каналов с помехами на основании двух теорем, доказанных К. Шенноном.

1-я теорема (для канала связи без помех):

Если источник сообщений имеет энтропию H (бит на символ), а канал

сообщения таким образом, чтобы передавать информацию по Рканалу со средней скоростью, сколь угодно близкой к величине C , но не превзойти еѐ.

связи – пропускную способность C (бит в секунду), то можно закодировать

К. Шеннон предложил также и метод такого кодирования, который получил название статистического, или оптимального кодирования. В даль-

нейшем идея такого кодирования была развита |

в работах Р. Фано и |

||

|

|

|

И |

Д. Хаффмена и в настоящее время широко используется на практике для |

|||

«cжатия сообщений». |

|

У |

|

2-я теорема (для каналов связи с помехами): |

Г |

|

|

Если пропускная способность канала равна |

|

||

C , |

а производительность |

||

и с вероятностью ошибки, сколь угодно близкой к нулю. Если же R( x ) C ,

источника R( x ) C , то путѐм соответствующего кодирования можно пере- |

|

|

Б |

давать информацию по каналу связи со с оростью, сколь угодно близкой к C |

|

а |

|

к |

|

то можно закодировать источник та им образом, что ненадѐжность будет |

||

|

т |

|

меньше, чем R( x ) C , где – сколь угодно малая величина. |

||

Не существует способа кодированияе |

, обеспечивающего ненадѐжность, |

|

о |

|

|

меньшую, чем R( x ) C . |

|

|

и |

|

|

К сожалению, те рема К. Шеннона для каналов с шумами (помехами)

указывает только на в зм жн сть такого кодирования, но не указывает способа построениялсоответствующего кода.

и3.8.бЭнтропия непрерывного источника случайной величины и еѐ

свойства

БДля нахождения энтропии непрерывного источника воспользуемся выражением для энтропии дискретного источника, заменив вероятности P( x )

на элементарные вероятности W( x )dx , где W( x ) – плотность распределения вероятности информационного сигнала источника. В результате получим

41

|

|

|

H( x ) W ( x )dx log2 W ( x )dx |

|

|

|

|

(3.28) |

|

|

|

|

|

|

W ( x ) log2 (W ( x ) log2 ( dx ) dx. |

|

|

|

|

|

Логарифм бесконечно малой величины (dx) равен минус бесконечно- |

||

сти, в результате чего получаем |

|

|

|

|

|

H( x ) |

W( x )log2 W( x ) dx. |

(3.29) |

|

|

|

Таким образом, энтропия непрерывной случайной величины бесконеч- |

||

|

|

Р |

но велика. Но так как в последнем выражении первое слагаемое ( ) от вели- |

||

чины x или от W( x ) не зависит, |

|

И |

при определении энтропии непрерывной |

||

величины это слагаемое отбрасывают, учитывая толькоУвторое слагаемое (некоторую «добавку» к бесконечности). Эта добавочная энтропия, опреде-

ляемая формулой |

|

|

|

|

|

|

|

Г |

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Б |

|

|

|

|

|

|

H( x ) |

|

|

|

(3.30) |

|||

|

|

|

|

W( x )log2 W( x ) dx, |

|||||||

|

|

|

|

|

|

|

|

а |

|

||

|

|

|

|

|

|

|

|

|

|

||

и называется дифференциальной энтропией непрерывной случайной величи- |

|||||||||||

ны (источника). |

|

|

|

|

|

|

к |

|

|

||

Как и для дискре ных сообщений, существуют следующие разновид- |

|||||||||||

ности дифференциальной эн ропии непрерывной величины. |

|

||||||||||

Условная энтр пия случайной величины y относительно случайной |

|||||||||||

величины x . |

|

|

|

т |

|

|

|

|

|

||

|

|

о |

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

||

|

|

и |

|

|

|

|

|

|

|||

|

|

|

|

W( x, y )log2 W( y / x ) dxdy. |

(3.31) |

||||||

|

|

|

H( y / x ) |

||||||||

|

л |

|

|

|

|

|

|

||||

|

|

|

|

|

|

|

|

|

|||

Совместнаяб |

энтропия двух непрерывных случайных величин равна |

||||||||||

и |

|

|

|

|

|

|

|

|

|

|

|

|

|

H( x, y ) |

W( x, y )log2 W( x, y ) dxdy. |

(3.32) |

|||||||

Б |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Для дифференциальной энтропии справедливы все свойства простой энтропии.

Если случайная величина ограничена в объѐме V b a (может принимать значения только в интервале от a до b ), то еѐ дифференциальная энтропия максимальна при равномерном закона распределения этой величины:

42

Hmax ( x ) log2( b a ). |

(3.33) |

Если случайная величина не ограничена в численных значениях (т. е. может изменяться в пределах от до ), а ограничена только по мощности, то дифференциальная энтропия максимальна в случае гауссовского закона распределения этой величины. Этот максимум соответствует величине

H |

max |

( x ) log |

2 |

2 e 2 |

, |

(3.34) |

|

|

|

|

|

где 2 – мощность случайной величины. |

|

|

Р |

|

|

|

|

Следовательно, энтропия зависит только от мощности 2 . |

|||

|

|

И |

|

Эта очень важная формула будет использоваться позднее для опреде- |

|||

ления пропускной способности непрерывного канала связи. |

|

|

|

|

У |

|

|

Г |

|

|

|

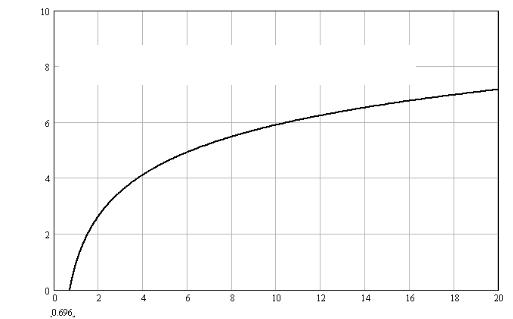

3.9. Пропускная способность непрерывного канала |

|

||

Б |

|

|

|

Сигнал, отображающий непрерывное сообщение, можно рассматривать |

|||

как некоторый случайный процесс, спектр которого ограничен определѐнной полосой частот. В соответствии с теоремой Котельникова для описания этого

характеризуется своими дискр тными значениями, то знание значений сиг-

процесса длительностью T |

требуется N |

T |

отсчѐтов, |

где t |

1 |

– ин- |

||

t |

2F |

|||||||

|

|

|

|

|

|

|||

|

|

а |

|

max |

|

|||

тервал дискретизации. Так как сигнал с ограниченным спектром полностью |

||||||||

|

к |

|

|

|

|

|||

|

е |

|

|

|

|

|

|

|

нала между этими значениями не увеличивает наших знаний о сигнале. Сле-

довательно, при определении эн ропии непрерывного сигнала достаточно

учитывать только его дискре ные значения, взятые в соответствии с теоре- |

||||

мой Котельникова. |

|

т |

|

|

Как было показано выше, энтропия обладает свойством аддитивности. |

||||

|

|

о |

|

|

Так, если у какого-то д скретного сигнала длительностью t энтропия равна |

||||

|

и |

|

элементов, будет равна |

|

H( x ) , то энтропия сигнала, составленного из N |

||||

л |

|

|

|

|

б |

|

|

|

|

N H( x ). Аналогичным образом можно вычислить энтропию непрерывного

сигнала дл тельностью T , которая будет равна |

|

|

и |

N H1 (x) 2 Fmax T H1(x), |

(3.35) |

Б |

|

|

где H1( x ) – энтропия одного сечения случайного сигнала, определяемая через одномерную плотность вероятности. Размерность энтропии H1( x ) – бит

на один отсчѐт случайного сигнала (одно сечение случайного процесса). Производительность непрерывного случайного процесса (источника)

будет равна

43

R( x ) |

H( x ) |

2 F |

H |

( x ). |

(3.36) |

|

|||||

|

T |

max |

1 |

|

|

|

|

|

|

|

Таким образом, производительность эргодического источника непрерывного сигнала полностью определяется энтропией одного отсчета и удвоенной полосой частот генерируемого источником сигнала.

Если x( t ) – сигнал на входе канала связи, а y( t ) x( t ) n( t ) – сигнал на его выходе ( n(t) – аддитивный шум канала), то скорость передачи информации по непрерывному каналу связи будет определяться так:

|

|

|

|

|

|

|

C max R( x, y ) , |

|

|

|

|

(3.37) |

|||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

И |

|

|

|

|

|

R( x, y ) |

H y x |

|

|

|

1 |

|

H( y ) H( y / x ) , |

|

Р(3.38) |

||||||||||

|

|

|

|

|

|

|

|

|

|

||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

У |

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Г |

|

|

||

где величину 1 / |

надо заменить на 2Fmax . Предполагая, что |

источник сиг- |

|||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Б |

|

|

|

||||

нала согласован с каналом и его полоса пропускания F Fmax , имеем |

|||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

а |

|

|

|

|

|

|

|

||||

|

|

|

|

R( x, y ) 2 F H( y ) H( y / x ) , |

|

(3.39) |

|||||||||||||||||

где, как и ранее, H( y ) |

|

|

|

|

к |

|

|

|

|

|

|

|

|

||||||||||

– это энтропия выходного сигнала канала связи; |

|||||||||||||||||||||||

H( y / x ) – энтропия шума (это |

название |

будет разъяснено далее по тексту). |

|||||||||||||||||||||

|

|

|

|

|

|

|

|||||||||||||||||

|

|

|

|

|

т |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

Пропускная способность равна максимально возможной скорости пе- |

|||||||||||||||||||||||

редачи по каналу связи, |

когда ис очник сигнала полностью согласован с ха- |

||||||||||||||||||||||

|

|

|

|

о |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

рактеристиками канала связи: |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||

|

|

|

и |

|

|

|

|

|

|

H ( y) H ( y / x) . |

|

|

|||||||||||

|

|

л |

C 2 Fmax |

|

(3.40) |

||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

|

б |

H( y ) достигается в случае гауссовского закона распреде- |

|||||||||||||||||||||

Максимум |

|||||||||||||||||||||||

ления случайной ве ичины y . При этом |

|

|

|

|

|

|

|

|

|

|

|||||||||||||

и |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

Б |

|

|

|

max H( y ) log2 |

|

|

|

2 |

|

|

|

|

|

(3.41) |

|||||||||

|

|

|

|

|

2 e y , |

|

|

|

|||||||||||||||

где 2 |

– мощность выходного сигнала канала связи. |

|

|

|

|||||||||||||||||||

y |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

При учѐте влияния помехи необходимо рассматривать наихудший слу- |

|||||||||||||||||||||||

чай, когда помеха распределена также по гауссовскому закону: |

|

||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

1 |

|

|

|

|

|

n |

2 |

|

|

|

|

|

|

|

|

|

|

W ( n ) |

|

|

|

|

|

exp |

|

|

, |

|

|

(3.42) |

||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||

|

|

|

|

|

n |

|

|

|

|

2 |

|

|

|

|

|

|

2 |

|

|

|

|

||

|

|

|

|

|

|

|

|

|

2 n |

|

|

|

2 n |

|

|

|

|

||||||

44

где 2n – мощность шума, (тем самым гарантируется пропускная способность

канала не хуже определенной, при любых статистических характеристиках шума).

Условная вероятность W( y / x ) – это вероятность распределения случайной величины y при якобы известном заранее значении x , хотя величина x является случайной. Но так как y( t ) x( t ) n( t ) , можно записать

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1 |

|

|

|

|

|

|

|

( y x ) |

2 |

|

|

|

|

Р |

|||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||

|

|

|

|

|

|

|

W( y / x ) |

|

|

|

|

|

|

|

exp |

|

|

|

|

|

|

|

|

|

|||||||||||

|

|

|

|

|

|

|

|

|

|

2 |

|

|

|

|

2 |

|

|

|

. |

|

|

(3.43) |

|||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

2 n |

|

|

|

|

|

|

2 n |

|

|

|

|

И |

||||||

Определим условную энтропию H( y / x ): |

|

|

|

|

|

|

|

|

|||||||||||||||||||||||||||

|

|

|

|

У |

|

||||||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Г |

|

|

|

|||||||

H( y / x ) |

|

W ( x, y )log2 W ( y / x ) dxdy |

|

|

|

|

|

|

|

||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

а |

|

|

|

|

|

|

|

|

|

|

|

||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||

|

W ( x ) W ( y / x )log2 W ( y / x ) dydx |

|

|

|

|

|

|

|

(3.44) |

||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

к |

|

|

|

Б |

|

|

|

|

|

|

|

|||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||

|

|

W ( x )log |

|

|

|

|

|

|

е |

|

|

2 e 2 |

|

H( n ). |

|

|

|

|

|||||||||||||||||

|

|

|

|

|

|

2 |

|

|

|

|

n |

|

|

|

|

|

|

2 |

|

|

|

|

n |

|

|

|

|

|

|

|

|

|

|

||

|

|

|

|

почему |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||

Отсюда видно, |

|

условная энтропия |

|

H( y / x ) называется энтро- |

|||||||||||||||||||||||||||||||

|

|

|

|

|

|

||||||||||||||||||||||||||||||

пией шума. |

|

|

и |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||

Осуществ в не бх димыетподстановки, получаем следующее выраже- |

|||||||||||||||||||||||||||||||||||

ние для пропускной способности канала связи: |

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||||||||||||||||

б |

|

|

|

|

|

|

|

|

|

2 |

|

|

|

|

|

|

|

|

|

2 |

|

|

|

|

|

|

|

|

|||||||

|

|

|

C 2 F log |

|

|

|

|

y |

F log |

|

|

|

y |

. |

|

|

|

|

|

|

(3.45) |

||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||||||||||

|

л |

|

|

|

|

|

2 |

2 |

|

|

|

|

|

|

|

2 |

|

2 |

|

|

|

|

|

|

|

|

|||||||||

Б |

|

|

|

|

|

|

|

|

|

|

|

|

|

n |

|

|

|

|

|

|

|

|

|

|

n |

|

|

|

|

|

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Учитывая, что рассматриваемые случайные процессы |

|

x( t ) , n( t ) и |

|||||||||||||||||||||||||||||||||

y( t ) x( t ) n( t ) |

являются гауссовскими, |

мощность выходного процесса |

|||||||||||||||||||||||||||||||||

y(t) определяется как |

сумма |

|

мощностей |

его |

|

аддитивных |

составляющих |

||||||||||||||||||||||||||||

2y 2x 2n . Тогда выражение для пропускной способности будет иметь вид (формула Шеннона)

45

|

|

|

|

2 |

|

|

|

|

|

|

C F log |

2 |

1 |

|

x |

|

F log |

2 |

1 q . |

(3.46) |

|

2 |

||||||||||

|

|

|

|

|

|

|

||||

|

|

|

|

n |

|

|

|

|

|

где q |

2 |

|

P |

|

|

x |

s |

– отношение мощности сигнала к мощности шума в канале |

|||

2 |

P |

||||

|

|

|

|||

|

n |

|

n |

|

|

связи. |

|

|

|

|

|

В заключение можно отметить следующее. Для достижения скорости |

|||||

передачи информации по непрерывному каналу связи, близкой к пропускной способности канала связи, сигнал x(t) по статистической структуре должен

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Р |

|

||

3.10. Предельные информационные характеристики канала связи |

|

||||||||||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

И |

|

||||

Преобразуем формулу Шеннона следующим образом: |

|

|

|

|

|||||||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

У |

|

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

P |

|

|

|

|

|

|

|

|

|

|

|

|

Г |

|

|

|

|

|

|

||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

E C |

|

|

|

|

|

|

|

|||||||

|

|

|

C F log |

|

1 |

|

|

|

s |

|

F log |

|

1 |

|

|

b |

, |

|

|

(3.47) |

|||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||||||||||||||

|

|

|

|

|

|

2 |

|

|

|

|

|

P |

|

|

|

|

|

|

|

|

2 |

|

|

|

N |

0 |

F |

|

|

|

|

|

|

||

|

|

|

|

|

|

|

|

|

|

|

|

|

n |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Б |

|

|

|

|

|

|

|

||||

где Eb Ps / C – энергия, приходящаяся |

|

|

|

|

один бит передаваемой информа- |

||||||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

на |

|

|

|

|

|

|

|

|

|

|

|

|||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

к |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||

ции; N0 Pn / F – спектральная плотность мощности аддитивного шума, |

|||||||||||||||||||||||||||||||||||

действующего в канале связи. |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||

Выполним ряд преобразованийе. |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||||||||||

|

|

|

|

о |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||

|

|

|

и |

|

|

|

|

|

C |

|

|

|

|

|

|

|

|

EbC |

|

|

|

|

|

|

|

|

|

|

|||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

(3.48) |

||||||

|

|

|

|

|

тlog2 1 |

|

N0 F |

, |

|

|

|

|

|

||||||||||||||||||||||

|

б |

|

|

|

|

|

|

F |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||

|

|

л |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Eb |

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

(3.49) |

|||||||||

|

|

|

|

|

|

log2 1 |

N0 |

, |

|

|

|

|

|

|

|

||||||||||||||||||||

Б |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||

и |

|

|

|

|

|

|

|

|

|

2 |

|

1 |

|

Eb |

. |

|

|

|

|

|

|

|

|

|

(3.50) |

||||||||||

|

|

|

|

|

|

|

|

|

|

|

N |

0 |

|

|

|

|

|

|

|

|

|

|

|||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Окончательно получим нижнюю границу отношения |

|

Eb |

, при которой |

||||||||||||||||||||||||||||||||

|

N0 |

||||||||||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

возможна |

реализация заданной |

|

спектральной эффективности |

C |

|

, |

|||||||||||||||||||||||||||||

|

F |

||||||||||||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||

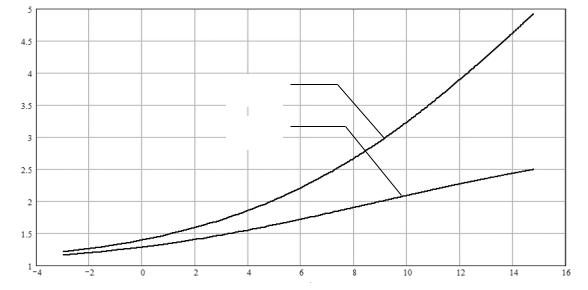

(бит/с)/Гц, |

канала связи |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||

быть близок к флюктуационной помехе (шуму) с гауссовским законом распределения.

46

Eb 2 1 .

N0

Рассмотрим канал связи при условии F . Перепишем формулу Шеннона следующим образом:

|

|

|

|

|

EbC |

N0 F |

|

|

|||

|

Eb |

|

|

EbC |

|

|

|||||

1 |

|

|

|

|

|

|

|

|

. |

(3.51) |

|

|

|

|

|

|

|||||||

|

log2 1 |

|

|

|

|

||||||

|

N0 |

|

|

|

N0 |

F |

|

|

Р |

||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

1 )x |

|

|

|

|

|

|

||

Учитывая, что lim (1 |

e , |

|

|

|

|

И |

|||||

получим минимально возможное отно- |

|||||||||||

x |

|

x |

|

|

|

|

|

|

|

||

шение энергии, приходящейся на один бит передаваемой информации, к спектральной мощности шума, при котором еще возможна передача информации.

|

|

|

|

|

|

|

Eb |

|

1 |

|

|

Б |

|

У |

|

Eb |

|

||

|

|

|

|

|

|

|

|

|

|

|

ln( 2 ) 0,69 . |

|

|

|

(3.52) |

||||

|

|

|

|

|

|

|

N0 |

|

log2( e ) |

|

|

|

Г |

|

|

|

|||

|

|

|

|

|

|

|

|

|

к |

|

|

|

|

|

|

|

|

||

|

|

Если рассмотреть полученную выше нижнюю границу для |

N0 |

, то в |

|||||||||||||||

случае |

если 0 , |

т. |

. Fа |

или |

|

C 0 |

, |

получим |

|||||||||||

|

Eb |

|

2 |

|

1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

lim |

|

ln( 2 ). Это означа т, что если |

E |

/ N |

0 |

0,69 , |

передача ин- |

|||||||||||

|

|

|

|

|

|||||||||||||||

|

N0 |

0 |

|

|

|

е |

|

|

b |

|

|

|

|

|

|||||

|

|

|

|

|

|

|

|

|

|

|

|

||||||||

|

|

|

|

|

|

вности |

|

|

|

|

|

|

|

|

|

|

|

|

|

формации невозможна. На рис. 3.3 приведена зависимость минимального |

|||||||||||||||||||

требуемого отношения энергии, приходящейся на один бит передаваемой |

||||

|

|

|

и |

|

информации, к спектральнтй плотности шума для обеспечения заданной |

||||

|

|

л |

|

|

спектральной эффект |

передачи информации. |

|||

|

б |

|

|

|

и |

|

|

|

|

Б |

|

|

|

|

47

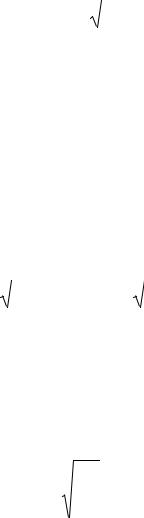

С/ F

Область запрещенных (нереализуемых) значений

|

|

|

|

|

|

Р |

|||

|

|

|

|

|

|

ИN |

|||

|

|

|

|

|

Г |

|

Eb |

||

|

|

|

|

|

|

|

0 |

|

|

|

|

|

|

|

Б |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Рис. 3.3. Соотношение между спектральной эффективностьюУ |

и требуе- |

||||||||

мым минимальным отношением сигнал/шум |

|

|

|||||||