- •Раздел 1. Общеобразовательные дисциплины

- •Раздел 2. Специальные дисциплины

- •Раздел 1. Общеобразовательные дисциплины

- •1.Основные понятия теории вероятностей. Случайные события, случайные величины. Функция распределения вероятностей, плотность распределения вероятностей.

- •2.Среднее значение (момента) случайных величин. Математическое ожидание, дисперсия.

- •3. Характеристическая функция случайных величин.

- •4. Нормальное (Гауссовское) распределение случайных величин. Плотность распределения и характеристическая функция момента.

- •5. Независимость случайных величин. Совместное распределение двух случайных величин. Условное распределение.

- •6. Семиуровневая модель osi/iso (гост р исо/мэк 7498-1-99).

- •Взаимодействие уровней модели osi

- •Уровень представления данных (Presentation layer)

- •Сеансовый уровень (Session layer)

- •Транспортный уровень (Transport Layer)

- •Сетевой уровень (Network Layer)

- •Канальный уровень (Data Link)

- •Физический уровень (Physical Layer)

- •7. Технико-экономические аспекты создания программного обеспечения вс. Оценка стоимости программной разработки.

- •8. Распределение затрат по фазам и видам работ программной разработки.

- •9. Компилятор в языках высокого уровня. Функции. Виды компиляторов.

- •Функции

- •Компиляторы

- •10. Ассемблер. Основные языковые конструкции. Необходимость двухпроходной трансляции. Основные работы, выполняемые транслятором. Таблицы транслятора.

- •11. Формальный язык. Грамматика. Сентенциальная форма. Нисходящий и восходящий анализ.

- •Грамматика

- •12. Понятие алгоритма и его свойства. Нормальные алгоритмы Маркова.

- •13. Иерархия запоминающих устройств. Кэш-память. Работа с кэш-памятью.

- •14. Прерывания. Классификация прерываний. Организация обработки прерываний.

- •15. Виды параллелизма. Векторная и конвейерная обработка. Классификация вычислительных комплексов по сочетанию потоков данных и потоков команд.

- •16. Информационная интегрированная среда предприятия. Общая база данных об изделиях (обди). Разделы обди.

- •17. Электронный документ. Технический электронный документ: форма представления, виды, жизненный цикл.

- •18. Электронная цифровая подпись. Суть и процесс использования электронной цифровой подписи.

- •19. Автоматизированные информационные системы. Цели и методы автоматизации.

- •20. Автоматизированные информационные системы. Математическое и программное обеспечение. Математическая модель. Программное изделие.

- •21. Свободное программное обеспечение: суть, области и проблемы использования.

- •22. Жизненный цикл программного обеспечения. Длительность. Состав. Стадии сопровождения.

- •Раздел 2. Специальные дисциплины

- •1. Модуль в языке System Verilog. Определение модуля, его применение. Задание портов и параметров.

- •2. Типы данных. Wire, reg, logic. Массивы. Строковый тип. Задание числе (в двоичном, десятичном, шестнадцатиричном виде).

- •3. Примитивы, типы примитивов. Объявление и применение примитивов.

- •4. Процедурные блоки (initial и always). Операторы управления временем.

- •Управление временем

- •5. Процедурные операторы. Операторы условного перехода. Операторы цикла. Операторы назначения. Оператор непрерывного назначения.

- •6. Маршрут проектирования программ плис. Средства разработки и проверки. Структура плис. Временные задержки сигналов

- •7. Математическое, программное и информационное обеспечение сапр. Математическая модель. Программное изделие.

- •8. Виды обеспечений, типы подсистем сапр. Общие требования к типовым сапр рэа.

- •9. Принципы измерения вектора движения ка

- •10. Геоцентрическая инерциальная система координат. Прямоугольные, сферические и геодезические координаты

- •11. Классификация орбит ка по параметрам движения. Параметры орбиты по Кеплеру.

- •12. Четыре основных свойства по.

- •13. Каскадная и спиральная модель жизненного цикла программного обеспечения

- •V модель (разработка через тестирование)

- •14. Биологический нейрон. Математическая модель нейрона. Связь искусственных нейронных сетей (инс) с другими дисциплинами. Проблемы, решаемые в контексте инс.

- •15. Архитектура нейронных сетей. Однослойный персептрон. Функции активации. Многослойный персептрон.

- •16. Понятие обучения. Методы обучения. Обучение персептрона. Процедура обратного распространения.

- •Метод к- ближайших соседей

- •Процедура обратного распространения

- •17. Гипотеза Хебба. Гипотеза ковариации. Конкурентное обучение.

- •18. Понятие vc-измерения (Вапника-Червоненкиса). Оценки обобщающей способности в задаче классификации. Теорема об универсальной аппроксимации.

- •19. Сети с локальным базисом. Сравнение сетей rbf с многослойным персептроном.

- •20. Сети Кохонена. Формализация задачи классификации для сети Кохонена. Алгоритм классификации для сети Кохонена.

- •21. Обучение Больцмана. Стохастические модели. Правило обучения Больцмана. Машина Больцмана.

- •22. Нейрокомпьютеры. Основные понятия. Классификация нейрокомпьютеров.

- •1. Что такое нейрокомпьютер?

- •2. Нейронные сети - основные понятия и определения

- •3. Модели нейронных сетей

- •3.1. Модель Маккалоха

- •3.2. Модель Розенблата

- •3.3. Модель Хопфилда

- •3.4. Модель сети с обратным распространением

- •4. Задачи, решаемые на основе нейронных сетей

- •5. Способы реализации нейронных сетей

- •6. Выводы

15. Архитектура нейронных сетей. Однослойный персептрон. Функции активации. Многослойный персептрон.

Архитектура нейронных сетей. Однослойный персептрон.

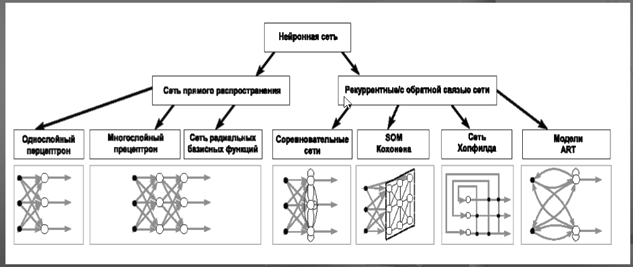

ИНС может рассматриваться как направленный граф со взвешенными связями, в котором искусственные нейроны являются узлами. По архитектуре связей ИНС могут быть сгруппированы в два класса: сети прямого распространения, в которых графы не имеют петель, и рекуррентные сети, или сети с обратными связями.

Однослойный персептрон.

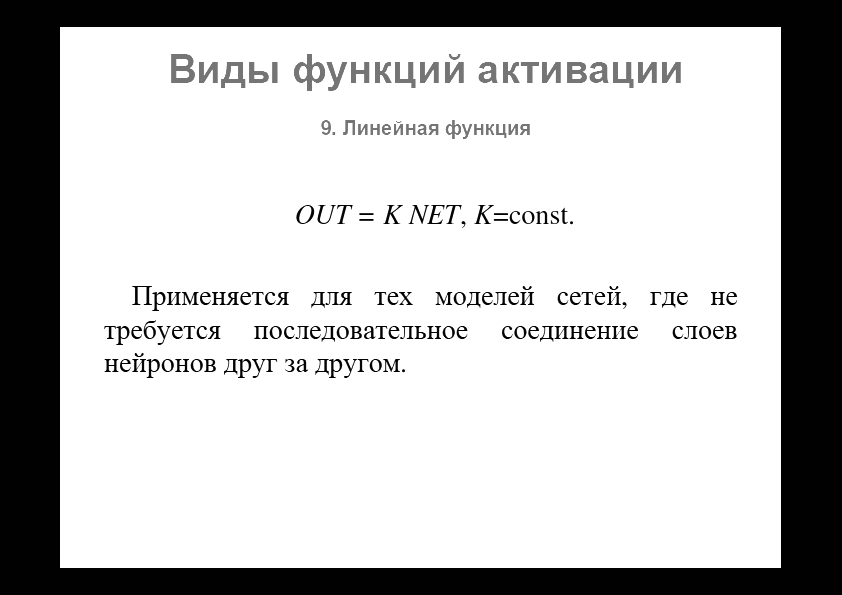

Функции активации

16. Понятие обучения. Методы обучения. Обучение персептрона. Процедура обратного распространения.

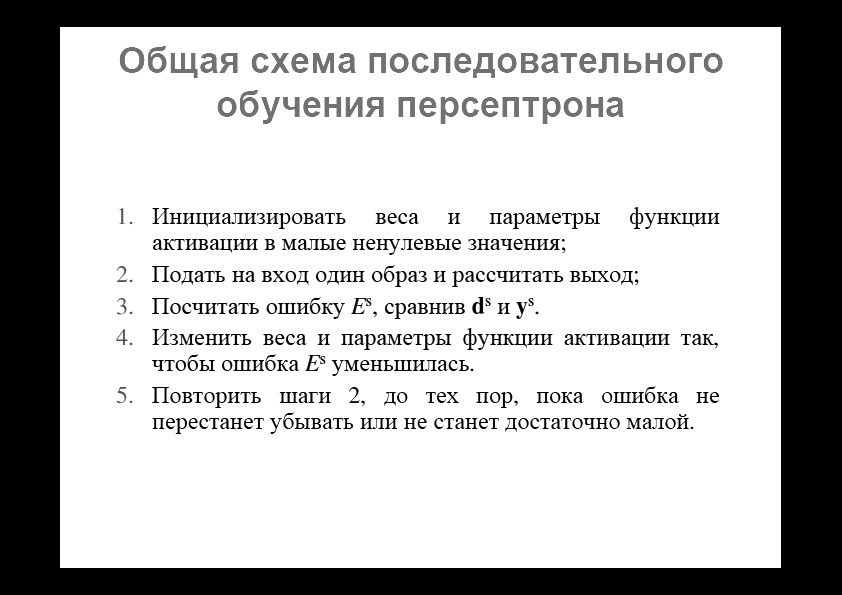

Понятие обучения

Обучение - это процесс, в котором свободные параметры нейронной сети настраиваются посредством моделирования среды, в которую эта сеть встроена. Тип обучения определяется способом подстройки этих параметров.

В нейронную сеть поступают стимулы из внешней среды.

В результате этого изменяются свободные параметры нейронной сети.

После изменения внутренней структуры нейронная сеть отвечает на возбуждения уже иным образом.

Методы обучения

Алгоритм с учителем, если при обучении изветсны и входные и выходные вектора сети.

без учителя, если известные только входные вектора и на их основе сеть учится давать наилучшие значения выходов.

с подкреплением, формируются сигналы во взаимодействии с внешней средой

Метод к- ближайших соседей

Процедура обратного распространения

Дополнительно: обучение 1слойного персептрон, обратное распространение

17. Гипотеза Хебба. Гипотеза ковариации. Конкурентное обучение.

Обучение Хебба Алгоритм обучения Хебба назван так в честь нейрофизиолога, который в нейробиологическом контексте предложил следующее правило модификации синаптических весов:

Если аксон клетки А находится на достаточно близком расстоянии от клетки В и постоянно или периодически участвует в ее возбуждении, наблюдается процесс метаболических изменений в одном или обоих нейронах, выражающийся в том, что эффективность нейрона А как одного из возбудителей нейрона В возрастает.

В контексте искусственных нейронных сетей данное правило может быть переформулировано в виде двух утверждений:

− если два нейрона, связанные синаптической связью возбуждаются одновременно (синхронно), то прочность этой связи (соответствующий синаптический вес) возрастает;

− если два нейрона по обе стороны синапса возбуждаются асинхронно, такой синапс ослабевает (синаптический вес уменьшается).

Можно сформулировать следующие свойства синапса Хебба:

− Зависимость от времени. Изменение синаптического веса зависит от точного времени возникновения предсинаптического и постсинаптического сигналов.

− Локальность. На изменение синаптического веса оказывают воздействие сигналы, находящиеся в пространственно-временной близости.

− Интерактивность. Изменение синаптического веса определяется сигналами на обоих его концах.

− Корреляция. Механизм изменения синаптического веса определяется наличием корреляции между предсинаптическим и постсинаптическим сигналом.

Математические модели обучения Хебба. Рассмотрим синапс с синаптическим весом wkj , который соединяет выходной сигнал yj некоторого нейрона j с соответствующим входом нейрона k. Выходной сигнал yj является j -ой компонентой вектора входного сигнала для нейрона k. Таким образом, модификация веса wkj нейрона k, будет определяться парой предсинаптического и постсинаптического сигналов (xj,yk). Изменение синаптического веса wkj в момент времени n будет определяться соотношением:

![]()

Это соотношение может быть записано в различных видах, каждый из которых все равно остается математической моделью алгоритма обучения Хебба.

Гипотеза Хебба. Является простейшей формой обучения Хебба. В соответствии с гипотезой Хебба выражение для модификации веса wkj в момент времени n записывается в виде:

![]()

где η – константа скорости обучения. Недостатком данной модели является то, что при частом приложении входного сигнала xj наблюдается неограниченный рост синаптического веса wkj, что приводит к потере избирательности связей и неспособности сети сохранить какую-либо информацию.

Гипотеза ковариации. Недостаток гипотезы Хебба может быть устранен, если переписать выражение для модификации синаптического веса wkj в виде:

![]()

где ![]() –

это усредненные по времени значения

предсинаптического и постсинаптического

сигналов.

–

это усредненные по времени значения

предсинаптического и постсинаптического

сигналов.

Синапс, вес которого изменяется в соответствии с гипотезой ковариации, обладает следующими свойствами:

− синаптический

вес увеличивается при высоком уровне

предсинаптического и постсинаптического

сигналов, то есть при ![]()

− синаптический

вес уменьшается при высоком уровне

предсинаптического сигнала, который

не вызывает существенной постсинаптической

активности, то есть![]()

− синаптический

вес уменьшается, если наблюдается

существенная постсинаптическая

активность при отсутствии значительного

предсинаптического сигнала, то есть

![]()

Конкурентное обучение При конкурентном обучении, в отличие от, например, обучения Хебба, в фиксированный момент времени в возбужденном состоянии может находиться только один нейрон выходного слоя. В связи с этим конкурентные сети часто применяются для решения задач классификации входных образов. Конкурентное обучение строится на основании следующих принципов:

− Все нейроны выходного слоя одинаковы и имеют в начальный момент времени случайные значения весов.

− Существует предельное значение выходного сигнала каждого нейрона.

− Существует механизм, определяющий нейрон, победивший в борьбе за право генерировать выходной сигнал. Принцип конкуренции можно сформулировать как «победитель получает все».

Механизм конкуренции может формироваться за счет введения отрицательных обратных связей, обеспечивающих латеральное торможение, когда каждый нейрон стремится затормозить связанные с ним нейроны (рис. 7.11).

Для того, чтобы

нейрон k выходного слоя победил в

конкурентной борьбе, его индуцированное

локальное поле

![]() должно

быть максимальным среди всех нейронов

выходного слоя. Таким образом, выходной

сигнал нейрона k можно записать в виде:

должно

быть максимальным среди всех нейронов

выходного слоя. Таким образом, выходной

сигнал нейрона k можно записать в виде:

Если предположить, что синаптические веса конкурирующих нейронов положительны и выполняются следующие нормировки:

Правило конкурирующего обучения можно записать в виде:

Данное правило обеспечивает смещение вектора синаптических весов в сторону вектора входного сигнала.

Дополнение: интуит