- •Глава 3 Функции нескольких переменных

- •3.1. Критерии оптимальности

- •3.2. Методы прямого поиска

- •3.2.1. Метод поиска по симплексу (s2-метод)

- •3.2.2. Метод поиска Хука — Дживса

- •3.7. Итерация поиска по методу Хука—Дживса в примере 3.3.

- •3.2.3. Метод сопряженных направлений Пауэлла

- •3.3. Градиентные методы

- •3.3.1. Метод Коши [20]

- •3.3.2. Метод Ньютона [23]

- •3.3.3. Модифицированный метод Ньютона

- •3.3.4. Метод Марквардта

- •3.3.5. Методы сопряженных градиентов

- •3.3.6. Квазиньютоновские методы

- •3.3.7. Обобщенный градиентный алгоритм

- •3.3.8. Численная аппроксимация градиентов

- •3.4. Сравнение методов и результаты вычислительных экспериментов

- •3.5. Заключение

- •Контрольные вопросы и задачи

3.3. Градиентные методы

В предыдущем разделе рассматривались методы, позволяющие получить решение задачи на основе использования только значений целевой функции. Важность прямых методов несомненна, поскольку в ряде практических инженерных задач информация о значениях целевой функции является единственной надежной информацией, которой располагает исследователь.

f(x)

= 2x![]() +

4x

+

4x![]() x

x![]() –

10x

–

10x![]() x

x![]() +

x

+

x![]()

Рис. 3.13. Решение задачи из примера 3.6 по методу сопряженных направлений Пауэлла.

С другой стороны, при использовании даже самых эффективных прямых методов для получения решения иногда требуется чрезвычайно большое количество вычислений значений функции. Это обстоятельство наряду с совершенно естественным стремлением реализовать возможности нахождения стационарных точек [т. е. точек, удовлетворяющих необходимому условию первого порядка (3.15а)] приводит к необходимости рассмотрения методов, основанных на использовании градиента целевой функции. Указанные методы носят итеративный характер так как компоненты градиента оказываются нелинейными функциями управляемых переменных.

Далее

везде предполагается, что f(х),

![]() f(x)

и

f(x)

и

![]()

![]() f(x)

существуют и непрерывны. Методы с

использованием как первых, так и вторых

производных рассматриваются лишь кратко

и главным образом в их связи с более

полезными методами. Особое внимание

уделяется подробному изложению методов

сопряженных

градиентов, в

основе

которых

лежит введенное выше понятие сопряженности

направлений, и так называемых

квазиньютоновских методов, которые

аналогичны методу Ньютона, но

используют лишь информацию о первых

производных. Предполагается, что

компоненты градиента могут быть записаны

в аналитическом виде или с достаточно

высокой точностью вычислены при

помощи численных методов. Кроме того,

рассматриваются способы численной

аппроксимации градиентов.' Все описываемые

методы основаны на итерационной процедуре

реализуемой в соответствии с формулой

f(x)

существуют и непрерывны. Методы с

использованием как первых, так и вторых

производных рассматриваются лишь кратко

и главным образом в их связи с более

полезными методами. Особое внимание

уделяется подробному изложению методов

сопряженных

градиентов, в

основе

которых

лежит введенное выше понятие сопряженности

направлений, и так называемых

квазиньютоновских методов, которые

аналогичны методу Ньютона, но

используют лишь информацию о первых

производных. Предполагается, что

компоненты градиента могут быть записаны

в аналитическом виде или с достаточно

высокой точностью вычислены при

помощи численных методов. Кроме того,

рассматриваются способы численной

аппроксимации градиентов.' Все описываемые

методы основаны на итерационной процедуре

реализуемой в соответствии с формулой

x![]() = x

= x![]() +α

+α![]() s(x

s(x![]() ) (3.42)

) (3.42)

где

x![]() — текущее

приближение к решению х*;

α

— текущее

приближение к решению х*;

α![]() — параметр характеризующий длину шага;

s(x

— параметр характеризующий длину шага;

s(x![]() )

=

s

)

=

s![]() — направление

поиска в N-мерном

пространстве

управляемых переменных xi,

i

=

1, 2, 3,...,

N.

Способ

определения s(x)

и

α

на каждой итерации связан с особенностями

применяемого метода. Обычно выбор α

— направление

поиска в N-мерном

пространстве

управляемых переменных xi,

i

=

1, 2, 3,...,

N.

Способ

определения s(x)

и

α

на каждой итерации связан с особенностями

применяемого метода. Обычно выбор α![]() осуществляется

путем решения задачи минимизации f(x)

в

направлении s(x

осуществляется

путем решения задачи минимизации f(x)

в

направлении s(x![]() ).

Поэтому

при реализации изучаемых методов

необходимо использовать эффективные

алгоритмы одномерной минимизации.

).

Поэтому

при реализации изучаемых методов

необходимо использовать эффективные

алгоритмы одномерной минимизации.

3.3.1. Метод Коши [20]

Предположим,

что в некоторой точке

![]() пространства управляемых переменных

требуется определить направление

наискорейшего локального спуска, т. е.

наибольшего локального уменьшения

целевой функции. Как и ранее, разложим

целевую функцию в окрестности точки

пространства управляемых переменных

требуется определить направление

наискорейшего локального спуска, т. е.

наибольшего локального уменьшения

целевой функции. Как и ранее, разложим

целевую функцию в окрестности точки

![]() в

ряд Тейлора

в

ряд Тейлора

f(x)

= f (![]() )+

)+![]() f(

f(![]() )

)![]() ∆x+… (3.43)

∆x+… (3.43)

и

отбросим члены второго порядка и выше.

Нетрудно видеть, что локальное уменьшение

целевой функции определяется вторым

слагаемым, так как значение f

(![]() )

фиксировано. Наибольшее уменьшение f

ассоциируется с выбором такого направления

в (3.42), которому соответствует наибольшая

отрицательная

величина

скалярного произведения, фигурирующего

в качестве второго слагаемого разложения.

Из свойства скалярного произведения

следует, что указанный выбор обеспечивается

при

)

фиксировано. Наибольшее уменьшение f

ассоциируется с выбором такого направления

в (3.42), которому соответствует наибольшая

отрицательная

величина

скалярного произведения, фигурирующего

в качестве второго слагаемого разложения.

Из свойства скалярного произведения

следует, что указанный выбор обеспечивается

при

s

(![]() )

= –

)

= –

![]() f(

f(![]() ), (3.44)

), (3.44)

и второе слагаемое примет вид

–α

![]() f(

f(![]() )

)![]()

![]() f(

f(![]() ).

).

Рассмотренный случай соответствует наискорейшему локальному спуску. Поэтому в основе простейшего градиентного метода лежит формула

x![]() = x

= x![]() –

α

–

α

![]() f

(x

f

(x![]() ), (3.45)

), (3.45)

где α

— заданный положительный параметр.

Метод обладает двумя недостатками:

во-первых, возникает необходимость

выбора подходящего значения α,

и,

во-вторых, методу свойственна медленная

сходимость к точке минимума вследствие

малости

![]() f

в окрестности этой точки.

f

в окрестности этой точки.

Таким образом, целесообразно определять значение α на каждой итерации

x![]() = x

= x![]() –

α

–

α![]()

![]() f

(x

f

(x![]() ), (3.46)

), (3.46)

Значение

α![]() вычисляется путем решения задачи

минимизации f

(x(k+1))

вдоль

направления

вычисляется путем решения задачи

минимизации f

(x(k+1))

вдоль

направления

![]() f

(x

f

(x![]() )

с

помощью того или иного метода одномерного

поиска. Рассматриваемый градиентный

метод носит название метода наискорейшего

спуска, или метода

Коши, поскольку

Коши первым использовал аналогичный

алгоритм для решения систем линейных

уравнений.

)

с

помощью того или иного метода одномерного

поиска. Рассматриваемый градиентный

метод носит название метода наискорейшего

спуска, или метода

Коши, поскольку

Коши первым использовал аналогичный

алгоритм для решения систем линейных

уравнений.

Поиск вдоль прямой в соответствии с формулой (3.46) обеспечивает более высокую надежность метода Коши по сравнению с простейшим градиентным методом, однако скорость его сходимости при решении ряда практических задач остается недопустимо низкой. Это вполне объяснимо, поскольку изменения переменных непосредственно зависят от величины градиента, которая стремится к нулю в окрестности точки минимума, и отсутствует механизм ускорения движения к точке минимума на последних итерациях. Одно из главных преимуществ метода Коши связано с его устойчивостью. Метод обладает важным свойством, которое заключается в том, что при достаточно малой длине шага итерации обеспечивают выполнение неравенства

f

(x![]() )

≤ f

(x

)

≤ f

(x![]() ). (3.47)

). (3.47)

С учетом этого свойства заметим, что метод Коши, как правило, позволяет существенно уменьшить значение целевой функции при движении из точек, расположенных на значительных расстояниях от точки минимума, и поэтому часто используется при реализации градиентных методов в качестве начальной процедуры. Наконец, на примере метода Коши можно продемонстрировать отдельные приемы, которые используются при реализации различных градиентных алгоритмов.

Пример 3.7. Метод Коши

Рассмотрим функцию

f(x)

= 8x![]() +

4x

+

4x![]() x

x![]() +

5x

+

5x![]()

и используем метод Коши для решения задачи ее минимизации.

Решение. Прежде всего вычислим компоненты градиента

![]() =

16x

=

16x![]() +

4x

+

4x![]() ,

, ![]() =

10x

=

10x![]() +

4x

+

4x![]() .

.

Для того чтобы применить метод наискорейшего спуска, зададим начальное приближение

x(0) = [10, 10]T

и с помощью формулы (3.46) построим новое приближение

x![]() = x

= x![]() -

α

-

α![]()

![]() f

(x

f

(x![]() )

)

f (x) =

8x![]() +

4x

+

4x![]() x

x![]() +

5x

+

5x![]()

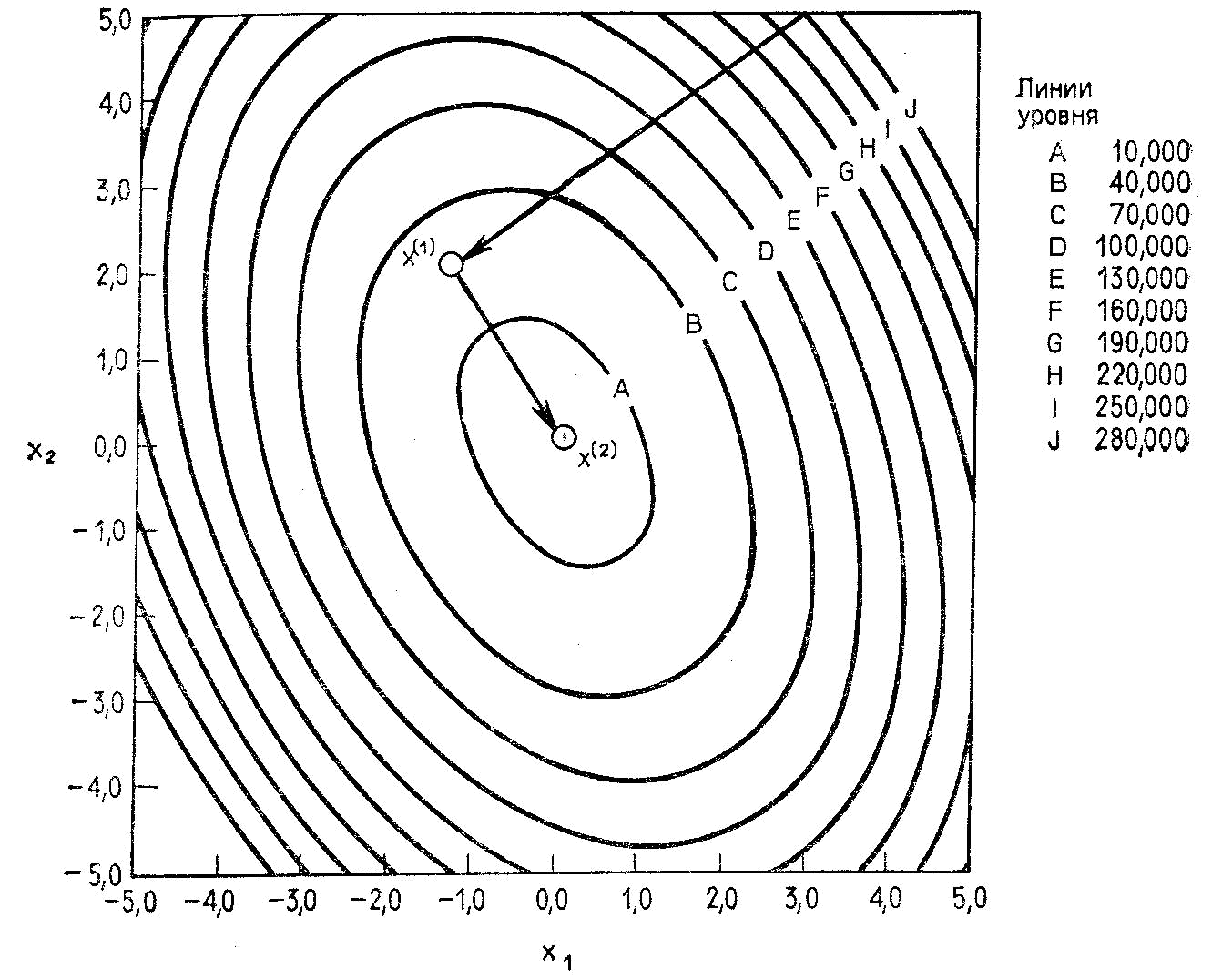

Рис. 3.14. Итерации по методу Коши с использованием метода квадратичной интерполяции.

Таблица 3.1. Результаты вычислений по методу Коши

|

k |

x |

x |

f(x |

|

1 |

-1.2403 |

2.1181 |

24.2300 |

|

2 |

0.1441 |

0.1447 |

0.3540 |

|

3 |

-0.0181 |

0.0309 |

0.0052 |

|

4 |

0.0021 |

0.0021 |

0.0000 |

Выберем

α![]() таким

образом, чтобы f

(x(1))

→ min.;

α

таким

образом, чтобы f

(x(1))

→ min.;

α![]() =

0,056. Следовательно, x(1)

= [–1,20,

2.16]T

Далее найдем точку

=

0,056. Следовательно, x(1)

= [–1,20,

2.16]T

Далее найдем точку

x![]() = x

= x![]() –

α

–

α![]()

![]() f

(x

f

(x![]() ),

),

вычислив

градиент в точке x![]() и

проведя

поиск вдоль прямой.

и

проведя

поиск вдоль прямой.

В таблице 3.1 представлены данные, полученные при проведении итераций на основе одномерного поиска по методу квадратичной интерполяции [21, 22]. Последовательность полученных точек изображена на рис. 3.14.

Несмотря на то что метод Коши не имеет большого практического значения, он реализует важнейшие шаги большинства градиентных методов. Блок-схема алгоритма Коши приведена на рис. 3.15. Заметим, что работа алгоритма завершается, когда модуль градиента или модуль вектора ∆x становится достаточно малым.

Рис. 3.15. Блок-схема метода Коши.