Дырда, Иващенко Учебн пособие рус

.pdfМинистерство транспорта и связи Украины

ГОСУДАРСТВЕННАЯ АДМИНИСТРАЦИЯ СВЯЗИ УКРАИНЫ

ОДЕССКАЯ НАЦИОНАЛЬНАЯ АКАДЕМИЯ СВЯЗИ им. А.С. ПОПОВА

Кафедра теории электрической связи им. А.Г. Зюко

В.Е Дырда, П.В. Иващенко

ТЕОРИЯ СВЯЗИ

Модуль 2. Передача информации в телекоммуникационных системах

Учебное пособие для бакалавров по направлению высшего образования 6.050903 - Телекоммуникации

Одесса 2011

2

ББК 32.811я7 УДК 621.391(075)

В учебном пособии для бакалавров в восьми лекциях рассмотрено: основные информационные характеристики источников дискретных и непрерывных сообщений; эффективное кодирование источников дискретных сообщений; кодирование аналоговых сигналов методами ІКМ, ДІКМ и ДМ; информационные характеристики каналов связи; теоремы Шеннона для источников сообщений и каналов связи.

Особенностью пособия является наличие значительного количества примеров и упражнений, справочного материала, словаря терминов и определений, индивидуальных и тестовых заданий. Расчетные формулы сведены в таблицы. Такое построение пособия является наиболее целесообразным для использования студентами при освоении материала модуля 2.

ОДОБРЕНО на заседании кафедры

теории электрической связи им. А.Г. Зюко и рекомендовано в печать.

Протокол № 9 от 25.03.2010 г.

УТВЕРЖДЕНО методическим советом академии связи.

Протокол № 6 от 30.03.2010 г.

|

|

|

3 |

|

|

СОДЕРЖАНИЕ |

|

ВВЕДЕНИЕ |

................................................................................................................................... |

4 |

|

1 |

ВХОДНЫЕ ...............................................ЗНАНИЯ И УМЕНИЯ К ИЗУЧЕНИЮ МОДУЛЯ |

6 |

|

2 |

КОНСПЕКТ ...............................................................................................................ЛЕКЦИЙ |

7 |

|

|

Объяснение ..............................................................................................к конспекту лекций |

7 |

|

|

Лекция 1. .............. |

Информационные характеристики источников дискретных сообщений |

7 |

|

Лекция 2. ..........Информационныехарактеристики двух источников дискретных сообщений |

11 |

|

|

Лекция 3. ............................................... |

Кодирование источников дискретных сообщений |

15 |

|

Лекция 4. ........... |

Информационные характеристики источника непрерывных сообщений |

24 |

|

Лекция 5. ................................................................ |

Кодирование непрерывных сообщений |

30 |

|

Лекция 6. ....................................Кодирование непрерывных сообщений с предсказанием |

40 |

|

|

Лекция 7. ................................... |

Информационные характеристики каналов электросвязи |

46 |

|

Лекция 8. ...................Потенциальные возможности передачи информации каналами связи |

51 |

|

3 |

ТЕМЫ ПРАКТИЧЕСКИХ ...................................ЗАНЯТИЙ И ЛАБОРАТОРНЫХ РАБОТ |

55 |

|

4 |

РЕКОМЕНДАЦИИ .......................................................К САМОСТОЯТЕЛЬНОЙ РАБОТЕ |

55 |

|

5 |

ЗАДАНИЯ ..........................................ДЛЯ ПРОВЕРКИ ЗНАНИЙ И УМЕНИЙ МОДУЛЯ |

58 |

|

6 |

ВЫХОДНЫЕ ...............................................................ЗНАНИЯ И УМЕНИЯ ИЗ МОДУЛЯ |

62 |

|

ЛИТЕРАТУРА ............................................................................................................................ |

62 |

||

ПРИЛОЖЕНИЕ .......................................................................................................................А |

63 |

||

4

ВВЕДЕНИЕ

Теория связи (ТС) является одной из фундаментальных теоретических дисциплин базовой подготовки специалистов-связистов по направлению 6.050903 – Телекоммуникации. Она базируется на новейшей науке “Статистическая теория связи”, возникшей в 30...40 гг.

XXст. и стремительно развивающейся во второй его половине.

ВТС рассматриваются основные процессы передачи сигналов каналами связи при наличии помех. Для этого в ней принятый единый методологический подход к решению задач электросвязи на основе вероятностных моделей. Детально изучаются методы математического описания сигналов и помех, методы обеспечения необходимых характеристик систем связи, таких как достоверность и скорость передачи информации.

Теоретической базой дисциплины ТС в ВУЗе являются такие дисциплины, как “Высшая математика” и “Теория электрических цепей и сигналов”. Принципы и методы дисциплины ТС являются основой техники телекоммуникаций и развиваются во всех инженерных дисциплинах подготовки бакалавров направления 6.050903 – Телекоммуникации.

Общая характеристика дисциплины: количество кредитов ECTS – 9; модулей – 4; общее количество часов – 324; в том числе: лекции – 104 ч.; практические занятия – 16 ч.; лабораторные занятия – 40 ч.; самостоятельная и индивидуальная работа – 164 ч.; вид контроля

– экзамены по1-му и 3-му модулю, зачет по 2-му и 4-му модулю, курсовая работа в 4-м модуле.

Согласно учебному плану ОНАЗ им. А.С. Попова по направлению 6.050903 – Телекоммуникации изучение дисциплины ТС распределено на зачетные модули:

Модуль 1. Математическое описание сигналов.

Модуль 2. Передача информации в телекоммуникационных системах. Модуль 3. Теории помехоустойчивости систем передачи.

Модуль 4. Основы теории корректирующих кодов.

Это учебное пособие подготовлено для изучения и усвоение студентами учебного материала модуля 2, в котором изложены основные положения науки “Теория информации” – одной из составных частей теории связи.

Начата наука “Теория информации” в 1948 г., когда Клод Шеннон (США) опубликовал статью “Математическая теория связи”, в которой заложенные основы теории информации и ее применения к задачам связи, введенные понятия – энтропия источника сообщений и пропускная способность канала связи.

Теория информации – это, в принципе, теоретическая наука об основных закономерностях передачи информации каналами связи. Но она сделала толчок для стремительного развития техники телекоммуникаций в XX ст. особенно, в его конце.

Во-первых, теория информации дала математический аппарат вычисления избыточности сообщений и методы ее сокращения. Эти методы применяются ныне для уменьшения скорости цифровых сигналов при передаче видеосообщений и аудиосообщений и объема данных для запоминания этих сообщений, например, в стандартах JPEG и MPEG, в архиваторах компьютеров.

Во-вторых, в теории информации строго математически доказан тот факт, что канал связи с помехами и ограниченной полосой пропускания имеет ограниченную скорость передачи информации (так называемую пропускную способность), но точность передачи сигналов при этом может быть как угодно высокой (ошибки, которые возникают в канале связи из-за действия помех, могут быть исправлены).

В-третьих, детальное развитие идеи исправления ошибок (так называемое помехоустойчивое кодирование) привело к появлению довольно мощных помехоустойчивых кодов, которые исправляют почти все ошибки. Только применение помехоустойчивых кодов позволило реализовать и глобальную спутниковая связь, и мобильные телефоны, и радиосвязь с внеземными космическими аппаратами и т.п.

5

На изучение модуля 2 планируется: количество кредитов ECTS – 2; общее количество часов – 72; в том числе: лекции – 16 ч.; лабораторные занятия – 8 ч.; самостоятельная и индивидуальная работа – 48 ч.; вид контроля – зачет.

Модуль 2 состоит из следующих содержательных модулей:

информационные характеристики источников сообщений;

эффективное кодирование сообщений;

информационные характеристики каналов электросвязи.

Это учебное пособие не заменяет рекомендованную учебную литературу, а дополняет ее. Необходимые теоретические выкладки к изучению модуля приведены в учебниках. В пособии же приведено целенаправленное толкование основных положений “Теории информации” относительно передачи информации каналами электросвязи. Для улучшения ее изучения студентами в пособии приводятся примеры, упражнения, задачи, индивидуальные задачи, справочный материал, словарь каждой лекции – т.е. основные понятия и термины.

Для облегчения восприятия учебного материала модуля важнейшие теоретические результаты, который следует понять и запомнить, выделены в специальной рамке за текстом и

обозначенные знаком “!”. Кроме того, при подборе материала пособия и его представлении авторы старались придерживаться правила – без сложных математических доказательств (а их в теории информации многовато) наглядно показать, что можно, а чего невозможно достичь во время передачи информации каналами электросвязи.

Пособие подготовили профессора Иващенко П.В. и Дирда В.Е. Значительный вклад во время работы над пособием внесли все преподаватели кафедры теории электрической связи им. А.Г. Зюко.

6

1 ВХОДНЫЕ ЗНАНИЯ И УМЕНИЯ К ИЗУЧЕНИЮ МОДУЛЯ

Приведенный в табл. 1.1 перечень входных знаний и умений студент должен получить во время изучения предыдущих дисциплин, чтобы усвоить содержание модуля 2. Шифры знаний и умений указаны согласно действующей учебной программе дисциплины ТС.

Таблица 1.1 – Перечень входных знаний и умений к модулю 2

Но- |

Содержание знаний |

Шифр |

|

мер |

|||

|

|

||

1 |

Методы вычисления производной и интегрирование функций |

Вх.Зн.02 |

|

2 |

Основные характеристики случайных событий и величин (теория веро- |

Вх.Зн.05 |

|

ятностей) |

|||

|

Математическое описание случайных сигналов: вероятностные и число- |

|

|

3 |

вые характеристики, корреляционная функция, спектральная плотность |

Вх.Зн.08 |

|

|

мощности |

|

|

4 |

Теорема В.А. Котельникова (отсчетов) |

Вх.Зн.09 |

|

Содержание умений |

|

1 |

Выполнять дифференцирование и интегрирование функций с помощью |

Вх.Ум.03 |

математических справочников и компьютерных программ |

||

2 |

Рассчитывать вероятностные и числовые характеристики случайных со- |

Вх.Ум.04 |

|

бытий, величин и процессов |

|

3 |

Рассчитывать частоту дискретизации аналоговых сигналов |

Вх.Ум.07 |

Приведенные в табл. 1.1 входные знания и умения должны обеспечить модули дисциплин, которые определены в табл. 1.2.

Таблица 1.2 – Модули предыдущих дисциплин, которые обеспечивают изучение мо-

дуля 2

Но |

Название модуля дисциплины, |

Шифр знания и |

|

умение, которые |

|||

мер |

которая обеспечивает входные знания и умения |

||

обеспечиваются |

|||

|

|

||

|

Дисциплина “Высшая математика” |

|

|

1 |

Дифференциальное исчисление функции одной или нескольких |

Вх.Зн.02 |

|

сменных |

Вх.Ум.03 |

||

2 |

Теория вероятностей и математическая статистика |

Вх.Зн.05 |

|

Вх.Ум.04 |

|||

|

|

||

|

Дисциплина “Теория связи” |

|

|

|

|

Вх.Зн.08 |

|

1 |

Математическое описание сигналов |

Вх.Зн.09 |

|

Вх.Ум.04 |

|||

|

|

||

|

|

Вх.Ум.07 |

7

2 КОНСПЕКТ ЛЕКЦИЙ

Объяснение к конспекту лекций

За более чем 45 лет преподавания во всех электротехнических институтах и техникумах связи СССР и Украины учебной дисциплины “Теория электрической связи” (сначала она называлась “Теория передачи сигналов”) выдано больше десяти учебников и учебных пособий.

В учебниках (см. перечень рекомендованной литературы) основные положения такой составляющей части теории связи как “Теория информации” детально изложены. Но в этих учебниках и пособиях основное внимание отводится теоретическим положением “Теории информации” и доказательства основных теорем.

Поэтому приведенный конспект лекции не дублирует учебную литературу, а дополняет ее примерами, упражнениями и задачами, справочными данными, которые необходимые для освещения того, как основные теоретические положения “Теории информации” находят применение в телекоммуникации.

Материал каждой лекции рекомендуется изучать по учебной литературе и этому конспекту в последовательности, которая представлена в тематике лекции, исполь-

!зуя таблицы расчетных формул и словарь основных терминов и определений относительно лекции

Лекция 1. Информационные характеристики источников дискретных сообщений

Тематика лекции

1 Математические модели источников дискретных сообщений и их основные пара-

метры.

2Количественная мера информации.

3Информационные характеристики источников дискретных сообщений: энтропия источника и ее свойства; избыточность и производительность источника.

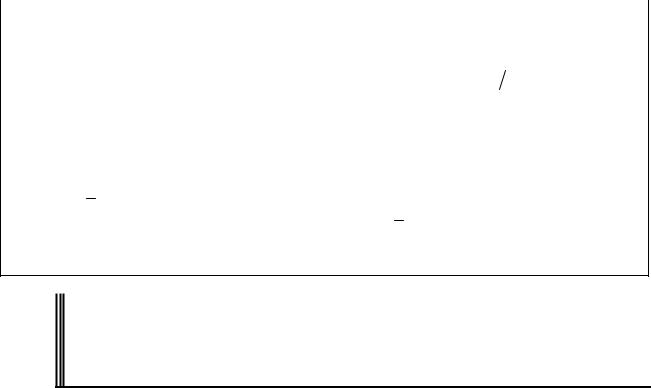

Таблица Л1.1 – Расчетные формулы информационных характеристик источников дискретных сообщений

Номер Наименование характеристики Расчетная формула формулы

Количество информации в сообщении (знаке) аk |

I(аk) = log2 (1/P(аk)) = |

(1.1) |

||||||

(собственная или безусловная), дв.ед. (бит) |

= – log2 P(аk) |

|||||||

|

||||||||

Условное количество информации в сообщении |

|

|

|

|

|

|

|

|

(знаке) аk, когда зависимость между сообщениями |

I(аk/ak – 1) = – log2 P(аk/ak – 1) |

(1.2) |

||||||

простирается в пределах двух сообщений аk и ak – |

|

|

|

|

|

|

|

|

1, дв.ед. (бит) |

|

|

|

|

|

|

|

|

Условноеколичество информации в сообщении(зна- |

|

|

|

|

|

|

|

|

ке) аk, когдазависимостьмеждусообщениями про- |

I(аk/аk – 1,…,ak–n+1)= |

(1.3) |

||||||

стирается впределахn сообщенийаk,…,ak–n+1, дв.ед. |

=–log2P(аk/аk – 1,…,ak–n+1) |

|||||||

|

||||||||

(бит) |

|

|

|

|

|

|

|

|

Энтропия источника независимых сообщений |

MA |

P ak H1 A |

(1.4) |

|||||

H A P ak log2 |

||||||||

(знаков) A, дв.ед./знак (бит/знак) |

k 1 |

|

|

|

|

|||

Энтропия источника зависимых сообщений (зна- |

|

|

|

|

|

|

|

|

ков) А, когда зависимость между сообщениями |

|

|

|

|

|

|

|

|

H2 A I ak |

ak 1 |

(1.5) |

||||||

простирается в пределах двух сообщений, |

||||||||

дв.ед./знак (бит/знак) |

|

|

|

|

|

|

|

|

Энтропия источника зависимых сообщений А, ко- |

|

|

|

|

|

|

|

|

гда зависимость между сообщениями простирает- |

Hn A |

|

|

(1.6) |

||||

I ak ak 1, ,ak n 1 |

||||||||

ся в пределах n сообщений, дв.ед./знак (бит/знак) |

|

|

|

|

|

|

|

|

8

Окончание табл. Л1.1

Максимальная энтропия источника A, дв.ед./знак |

Нmax(A) = log2 MА |

(1.7) |

|||

(бит/знак) |

|||||

|

|

|

|

||

Коэффициент избыточности источникаА |

Kизб = 1 – Нn(A)/Нmax(A) |

(1.8) |

|||

Производительность источника сообщений, |

|

|

|

|

|

Rи Hn A T |

(1.9) |

||||

дв.ед./с (бит/с) |

|||||

Пояснения: P(аk) – априорная (безусловная) вероятность сообщения (знака) аk;

P(аk/aj) – апостериорная (условная) вероятность сообщения (знака) аk, если сообщение (знак) aj известное;

аk,…,ak–n+1 – известны (n–1) предыдущие сообщения (знаки), индекс указывает номер сообщения в последовательности с выхода источника;

Т– средняя длительность сообщения (знака) – вычисляется как математическое ожидание длительности сообщений Tk: T Tk P ak ;

k

МА – объем алфавита источника

Определение. Дискретное сообщение – это последовательность отдельных знаков, количество которых является конечным. Знаки образуют алфавит источника. Коли-

!чество знаков в алфавите называется объемом алфавита MА. Знаками могут быть отдельные буквы, цифры, символы или их соединение, например, слова или даже предложения.

Классификация источников. Источники дискретных сообщений делятся на:

–источники независимых сообщений (источники без памяти), когда появление любого знака аk никак не обусловлено знаками, которые появились до него;

–источники зависимых сообщений (источники с памятью), когда появление знака аk связано с предыдущими знаками.

Условно источники дискретных сообщений можно разделить на две группы: текстовые и цифровые.

Текстовые сообщения состоят из последовательности букв, цифр и символов алфавита, который определяет определенный язык, например, русский. Объем алфавита, особенно алфавитов восточных языков, может быть значительным – сотни и тысячи.

Цифровыми считаются сообщения обмена информацией между компьютерами и сообщения, полученные после преобразования аналоговых сигналов в цифровые (в связи, вещании, при записи на электронные носители). Как правило, цифровые сообщения двоичные,

т.е. MА = 2.

Математическая модель источника.

Источник независимых сообщений задается перечнем знаков аk и их априорных (безусловных) вероятностей P(аk), k = 1, 2, ..., MА, при этом вероятности удовлетворяют условию

P(ak ) 1.

k

Источник зависимых сообщений задается апостериорными (условными) вероятностями; так, если зависимость между знаками простирается в пределах двух знаков аk и аj, то источник задается вероятностями P(аk/aj), k, j = 1, 2, ..., MА; если зависимость между знаками простирается в пределах трех знаков аk, аj, и аl, то источник задается вероятностями

P(аk/aj,аl), k, j, l = 1, 2, ..., MА и так далее.

Источник задается также значениями длительностей выдачи каждого знака Тk, k = 1, 2, ..., MА. Когда длительности выдачи всех знаков одинаковые, источник называют синхронным, в противном случае – асинхронным.

Количественная мера информации детально описана в [1, с. 284...286], [3,

с. 276...277]. Особенностью количественной меры информации есть то, что по предложению

9

Р. Хартли (1928 г.) для вычисления количества информации в сообщениях принята логарифмическая мера: расчетные формулы (1.1), (1.2) и (1.3) в табл. Л1.1.

Логарифмическая мера количества информации в сообщении применена по той причине, что она удовлетворяет обычным представлениям об информации:

!количество информации – величина аддитивная; в сообщении, вероятность которого равна единице, количество информации равняется нулю

Единицы измерения информации приведены в [1, с. 284...285], [3, с. 277]. Обраща-

ем внимание на такие основные положения:

Единица измерения количества информации определяется основой логарифма,

!общепринятое вычисление логарифма с основой 2

1 дв.ед. (бит) – количество информации в сообщении, вероятность которого рав-

!на 0,5

Пример 1.1. Найти количество информации в последовательности из шести знаков от некоторого датчика, при условии, что знаки источника равновероятные и независимые, а объем источника МA = 16.

Решение. Если знаки равновероятные, то вероятность каждого из них Р(аk) = 1/ МА = 1/16, каждый знак по формуле (1.1) несет І(аk) = – log216 = 4 дв.ед. информации. Знаки независимые, поэтому количество информации в последовательности из N = 6 знаков Ізн =

I(ak ) = 6 4 = 24 дв.ед.

k

Пример 1.2. Найти количество информации в слове Одеса украинского текста, считая, что буквы в текстах независимые.

Решение. Вероятности букв в украинских текстах приведены в табл. 4.1. По формуле (1.1) они несут такое количество информации: І(о) = 3,47 дв.ед.; І(д) = 5,27 дв.ед.; І(е) = 4,61 дв.ед.; І(с) = 5,09 дв.ед.; І(а) = 3,76 дв.ед. Таким образом, количество информации в слове Одеса в силу аддитивности информации равняется Ісл = 3,47 + 5,27 + 4,61 + 5,09 + 3,76 = 22,20 дв.ед.

Энтропия источника и ее свойства детально описаны в [1, с. 294…298], [4,с. 277...278]. Расчетные формулы (1.4), (1.5), (1.6) и (1.7). Обращаем внимание на такие основные положения:

!Энтропияника источника – это среднее количество информации в одном знаке источ-

Максимальную энтропию имеет источник равновероятных независимых сообще-

!ний

Упражнение 1.1. Вывести формулу для энтропии H(A)источника независимых сообщений.

Решение. Согласно определению, энтропия исчисляется как математическое ожида-

ние количества информации в одном знаке источника, т.е. H A I ak . По формуле (1.1)

І(аk) = log 2 (1/P(аk)). Тогда согласно правилу вычисления математического ожидания энтропия будет равна

MА

H A P ak log2 1 P ak .

P ak .

k 1

Упражнение 1.2. Доказать, что энтропия источника сообщений принимает лишь неотрицательные значения.

10

Решение. Поскольку вероятности знаков P(аk) 1, то 1/ P(аk) 1. А логарифм числа, большего единицы, всегда неотрицательный, поэтому количество информации всегда неотрицательное. Среднее значение неотрицательных чисел, которое определяет энтропию, также число неотрицательное.

Пример 1.3. Вычислить энтропию источника сообщений с объемом алфавита МА = 4, если вероятности независимых знаков: Р(а1) = 0,5; Р(а2) = 0,25; Р(а3) = Р(а4) = 0,125.

Решение. Согласно формуле (1.4) энтропия источника H(A) = – (0,5 log2 0,5 + + 0,25 log2 0,25 + 2 0,125 log2 0,125) = 1,75 дв.ед./знак.

Пример 1.4. Вычислить максимальную энтропию источника сообщений с объемом алфавита МА = 28.

Решение. Согласно формуле (1.7) максимальная энтропия источника

Hmax(A) = log2 28 = 4,81 дв.ед./знак.

! |

Энтропия источника зависимых сообщений меньше энтропии источника незави- |

симых сообщений, т.е. Hn(A) … H2(A) H1(A) Hmax(A) |

Избыточность источника сообщений – это его свойство выдавать информацию большим количеством знаков, чем можно было бы [1, с. 298...299], [3, с. 278...279].

!Количественно избыточность источника сообщений характеризуется коэффициентом избыточности – расчетная формула (1.8) в табл. Л1.1.

Пример 1.5. Вычислить коэффициент избыточности источника сообщений, заданного в примере 1.3.

Решение. Согласно формуле (1.7) Hmax(A) = log2 4 = 2 дв.ед./знак. Энтропия источника вычислена в примере 1.3 и равняется 1,75 дв.ед./знак. Тогда по формуле (1.8) коэффициент избыточности Kизб = 1 – Н(A)/Нmax(A) = 1 – 1,75/2 = 0,125.

Производительность источника определена в [3, с. 279...280]. Расчетная формула

(1.9).

Производительность источника сообщений, это – средняя скорость выдачи ин-

!формации источником, т.е. среднее количество информации, производимой источником за секунду

Пример 1.6. Вычислить производительность источника дискретных сообщений, описанного в примере 1.3, если длительности сообщений 1, 2, 3 и 4 мс соответственно.

Решение. Энтропия этого источника из примера 1.3 H(A) 1,75 дв.ед./знак, средняя

длительность знаков вычисляется как математическое ожидание Т = 0,5 1 + 0,25 2 + 0,125 3 + 0,125 4 = 1,875 мс. Тогда по формуле (1.9) Rи = 1,75/(1,875 10–3) = 933 дв.ед./с.

Контрольные вопросы

1.1.Дать определения понятия информация.

1.2.Почему применяется логарифмическая мера количества информации?

1.3.Что в теории информации называют энтропией источника и как она определяется для источников независимых и зависимых сообщений?

1.4.Объяснить, какая разность в единицах измерения дв.ед., бит, дв.ед./с, бит/с.

1.5.Объяснить, какое отношение имеет единица измерения количества информации “бит” к двоичной системе исчисления.

1.6.Дать определения понятий производительность и избыточность источника сооб-

щений.

1.7.Перечислить причины появления избыточности источника.