- •Методы нейроинформатики

- •Фцп "интеграция"

- •Предисловие редактора

- •Моделирование данных при помощи кривыхдля восстановления пробелов в таблицах

- •660036, Красноярск-36, ивм со ран,

- •1. Общая схема метода

- •2. Итерационный метод главных компонент для данных с пропусками

- •3. Квазилинейные факторы и формулы Карлемана

- •4. Нейронный конвейер

- •Литература

- •Финитность и детерминированность простых программ для кинетической машины кирдина

- •660036, Красноярск-36, ивм со ран,

- •1. Введение

- •2. Понятие кинетической машины Кирдина

- •3. Модели выполнения программы

- •3.1. Последовательная модель

- •3.2. Параллельно-последовательная модель

- •3.3. Максимальная параллельно-последовательная модель

- •4. Программы, состоящие из одной команды

- •4.1. Распад

- •4.2. Синтез

- •4.3. Прямая замена

- •5. Заключение

- •ЛитературА

- •Алгоритмическая универсальность кинетической машины кирдина

- •660036, Красноярск-36, ивм со ран,

- •Литература

- •Погрешности нейронных сетей. Вычисление погрешностей весов синапсов

- •660036, Красноярск-36, ивм со ран,

- •1. Введение

- •2. Структура сети

- •3. Два базовых подхода к оценкам погрешности

- •4. Погрешности весов синапсов

- •5. Гарантированные интервальные оценки погрешностей весов синапсов

- •6. Среднеквадратические оценки погрешностей весов синапсов

- •7. Заключение

- •Литература

- •Нейросетевые методы обработки информации в задачах прогноза климатических характеристик и лесорастительных свойств ландшафтных зон

- •660036, Красноярск-36, ивм со ран,

- •Введение

- •1. Проблемы обработки таблиц экспериментальных данных

- •2. Искусственные нейронные сети

- •2.1. Элементы нейронных сетей

- •2.2. Архитектуры нейронных сетей

- •2.3. Решение задач нейронными сетями

- •2.4. Подача входных сигналов и снятие выходных сигналов сети

- •2.5. Обучение нейронных сетей

- •2.6. Вычисление градиента функции оценки по подстроечным параметрам сети

- •2.7. Факторы, влияющие на обучение нейронной сети

- •2.8. Упрощение нейронных сетей

- •2.9 Вычисление показателей значимости параметров и входных сигналов сети

- •3. Транспонированная задача регрессии

- •4. Применение нейросетевых технологий для обработки таблицы климатических данных

- •4.1. Заполнение пропусков в таблице климатических данных

- •4.2. Построение классификационной модели ландшафтных зон и секторов континентальности

- •4.2.1. Классификация ландшафтных зон Сибири

- •4.2.2. Идентификация лесных зон по континентальности

- •4.3. Прогнозирование возможного изменения ландшафтных зон и секторов континентальности

- •5. Заключение

- •Литература

- •Интуитивное предсказание нейросетями взаимоотношений в группе

- •660049, Красноярск, пр. Мира 82

- •1. Проблема оценки взаимоотношений

- •2. Общая задача экспериментов

- •3. Применяемые в экспериментах психологические методики

- •4. Эксперименты по предсказанию группового статуса

- •5. Нейросетевое исследование структуры опросника

- •6. Оценка оптимизации задачника нейросетью с позиций теории информации

- •7 Эксперименты по предсказанию парных взаимоотношений

- •Литература

- •Аппроксимация многомерных функций полутораслойным предиктором с произвольными преобразователями

- •660049, Красноярск, пр. Мира 82

- •1. Постановка проблемы

- •2. Аналитическое решение

- •3. Запись решения в идеологии нейросетей

- •4. Алгоритмическая часть

- •5. Оценка информационной емкости нейронной сети при помощи выборочной константы Липшица

- •6. Соглашение о терминологии

- •7. Компоненты сети

- •8. Общий элемент сети

- •9. Вход сети

- •10. Выход сети

- •11. Синапс сети

- •12. Тривиальный сумматор

- •13. Нейрон

- •14. Поток сети

- •15. Скомпонованная полутораслойная поточная сеть

- •Литература

- •Использование нейросетевых технологий при решении аналитических задач в гис

- •660036, Красноярск-36, ивм со ран,

- •Литература

- •Использование нейросетевых технологий для проведения учебно-исследовательских работ

- •1. Введение

- •2. Зимняя Политехническая Школа по Нейроинформатике

- •3. Задачи

- •4. Результаты

- •5. Перспективы

- •Литература

- •Производство полуэмпирических знаний из таблиц данных с помощью обучаемых искусственных нейронных сетей

- •660036, Красноярск-36, ивм со ран,

- •1. Введение

- •2. Логически прозрачные нейронные сети

- •2.1. Архитектура логически прозрачных сетей

- •2.2. Критерии логической прозрачности нейронной сети

- •2.3. Требования к нелинейности элементов

- •3. Контрастирование нейронов

- •4. Приведение нейронных сетей к логически прозрачному виду

- •4.1. Наложение ограничений на архитектуру нейросети

- •4.2. Упрощение нейросети

- •4.3. Приведение настраиваемых параметров сети к предельным значениям и модификация нелинейных преобразователей нейронов

- •4.4. Проведение эквивалентных преобразований структуры нейросети

- •5. Вербализация нейронных сетей

- •6. Автоматическая генерация полуэмпирических теорий

- •7. Когнитологические аспекты

- •8. Влияние функции оценки на логическую прозрачность сети. Исключение примеров

- •9. Как выбирают американских президентов

- •10. Заключение

- •Литература

- •Содержание

3. Запись решения в идеологии нейросетей

Как уже было сказано, выше, ряд вида

![]() может быть представлен как нейронная

сеть, имеющая структуру, показанную на

рис.1.

может быть представлен как нейронная

сеть, имеющая структуру, показанную на

рис.1.

Тогда вычисление градиента функции ошибки Hможно производить, используя схему, двойственную данной. При этом решение задачи может быть существенно упрощено применением следующего приема. Поскольку обучение следующего слоя начинается тогда, когда предыдущие уже обучены, а их связи зафиксированы, то, фактически, каждый нейрон обучается отдельно от других, а в качестве значения, вычисляемогоk-м нейроном берется погрешность вычисления функции предыдущимиk-1 - нейронами, илиFi.

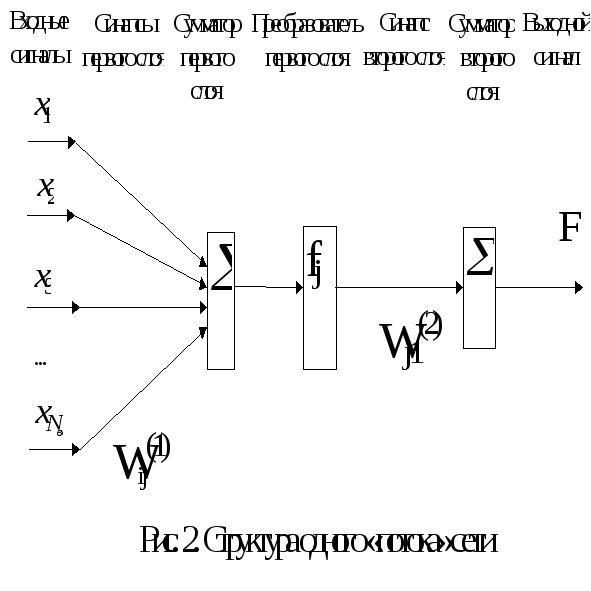

Процесс обучения всей сети сводится этим ее разбиением к ряду последовательных процессов обучения структур вида, представленного на рис. 2.

Здесь x1 - xN - входные сигналы сети,Wij(1)- синапсы первого слоя отi-го входа кj-му сумматору первого слоя,Wj1(2)- синапсы второго слоя отj-го преобразователя к выходному сумматору,fj - j-й преобразователь, символом обозначаются тривиальные сумматоры.

Далее в тексте такая структура будет именоваться «потоком сети» или просто «потоком».

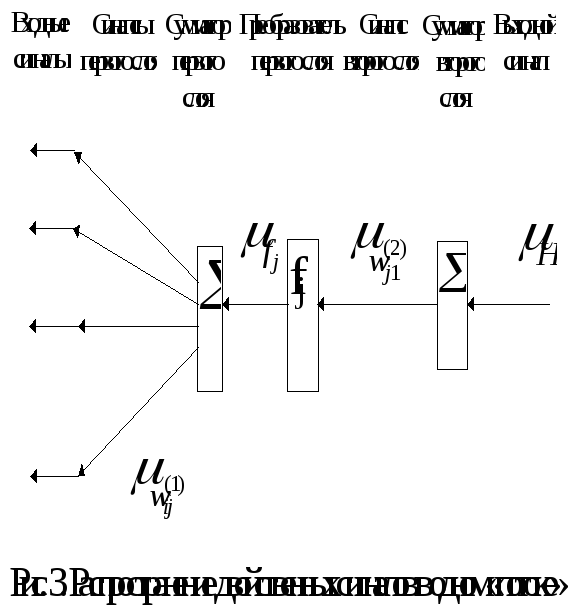

Вычисление производных H (функции ошибки) для сети, представляющего собой один «поток», можно вести на основе аппарата двойственных функций и алгоритма обратного распространения ошибки. Схема прохождения сигналов при обратном функционировании показана на рис. 3.

Здесь

![]() - двойственный сигнал от функции оценки,

передаваемый без изменения через

тривиальный сумматор второго слоя,

- двойственный сигнал от функции оценки,

передаваемый без изменения через

тривиальный сумматор второго слоя,![]() -

двойственный сигнал от соответствующего

синапса второго слоя,

-

двойственный сигнал от соответствующего

синапса второго слоя,![]() -

двойственный сигнал от преобразователяj-го

«потока», передающийся сумматору для

раздачи на синапсы,

-

двойственный сигнал от преобразователяj-го

«потока», передающийся сумматору для

раздачи на синапсы,![]() -

двойственные сигналы соответствующих

синапсов первого слоя.

-

двойственные сигналы соответствующих

синапсов первого слоя.

4. Алгоритмическая часть

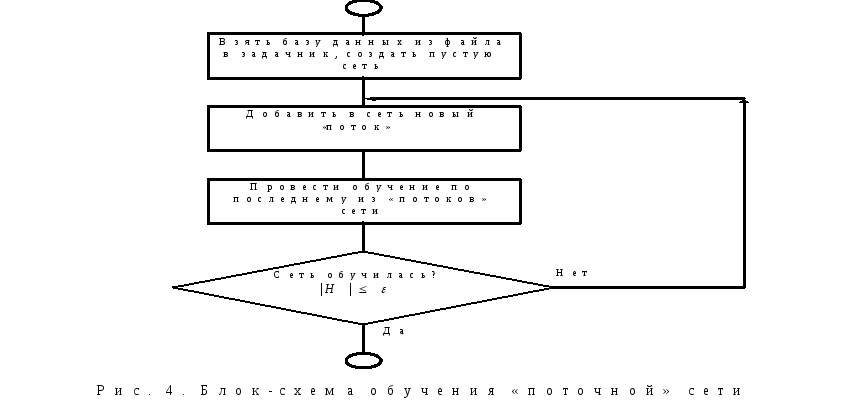

Обучение сети, состоящей из «потоков» производится в соответствии с алгоритмом, представленным на рис. 4.

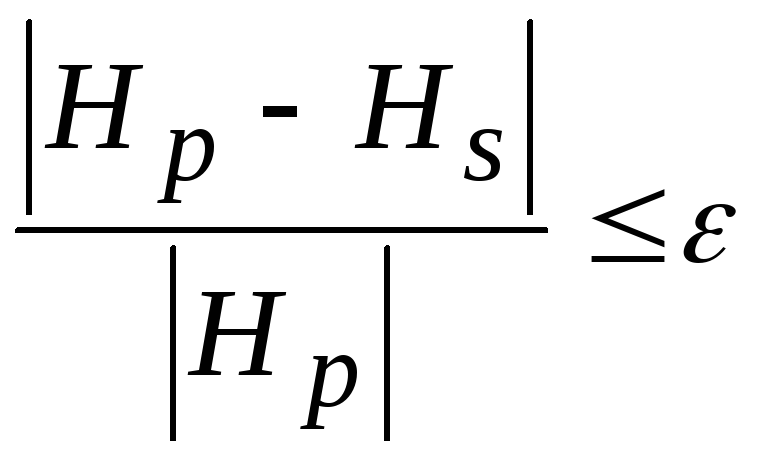

Здесь H - значение оценки сети, накопленное по всему задачнику,- константа малости ошибки.

Для обучения каждого из потоков используется алгоритм, показанный на рис.5. Здесь Nф- общее число функций, по которому идет обучение,o - карта параметров сети,h0 - шаг оптимизации в начале цикла,s - градиент функции оценкиH по обучаемым параметрам.

Используемое в алгоритме условие остановки формируется из двух подусловий, скомбинированных через «или»:

Число шагов оптимизации, во время которых

превысило заранее заданную величину

(при обучении использовалось значениеNsh=15),

то есть сеть в данной конфигурации уже

не может улучшить оценку;

превысило заранее заданную величину

(при обучении использовалось значениеNsh=15),

то есть сеть в данной конфигурации уже

не может улучшить оценку;Достигнуто заданное значение функции оценки

,

то есть сеть уже обучена.

,

то есть сеть уже обучена.

При обучении одного потока используются процедуры подбора шага оптимизации - Increase (поиск шага в сторону возрастания, блок-схему см. на рис. 6),Decrease (поиск шага в сторону убывания, блок-схему см. на рис. 7) иParabola (поиск оптимального шага по формулам параболического поиска блок-схему см. на рис. 8).

В процедурах используются следующие обозначения:

H(...) - функция оценки сети, накопленная по всему задачнику;

h1, h2, h3 - различные значения величины шага оптимизации, используемые при ее подборе;

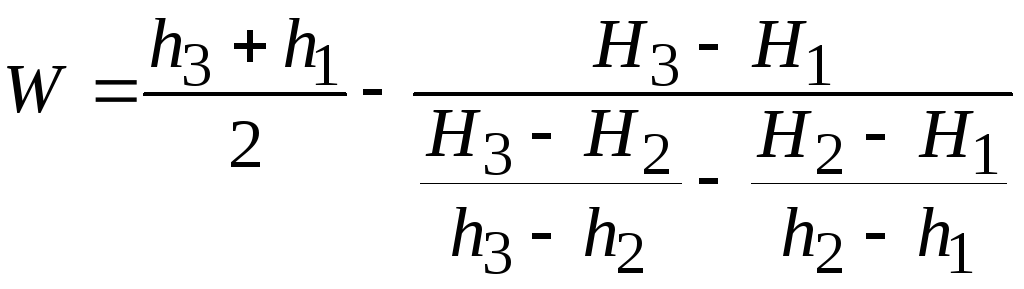

W - величина шага в вершину параболы, проходящей через точки (h1, H1), (h2, H2), (h3, H3). Вычисляется по формуле:

H1, H2, H3 - значения функции ошибки, соответствующие смещению обучаемых параметров по направлению градиента на величину шагаh1, h2 и h3.

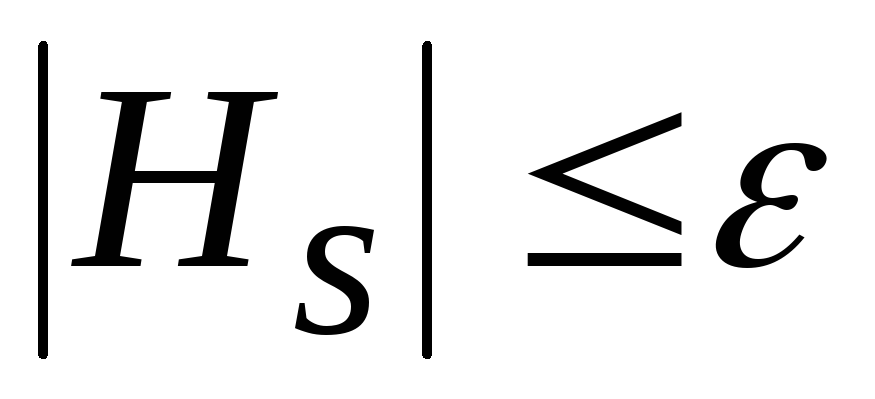

Условие выпуклости комбинации h1,2,3, H1,2,3 определяется формулой

![]()

Если выражение истинно, то условие выпуклости выполнено.

Теперь, рассмотрев алгоритмы обучения сети, перейдем к описанию компонентов, структуры и функционирования сети.