- •1. Предмет и метод статистики

- •1.1 Возникновение и определение статистики

- •1.2. Предмет статистики и особенности статистики как науки

- •1.3. Статистические закономерности

- •1.4. Признаки

- •1.5. Метод статистики

- •1.6. Организация государственной статистики в рф

- •2. Средние величины

- •3. Статистическое наблюдение

- •3.1. Понятие статистического наблюдения. Этапы его проведения

- •3.2. Методологические вопросы статистического наблюдения

- •3.3. Основные организационные формы, виды и способы статистического наблюдения

- •Статистическое наблюдение

- •3.4. Статистическая отчетность

- •3.5. Требования, предъявляемые к данным стат. Наблюдения

- •3 Этап сн: подготовка данных к обработке

- •4. Вариационные ряды и их характеристика

- •4.1. Вариация массовых явлений

- •4.2. Построение вариационного ряда. Виды рядов. Ранжирование данных

- •4.3. Определение числа групп и величины интервала

- •4.4. Плотность распределения

- •4.5. Графическое изображение вариационного ряда

- •4.6. Структурные средние

- •Мода распределения

- •Медиана распределения

- •4.7. Другие структурные характеристики вариационного ряда Квартили и децили распределения

- •4.8. Показатели размера и интенсивности вариации

- •4.9. Свойства дисперсии и способы ее расчета

- •4.10. Дисперсия альтернативного признака

- •4.11. Виды дисперсий и правило их сложения

- •4.12. Закономерности распределения

- •4.13. Закон нормального распределения

- •4.14. Моменты распределения

- •4.15. Асимметрия распределения

- •4.16. Эксцесс распределения

- •5. Статистическая сводка. Группировка данных наблюдений. Таблицы

- •5.1. Статистическая сводка

- •5.2. Группировка данных

- •5.3. Определение числа групп и величины интервалов

- •5.4. Виды группировок

- •Типологические группировки

- •Структурные группировки

- •Аналитические группировки

- •5.5. Классификации

- •5.6. Сопоставимость статистических группировок

- •5.7. Статистические таблицы

- •6. Выборочное наблюдение и его организация

- •6.1. Выборочное наблюдение. Принципы теории выборки

- •6.2. Ошибки репрезентативности. Ошибки выборки

- •6.3. Определение необходимого объема выборки

- •6.4. Виды отбора единиц в выборочную совокупность

- •6.5. Малая выборка

- •6.6. Моментные наблюдения

- •7. Статистические показатели

- •7.1. Сущность статистических показателей

- •Границы объекта:

- •Статистический показатель

- •7.2. Классификация статистических показателей

- •7.3. Абсолютные показатели

- •7.4. Относительные показатели

- •8. Статистические методы изучения взаимосвязи между явлениями

- •8.1. Понятие корреляционной зависимости

- •8.2. Методы выявления корреляционной связи

- •Метод группировок

- •8.3. Изучение связи между двумя атрибутивными (качественными, описательными) признаками

- •8.4. Измерение связи по таблицам взаимной сопряженности

- •8.5. Измерение тесноты связи между порядковыми переменными

- •8.6. Показатели тесноты связи между двумя количественными признаками

- •Линейный коэффициент корреляции

- •8.7. Определение уравнения регрессии между двумя переменными

- •8.8. Теоретическое корреляционное отношение

- •8.9. Множественная корреляция

- •9. Ряды динамики

- •9.1. Понятие о рядах динамики. Их виды

- •9.2. Сопоставимость уровней ряда.

- •9.3. Основные показатели рядов динамики

- •Методы выявления основной тенденции в рядах динамики

- •Выявление и измерение сезонных колебаний

- •Измерение колеблемости в рядах динамики

- •Автокорреляция в рядах динамики

- •Определение уравнения авторегрессии

- •Элементы прогнозирования

- •10. Виды и способы построения индексов

- •10.1. Понятие об индексах. Их виды

- •10.2. Агрегатные индексы

- •1. Агрегатный индекс физического объема.

- •2. Агрегатный индекс цен

- •10.3. Средние индексы из индивидуальных

- •1. Индекс физического объема

- •2. Индекс цен

- •10.4. Индексы переменного и постоянного составов. Индекс структурных сдвигов

- •Iпост .

- •10.5. Цепные и базисные индексы

- •10.6. Определение роли отдельных факторов в динамике результативных показателей

- •10.7. Территориальные индексы

8.3. Изучение связи между двумя атрибутивными (качественными, описательными) признаками

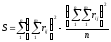

Для определения

тесноты связи двух качественных признаков

(c

альтернативной вариацией признака),

каждый из которых состоит из двух групп,

рассчитывают коэффициенты

ассоциации  и контингенции

и контингенции

на основе построения таблицы

сопряженности:

на основе построения таблицы

сопряженности:

|

a |

b |

a + b |

|

c |

d |

c + d |

|

a + c |

b + d |

a + b + c + d |

Таблица сопряженности

размерностью

называется «таблицей 4-х полей», частоты

признака в полях таблицы обозначим

соответственно

называется «таблицей 4-х полей», частоты

признака в полях таблицы обозначим

соответственно .

.

Таблица показывает связь между двумя явлениями с альтернативной вариацией признака.

Коэффициенты

ассоциации

служит для определения тесноты связи

двух признаков с альтернативной

вариацией, и рассчитывается по формуле:

служит для определения тесноты связи

двух признаков с альтернативной

вариацией, и рассчитывается по формуле: .

.

Недостаток коэффициента ассоциации: если в одной из 4-х клеток таблицы частота равна нулю, значение коэффициента ассоциации по модулю будет равно единице, что преувеличивает меру действительной связи.

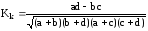

Коэффициент

контингенции

служит для определения тесноты связи

двух качественных признаков, каждый из

которых состоит из двух групп, и

рассчитывается по формуле:

служит для определения тесноты связи

двух качественных признаков, каждый из

которых состоит из двух групп, и

рассчитывается по формуле: .

.

Коэффициент

контингенции всегда меньше коэффициента

ассоциации. Связь считается существенной,

если

≥0,5;

≥0,5; ≥0,3.

≥0,3.

8.4. Измерение связи по таблицам взаимной сопряженности

Если каждый из качественных признаков состоит из большого числа групп (более двух), то теснота связи измеряется на основе таблицы сопряженности с помощью коэффициентов взаимной сопряженности Пирсона и Чупрова.

Таблица сопряженности в этом случае имеет вид:

|

Y

X |

I |

II |

III |

Всего |

|

I |

|

|

nxy |

nx |

|

II |

|

|

|

nx |

|

III |

|

|

|

nx |

|

Итого |

ny |

ny |

ny |

n |

Коэффициент

взаимной сопряженности Пирсона

;

;

где

– показатель взаимной сопряженности:

– показатель взаимной сопряженности: ;

;

nxy – частота каждой клетки таблицы взаимной сопряженности, (т.е. частоты взаимного сочетания 2-х атрибутивных (описательных) признаков);

nx, ny – итоговые частоты соответствующих строк и столбцов.

Недостаток коэффициента Пирсона в том, что он не достигает единицы и при полной связи признаков, а лишь стремится к единице при увеличении числа групп.

Более совершенная мера связи предложена Чупровым.

Коэффициент

взаимной сопряженности Чупрова

,

,

К1, К2 – число строк и столбцов.

Коэффициент взаимной сопряженности Чупрова может достигать предельного значения, равного единице, только в случае квадратной таблицы (m=p): чем более несимметрична таблица, тем больше коэффициент Чупрова отличается от единицы при полной связи признаков. Как привило, коэффициент Чупрова гораздо строже оценивает тесноту связи, чем коэффициент Пирсона, слишком быстро приближающийся к единице.

8.5. Измерение тесноты связи между порядковыми переменными

Коэффициент корреляции рангов (коэффициент Спирмена) учитывает согласованность рангов. (Ранг – порядковый номер, присваиваемый каждому значению факторного и результативного признака в ранжированном ряду).

Коэффициент Спирмена

рассчитывается по формуле:

,

,

где n – количество единиц совокупности; d – разность рангов по признакам х и y.

Порядок сопоставления рангов факторного и результативного показателей таков: единицы совокупности ранжируются по факторному и результативному признакам и каждой единице присваивается номер (место) в упорядоченном ряду признаков. Если встречаются в ряду одинаковые варианты по результативному и факторному признакам, то каждой из них присваивается среднее арифметическое значение их рангов, т.е. наблюдаются т.н. связанные ранги.

Коэффициент корреляции рангов может принимать значения от –1 до +1. Значение = +1 означает строгое изменение рангов в одном направлении, = –1 – в противоположном, при = 0 связь отсутствует.

Недостаток

коэффициента корреляции рангов:

одинаковым разностям рангов могут

соответствовать неодинаковые разности

значений признаков (количественных).

Следовательно, для количественных

признаков

является приближенной мерой тесноты

связи.

является приближенной мерой тесноты

связи.

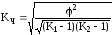

Коэффициент

конкордации (множественный коэффициент

ранговой корреляции) применяют

для определения

тесноты связи между произвольным числом

признаков:

,

,

где m – количество факторов, n – число единиц наблюдения (ранжируемых единиц),

S

– отклонение суммы квадратов суммы

рангов по всем факторам от среднего

квадрата суммы рангов.