- •Глава 3 Основы количественной теории информации

- •3.1. Основные понятия теории информации

- •3.2. Количество информации

- •Количество информации для равновероятных символов в сообщении

- •Количество информации для неравновероятных независимых символов в сообщении

- •Количество информации в случае неравновероятных зависимых символов

- •3.3. Энтропия и ее свойства

- •Свойства энтропии

- •01/E 1

- •Условная энтропия

- •Энтропия непрерывных сообщений

- •Относительная энтропия

- •3.4. Количественные характеристики источника сообщений Избыточность сообщения

- •Экономичность источников информации

- •Производительность источника сообщений

- •Вопросы и задачи к главе 3

Энтропия непрерывных сообщений

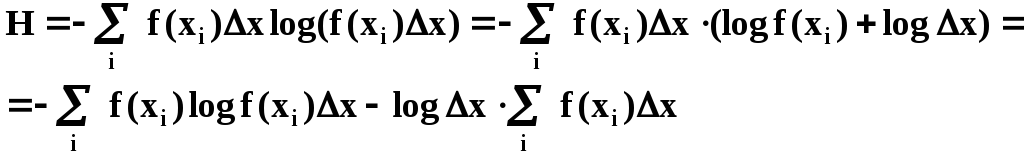

Рассмотрим систему, где качественные признаки состояния изменяются непрерывно (непрерывный сигнал). Вероятность нахождения системы в состоянии х(т.е. сигнал принимает значениех) характеризуется плотностью вероятностиf(x). Чтобы найти энтропию такого сообщения, разбиваем диапазон возможного изменения сигнала на дискреты размером∆x.

Вероятность нахождения системы в i-й дискрете равна

P(xi) = f(xi)∙x

Тогда энтропия системы вычисляется так:

при малых Δх:

![]()

А также

![]()

Таким образом

![]() (3.13)

(3.13)

Если ∆х=1 (это зависит

от масштаба), то![]()

Величина Н*называетсяприведеннойилидифференциальнойэнтропией.

При уменьшении ∆хНстремится к∞. Это естественно, т.к. чем точнее мы хотим задать состояние системы, тем большую степень неопределенности мы должны устранить. Дифференциальная энтропия не является мерой количества информации, хотя и характеризует степень неопределенности, присущую источнику.

Относительная энтропия

Идеальные сообщения, имеющие максимальную энтропию, оптимальны в том смысле, что в них на один символ (элемент, уровень квантования) приходится наибольшее количество информации.

В реальных сообщениях символы всегда коррелированны (после запятой не появляется точка, после гласной мягкий знак), вследствие чего количество информации, приходящееся на один символ будет меньше, чем в идеальных. Соотношение реальных и оптимальных сообщений выражается посредством коэффициента сжатия(относительная энтропия)

![]()

где n0иnp– количество символов оптимального и реального сообщения.

Одно и то же количество информации I(s)может содержаться в сообщении, состоящим изnpсимволов с энтропиейНр(s)или изn0символов с энтропиейН0(s)

I(s) = np∙Hp(s) = n0∙H0(s), а так как Hp(s)≤H0(s), то npn0.

3.4. Количественные характеристики источника сообщений Избыточность сообщения

Коэффициент избыточности выражается так

Он показывает, какая часть реального сообщения является излишней и могла бы не передаваться, если бы сообщение было организовано оптимально.

Экономичность источников информации

Энтропию можно увеличивать за счет обеспечения равновероятности символов алфавита, а также за счет увеличения мощности алфавита. Однако увеличение мощности алфавита приводит к сложностям приема-передачи информации (непрерывный сигнал передается и воспринимается с погрешностями, китайские иероглифы трудны для освоения, для них не хватает клавиш на клавиатуре…), к увеличению избыточности сообщений (в языках программирования ряд команд применяется редко). Существует теоретический оптимум для мощности алфавита.

Пусть имеется источник с алфавитом мощности m. Тот же алфавит можно получить, используя два источника с алфавитамиm/2или три источника с алфавитамиm/3и т.д. При какой мощности алфавитаmобщая энтропия будет максимальной, еслиk∙m = const, гдеk– количество независимых источников, аm– это мощность алфавита каждого источника? (Под независимыми источниками можно понимать и независимые сигналы одного источника)

Пусть k∙m = а. Энтропия композиции независимых источников равна

![]()

k = а/m

![]()

Найдем максимум энтропии, для чего продифференцируем по m

![]()

![]()

m = e

Оптимальная мощность алфавита теоретически равна основанию натуральных логарифмов е(2.718281828459045…), а практически – трем.

Очевидно, что троичный алфавит является более экономичным, чем двоичный. Именно поэтому в истории развития вычислительной техники были случаи создания компьютеров, использующих троичный алфавит. В 1958 году группа советских инженеров под руководством конструктора Н.П. Брусенцова представила электронно-вычислительную машину «Сетунь», работающую на принципах троичной логики. Элементной базой такого компьютера были магнитные усилители на ферритовых сердечниках. Они допускали три устойчивых состояния: ток в прямом направлении (логическая «единица»), ток в обратном направлении (логическая «минус единица») и отсутствие тока (логический «ноль»). Машины этой серии выпускались с 1962 по 1964 год и отличались исключительной надежностью. Архитектурно они были совершеннее «двоичных» полупроводниковых аналогов. Помешали их массовому распространению миниатюризация, удешевление и повышение надежности полупроводниковых элементов. «Сетунь» стала экономически невыгодной.