- •Глава 3 Основы количественной теории информации

- •3.1. Основные понятия теории информации

- •3.2. Количество информации

- •Количество информации для равновероятных символов в сообщении

- •Количество информации для неравновероятных независимых символов в сообщении

- •Количество информации в случае неравновероятных зависимых символов

- •3.3. Энтропия и ее свойства

- •Свойства энтропии

- •01/E 1

- •Условная энтропия

- •Энтропия непрерывных сообщений

- •Относительная энтропия

- •3.4. Количественные характеристики источника сообщений Избыточность сообщения

- •Экономичность источников информации

- •Производительность источника сообщений

- •Вопросы и задачи к главе 3

Свойства энтропии

Энтропия принимает значение, равное 0, только в случае детерминированного источника сообщений системы.

Детерминированность источника означает, что один из возможных символов генерируется источником постоянно (с единичной вероятностью), а остальные – не производятся вовсе. Предположим для определенности, что генерируется k-й символ.

Пусть P(ak)=1 , а P(ai)=0 для всех i=1,m ik

Тогда, обозначив элемент суммы в формуле (3.8) через hi, получим

![]()

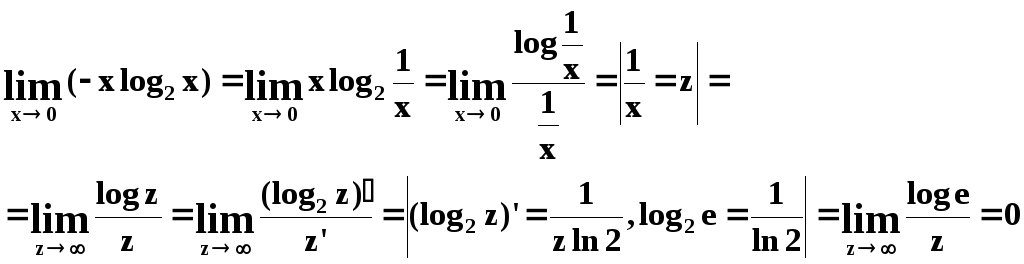

Раскроем неопределенность вида 0∙∞по правилу Лопиталя.

Следовательно, для детерминированного источника hi= 0 для всехi. С другой стороны, если ни однаp(ai)1, то ни одно слагаемоеhiне обращается в0. Что и требовалось доказать.

Энтропия - величина неотрицательная и ограниченная.

Если каждое слагаемое hi=-p(ai)log2p(ai)неотрицательно и ограниченно, то и их сумма также будет неотрицательна и ограниченна.

Докажем неотрицательность:

p(a) 0; p(a) ≤ 1 log p(a) ≤ 0 - p(a) log p(a) 0

Докажем ограниченность, продифференцировав по p:

![]()

Следовательно, величина hiимеет экстремум (можно доказать, что это максимум), а значит это величина ограниченная (см. рис.3.2)

h i

i

pi

01/E 1

Рис. 3.2. К свойству ограниченности энтропии.

Энтропия системы, имеющей m равновероятных состояний, максимальна и равна log2m.

Докажем максимальность

Пусть m=2, тогдаp1+p2=1

H = -p1∙logp1 - p2∙logp2 = -p1∙logp1-(1-p1)∙log(1-p1). Чтобы найти максимум энтропии, определим и приравняем нулю частную производную.

-log p1 + log(1-p1) = 0

p1= ½ = p2

Следовательно, при двух символах в алфавите максимум энтропии достигается в случае равновероятных символов. То же можно доказать и для большего числа символов в алфавите.

Найдем значение максимальной энтропии. Пусть все символы равновероятны: pi = 1/m.

![]()

Совместная энтропия независимых источников сообщений равна сумме энтропий.

Пусть источник Апорождает ансамбльNaсообщений(a1, a2,…, aNa),источникBпорождает ансамбльNbсообщений(b1, b2,…, bNb) и источникинезависимы. Общий алфавит источников представляет собой множество пар вида(ai, bj),общая мощность алфавита равнаNaNb.

Совместная энтропия композиции двух источников равна

![]()

Поскольку AиBнезависимы, тоP(ai,bj) = P(ai)∙P(bj),alog P(ai,bj) = log P(ai) + log P(bj).Отсюда вытекает:

Изменим порядок суммирования

![]()

учитывая, что

![]() и

и![]() ,

получим

,

получим

![]() (3.9)

(3.9)

Вывод можно распространить и на большее количество независимых источников

Условная энтропия

Найдем совместную энтропию сложной информационной системы (композиции A,B) в том случае, если их сообщения не являются независимыми, т.е. если на содержание сообщенияBоказывает влияние сообщениеA.

Например, сообщение «Спартак выиграл в футбольном матче против Динамо» полностью снимает неопределенность сообщения о том, как сыграло Динамо.

Другой пример: сообщение Асодержит информацию о женщине (фамилию, имя, отчество, год рождения, место рождения, образование, домашние адрес и телефон), а сообщениеВсодержит аналогичную информацию о ее муже. Очевидно, что сообщениеВчастично содержит в себе информациюА(а именно: фамилию жены, ее домашний адрес и телефон, скорее всего совпадающие с фамилией, домашним адресом и телефоном мужа, а также вероятностную оценку ее года рождения, который скорее всего близок к году рождения мужа). Таким образом, совместная энтропия двух сообщений не является простой суммой энтропий отдельных сообщений.

Пусть источник Апорождает ансамбльNaсообщений(a1, a2,…, aNa),источникBпорождает ансамбльNbсообщений(b1, b2,…, bNb)и источникизависимы. Общий алфавит источников представляет собой множество пар вида(ai, bj), общая мощность алфавита:NaNb.

Энтропия сложной информационной системы (из двух источников) равна

![]()

Поскольку AиBзависимы, тоP(ai,bj) = P(ai)∙P(bj|ai),

a log P(ai,bj) = log P(ai) + log P(bj|ai). Подставив это в выражение для энтропии сложной системы, получаем:

В первом слагаемом индекс jимеется

только уB,изменив порядок суммирования,

получим член вида:![]() ,

который равен1поскольку

характеризует достоверное событие

(какое-либо сообщений bj

в любом случае реализуется). Следовательно,

первое слагаемое оказывается равным:

,

который равен1поскольку

характеризует достоверное событие

(какое-либо сообщений bj

в любом случае реализуется). Следовательно,

первое слагаемое оказывается равным:

![]()

Во втором слагаемом члены вида

![]() имеют смысл энтропии

источника B

при условии, что реализовалось сообщение

ai

– будем называть

ее частной условной

энтропией. Если ввести

данное понятие и использовать его

обозначение, то второе слагаемое будет

иметь вид:

имеют смысл энтропии

источника B

при условии, что реализовалось сообщение

ai

– будем называть

ее частной условной

энтропией. Если ввести

данное понятие и использовать его

обозначение, то второе слагаемое будет

иметь вид:

![]() , (3.10)

, (3.10)

где H(B|A) есть общая условная энтропия источника В относительно источника А. Окончательно получаем для энтропии сложной системы:

H(A, B) = H(A) + H(B|A) (3.11)

Полученное выражение представляет собой общее правило нахождения энтропии сложной системы. Совершенно очевидно, что выражение (3.9) является частным случаем (3.11) при условии независимости источников АиВ.

Относительно условной энтропии можно высказать следующие утверждения:

Условная энтропия является величиной неотрицательной. Причем H(B|A) = 0 только в том случае, если любое сообщение А полностью определяет сообщение В, т.е.

H(B|a1) = H(B|a2) =…= H(B|aN) = 0

В этом случае H(А,B) = H(A).

Если источники А и В независимы, то H(B|A) = H(B), причем это оказывается наибольшим значением условной энтропии. Другими словами, сообщение источника А не может повысить неопределенность сообщения источника В; оно может либо не оказать никакого влияния (если источники независимы), либо понизить энтропию В.

Приведенные утверждения можно объединить одним неравенством:

0 ≤ H(B|A) ≤ H(B), (3.12)

т.е. условная энтропия не превосходит безусловную.

Из соотношений (3.11) и (3.12) следует, что

H(A, B) ≤ H(A) + H(B),

причем равенство реализуется только в том случае, если источники АиВнезависимы.