- •Глава 7. Основы теории информации

- •7.1. Информационные характеристики источников сообщений

- •7.1.1. Определение количества информации

- •, (7.1)

- •Определение количества информации по к. Шеннону

- •Энтропия сообщения. Среднее количество информации по всем состояниям системы:

- •7.1.2. Информационные характеристики источников дискретных сообщений

- •Измеряется производительность источника в единицах измерения информации, отнесенных к единице времени - секунде.

- •7.1.3. Информационные характеристики источников непрерывных сообщений

- •7.2. Информационные характеристики каналов электросвязи

- •7.2.1. Вероятностные модели каналов связи в теории информации

- •7.2.2. Информационные характеристики каналов связи Информация

- •7.2.4. Обменность канальных ресурсов

7.2. Информационные характеристики каналов электросвязи

7.2.1. Вероятностные модели каналов связи в теории информации

В данном вопросе ограничимся моделью дискретного канала связи (ДКС).

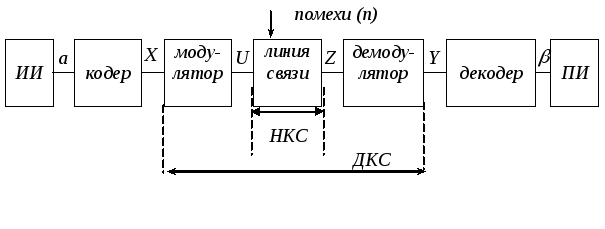

Напомним, что ДКС представляет собой совокупность средств, предназначенных для передачи дискретных сигналов. Дискретный канал связи состоит из модулятора, непрерывного канала и демодулятора (рис.7.5).

Рис.7.5.

Обобщенная структурная схема системы

передачи информации

Рис.7.5.

Обобщенная структурная схема системы

передачи информации

Сообщение

![]() источника информации (ИИ) после кодирования

преобразуется в символ

источника информации (ИИ) после кодирования

преобразуется в символ![]() и модуляции превращается в сигнал

и модуляции превращается в сигнал![]() ,

поступающий в линию связи. В результате

воздействия на

,

поступающий в линию связи. В результате

воздействия на![]() помех сигнал

помех сигнал![]() на приемной стороне отличается от

на приемной стороне отличается от![]() .

.

Приемная часть

содержит демодулятор, преобразующий

![]() в символ

в символ![]() и декодер, преобразующий символ

и декодер, преобразующий символ![]() в сообщение

в сообщение

![]() ,

поступающий к получателю информации.

,

поступающий к получателю информации.

На вход канала

подаются дискретные символы ![]() ,

образующие алфавит источника сообщений

,

образующие алфавит источника сообщений

![]() ,

,![]() ,

,![]() ,…,

,…,![]() ,.

,.

На выходе дискретного

канала появляются дискретные символы

![]() ,

которые характеризуются совокупностью

символов

,

которые характеризуются совокупностью

символов![]() ,

,![]() ,

,![]() ,…,

,…,![]() (рис.7.6).

(рис.7.6).

Каждое из передаваемых

символов ![]() ,

,![]() ,

,![]() ,…,

,…,![]() характеризуется вероятностью появления

на выходе источника

характеризуется вероятностью появления

на выходе источника![]() ,

,![]() ,…,

,…,![]() .

.

Канал связи

характеризуется априорными условными

вероятностями переходов (рис.7.6)

![]() .

Если

.

Если![]() =

=![]()

![]() ,

где

,

где![]() - вероятность правильного приема и

- вероятность правильного приема и![]() ,

при

,

при![]() ,

где

,

где![]() - вероятность ошибки, то такой канал

называется симметричным.

- вероятность ошибки, то такой канал

называется симметричным.

7.2.2. Информационные характеристики каналов связи Информация

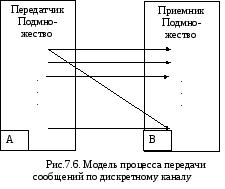

Источник информации (передатчик) и приемник можно рассматривать как подсистемы одной сложной системы.

Если рассматривать

рис.7.5 в качестве модели процесса

передачи сообщений по дискретному

каналу, то можно выделить ансамбль

символов на выходе источника

![]() и ансамбль символов на входе приемника

(получателя)

и ансамбль символов на входе приемника

(получателя)![]() .

.

Каждый из этих ансамблей характеризуется своим распределением вероятностей:

![]()

Объединение этих ансамблей характеризуется взаимными вероятностями

![]() .

.

Условную информацию можно определить из выражения

![]() .

.

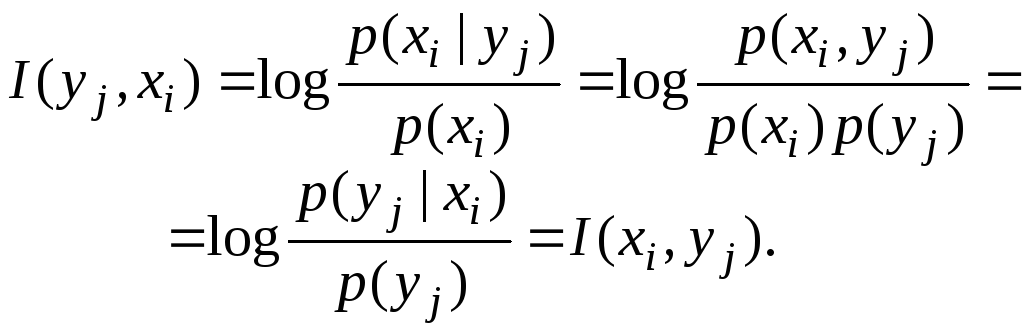

Взаимную информацию между состояниями подсистем можно записать в виде

![]() .

.

Умножая

числитель и знаменатель под логарифмом

на

![]() и учитывая

равенства

и учитывая

равенства

![]() ,

,

получим

(7.20)

(7.20)

Отсюда следует,

что

![]() несет об

несет об![]() такое же количество информации, какое

такое же количество информации, какое![]() несет об

несет об![]() (свойство симметрии). Поэтому

(свойство симметрии). Поэтому

![]() называется взаимным количеством

информации между

называется взаимным количеством

информации между![]() -м

символом множества

-м

символом множества![]() и

и![]() -м

символом множества

-м

символом множества![]() ..

..

Поскольку сложная

система случайным образом приходит в

то

или иное

состояние, определяемое парой

![]() ,

то

,

то

![]() будет случайной величиной, которую

можно усреднить по всему множеству

состояний.

будет случайной величиной, которую

можно усреднить по всему множеству

состояний.

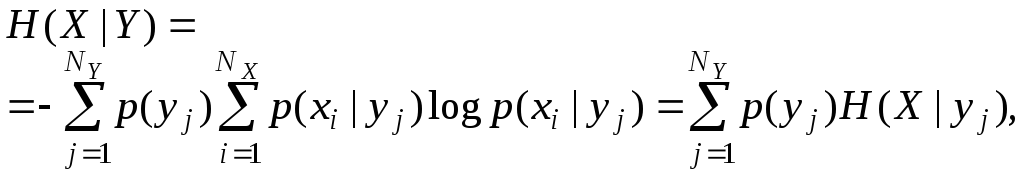

Энтропия, среднее количество информации в принятом сообщении

При передаче дискретных сообщений по ДКС различают следующие энтропии:

-безусловная

энтропия источника, или среднее

количество информации на символ,

выдаваемое источником.

-безусловная

энтропия источника, или среднее

количество информации на символ,

выдаваемое источником. –безусловная

энтропия приемника или среднее количество

информации на символ, получаемое

приемником.

–безусловная

энтропия приемника или среднее количество

информации на символ, получаемое

приемником.

–условная энтропия

YотносительноХ,

или мера количества информации в

приемнике, когда известно, что передаетсяХ. Эта энтропия характеризует

количество ложной информации, создаваемой

помехами:

–условная энтропия

YотносительноХ,

или мера количества информации в

приемнике, когда известно, что передаетсяХ. Эта энтропия характеризует

количество ложной информации, создаваемой

помехами:

![]() (7.21)

(7.21)

–условная энтропия

XотносительноY,

или мера количества информации об

источнике, когда известно, что принимаетсяY. Характеризует

количество информации, потерянной за

счет помех:

–условная энтропия

XотносительноY,

или мера количества информации об

источнике, когда известно, что принимаетсяY. Характеризует

количество информации, потерянной за

счет помех:

![]() (7.22)

(7.22)

Условную энтропию можно так же представить в виде

где величина

![]() (7.23)

(7.23)

называется частной

условной энтропией.

Она характеризует неопределенность

состояния системы А (передатчика) в

случае, когда известно состояние

![]() у наблюдаемой

системы В (приемника). Зафиксировав

состояние

у наблюдаемой

системы В (приемника). Зафиксировав

состояние

![]() системы В, мы тем самым изменяем комплекс

условий,

при которых

может реализоваться событие

системы В, мы тем самым изменяем комплекс

условий,

при которых

может реализоваться событие

![]() .

Это обнаруживается как изменение

вероятности реализации события

.

Это обнаруживается как изменение

вероятности реализации события

![]()

![]() (имеет место статистическая зависимость).

Если до изменения условий указанная

вероятность была равна безусловной

(полной) вероятности

(имеет место статистическая зависимость).

Если до изменения условий указанная

вероятность была равна безусловной

(полной) вероятности

![]() ,

то после

изменения условий она стала равной

условной вероятности

,

то после

изменения условий она стала равной

условной вероятности

![]() .

При отсутствии статистической зависимости

.

При отсутствии статистической зависимости

![]() ,

поскольку

,

поскольку

![]()

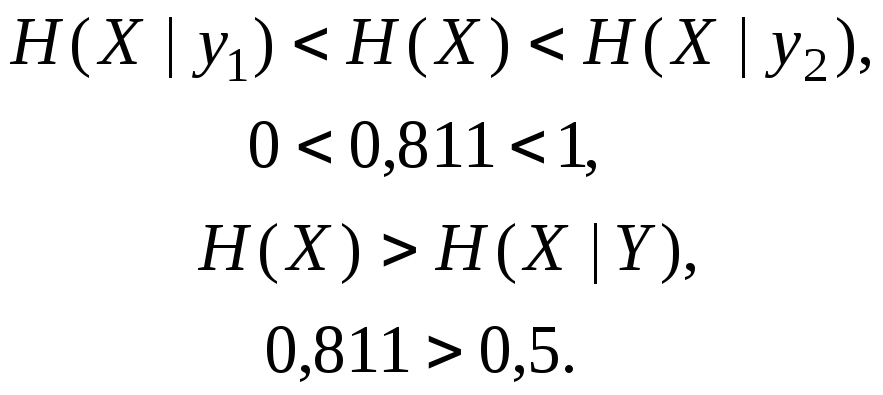

При наличии

статистической зависимости энтропия

![]() может оказаться как меньше, так и больше

может оказаться как меньше, так и больше![]() .

Напомним, что для энтропии

.

Напомним, что для энтропии

![]() всегда справедливо неравенство

всегда справедливо неравенство

![]() .

.

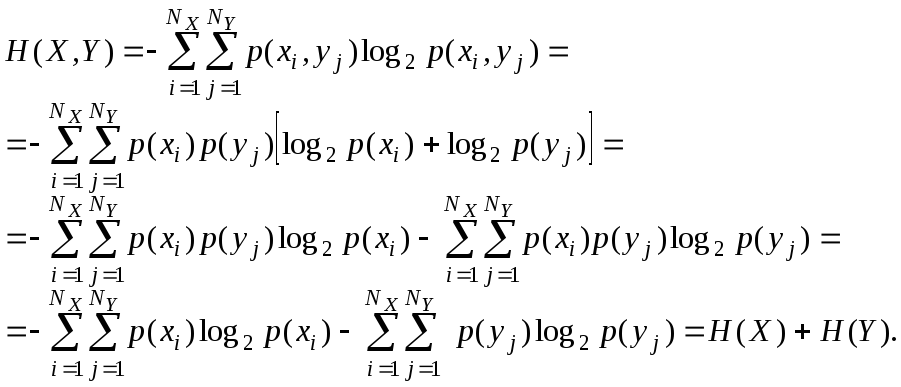

–совместная

энтропия системы передачи (энтропия

объединения) – средняя информация на

пару (переданного и принятого) символов:

–совместная

энтропия системы передачи (энтропия

объединения) – средняя информация на

пару (переданного и принятого) символов:

![]() .

(7.24)

.

(7.24)

Для независимых систем

![]()

Для зависимых систем

![]()

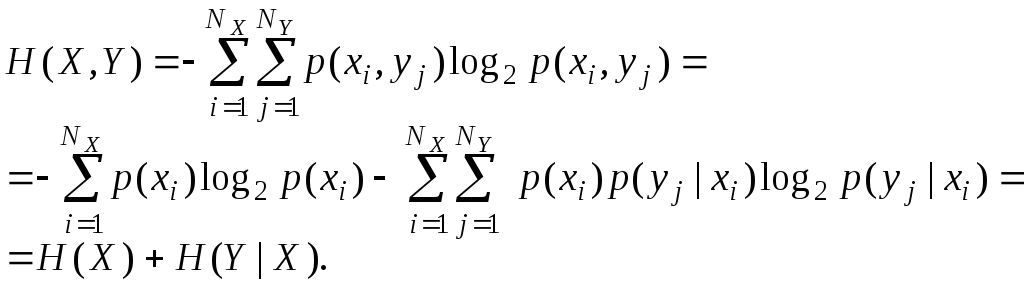

В качестве примера

вычислим энтропии

![]() ,

,

![]() ,

,

![]() и взаимную информацию

и взаимную информацию

![]() ,

когда системы А и В описываются двумерным

распределением

,

когда системы А и В описываются двумерным

распределением

![]() ,

заданным в виде табл.

7.1. Вычисленные

значения условной вероятности

,

заданным в виде табл.

7.1. Вычисленные

значения условной вероятности

![]() записаны в табл.

7.2

записаны в табл.

7.2

Таблица

7.1. Двумерное распределение

![]()

|

y |

x1 |

x2 |

p(yj) |

|

y1 y2 |

|

|

0,5 0,5 |

|

p(xi) |

0,75 |

0,25 |

|

Таблица 7.2. Условные вероятности

|

y |

x1 |

x2 |

|

y1 y2 |

|

|

Используя записанные в таблицах значения вероятностей, получим

![]()

![]()

![]()

![]()

![]()

![]()

![]()

Отсюда

Скорость передачи информации

Скорость передачи информации по дискретному каналу связи без помех

Среднее количество информации, переносимое одним символом равно энтропии символа на входе канала

![]() .

.

Скорость

передачи информации

![]() будет

зависеть от количества информации

будет

зависеть от количества информации![]() ,

приходящейся на один символ, или энтропии

символаН(Х)

на входе канала и скорости передачи

элементарных символов сигнала

,

приходящейся на один символ, или энтропии

символаН(Х)

на входе канала и скорости передачи

элементарных символов сигнала

![]() :

:

![]() ,,

(7.25)

,,

(7.25)

где

![]() ,

,![]() - длительность элементарного символа.

- длительность элементарного символа.

Скорость передачи информации по дискретному каналу связи с помехами

Среднее количество информации, переносимое одним символом при наличии помех

![]()

![]() .

.

Тогда скорость передачи информации:

![]() .

(7.26)

.

(7.26)

Смысл соотношения (7.26) представляется моделью, приведенной на рис. 7.7.

Рис. 7.7. Модель системы передачи информации в условиях помех

Источник входных

символов выдаёт среднее количество

информации

![]() .

За счет помех часть этой информации

теряется в канале

.

За счет помех часть этой информации

теряется в канале![]() и создается ложная информация

и создается ложная информация![]() .

Количество информации на выходе (полная,

а не относительно источника!) равно

сумме количества информации

.

Количество информации на выходе (полная,

а не относительно источника!) равно

сумме количества информации![]() переданного по каналу и ложной информации

переданного по каналу и ложной информации![]() создаваемой помехами. Смысл обозначения

на рисунке 7.7 следующий:

создаваемой помехами. Смысл обозначения

на рисунке 7.7 следующий:![]() – производительность источника

передаваемых сообщений;

– производительность источника

передаваемых сообщений;![]() – производительность канала, т.е. полная

информация в принятом сигнале за единицу

времени,

– производительность канала, т.е. полная

информация в принятом сигнале за единицу

времени,![]() – скоростьутечки

информации при прохождении через канал.

– скоростьутечки

информации при прохождении через канал.

![]() – скорость передачи посторонней

информации, не имеющей отношения к

– скорость передачи посторонней

информации, не имеющей отношения к![]() и создаваемой присутствующими в канале

помехами. Практически, это информация

о помехах, получаемая на выходе канала.

и создаваемой присутствующими в канале

помехами. Практически, это информация

о помехах, получаемая на выходе канала.

Рассмотрим пример

определения скорости передачи информации

по каналу связи. Пусть источник сообщений

вырабатывает символы с вероятностями

![]() ;

;![]() ;

;![]() .

Корреляция между символами отсутствует.

Передача осуществляется двоичным кодом.

Длительность элемента кода

.

Корреляция между символами отсутствует.

Передача осуществляется двоичным кодом.

Длительность элемента кода![]() мс.

мс.

Необходимо определить скорость передачи информации.

Скорость передачи информации определим из выражения

![]() .

.

Для этого определим среднюю энтропию сообщений на один символ. Для этого используем выражение для нашего случая:

![]() Для

передачи трех сообщений двоичным кодом

необходимо хотя бы два разряда, т.е.

кодовая комбинация должна состоять из

двух элементов. Значит, длина кодовой

комбинации

Для

передачи трех сообщений двоичным кодом

необходимо хотя бы два разряда, т.е.

кодовая комбинация должна состоять из

двух элементов. Значит, длина кодовой

комбинации ![]() ,

а

скорость передачи сигналов

,

а

скорость передачи сигналов

![]()

Скорость передачи информации составит

![]()

Пропускная способность каналов связи

Пропускная способность дискретных каналов связи

Пропускной способностью канала связи называется максимально возможная скорость передачи по этому каналу, которая обеспечивается при источнике с максимальной энтропией.

Еще раз подчеркнем, пропускная способность – характеристика канала связи. Для дискретного канала она зависит от технической скорости передачи, которая ограничивается полосой пропускания канала, и от потерь информации. Последние зависят от помех, действующих в канале, способов обработки сигналов в передатчике и приемнике, а также и от технической скорости передачи. Рассмотрим с точки зрения пропускной способности дискретный канал связи без помех и дискретный канал связи с помехами.

Пропускная способность дискретного канала без помех

Докажем, что для дискретного канала пропускная способность зависит от технической скорости передачи.

Известно, что среднее количество информации, переносимое одним символом, равно энтропии символа на входе канала

![]() [бит/символ].

[бит/символ].

Скорость

передачи информации будет зависеть от

количества информации, приходящейся

на один символ или энтропии символа

H(X)

на входе канала и скорости передачи

элементарных символов сигнала

(электрических

кодовых сигналов)

![]() .

.

Т.е.:

![]() [бит./с].

(7.27)

[бит./с].

(7.27)

Из выражения (7.27) следует, что пропускная способность канала связи это действительно наибольшая теоретически достижимая для данного канала скорость передачи информации. От свойства сигнала пропускная способность не зависит.

Пропускная способность представляет собой максимальное количество информации, которое можно передать по каналу при данных условиях за единицу времени. Математически это записывается в следующей форме:

![]() (7.28)

(7.28)

где

![]() – пропускная способность,

– пропускная способность,

![]() –

количество информации, передаваемое в

единицу времени с помощью входных

сигналов

–

количество информации, передаваемое в

единицу времени с помощью входных

сигналов

![]() и выходных

и выходных![]() .

.

Запись

![]() означает, что отыскание максимума

выражения (7.28) ведется по всем возможным

источникам сообщений.

означает, что отыскание максимума

выражения (7.28) ведется по всем возможным

источникам сообщений.

Считая,

скорость передачи

![]() заданной и раскрывая значение

заданной и раскрывая значение

![]() получим, что максимальная скорость

передачи информации будет обеспечена

при максимальном значении энтропии

сигнала.

получим, что максимальная скорость

передачи информации будет обеспечена

при максимальном значении энтропии

сигнала.

Известно, что максимальное значение энтропии обеспечивается при равномерном распределении вероятностей и статистической независимости символов алфавита сигнала. Таким образом:

![]() , (7.29)

, (7.29)

![]() - количество

символов в алфавите.

Из

формулы видно, что пропускная способность

измеряется в единицах измерения

количества информации за единицу

времени.

- количество

символов в алфавите.

Из

формулы видно, что пропускная способность

измеряется в единицах измерения

количества информации за единицу

времени.

Рассмотрим методику определения пропускной способности канала связи без помех на следующем примере.

В

информационном канале без помех для

передачи сообщений используется алфавит

с четырьмя различными символами

![]() =4,

а код каждого сообщения содержит

=4,

а код каждого сообщения содержит

![]() =2

бита. Длительности всех разрядов,

соответствующих битам одинаковы и равны

одной миллисекунде:

=2

бита. Длительности всех разрядов,

соответствующих битам одинаковы и равны

одной миллисекунде:

![]() мс.

мс.

Определить пропускную способность канала передачи.

Решение.

Для расчета пропускной способности дискретного канала без помех используется выражение (7.29).

Скорость передачи одного символа

![]() ,

,

где

![]() –

средняя длительность передачи символа.

–

средняя длительность передачи символа.

Так как код каждого символа содержит 2 бита, то длительность всех сигналов будет постоянна и равна

![]() мс.

мс.

![]() .

.

И, следовательно

![]() .

.

Пропускная способность дискретного канала с помехами

При определении

пропускной способности канала

предполагается, что заданы свойства

канала (структура и уровень сигнала и

помех, вид модуляции, методы кодирования

и декодирования и др.). Эти свойства

определяют статистические связи между

принимаемыми сигналами, которые в свою

очередь выражаются условными вероятностями

вида

![]() и

и

![]() (рис.7.6).

При заданных таким образом свойствах

канала максимальную скорость передачи

информации можно обеспечить выбором

оптимального ансамбля сигналов. При

этом накладываются ограничения в

отношении уровня сигнала, его структуры,

спектра, объёма алфавита и др. Выбор

оптимального ансамбля сигналов означает

выбор оптимального распределения

вероятностей

(рис.7.6).

При заданных таким образом свойствах

канала максимальную скорость передачи

информации можно обеспечить выбором

оптимального ансамбля сигналов. При

этом накладываются ограничения в

отношении уровня сигнала, его структуры,

спектра, объёма алфавита и др. Выбор

оптимального ансамбля сигналов означает

выбор оптимального распределения

вероятностей

![]() .

.

В соответствии с этим пропускная способность дискретного канала с помехами определяется как максимальная скорость передачи информации, которая может быть достигнута при заданных свойствах канала и наложенных ограничениях:

![]() .

(7.30)

.

(7.30)

В

соотношении (7.30) максимум берётся по

всем допустимым распределениям

вероятности

![]() .

Здесь

.

Здесь![]() –

максимальное число сообщений, которое

может быть передано по каналу за единицу

времени. Величина

–

максимальное число сообщений, которое

может быть передано по каналу за единицу

времени. Величина![]() зависит от электрических характеристик

канала и вида модуляции. При передаче

с большой скоростью, т.е. короткими

импульсами, через канал с ограниченной

полосой, недостаточно для неискаженного

воспроизведения этих импульсов возникает

взаимное перекрытия ряда соседних

сигналов, снижающее достоверность

приёма. Предельная удельная скорость

передачи дискретных сигналов, при

которой может быть достигнут безыскаженный

прием, составляет 2 бода на 1 Герц полосы

канала.

зависит от электрических характеристик

канала и вида модуляции. При передаче

с большой скоростью, т.е. короткими

импульсами, через канал с ограниченной

полосой, недостаточно для неискаженного

воспроизведения этих импульсов возникает

взаимное перекрытия ряда соседних

сигналов, снижающее достоверность

приёма. Предельная удельная скорость

передачи дискретных сигналов, при

которой может быть достигнут безыскаженный

прием, составляет 2 бода на 1 Герц полосы

канала.

Для двоичного канала Vmax представляет собой максимально возможную скорость манипуляции Вmax. Напомним, что в отсутствие помех Н(XY)=0. Пропускная способность двоичного канала равна скорости манипуляции Вmax.

В дальнейшем будем рассматривать только такие каналы, которые называют каналами без памяти. Дискретный канал называется каналом без памяти, если вероятность перехода любого входного символа в любой выходной не зависит от того, какие символы передавались до этого и как они были приняты.

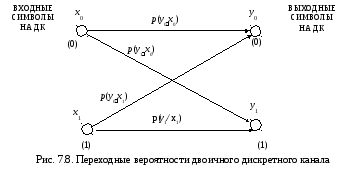

Если алфавит входных (X) и выходных (Y) сигналов состоит из двух символов, то канал называется двоичным. Диаграмма переходных вероятностей такого канала представлена на рис. 7.8.

Алфавит входных сигналов имеет два символа х0 и х1 . Выбранный случайным образом источником сообщений, один из этих символов подаётся на вход дискретного канала. На приёме регистрируется у0 и y1. Выходной алфавит тоже имеет два символа. Символ у0 может быть зарегистрирован при передаче сигнала х0 . Вероятность такого события – р(y0x0). Символ у0 может быть зарегистрирован при передаче сигнала х1. Вероятность такого события – р(y0x1). Символ y1 может быть зарегистрирован при передачи сигналов х0 и х1 с вероятностями р(y1x0) и р(y1 x1) соответственно. Правильному приёму соответствуют события с вероятностями появления р(y1x1) и р(y0x0). Ошибочный прием символа происходит при появлении событий с вероятностями р(y1x0) и р(y0x1). Стрелки на рисунке 7.8 показывают, что возможные события заключаются в переходе символа х1 в y1 и х0 в y0 (это соответствует безошибочному приему), а также в переходе х1 в y0 и х0 в y1 (это соответствует ошибочному приему). Такие переходы характеризуются соответствующими вероятностями р(y1x1), р(y0x0), р(y1x0), р(y0x1), а сами вероятности называют переходными. Переходные вероятности характеризуют вероятности воспроизведения на выходе канала переданных символов.

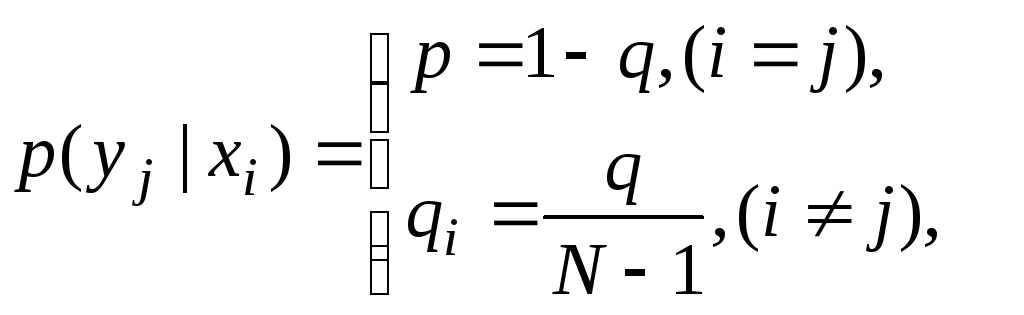

Канал без памяти называют симметричным, если соответствующие переходные вероятности одинаковы, а именно одинаковы вероятности правильного приёма, а также одинаковы вероятности любых ошибок. То есть:

![]() - правильный прием,

- правильный прием,

![]() - ошибочный прием.

- ошибочный прием.

Для общего случая

(7.32)

(7.32)

где

![]() – объём алфавита сигналов.

– объём алфавита сигналов.

В

большинстве случаев

![]() .

.

Дискретный

канал считается полностью определенным,

если известна скорость передачи отдельных

элементов дискретных сигналов и

определены (переходные) вероятности

![]() .

.

Переходные

вероятности

![]() и распределение вероятностей

и распределение вероятностей![]() позволяют определить апостериорную

неопределённость

позволяют определить апостериорную

неопределённость

![]() не устраняемую полностью при приеме,

так как в канале с помехами возможно

искажение передаваемых сигналов.

Напомним, что

не устраняемую полностью при приеме,

так как в канале с помехами возможно

искажение передаваемых сигналов.

Напомним, что

![]() определяется выражением

определяется выражением

![]() .

(7.33)

.

(7.33)

В выражении 7.33

![]() условная энтропия входного символа

условная энтропия входного символа

![]() при принятом символе

при принятом символе

![]() ;

;

![]() – условная вероятность передачи

– условная вероятность передачи![]() ,

если принят

,

если принят![]() .

Границы условной энтропии

.

Границы условной энтропии

![]() определяются неравенством

определяются неравенством

![]() .

(7.34)

.

(7.34)

При

чем

![]() при отсутствии помех в канале. Это

означает, что остаточной (апостериорной)

неопределённости нет. Помеха не искажает

передаваемые сигналы. Сообщение на

приеме восстанавливаются полностью, и

из них извлекается вся информация.

при отсутствии помех в канале. Это

означает, что остаточной (апостериорной)

неопределённости нет. Помеха не искажает

передаваемые сигналы. Сообщение на

приеме восстанавливаются полностью, и

из них извлекается вся информация.

![]() при

обрыве канала. При обрыве канала

информация по каналу не передается и

неопределенность на приёме не уменьшается.

при

обрыве канала. При обрыве канала

информация по каналу не передается и

неопределенность на приёме не уменьшается.

Таким

образом, при неполной достоверности

сообщений, среднее количество информации

равно разности безусловной энтропии

Н(X)

и условной энтропии

![]() характеризующей остаточную неопределённость

сообщений. И в результате передачи по

каналу одного элемента сообщения X

неопределенность на выходе уменьшиться

в среднем на величину

характеризующей остаточную неопределённость

сообщений. И в результате передачи по

каналу одного элемента сообщения X

неопределенность на выходе уменьшиться

в среднем на величину

![]() .

(7.35)

.

(7.35)

В

выражении 7.35 условная вероятность

![]() определяется распределением вероятностей

определяется распределением вероятностей![]() и переходными вероятностями

и переходными вероятностями![]()

![]() ,

(7.36)

,

(7.36)

где

![]() – вероятность ошибочного приема символа,

– вероятность ошибочного приема символа,![]() – вероятность правильного приёма

символа,

– вероятность правильного приёма

символа,![]() – объем алфавита.

– объем алфавита.

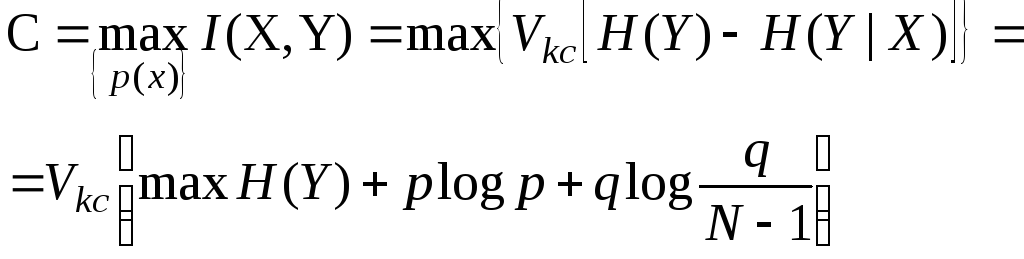

Подставляя (7.36) в выражение (7.30) для пропускной способности получаем

(7.37)

(7.37)

Максимальное значение энтропия принимает при равно вероятных символах сообщения. Т.к. Н(Y) = log N, где N – алфавит выходных сигналов, то для пропускной способности можем окончательно записать

![]() [бит/сек].

(7.38)

[бит/сек].

(7.38)

Пропускная

способность канала в расчете на один

символ

определяется путем деления С

на количество элементов сообщения,

передаваемых в единицу времени, т.е. на

скорость передачи

![]() .Пропускная

способность канала в расчете на один

символ

составляет

.Пропускная

способность канала в расчете на один

символ

составляет

![]() [бит/символ].

(7.39)

[бит/символ].

(7.39)

Из

выражения 7.39 следует, что при

![]() и

и![]() пропускная

способность симметричного канала равна

нулю. Действительно, представляя значения

пропускная

способность симметричного канала равна

нулю. Действительно, представляя значения

![]() и

и![]() выражение 7.39 получаем

выражение 7.39 получаем

Этот случай соответствует обрыву канала. Физически, это означает, что по каналу идет передача информации, на выходе канала её получить невозможно, т.к. при любом переданном символе xi все принимаемые символы уj равновероятные, т.е. р(уj|xi) = 1/N. Максимальной пропускная способность становится при отсутствии помех. В этом случае вероятность ошибки q становится равной 0: q = 0, а вероятность безошибочного приёма р= 1. Подставляя эти значения в (7.39) получаем

![]() [бит/сек].

[бит/сек].

В частном случае двоичного симметричного канала без памяти, т.е. при N= 2 получаем:

C = 1 + p log p + (1-p) log (1-p).

Беря различные значения р, можем определить пропускную способность для такого канала (рис.7.9).

C

Из графика (рис.7.9) видно, что пропускная способность максимальна, если вероятность ошибки q равна 0. При увеличении вероятностиqот 0 до 0,5 пропускная способностьСуменьшается до нуля. В точкеq=0,5 пропускная способность равна нулю. Этот случай соответствует обрыву канала. При дальнейшем возрастании вероятности ошибокqпропускная способностьСначинает увеличиваться и достигает максимума приq=1. это означает, что все переданные «1» под воздействием помех переходят в «0», а все «0» переходят в «1». Поэтому, изменением полярности на приеме можно полностью исключить ошибки.

Пропускная способность непрерывных каналов связи

Определение пропускной способности непрерывного канала с белым шумом

Непрерывный канал связи, как и дискретный, характеризуется количеством передаваемой информации и пропускной способностью – максимально возможной скоростью передачи информации.

Рассмотрим

непрерывный канал с дискретным временем,

т.е. канал, по которому со скоростью

![]() передаются отсчеты дискретного по

времени и непрерывного по интенсивности

сигнала.

передаются отсчеты дискретного по

времени и непрерывного по интенсивности

сигнала.

В соответствии со схемой (рис.7.5)

![]() ,

,

где

![]() –

дифференциальная энтропия суммы сигнала

и помехи

–

дифференциальная энтропия суммы сигнала

и помехи

![]() на выходе непрерывного канала;

на выходе непрерывного канала;

![]() –условная

дифференциальная энтропия суммы

–условная

дифференциальная энтропия суммы

![]() при известном входном сигнале

при известном входном сигнале![]() .

.

Если

помехи в канале связи являются аддитивными,

т.е.

![]() ,

то можно показать, что

,

то можно показать, что

![]() ,

,

где

![]() –

дифференциальная энтропия помехи. Тогда

среднее количество информации, переносимое

одним отсчетом, равно

–

дифференциальная энтропия помехи. Тогда

среднее количество информации, переносимое

одним отсчетом, равно

![]() ,

,

а скорость передачи информации

![]() .

.

В

частном случае, если средние мощности

сигнала и шума на выходе канала ограничены

(в определенной полосе частот), а

распределение плотности вероятностей

![]() и

и![]() являются нормальными (гауссовскими),

то

являются нормальными (гауссовскими),

то

![]() ,

,

![]() ,

,

где

Рс

и Рп

– средние мощности полезного сигнала

![]() и помехи

и помехи![]() на выходе канала;

на выходе канала;

Рс+Рп

–

средняя мощность (дисперсия) суммы

![]() (при независимости

(при независимости

![]() иn(t)).

иn(t)).

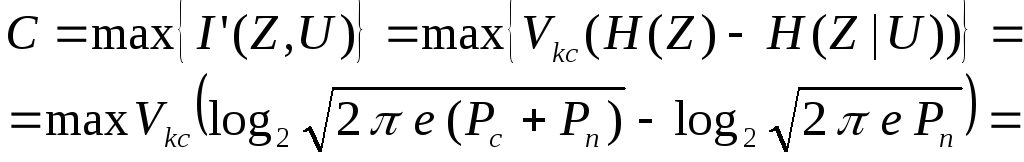

Тогда пропускная способность непрерывного канала с дискретным временем рассчитывается по формуле:

![]() (7.40)

(7.40)

где

![]() – отношение

сигнал/помеха

на выходе канала связи.

– отношение

сигнал/помеха

на выходе канала связи.

Скорость передачи кодовых символов равна частоте дискретизации, которая в свою очередь в соответствии с теоремой Котельникова равна удвоенной максимальной частоте сигнала

![]() .

.

Тогда

![]()

В

полностью непрерывном канале с полосой

пропускания

![]() предельная максимальная частота сигнала

предельная максимальная частота сигнала

![]() ,так

что

,так

что

![]() (7.41)

(7.41)

Это выражение называется формулой Шеннона, которая справедлива лишь по отношению к гауссовым каналам, т.е. к каналам с белым гауссовским шумом.

X

X X

X