- •Глава 7. Основы теории информации

- •7.1. Информационные характеристики источников сообщений

- •7.1.1. Определение количества информации

- •, (7.1)

- •Определение количества информации по к. Шеннону

- •Энтропия сообщения. Среднее количество информации по всем состояниям системы:

- •7.1.2. Информационные характеристики источников дискретных сообщений

- •Измеряется производительность источника в единицах измерения информации, отнесенных к единице времени - секунде.

- •7.1.3. Информационные характеристики источников непрерывных сообщений

- •7.2. Информационные характеристики каналов электросвязи

- •7.2.1. Вероятностные модели каналов связи в теории информации

- •7.2.2. Информационные характеристики каналов связи Информация

- •7.2.4. Обменность канальных ресурсов

7.1.2. Информационные характеристики источников дискретных сообщений

Основными информационными параметрами дискретных источников сообщений являются энтропия, избыточность и производительность.

Энтропия дискретных источников сообщений

С

целью определения того какой из двух

источников «информативнее» определяют

энтропию

![]() каждого из них и полученные значения

сравнивают между собой.

каждого из них и полученные значения

сравнивают между собой.

Например. Первый источник сообщения выдает 5 равновероятных сообщений. Второй источник выдает пять сообщений со следующим рядом распределения вероятностей:

![]()

![]()

![]()

![]()

![]() .

.

Используя выражения (7.7) для определения энтропии дискретных событий, получим:

а) для первого источника

![]() ,

,

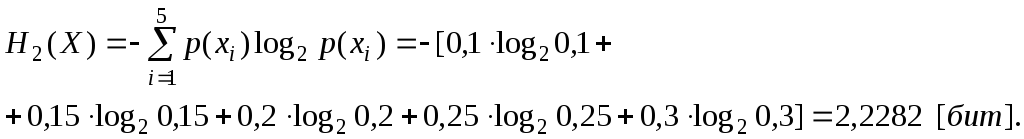

б) для второго источника

Таким образом, так как энтропия первого источника сообщений больше второго, то можно сделать вывод: первый источник «информативнее» второго.

Сравнение

полученных значений

![]() энтропий для первого и второго источников

показывает, что энтропия максимальна,

если сообщения равновероятны.

энтропий для первого и второго источников

показывает, что энтропия максимальна,

если сообщения равновероятны.

Еще меньшей будет энтропия при наличии корреляции (связи) между сообщениями (элементами сообщений).

Избыточность дискретных источников сообщений

Сообщения, энтропия которых максимальна, переносит максимальное количество информации. Т. е. эти сообщения являются оптимальными с точки зрения наибольшего количества передаваемой информации. Энтропия источника сообщений максимальна (и, следовательно, он вырабатывает максимальное количество информации в среднем на один символ), когда все символы алфавита источника равновероятны и независимы.

Проанализируем алфавит русского языка. Если не делать различий между буквами «е» и «ё», твердым и мягким знаками, то можно считать, что в русском алфавите содержится 31 буква. С учетом того, что между отдельными словами необходим знак «пробел» нужно передавать 32 символа.

Считаем символы равновероятными и независимыми, и средняя энтропия на символ будет максимальна и равна

![]() [бит/символ].

[бит/символ].

Т.е. каждая буква представима 5-ю битами.

Если

буквы передаются не хаотически, а

составляют связный текст, то появление

их неравновероятно (вероятность появления

буквы "О" в 45 раз больше, чем буквы

"Ф"). Энтропия при этом уменьшается.

Для русского языка с учетом различных

вероятностей появления букв (символов)

![]() бит/символ.

бит/символ.

Помимо

неравновероятности появления букв,

буквы в тексте зависимы. Так, после

гласных не может появиться "Ь",

мала вероятность сочетания более трёх

согласных подряд. Например, после

сочетания «ПР» наиболее вероятно

появление одной из гласных «И», «О»,

«Е». Таким образом, зная одну предыдущую

букву, можно предугадать какой будет

последующая буква. Поэтому ее появление

не представит большой неожиданности

или новизны. С учетом связи между двумя

символами энтропия уменьшается до

значения

![]() бит/символ. Между тремя символами - до

значения

бит/символ. Между тремя символами - до

значения

![]() бит/символ. И, наконец, между восемью

символами - до значения

бит/символ. И, наконец, между восемью

символами - до значения

![]() бит/симв., и далее остается неизменной.

бит/симв., и далее остается неизменной.

При

неизменном объеме информации, приходящейся

в среднем на одно сообщение, уменьшение

энтропии

![]() относительно

ее максимально возможного при данном

алфавите значения

относительно

ее максимально возможного при данном

алфавите значения

![]() ,

вызывает необходимость увеличения

количества символов, необходимых для

передачи одного сообщения. При энтропии

,

вызывает необходимость увеличения

количества символов, необходимых для

передачи одного сообщения. При энтропии

![]() оказалось

необходимо в среднем на одно сообщение

оказалось

необходимо в среднем на одно сообщение

![]() символов. Вместе с тем при передаче

сообщения с энтропией

символов. Вместе с тем при передаче

сообщения с энтропией

![]() ,

необходимо увеличить число символов

на величину

,

необходимо увеличить число символов

на величину

![]() ,

т.е. передавать

,

т.е. передавать![]() символов в среднем на сообщение. Число

символов

символов в среднем на сообщение. Число

символов![]() называют

избыточным.

называют

избыточным.

Мера

возможного сокращения (без потери

информации) сообщения, например вследствие

использования статистических взаимосвязей

между его элементами, называется

избыточностью сообщения.

Количественно избыточность оценивают

отношением числа избыточных символов

![]() в сообщении

к их общему числу

в сообщении

к их общему числу

![]()

![]() (7.8)

(7.8)

или

![]() .

(7.9)

.

(7.9)

Для русского языка избыточность составляет

![]() .

.

Избыточность показывает, какая часть букв в слове не загружена информацией.

Заметим, что избыточность величина безразмерная.

Полезна ли избыточность? Однозначного ответа на этот вопрос нет. Избыточность приводит к увеличению времени передачи сообщения за счет того, что необходима передача дополнительного числа символов. Это приводит так же к излишней загрузке каналов связи. Но некоторая избыточность бывает полезной для обеспечения требуемой надежности связи повышением помехоустойчивости передачи сообщений. Следует отметить, что у всех европейских языков избыточность примерно одинакова. Избыточность разговорных языков сформировалась в результате длительной общественной практики и позволяет восстанавливать целые слова и фразы при их искажениях под воздействием различных мешающих факторов.

Простейшим методом уменьшения избыточности являются широко применяемые при передаче телеграфного текста сокращения. Исключенные предлоги и союзы без труда восстанавливаются получателем по общей конструкции фразы, падежным окончаниям и т.п.

Для полного устранения избыточности необходимо осуществить согласование канала связи и источника сообщения путем статистического кодирования. Основная идея статистического кодирования состоит в том, что наиболее часто встречающимся сообщениям присваиваются короткие кодовые комбинации. Примером статистического кодирования может служить телеграфный код Морзе. Уменьшение избыточности, обусловленное наличием статистических связей между буквами, может быть достигнуто кодированием не отдельных элементарных сообщений (например, букв, а составных из них сравнительно длинных последовательностей (блоков)). Статистические связи между блоками значительно слабее межбуквенных связей. Подобный метод уменьшения межбуквенных статистических связей, т.е. корреляции между буквами часто называют декорреляцией укрупнением. В настоящее время рассмотренные методы уменьшения избыточности еще широко не используются. Причинами этого являются сравнительная сложность аппаратуры, реализующей кодирование и декодирование сигналов, а также задержка в передаче информации, возникающая при укрупнении элементарных сообщений в сравнительно длинные блоки.

Производительность дискретных источников сообщений

Зачастую

некоторые источники передают сообщения

с фиксированной скоростью передачи

каждого элемента, затрачивается в

среднем время

![]() на каждое сообщение.

на каждое сообщение.

Производительностью источника называется суммарная энтропия сообщений передаваемых за единицу времени. Математически это определение записывается в следующем виде

![]() .

(7.10)

.

(7.10)