- •Введение

- •Информация, сообщения, сигналы

- •Блок-схема передачи информации

- •Краткая история и примеры устройств передачи различных сообщений

- •Классификация сигналов

- •Количество информации дискретных сообщений

- •6.1 Свойства энтропии источника

- •6.1.1 Энтропия максимальна и равна:

- •6.1.2 Энтропия есть величина вещественная и неотрицательная, а так же ограниченная.

- •6.1.4 Энтропия есть величина вещественная и неотрицательная, а так же ограниченная.

- •6.2 Двоичный дискретный источник

- •Количество информации непрерывных сообщений

- •Статистически зависимые источники сообщений

- •Практические приложения теории информации

- •9.1 Сигнал и аддитивная помеха

- •9.2 Кодирование дискретных сообщений

- •9.3 Эффективное первичное кодирование

- •9.2.1 Метод укрупнения алфавита

- •9.2.2 Методы статистического кодирования

- •9.2.3 Кодирование в биологических структурах

- •Курсовая работа по теории информации

Статистически зависимые источники сообщений

Перейдем к рассмотрению более сложных случаев передачи сообщений, которыми занимается теория информации. Рассматривая выше дискретные или непрерывные источники, мы полагали, что в этих источниках передача сообщений происходит независимо, в то время как в реальных случаях появление сообщения часто зависит от предыдущего сообщения.

Если взять человеческую речь, то понятно, что появление букв нельзя охарактеризовать как независимые события. Буквы зависят от того, какие буквы были перед ними.

Слова так же имеют определенную связь по отношению с предыдущими словам. Это непростые процессы, но они встречаются в реальности. Теория информации должна их объяснять. Часто работает не один источник информации, а два или более, и эти источники могут также работать в зависимости друг от друга.

Рассмотрим случай, когда два дискретных источника сообщений вырабатывают сообщения: х1, х2, … хm и y1, y2, … yn

Каждый

из этих источников формирует эти

сообщения с соответствующими вероятностями.

Каждому сообщению первого источника

соответствуют определенные вероятности

,

а каждому сообщению второго источника

-вероятности

,

а каждому сообщению второго источника

-вероятности

.

.

Рассмотрим

появление сообщения второго источника,

статистически зависимое от сообщения

первого источника. Статистическую

зависимость будем отображать в виде

условной вероятности

,

дающей количественную оценку вероятности

того, что вторым источником будет

сформировано сообщение

,

дающей количественную оценку вероятности

того, что вторым источником будет

сформировано сообщение

при условии, что первым источником было

образовано сообщение

при условии, что первым источником было

образовано сообщение

.

.

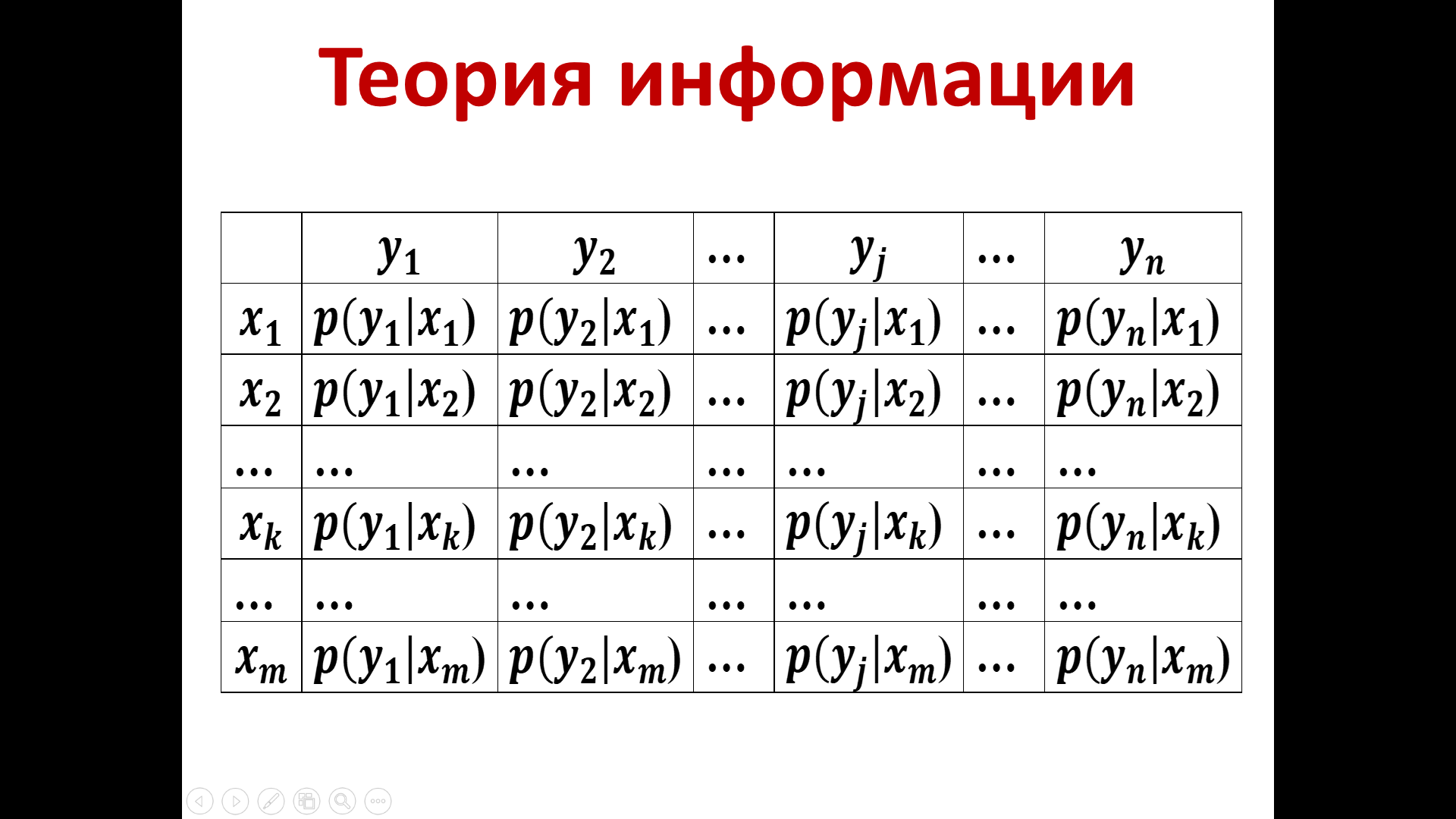

Полная количественная оценка условных вероятностей дается в таблице 5

Таблица 5

(Часто данные табл.5 записывают в виде матрицы условных вероятностей)

Источники описываются ансамблями, т.е. сообщениями и вероятностями их появления. При статистической зависимости нам необходимо дополнительно указать условные вероятности.

Таким образом, для описания двух источников, вырабатывающих статистически зависимые сообщения, помимо распределения вероятностей, характеризующей каждый из источников, нам необходимо знать условные вероятности того, как статистически связано каждое сообщение второго источника yj с предыдущим сообщением, вырабатываемым первым источником xk.

Очевидно должно выполняться условие нормировки, а именно, сумма всех условных вероятностей , при условии, что было выработано первым источником сообщение xk равна 1.

(27)

(27)

Условие

выполняется для всех суммируемых

вероятностей j

от 1 до

.

.

В общем случае величина n, характеризующая количество сообщений второго источника, не совпадает с m, т.е. с количеством сообщений первого источника.

Бывают случаи, когда m=n, но в общем случае совпадений нет.

p(xk) – вероятность элемента xk в сообщении A или в сообщении от первого источника.

p(yj) – вероятность элемента yj в сообщении B или в сообщении от второго источника.

Частная условная энтропия, которая характеризует появление всех возможных элементов yj в сообщении В при условии, что в сообщении А был элемент xk, можно вычислить по формуле:

(28)

(28)

Суммирование ведется по всем j от 1 до n, где n-число возможных сообщений, вырабатываемых вторым источником

Общая условная энтропия будет характеризовать все возможные случаи с учетом появления разных элементов xk в сообщении А и последующего появления различных элементов yj в сообщении В.

.

(29)

.

(29)

Суммирование осуществляется при вычислении произведения вероятности появления элемента xk в сообщении А (от 1-го источника) на значение частной условной энтропии, вычисляемой по формуле (28).

Из теории информации нам известно, что вероятность совместного появления элемента xk и yj может быть оценена как произведение вероятности появления элемента xk, умноженной на вероятность появления элемента yj при условии, что появился элемент xk. Либо произведение вероятностей появления элемента yj на условную вероятность того, что появился элемент xk при условии появления yj . Запишем это

(30)

(30)

Данное соотношение позволяет в более компактном виде записать общую условную энтропию из (29):

(31)

(31)

Исследуем свойства энтропии, характеризующей источники сообщений в случае, если сообщения вырабатываемые данными источником, являются статистически зависимыми, или, если рассматриваются несколько статистически зависимых источников.

Следуя формальному определению энтропии, можно записать, что энтропия объединения статистически зависимых сообщений может быть вычислена по формуле:

(32)

(32)

При

этом энтропия объединения статистически

зависимых сообщений может быть рассчитана

исходя из соотношений с энтропией

каждого источника в отдельности

или

или

условной энтропии

условной энтропии

или

или

.

.

(33)

(33)

Это общее соотношение может иметь более простое толкование, если вернуться к случаю статистически зависимых сообщений. Если отсутствует статистическая зависимость, то объединение может быть оценено суммой энтропий двух источников.

,

(34)

,

(34)

т.к.

при отсутствии статистической связи

.

.

Если существует полная (или абсолютная) статистическая зависимость, то условные энтропии равны нулю.

(35)

(35)

Это соответствует нашим представлениям о том, что любое сообщение, если оно заранее известно, обладает нулевым количеством информации.

После знакомства с основами теории информации, перейдем к рассмотрению практических приложений.