- •Кибернетика

- •Примеры:

- •Основными разделами (они фактически абсолютно самостоятельны и не зависимы) в современной кибернетике считаются:

- •Теория информации тесно связана с такими разделами математики как:

- •Формальное представление знаний

- •Программа в Pascal

- •Управление и информация.

- •О определяющее воздействие результат деятельности бщая схема процесса управления.

- •Информация как снятая неопределенность.

- •Энтропия.

- •Формальные определения.

- •Теорема отсчетов

Управление и информация.

Управление - это процесс обеспечивающий целенаправленное поведение какой либо системы. Управлять - влиять на ход какого либо процесса или состоянии некоторого объекта. Любой вид управления подразумевает вполне определённую цель, то есть управление всегда является целенаправленным действием с заранее заданной целью. Как правило управляющие воздействия и реакции объекта управления на эти воздействия носят информационный характер.

При образовании и анализ информации основа процессов управления в любой области.

Под управлением понимают совокупность действий направленных на поддержание или улучшении работы управляемого объекта в соответствии с имеющиеся программой (алгоритм функционирования) или целью управления.

Управление - воздействие управляющей системы на объект управления с целью сведения к минимуму различий между параметрами реальные деятельности объекта управления и параметрами определяемыми целью деятельности объекта.

О определяющее воздействие результат деятельности бщая схема процесса управления.

управляющая система

Объект управления

цель деятельности объекта

окружающая среда.

Обратная связь.

В любом процессе управления всегда происходит взаимодействие двух систем управляющей и управляемой. Если они соединены каналами прямой и обратной связи то такую систему называют замкнутой или системой с обратной связью.

По каналу прямой связи передаются сигналы (команды управления) вырабатываемые в управляющей системе. Подчиняясь этим командам управляемый объект осуществляет свои функции. В свою очередь объект управления соединён с управляющей системой каналом обратной связи, по которому поступает информация о состоянии управляемого объекта. В управляющей системе эта информация используется для выработки новых сигналов управления. Иногда нарушается нормальное функционирование каналов прямой или обратной связи, в этом случае система управления становится разомкнутой. Когда нарушена работа прямого канала связи управляющее воздействие не доходит до объекта управления. Его поведение становится хаотичным и не предсказуемым, либо он продолжает действовать по последним полученным инструкциям которые вероятнее всего уже устарели. В этом случае нельзя ожидать достижения заданной цели. В разомкнутой системе управления достижение желаемого результата мало вероятно, как правило разомкнутая система оказывается не способной к управлению. Для выработки управляющих решений обеспечивающих достижения цели управления управляющая система должна получать информацию не только о состоянии объекта управления но и о состоянии внешней среды. Принцип замкнутой системы управления (с обратной связью) лежит в основе действия большинства современных систем автоматического управления в том числе компьютера. Общие принципы управления применимы только не для решения задач управление сложными техническими объектами но так же для совершенствования управления экономическими и общественно социальными системами. Для этого разработаны теория оптимального планирования, математического программирования, теория операций, теория игр, теория массового обслуживания и т.д..

17.10.2013г.

Измерение информации.

Количество информации как мера уменьшения

неопределённости знаний.

В информатике используют различные подходы к измерению информации:

Содержательный.

Сообщение - информационный поток, который в процессе передачи информации поступает к приёмнику. Сообщение несёт информацию для человека если содержащиеся в нём сведения являются для него новыми и понятными. Информацию можно расценивать как знания человека. Сообщение должно быть информативно. Если сообщение не информативно то количество информации с точки зрения человека равно нулю.

2) Алфавитный подход к измерению информации - не связывает количество информации с содержанием сообщения.

Алфавитный подход - объективный подход к измерению информации. Он удобен при использовании технических средств работы с информацией так как не зависит от содержания сообщения.

Количество информации зависит от объема текста и мощности алфавита. Ограничений на максимальную мощность алфавита нет, но есть достаточный алфавит мощностью 256 символов. Этот алфавит используется для представления текстов в компьютере, так как 256=28. 1 символ несёт в тексте 8 бит информации.

Количество информации - это мера уменьшения неопределённости.

1бит - это такое количество информации которое содержит сообщение уменьшающее неопределённость знаний в 2 раза.

бит - это наименьшая единица измерения информации.

1байт = 8бит

1Кбайт = 1024 байт = 210 байт

1Мбайт = 1024 Кбайт = 220 байт

1Гбайт = 1024 Мбайт = 230 байт

3) Вероятностный подход к измерению информации.

Все события происходят с различной вероятностью, но зависимость между вероятностью событий и количеством информации полученной при совершении того или иного события можно выразить формулами Хартли и Шеннона.

Логарифмом числа B по основанию A называют показатель степени в которую нужно возвести A чтобы получить B.

logAB = C , АС = B; A>0, A <> 1, B>0.

log28=3;

Десятичные логарифмы (логарифмы по основанию 10; log10A). Обозначаются как "lg A".

Натуральные логарифмы (логарифмы по основанию E); logEA; lnA. Числом E в математике принято обозначать предел к которому стремится выражение (1+1/n)n, при n стремящимся к бесконечности.

E=lim(1+1/n)n =(приблизительно) 2,72;

Число Е является иррациональным числом - число несоизмеримо с единицей. Оно не может быть точно выражено не целым не дробным рациональным числом.

Е это первая буква латинского слова exponere -выставлять на показ. Отсюда и возникло название в математике "экспоненциальное" - показательная функция.

Число Е широко применяется в математике и во всех науках так или иначе применяющих для своих нужд математические расчеты.

Свойства логарифма:

1) Alogab=b , а>0, a<>1, b>0;

2log24=22=4

2) logA1=0; 50=1; log51=0;

3) logAA=1; 51=5;

4) logAAm = m; log552=2;

Действия с логарифмами

1) Логарифм произведения - logC(A*B) = logCA+logCB; C>0, C<>1, A and B >0;

2) Логарифм частного - logC(A/B) = logCA-logCB; C>0, C<>1, A and B >0;

3) Логарифм степени - logCAk = k*logCA; C>0, C<>1, A>0;

4) Логарифм корня - logCn√A=1/n*logCA

Количество информации в сообщении о каком-то событии зависит от вероятности совершения данного события.

24.10.13.

Научный подход к оценке сообщений был предложен ещё в 1928 году математиком Хартли и расчетная формула имеет вид I=log2N (N=2I), где N - количество равновероятных событий (число возможных выборов), I - количество информации (длинна кода необходимая для кодирования N событий).

Если N=2 (альтернатива - выбор из 2 возможностей) то I = 1бит.

Бит выбран в качестве единицы количества информации потому что принято считать что двумя двоичными словами исходной длины k или словом длинны 2k можно передать в 2 раза больше информации чем одним исходным словом.

Число возможных равновероятных выборов при этом увеличивается в 2k раз, тогда как I удваивается.

Иногда формула Хартли записывается иначе. Так как наступление каждого из N возможных событий имеет одинаковую вероятность: P=1/N. Значит подставив в формулу выше получится: I=log2P-1=-log2P.

Б

N

Ф

I=1

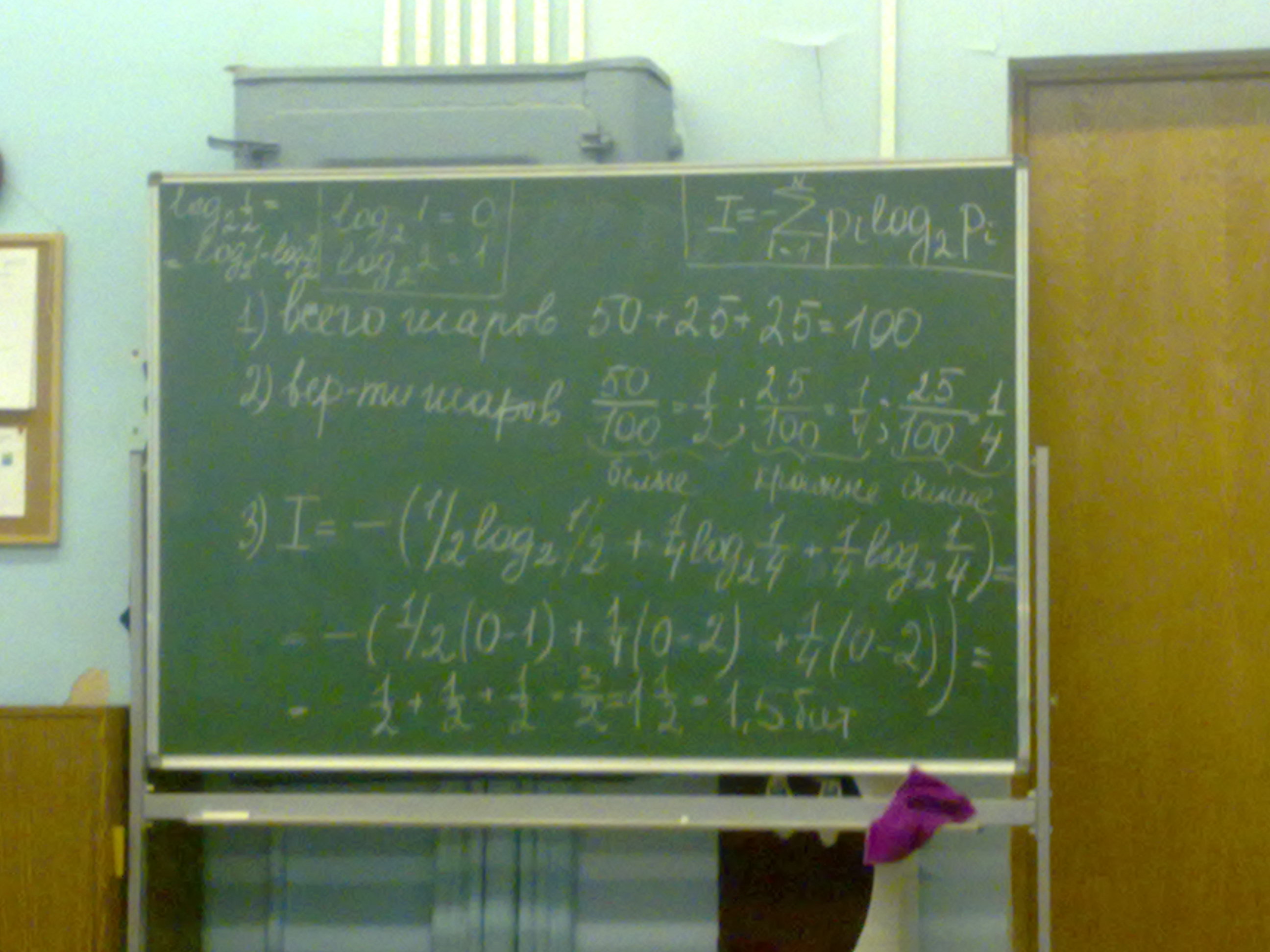

количества информации, N - количество возможных событий, pi - возможно вероятные события.

Задача №1

Какое количество информации будет содержать зрительное сообщение о цвете вынутого шарика если в не прозрачном мешочке находится 50 белых, 25 красных, 25 синих шариков.

Количество информации достигает максимального значения если события равновероятны поэтому количество информации можно рассчитать по формуле I=log2N.