Скорость передачи информации

Если источник выдает L элементарных сигналов в единицу времени, а средняя длина кода одного знака составляет K(A,a), то, очевидно, отношение L/K(A,a) будет выражать число знаков первичного алфавита, выдаваемых источником за единицу времени. Если с каждым из них связано среднее количество информации I(A), то можно найти общее количество информации, передаваемой источником за единицу времени – эта величина называется скоростью передачи или энтропией источника (будем обозначать ее J):

![]() (4)

(4)

Энтропия источника, в отличие от пропускной способности, является характеристикой источника, а не канала связи.

Размерностью J, как и C, является бит/с. Каково соотношение этих характеристик? Рассмотрим канал без помех. Тогда выразив L из (3) и подставив в (4), получим:

![]()

Согласно первой теореме Шеннона при любом способе кодирования

![]()

хотя может быть сколь угодно близкой к этому значению. Следовательно, всегда J C0, т.е. скорость передачи информации по каналу связи не может превысить его пропускной способности.

Как показано в теории Шеннона, данное утверждение справедливо как при отсутствии в канале помех (шумов) (идеальный канал связи), так и при их наличии (реальный канал связи).

Пример 1. Первичный алфавит состоит из трех знаков с вероятностями p1 = 0,2; p2 = 0,7; p3 = 0,1. Для передачи по каналу без помех используются равномерный двоичный код. Частота тактового генератора 500 Гц. Какова пропускная способность канала и скорость передачи?

Поскольку код двоичный, n = 2; из (3) C0 = 500 бит/с. Число знаков первичного алфавита N = 3.

I(A) = I1 = – 0,2·log20,2 – 0,7·log20,7 – 0,1·log20,1 = 1,16 бит K(A,2) log2 N = 2.

Следовательно, из (4) получаем:

![]()

Математическая постановка задачи влияния шумов на дискретный канал связи.

Используем для анализа процесса передачи информации по дискретному каналу с помехами энтропийный подход.

Пусть опыт b состоит в выяснении того, какой сигнал был принят на приемном конце канала; исходами этого опыта являются сигналы bj, общее число которых равно m. Опыт a состоит в выяснении того, какой сигнал был послан на вход канала; исходами этого опыта являются сигналы, образующие алфавит ai; их общее количество равно n. Опыт b несет в себе информацию относительно опыта a, значение которой равно:

I(b,a) = H(a) – Hb(a)

Смысл этого выражения в применении к рассматриваемой ситуации в том, что распознанный на приемном конце сигнал содержит информацию о сигнале, который был отправлен, но, в общем случае, информацию не полную. Влияние помех в канале таково, что в процессе передачи часть начальной информации теряется, и исход опыта b не несет полной информации относительно предшествующего исхода опыта a.

H(a) – энтропия, связанная с определением того, какой сигнал передан, равна:

![]()

Hb(a) – условная энтропия (энтропия опыта a при условии, что ему предшествовал опыт b). В нашем случае:

![]()

![]()

Окончательно для средней информации на один элементарный сигнал имеем:

![]() (5)

(5)

Часто бывает удобнее воспользоваться подобным же соотношением, которое получается на основе равенства:

I(b,a) = I(a,b) = H(b) – Ha(b)

![]() (6)

(6)

Проведенные рассуждения приводят к ряду заключений.

Для определения информации сигнала, принятого на приемном конце канала, необходимо знание априорных и апостериорных вероятностей. И обратное утверждение: знание априорных и апостериорных вероятностей позволяет установить (вычислить) информацию, связанную с переданным сигналом.

Как отмечалось ранее, I(b,a) = H(a) лишь в том случае, когда исход опыта b однозначно определяет исход предшествующего опыта a – это возможно только при отсутствии помех в канале. I(b,a) = 0, если a и b независимы, т.е. отсутствует связь между сигналами на входе и выходе канала. Действие помех состоит в том, что на выход канала приходят сигналы, содержащие меньше информации, чем они имели при отсылке.

Как уже указывалось, апостериорные вероятности определяются свойствами канала связи, а априорные – особенностями источника (точнее, кодера). Следовательно, воспользовавшись (5) или (6) и варьируя значения p(ai) в допустимых по условию задачи пределах, можно найти наибольшее значение max{I(b,a)}. Тогда:

![]() (7)

(7)

Полученное выражение определяет порядок решения задачи о нахождении пропускной способности конкретного канала:

исходя из особенностей канала, определить априорные и апостериорные вероятности;

варьируя p(ai) и пользуясь (5), найти максимальное информационное содержание элементарного сигнала;

по (6) вычислить пропускную способность.

Пример 2. Пусть в канале

отсутствуют помехи или они не препятствуют

передаче. Тогда m = n, сигналы на

приемном конце совпадают с отправленными.

Это означает, что апостериорные

вероятности

![]() =

1 при i = j и

=

0 при i <> j. В этом случае Hb(a) =

0 и max{I(b,a)} = max{H(a)} = log2n

(это значение достигается, если появление

всех входных сигналов равновероятно).

Из (6) получаем С = L×log2n,

что совпадает с (3). Тем самым показано,

что определение (3) пропускной способности

канала без помех является частным

случаем более общего определения (6).

=

1 при i = j и

=

0 при i <> j. В этом случае Hb(a) =

0 и max{I(b,a)} = max{H(a)} = log2n

(это значение достигается, если появление

всех входных сигналов равновероятно).

Из (6) получаем С = L×log2n,

что совпадает с (3). Тем самым показано,

что определение (3) пропускной способности

канала без помех является частным

случаем более общего определения (6).

Рассмотрим некоторые примеры каналов передачи информации с помехами.

Однородный двоичный симметричный канал.

Пусть на вход канала подаются сигналы двух типов (a1 и a2 – например, импульс и пауза) и они же принимаются на выходе, т.е. {a} = {b}, m = n. Пусть, далее, вероятность ошибки передачи для обоих сигналов одинакова и равна p; тогда, для дополнительных событий вероятность безошибочной передачи равна 1 - p. Применяя принятые выше обозначения, можно записать:

![]()

Рис.1.

Представление канала в виде графа

Рис.1.

Представление канала в виде графа

Такой канал называется

двоичным симметричным (относительно

инверсии a1![]() a2);

схематически его можно представить в

виде графа (см. рис. 1). Линии со стрелками

указывают, в какие принимаемые сигналы

могут перейти те, что отправлены на

входе; рядом со стрелками указаны

вероятности соответствующих переходов.

a2);

схематически его можно представить в

виде графа (см. рис. 1). Линии со стрелками

указывают, в какие принимаемые сигналы

могут перейти те, что отправлены на

входе; рядом со стрелками указаны

вероятности соответствующих переходов.

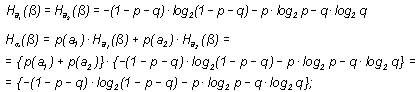

Найдем пропускную способность канала, воспользовавшись определением (7). Оно, в свою очередь, требует вычисления I(b,a) (или I(a,b)) и установления ее максимума как функции p. Если по-прежнему опыт a состоит в распознавании сигнала на входе канала, а опыт b – на выходе, с учетом того, что b1 = a1, а b2 = a2, и воспользовавшись выражением (6), получаем:

поскольку p(a1) + p(a2)= 1 как достоверное событие. Другими словами, в рассматриваемом канале энтропия Ha(b) не зависит от значений p(a1) и p(a2), а определяется только вероятностью искажений сигнала при передаче. Следовательно,

C = L · max{H(b) + (1 – p) + p · log2p}

Поскольку m = 2, max{H(b)} = 1. Таким образом, окончательно для пропускной способности симметричного двоичного канала имеем:

C = L {1 + (1 – p) · log2(1 – p) + p log2p}

Рис.2.

График функции C(p)

Рис.2.

График функции C(p)

График функции C(p) изображен на рис. 2. Максимального значения равного L функция C(p) достигает при p = 0 (очевидно, это означает отсутствие помех) и при p = 1 – это соответствует ситуации, когда канал полностью инвертирует входные сигналы (т.е. заменяет 0 на 1, а 1 на 0) - это не служит препятствием для однозначной идентификации посланного сигнала по принятому и, следовательно, не снижает пропускной способности канала. Во всех остальных ситуациях 0 < p < 1 и C(p) < L. Наконец, при p = 0,5 пропускная способность становится равной 0 – это вполне естественно, поскольку вероятность искажения 0,5 означает, что независимо от того, какой сигнал был послан, на приемном конце с равной вероятностью может появиться любой из двух допустимых сигналов. Ясно, что передача в таких условиях оказывается невозможной.

Поскольку канал двоичный, согласно (3) L = C0. Произведя соответствующую замену, получим:

C = C0 {1 + (1 – p) log2(1 – p) + p log2p} (8)

В выражение в фигурных скобках не превышает 1, следовательно, справедливо соотношение: С C0, т.е. можно считать доказанным, что наличие помех снижает пропускную способность (и даже может сделать ее равной 0).

Пример 3. Каково отношение C/C0, если средняя частота появления ошибки при передаче сообщения в двоичном симметричном канале составляет 1 ошибочный сигнал на 100 переданных?

Очевидно, вероятность появления ошибки передачи p = 0,01. Следовательно, из (8) получаем:

![]()

т.е. пропускная способность канала снизилась приблизительно на 8%.

Следует заметить, что отношение C/C0 убывает при увеличении вероятности искажения довольно быстро, что иллюстрируется таблицей:

Таблица 1. Зависимость C/C0 и вероятности искажения |

||||

Число ошибок передачи (на 100) |

1 |

10 |

25 |

50 |

Вероятность ошибки |

0,01 |

0,10 |

0,25 |

0,50 |

С/С0 |

0,92 |

0,53 |

0,19 |

0 |

Однородный симметричный канал со стиранием.

Снова рассмотрим двоичный канал (на входе сигналы a1 и a2 с вероятностями появления p(a1) и p(a2), соответственно). Допустим, что на приемном конце любой из них с вероятностью p может быть интерпретирован как, но, помимо этого, с вероятность q искажения в канале оказываются такими, что принятый знак не идентифицируется ни с одним из поступающих на вход. Другим словами, сигнал искажается настолько, что становится «неузнаваемым». В таком случае можно считать, что принят новый сигнал a3, появление которого можно интерпретировать как пропажу (стирание) входного сигнала (как если бы при переписывании мало разборчивого текста все непонятные буквы мы заменяли бы каким-то знаком) – по этой причине канал назван двоичным симметричным со стиранием. Тогда:

![]()

и таблица апостериорных вероятностей канала имеет вид:

Таблица 1. Таблица апостериорных вероятностей |

||

1-p-q |

p |

q |

p |

1-p-q |

q |

Его граф представлен на рисунке 1.

Рис.1.

Представление канала в виде графа

Рис.1.

Представление канала в виде графа

Вновь, как и при решении предыдущей задачи, воспользуемся соотношением (6).

Расчет условной энтропии дает:

Вновь учтено, что p(a1) + p(a2) = 1 как достоверное событие.

Таким образом:

I(a,b) = H(a) + (1 – p – q) · log2(1 – p – q) – p · log2p – q · log2q

Поскольку Ha(b) не зависит от значений априорных вероятностей, I(a,b) достигает максимума при таких p(a1) и p(a2), когда наибольшее значение приобретает энтропия H(b). Для нахождения H(b) необходимо знать вероятности всех сигналов, появляющихся на выходе из канала (обозначим эти вероятности qj (j = 1,2,3)).

Вероятность появления a3 (стирания) уже установлена: q3 = q. Для a1 вероятность q1 = p(a1)·(1 – p – q) + p(a2)·p; аналогично для a2 находим q2 = p(a2)·p + p(a2)·(1 – p – q). Тогда:

H(b) = –q1 · log2(q1) –q2 · log2(q2) –q · log2(q)

Поскольку q определяется особенностями канала и не зависит от априорных вероятностей сигналов на входе, наибольшим H(b) будет при максимальном значении выражения

– q1·log2 q1 – q2·log2 q2,

причем, при любых p(a1) и p(a2) справедливо q1 + q2 = 1 – q. Можно показать, что указанное выражение достигает максимума при условии q1 = q2 = 0,5·(1 – q). Тогда:

Окончательно для пропускной способности двоичного симметричного канала со стиранием имеем:

C = L · {(1 – q)[ 1 – log2(1 – q)] + (1 – p – q )· log2 (1 – p – q ) + p·log2p}

Рис.2.

Зависимость q

и C/L

Рис.2.

Зависимость q

и C/L

Проанализируем полученный результат. С = C(p,q), причем, C будет уменьшаться при увеличении как p, так и q. Если вероятности p и q отличны от 0, то, как видно из полученного выражения, C < C0. В реальных двоичных каналах со стиранием p < q, т.е. вероятность такого искажения входного сигнала, при котором его невозможно распознать, выше вероятности такого искажения, при котором сигнал становится похожим на второй из используемых сигналов. В тех ситуациях, когда p пренебрежимо мала и единственным искажением оказывается "стирание" сигнала, пропускная способность оказывается равной: C = L·(1 – q). График этой функции представлен на рис.2. Полученный результат представляется вполне закономерным: при p = 0 из L двоичных сигналов, передаваемых по каналу за единицу времени, в среднем L·q будет "стираться", но при этом остальные L·(1– q) сигналов будут на приемном конце расшифровываться без потерь, и с каждым из них связан ровно 1 бит информации.

Заканчивая рассмотрение характеристик реального дискретного канала передачи информации, мы можем сделать следующие заключения:

Помехи, существующие в реальном канале связи, приводят к снижению его пропускной способности (по сравнению с аналогичным каналом без помех).

Пропускная способность реального канала может быть рассчитана по известным априорным и апостериорным вероятностям. Для их определения требуются статистические исследования передачи информации в канале.

Передача информации по непрерывному каналу.

Выше мы обсуждали передачу информации в канале связи посредством дискретных сигналов. Однако при этом непосредственно сам канал связи - проводники, электромагнитное поле, звук, оптоволоконные линии и пр. – свойствами дискретности не обладает. Другими словами, по тем же каналам может передаваться и аналоговая информация – характер передаваемых сигналов определяется передатчиком. Линии связи, основанные на использовании аналоговых сигналов, имеют весьма широкую область практического применения - это радио- и телевизионная связь, телефон и модем, различные телеметрические каналы и пр.

Непрерывным называется канал, который обеспечивает передачу непрерывных (аналоговых) сигналов.

Схема непрерывного канала представлена на рисунке 1.

Рис.1.

Схема непрерывного канала передачи

информации

Рис.1.

Схема непрерывного канала передачи

информации

Непрерывные сигналы, поступающие в канал связи из передатчика описываются некоторой непрерывной функцией времени Z(t). Ограничения на значения этой функции задаются величиной средней мощности передаваемых сигналов PZ. Другой характеристикой непрерывного канала, как и канала дискретного, является полоса пропускания – интервал частот сигналов, которые могут распространяться в данном канале nmin – nmax. Если по своему физическому смыслу Z является напряжением или силой электрического тока, то при неизменном электрическом сопротивлении канала связи PZ ~ <Z2>, т.е. мощность сигнала определяет его амплитуду и средний квадрат значения параметра сигнала.

Сигналы на выходе канала Z'(t), поступающие в приемник, также являются аналоговыми и формируются они в результате сложения сигналов на входе канала и помех - их можно описать некоторой непрерывной функцией времени x(t); в результате:

Z'(t) = Z(t) + x(t).

Явный вид функции помех заранее неизвестен. Поэтому для количественного описания прохождения сигналов по непрерывному каналу приходится принимать ту или иную модель помех и модель канала. Наиболее распространенной является модель гауссовского канала: принимается, что помехи, будучи непрерывными случайными величинами, подчиняются нормальному (гауссовскому) статистическому распределению с математическим ожиданием (средним значением) равным нулю (mx = 0):

Эта функция имеет единственный параметр sx, квадрат которого называется дисперсией sx2 = Dx и имеет смысл средней мощности помех в канале с единичным электрическим сопротивлением, т.е.

![]()

Если при этом выполняется условие, что в пределах полосы пропускания средняя мощность помех оказывается одинаковой на всех частотах, а вне этой полосы она равна нулю, то такие помехи называются белым шумом.

Не в даваясь в математическую сторону вывода, укажем, что основываясь на аппарате, описывающем непрерывные случайные величины, можно получить выражение для информации, связанной с отдельным аналоговым сигналом, а на его основе вывести формулу для пропускной способности непрерывного канала. В частности, для принятой модели гауссовского канала с белым шумом получается выражение, которое также называется формулой Шеннона:

(9)

(9)

где PZ – средняя мощность сигнала; Px – средняя мощность помех, vm - наибольшая частота в полосе пропускания.

![]()

Замечание. Из (9) следует, что при фиксированной vm пропускная способность определяется только отношением мощностей сигнала и помех. Ограничение пропускной способности непрерывного канала связано с тем, что любые используемые для связи сигналы имеют конечную мощность.

C = 0 только при PZ = 0. Т.е. непрерывный канал обеспечивает передачу информации даже в том случае, если уровень шумов превышают уровень сигнала – это используется для скрытой (неперехватываемой) передачи.

Повысить пропускную способность непрерывного канала можно за счет расширения полосы пропускания.

Приведем характеристики некоторых каналов связи.

Таблица 1. Xарактеристики некоторых каналов связи |

|||

Вид связи |

vm(Гц) |

PZ/Px |

С (бит/с) |

Телеграф |

120 |

26 |

640 |

Телефон |

3*103 |

217 |

5*104 |

Телевидение |

7*106 |

217 |

130*106 |

Компьютерная сеть |

|

|

до 109 |

Слух человека |

20*103 |

|

5*104 |

Глаза человека |

|

|

5*106 |

Из сопоставления данных видно, что пропускная способность телефонного канала связи совпадает с пропускной способностью органов слуха человека. Однако она существенно выше скорости обработки информации человеком, которая составляет не более 50 бит/с. Другими словами, человеческие каналы связи допускают значительную избыточность информации, поступающей в мозг.

Мы коснулись лишь одной (хотя и наиболее часто применяемой) модели непрерывного канала. В реальных каналах действие помех на входные сигналы может быть гораздо сложнее и, соответственно, гораздо хуже поддаваться математическому описанию.