Основы теории информации

Понятие информатики как науки.

Информатика - молодая научная дисциплина, изучающая вопросы, связанные с поиском, сбором, хранением, преобразованием и использованием информации в самых различных сферах человеческой деятельности. Генетически информатика связана с вычислительной техникой, компьютерными системами и сетями, т.к. именно компьютеры позволяют порождать, хранить и автоматически перерабатывать информацию в таких количествах, что научный подход к информационным процессам становится одновременно необходимым и возможным. До настоящего времени толкование термина "информатика" (в том смысле как он используется в современной научной и методической литературе) еще не является установившимся и общепринятым. Обратимся к истории вопроса, восходящей ко времени появления электронных вычислительных машин.

После второй мировой войны возникла и начала бурно развиваться кибернетика как наука об общих закономерностях в управлении и связи в различных системах: искусственных, биологических, социальных. Рождение кибернетики принято связывать с опубликованием в 1948 г. американским математиком Норбертом Винером, ставшей знаменитой, книги "Кибернетика, или управление и связь в животном и машине". В этой работе были показаны пути создания общей теории управления и заложены основы методов рассмотрения проблем управления и связи для различных систем с единой точки зрения. Развиваясь одновременно с развитием электронно-вычислительных машин, кибернетика со временем превращалась в более общую науку о преобразовании информации.

Под информацией в кибернетике понимается любая совокупность сигналов, воздействий или сведений, которые некоторой системой воспринимаются от окружающей среды (входная информация X), выдаются в окружающую среду (выходная информация Y), а также хранятся в себе (внутренняя, внутрисистемная информация Z).

Развитие кибернетики в нашей стране встретило идеологические препятствия. Как отмечал академик А.И.Берг, в конце 50-х, начале 60-х годов в нашей литературе были допущены грубые ошибки в оценке значения и возможностей кибернетики. Все это нанесло серьезный ущерб развитию науки, привело к задержке в разработке многих теоретических положений и даже самих электронных машин.

Достаточно сказать, что еще в философском словаре 1959 года издания кибернетика характеризовалась как "буржуазная лженаука". Причиной этого явления послужили, с одной стороны, недооценка новой бурно развивающейся науки отдельными учеными "классического" направления, с другой - неумеренное пустословие тех, кто вместо активной разработки конкретных проблем кибернетики в различных областях спекулировал на полуфантастических прогнозах о безграничных возможностях кибернетики, дискредитируя тем самым эту науку.

Дело к тому же осложнялось тем, что развитие отечественной кибернетики на протяжении многих лет сопровождалось серьезными трудностями в реализации крупных государственных проектов, например, создания автоматизированных систем управления (АСУ). Однако, за это время удалось накопить значительный опыт создания информационных систем и систем управления технико-экономическими объектами. Требовалось выделить из кибернетики здоровое научное и техническое ядро и консолидировать силы для развития нового движения к давно уже стоящим глобальным целям.

Подойдем сейчас к этому вопросу с терминологической точки зрения. Вскоре вслед за появлением термина "кибернетика" в мировой науке стало использоваться англоязычное "Computer Science", а чуть позже, на рубеже шестидесятых и семидесятых годов, французы ввели получивший сейчас широкое распространение термин "Informatique". В русском языке раннее употребление термина "информатика" связано с узко-конкретной областью изучения структуры и общих свойств научной информации, передаваемой посредством научной литературы. Эта информационно-аналитическая деятельность, совершенно необходимая и сегодня в библиотечном деле, книгоиздании и т.д., уже давно не отражает современного понимания информатики. Как отмечал академик А.П.Ершов, в современных условиях термин - информатика - "вводится в русский язык в новом и куда более широком значении - как название фундаментальной естественной науки, изучающей процессы передачи и обработки информации. При таком толковании информатика оказывается более непосредственно связанной с философскими и общенаучными категориями, проясняется и ее место в кругу "традиционных" академических научных дисциплин"[1].

Попытку определить, что же такое современная информатика, сделал в 1978 г. Международный конгресс по информатике. Он отметил, что понятие информатики охватывает области, связанные с разработкой, созданием, использованием и материально-техническим обслуживанием систем обработки информации, включая машины, оборудование, математическое обеспечение, организационные аспекты, а также комплекс промышленного, коммерческого, административного и социального воздействия.

![]()

(1) Ершов А.П. Информатика: предмет и понятие. В кн.: Кибернетика. Становление информатики. - М.: Наука, 1986.

Информатика как единство науки и технологии.

Информатика - отнюдь не только "чистая наука". У нее, безусловно, имеется научное ядро, но важная особенность информатики - широчайшие приложения, охватывающие почти все виды человеческой деятельности: производство, управление, науку, образование, проектные разработки, торговлю, финансовую сферу, медицину, криминалистику, охрану окружающей среды и др. И, может быть, главное из них - совершенствование социального управления на основе новых информационных технологий.

Как наука, информатика изучает общие закономерности, свойственные информационным процессам (в самом широком смысле этого понятия). Когда разрабатываются новые носители информации, каналы связи, приемы кодирования, визуального отображения информации и многое другое, то конкретная природа этой информации почти не имеет значения. Для разработчика системы управления базами данных (СУБД) важны общие принципы организации и эффективность поиска данных, а не то, какие конкретно данные будут затем заложены в базу многочисленными пользователями. Эти общие закономерности есть предмет информатики как науки.

Объектом приложений информатики являются самые различные науки и области практической деятельности, для которых она стала непрерывным источником самых современных технологий, называемых часто "новые информационные технологии" (НИТ). Многообразные информационные технологии, функционирующие в разных видах человеческой деятельности (управлении производственным процессом, проектировании, финансовых операциях, образовании и т.п.), имея общие черты, в то же время существенно различаются между собой.

Перечислим наиболее впечатляющие реализации информационных технологий используя, ставшие традиционными, сокращения.

АСУ - автоматизированные системы управления - комплекс технических и программных средств, которые во взаимодействии с человеком организуют управление объектами в производстве или общественной сфере. Например, в образовании используются системы АСУ-ВУЗ.

АСУТП - автоматизированные системы управления технологическими процессами. Например, такая система управляет работой станка с числовым программным управлением (ЧПУ), процессом запуска космического аппарата и т.д.

Структура современной информатики.

Оставляя в стороне прикладные информационные технологии, опишем составные части "ядра" современной информатики. Каждая из этих частей может рассматриваться как относительно самостоятельная научная дисциплина; взаимоотношения между ними примерно такие же, как между алгеброй, геометрией и математическим анализом в классической математике - все они хоть и самостоятельные дисциплины, но, несомненно, части одной науки.

Теоретическая информатика - часть информатики, включающий ряд математических разделов. Она опирается на математическую логику и включает такие разделы как теория алгоритмов и автоматов, теория информации и теория кодирования, теория формальных языков и грамматик, исследование операций и другие. Этот раздел информатики использует математические методы для общего изучения процессов обработки информации.

Вычислительная техника - раздел, в котором разрабатываются общие принципы построения вычислительных систем. Речь идет не о технических деталях и электронных схемах (это лежит за пределами информатики как таковой), а о принципиальных решениях на уровне, так называемой, архитектуры вычислительных (компьютерных) систем, определяющей состав, назначение, функциональные возможности и принципы взаимодействия устройств. Примеры принципиальных, ставших классическими решений в этой области - неймановская архитектура компьютеров первых поколений, шинная архитектура ЭВМ старших поколений, архитектура параллельной (многопроцессорной) обработки информации.

Программирование - деятельность, связанная с разработкой систем программного обеспечения. Здесь отметим лишь основные разделы современного программирования: создание системного программного обеспечения и создание прикладного программного обеспечения. Среди системного - разработка новых языков программирования и компиляторов к ним, разработка интерфейсных систем (пример - общеизвестная операционная оболочка и система Windows). Среди прикладного программного обеспечения общего назначения самые популярные - системы обработки текстов, электронные таблицы (табличные процессоры), системы управления базами данных. В каждой области предметных приложений информатики существует множество специализированных прикладных программ более узкого назначения.

Информационные системы - раздел информатики связанный с решением вопросов по анализу потоков информации в различных сложных системах, их оптимизации, структурированию, принципах хранения и поиска информации. Информационно-справочные системы, информационно-поисковые системы, гигантские современные глобальные системы хранения и поиска информации (включая широко известный Internet) в последнее десятилетие XX века привлекают внимание все большего круга пользователей. Без теоретического обоснования принципиальных решений в океане информации можно просто захлебнуться. Известным примером решения проблемы на глобальном уровне может служить гипертекстовая поисковая система WWW, а на значительно более низком уровне - справочная система, к услугам которой мы прибегаем, набрав телефонный номер 09.

Искусственный интеллект - область информатики, в которой решаются сложнейшие проблемы, находящиеся на пересечении с психологией, физиологией, лингвистикой и другими науками. Как научить компьютер мыслить подобно человеку? - Поскольку мы далеко не все знаем о том, как мыслит человек, исследования по искусственному интеллекту, несмотря на полувековую историю, все еще не привели к решению ряда принципиальных проблем. Основные направления разработок, относящихся к этой области - моделирование рассуждений, компьютерная лингвистика, машинный перевод, создание экспертных систем, синтез и анализ сообщений на естественных языках, распознавание образов и другие. От успехов работ в области искусственного интеллекта зависит, в частности, решение такой важнейшей прикладной проблемы как создание интеллектуальных интерфейсных систем взаимодействия человека с компьютером, благодаря которым это взаимодействие будет походить на общение между людьми и станет более эффективным.

Место информатики в системе наук.

Рассмотрим место науки информатики в традиционно сложившейся системе наук (технических, естественных, гуманитарных и т.д.). В частности, это позволило бы найти место общеобразовательного курса информатики в ряду других учебных предметов.

Напомним, что по определению А.П.Ершова информатика - фундаментальная естественная наука. Академик Б.Н.Наумов определял информатику как естественную науку, изучающую общие свойства информации, процессы, методы и средства ее обработки (сбор, хранение, преобразование, перемещение, выдача).

Уточним, что такое фундаментальная наука и что такое естественная наука. К фундаментальным принято относить те науки, основные понятия которых носят общенаучный характер, используются во многих других науках и видах деятельности. Нет, например, сомнений в фундаментальности столь разных наук как математика и философия. В этом же ряду и информатика, так как понятия "информация", "процессы обработки информации" несомненно имеют общенаучную значимость.

Естественные науки - физика, химия, биология и другие - имеют дело с объективными сущностями мира, существующими независимо от нашего сознания. Отнесение к ним информатики отражает единство законов обработки информации в системах самой разной природы - искусственных, биологических, общественных.

Однако, многие ученые подчеркивают, что информатика имеет характерные черты и других групп наук - технических и гуманитарных (или общественных).

Черты технической науки придают информатике ее аспекты, связанные с созданием и функционированием машинных систем обработки информации. Так, академик А.А.Дородницын определяет состав информатики как три неразрывно и существенно связанные части: технические средства, программные и алгоритмические. Первоначальное наименовании школьного предмета "Основы информатики и вычислительной техники" в настоящее время изменено на "Информатика" (включающее в себя разделы, связанные с изучением технических, программных и алгоритмических средств). Науке информатике присущи и некоторые черты гуманитарной (общественной) науки, что обусловлено ее вкладом в развитие и совершенствование социальной сферы. Таким образом, информатика является комплексной, междисциплинарной отраслью научного знания.

Социальные аспекты информатики.

Термин "социальные аспекты" применительно к большей части наук, тем более фундаментальных, звучит странно. Вряд ли фраза "Социальные аспекты математики" имеет смысл. Однако, информатика - не только наука. Вспомним цитированное выше определение: "... комплекс промышленного, коммерческого, административного и социального воздействия".

И впрямь, мало какие факторы так влияют на социальную сферу обществ (разумеется, находящихся в состоянии относительно спокойного развития, без войн и катаклизмов) как информатизация. Информатизация общества - процесс проникновения информационных технологий во все сферы жизни и деятельности общества. Многие социологи и политологи полагают, что мир стоит на пороге информационного общества. В.А.Извозчиков под "информационным" ("компьютеризированным") обществом такое общество, во все сферы жизни и деятельности членов которого включены компьютер, телематика, другие средства информатики в качестве орудий интеллектуального труда, открывающих широкий доступ к сокровищам библиотек, позволяющих с огромной скоростью проводить вычисления и перерабатывать любую информацию, моделировать реальные и прогнозируемые события, процессы, явления, управлять производством, автоматизировать обучение и т.д.". Под "телематикой" он понимает службы обработки информации на расстоянии (кроме традиционных телефона и телеграфа).

Последние полвека информатизация является спутницей перетока людей из сферы прямого материального производства в, так называемую, информационную сферу. Промышленные рабочие и крестьяне, составлявшие в середине XX века более 2/3 населения, сегодня в развитых странах составляют менее 1/3. Все больше тех, кого называют "белые воротнички" - людей, не создающих материальные ценности непосредственно, а занятых обработкой информации (в самом широком смысле): это и учителя, и банковские служащие, и программисты, и многие другие категории работников. Появились и новые пограничные специальности. Можно ли назвать рабочим программиста, разрабатывающего программы для станков с числовым программным управлением? - По ряду параметров можно, однако его труд не физический, а интеллектуальный.

Приведем статистические данные, описывающие изменения в профессиональной структуре труда в США (стране, где информатизация идет особенно быстро) за период с 1970 по 1980 гг.

Таблица 1. Изменения в структуре труда в США за 10 лет |

|||

Категория работающих |

1970 г. в % |

1980 г., % |

Относительный прирост численности, % |

Работники сервиса |

19,9 |

21,5 |

+0,1 |

Рабочие (промышленные,сельскохозяйственные,фермеры) |

38,7 |

34,2 |

-11,6 |

Занятые обработкой информации(всего) |

41,5 |

44,4 |

+6,7 |

в том числе:менеджеры |

8,5 |

8,7 |

+2,4 |

конторские служащие |

18,0 |

18,9 |

+5,0 |

специалисты с высшимобразованием |

15,0 |

16,8 |

+12,0 |

Динамика, отраженная в этой таблице, подтверждает сказанное выше. Разумеется, не вся она обусловлена информатизацией, есть и иные факторы, но информатизация вносит решающий вклад. Даже в традиционных сферах деятельности - промышленности и торговле - работа с информацией становится на уровень работы с материальными объектами, в чем убеждают данные, приведенные в таблице 2.

Таблица 2. Профессиональная структура занятости в экономике США |

||

Отрасль |

Работают с информацией, % |

Работают с материальными объектами,% |

Обрабатывающая промышленность |

40 |

60 |

Транспорт и связь |

44 |

56 |

Оптовая торговля |

68 |

32 |

Розничная торговля |

58 |

42 |

Сфера услуг |

63 |

37 |

Финансовая деятельность |

92 |

8 |

Государственные учреждения |

70 |

30 |

За годы, прошедшие с момента публикации этих данных, ситуация изменилась в сторону дальнейшего увеличения доли населения, занятого в профессиональном труде обработкой информации. К середине 90-х годов численность "информационных работников" (к которым причисляют всех, в чьей профессиональной деятельности доминирует умственный труд), достигла в США 60%. Добавим, что за те же годы производительность труда в США за счет научно-технического прогресса (ведь информатизация - его главная движущая сила) в целом выросла на 37%.

Информатизация сильнейшим образом влияет на структуру экономики ведущих в экономическом отношении стран. В числе их лидирующих отраслей промышленности традиционные добывающие и обрабатывающие отрасли оттеснены максимально наукоемкими производствами электроники, средств связи и вычислительной техники - так называемой сферой высоких технологий. В этих странах постоянно растут капиталовложения в научные исследования, включая фундаментальные науки. Темпы развития сферы высоких технологий и уровень прибылей в ней превышают в 5-10 раз темпы развития традиционных отраслей производства. Такая политика имеет и социальные последствия - увеличение потребности в высокообразованных специалистах и связанный с этим прогресс системы высшего образования. Информатизация меняет и облик традиционных отраслей промышленности и сельского хозяйства. Промышленные роботы, управляемые ЭВМ, станки с ЧПУ стали обычным оборудованием. Новейшие технологии в сельскохозяйственном производстве не только увеличивают производительность труда, но и облегчают его, вовлекают более образованных людей.

Казалось бы, компьютеризация и информационные технологии несут в мир одну лишь благодать, но социальная сфера столь сложна, что последствия любого, даже гораздо менее глобального процесса, редко бывают однозначными. Рассмотрим, например, такие социальные последствия информатизации как рост производительности труда, интенсификацию труда, изменение условий труда. Все это, с одной стороны, улучшает условия жизни многих людей, повышает степень материального и интеллектуального комфорта, стимулирует рост числа высокообразованных людей, а с другой - является источником повышенной социальной напряженности. Например, появление на производстве промышленных роботов ведет к полному изменению технологии, которая перестает быть ориентированной на человека. Тем самым меняется номенклатура профессий. Значительная часть людей вынуждена менять либо специальность, либо место работы - рост миграции населения характерен для большинства развитых стран.

Государство и частные фирмы поддерживают систему повышения квалификации и переподготовки, но не все люди справляются с сопутствующим стрессом.

Прогрессом информатики порожден и другой достаточно опасный для демократического общества процесс - все большее количество данных о каждом гражданине сосредоточивается в разных (государственных и негосударственных) банках данных. Это и данные о профессиональной карьере (базы данных отделов кадров), здоровье (базы данных учреждений здравоохранения), имущественных возможностях (базы данных страховых компаний), перемещении по миру и т.д. (не говоря уже о тех, которые копят специальные службы). В каждом конкретном случае создание банка может быть оправдано, но в результате возникает система невиданной раньше ни в одном тоталитарном обществе прозрачности личности, чреватой возможным вмешательством государства или злоумышленников в частную жизнь. Одним словом, жизнь в "информационном обществе" легче, по-видимому, не становится, а вот то, что она значительно меняется - несомненно.

Трудно, живя в самом разгаре описанных выше процессов, взвесить, чего в них больше - положительного или отрицательного, да и четких критериев для этого не существует. Тяжелая физическая работа в не слишком комфортабельных условиях, но с уверенностью, что она будет постоянным источником существования для тебя и твоей семьи, с одной стороны, или интеллектуальный труд в комфортабельном офисе, но без уверенности в завтрашнем дне. Что лучше? Конечно, вряд ли стоит уподобляться английским рабочим, ломавшим в конце XYIII века станки, лишавшие их работы, но правительство и общество обязаны помнить об отрицательных социальных последствиях информатизации и научно-технического прогресса в целом и искать компенсационные механизмы.

Правовые аспекты информатики.

Деятельность программистов и других специалистов, работающих в сфере информатики, все чаще выступает в качестве объекта правового регулирования. Некоторые действия при этом могут быть квалифицированы как правонарушения (преступления).

Правовое сознание в целом, а в области информатики особенно, в нашем обществе находится на низком уровне. Все ли знают ответы на следующие вопросы:

можно ли не копируя купленную программу предоставить возможность пользоваться ею другому лицу;

кому принадлежит авторское право на программу, созданную студентом в ходе выполнения дипломной работы;

можно ли скопировать купленную программу для себя самого, чтобы иметь резервную копию;

можно ли декомпилировать программу, чтобы разобраться в ее деталях или исправить ошибки;

в чем состоит разница между авторским и имущественным правом.

Вопросов, подобных этим, возникает множество. Есть, конечно, такие, ответы на которые очевидны: нельзя создавать вирусы, нельзя хулиганить в сетях, нельзя в некоммерческих телеконференциях запускать коммерческую информацию, нельзя вскрывать и искажать защищенную информацию в чужих базах данных и т.д., т.е. совершать поступки, которые могут быть объектом уголовного преследования. Но на многие вопросы ответы отнюдь не очевидны, а иногда казуистически запутаны, причем не только в нашей стране. Остановимся на правовом регулировании в области информатики в России более подробно.

Необходимо отметить, что регулирование в сфере, связанной с защитой информации, программированием и т.д., является для российского законодательства принципиально новым, еще слабо разработанным направлением. К 1992 году был принят Закон Российской Федерации "О ПРАВОВОЙ ОХРАНЕ ПРОГРАММ ДЛЯ ЭЛЕКТРОННЫХ ВЫЧИСЛИТЕЛЬНЫХ МАШИН И БАЗ ДАННЫХ", содержащий обширный план приведения российского законодательства в сфере информатики в соответствие с мировой практикой. Действие этого Закона распространяется на отношения, связанные с созданием и использованием программ для ЭВМ и баз данных. Также предусматривалось внести изменения и дополнения в Гражданский кодекс РФ, в Уголовный кодекс РФ, другие законодательные акты, связанные с вопросами правовой охраны программ для электронных вычислительных машин и баз данных, привести решения Правительства РФ в соответствие с Законом, обеспечить пересмотр и отмену государственными ведомствами и другими организациями РФ их нормативных актов, противоречащих указанному Закону, обеспечить принятие нормативных актов в соответствии с указанным Законом и т.д.

Главное содержание данного Закона - юридическое определение понятий, связанных с авторством и распространением компьютерных программ и баз данных, таких как Авторство, Адаптация, База данных, Воспроизведение, Декомпилирование, Использование, Модификация и т.д., а также установление прав, возникающих при создании программ и баз данных - авторских, имущественных, на передачу, защиту, регистрацию, неприкосновенность и т.д.

Авторское право распространяется на любые программы для ЭВМ и базы данных (как выпущенные, так и не выпущенные в свет), представленные в объективной форме, независимо от их материального носителя, назначения и достоинства. Авторское право распространяется на программы для ЭВМ и базы данных, являющиеся результатом творческой деятельности автора. Творческий характер деятельности автора предполагается до тех пор, пока не доказано обратное.

Предоставляемая настоящим Законом правовая охрана распространяется на все виды программ для ЭВМ (в том числе на операционные системы и программные комплексы), которые могут быть выражены на любом языке и в любой форме, и на базы данных, представляющие собой результат творческого труда по подбору и организации данных. Предоставляемая правовая охрана не распространяется на идеи и принципы, лежащие в основе программы для ЭВМ и базы данных или какого-либо их элемента, в том числе идеи и принципы организации интерфейса и алгоритма, а также языки программирования.

Авторское право на программы для ЭВМ и базы данных возникает в силу их создания. Для признания и осуществления авторского права на программы для ЭВМ и базы данных не требуется опубликования, регистрации или соблюдения иных формальностей. Авторское право на базу данных признается при условии соблюдения авторского права на каждое из произведений, включенных в базу данных.

Автором программы для ЭВМ и базы данных признается физическое лицо, в результате творческой деятельности которого они созданы.

Если программа для ЭВМ и база данных созданы совместной творческой деятельностью двух и более физических лиц, то, независимо от того, состоит ли программа для ЭВМ или база данных из частей, каждая из которых имеет самостоятельное значение, или является неделимой, каждое из этих лиц признается автором такой программы для ЭВМ и базы данных.

Автору программы для ЭВМ или базы данных или иному правообладателю принадлежит исключительное право осуществлять и (или) разрешать осуществление следующих действий:

выпуск в свет программы для ЭВМ и базы данных;

воспроизведение программы для ЭВМ и базы данных (полное или частичное) в любой форме, любыми способами;

распространение программы для ЭВМ и баз данных;

модификацию программы для ЭВМ и базы данных, в том числе перевод программы для ЭВМ и базы данных с одного языка на другой;

иное использование программы для ЭВМ и базы данных.

Однако, имущественные права на программы для ЭВМ и базы данных, созданные в порядке выполнения служебных обязанностей или по заданию работодателя, принадлежат работодателю, если в договоре между ним и автором не предусмотрено иное. Таким образом, имущественное право на программу, созданную в ходе дипломного проектирования, принадлежит не автору, а вузу - по крайней мере, пока между ними не будет заключено специальное соглашение.

Имущественные права на программу для ЭВМ и базу данных могут быть переданы полностью или частично другим физическим или юридическим лицам по договору. Договор заключается в письменной форме и должен устанавливать следующие существенные условия: объем и способы использования программы для ЭВМ или базы данных, порядок выплаты и размер вознаграждения, срок действия договора.

Лицо, правомерно владеющее экземпляром программы для ЭВМ или базы данных, вправе без получения дополнительного разрешения правообладателя осуществлять любые действия, связанные с функционированием программы для ЭВМ или базы данных в соответствии с их назначением, в том числе запись и хранение в памяти ЭВМ, а также исправление явных ошибок. Запись и хранение в памяти ЭВМ допускаются в отношении одной ЭВМ или одного пользователя в сети, если иное не предусмотрено договором с правообладателем. Также допускается без согласия правообладателя и без выплаты ему дополнительного вознаграждения осуществлять следующие действия:

адаптацию программы для ЭВМ или базы данных;

изготавливать или поручать изготовление копии программы для ЭВМ или базы данных при условии, что эта копия предназначена только для архивных целей и при необходимости (в случае, когда оригинал программы для ЭВМ или базы данных утерян, уничтожен или стал непригодным для использования) для замены правомерно приобретенного экземпляра.

Лицо, правомерно владеющее экземпляром программы для ЭВМ, вправе без согласия правообладателя и без выплаты дополнительного вознаграждения выполнять декомпилирование программы для ЭВМ с тем, чтобы изучить кодирование и структуру этой программы при следующих условиях:

информация, необходимая для взаимодействия независимо разработанной данным лицом программы для ЭВМ с другими программами, недоступна из других источников;

информация, полученная в результате этого декомпилирования, может использоваться лишь для организации взаимодействия независимо разработанной данным лицом программы для ЭВМ с другими программами, а не для составления новой программы для ЭВМ, по своему виду существенно схожей с декомпилируемой программой.

Свободная перепродажа экземпляра программы для ЭВМ и базы данных допускается без согласия правообладателя и без выплаты ему дополнительного вознаграждения после первой продажи или другой передачи права собственности на этот экземпляр.

Выпуск под своим именем чужой программы для ЭВМ или базы данных, а также незаконное воспроизведение или распространение таких произведений влечет за собой уголовную ответственность.

В настоящее время уголовное законодательство РФ не в полной мере учитывает все возможные компьютерные преступления. Вообще же, в законодательной практике многих стран отмечены различные виды компьютерных преступлений и разработаны методы борьбы с ними.

Компьютерные преступления условно можно разделить на две большие категории.

Преступления, связанные с вмешательством в работу компьютеров.

Преступления, использующие компьютеры как необходимые технические средства.

Можно выделить следующие виды компьютерной преступности 1-го вида:

несанкционированный доступ в компьютерные сети и системы, банки данных с целью шпионажа или диверсии (военного, промышленного, экономического), с целью, так называемого, компьютерного хищения или из хулиганских побуждений;

ввод в программное обеспечение так называемых "логических бомб", срабатывающих при определенных условиях (логические бомбы, угрожающие уничтожением данных, могут использоваться для шантажа владельцев информационных систем, или выполнять новые, не планировавшиеся владельцем программы, функции, при сохранении работоспособности системы; известны случаи, когда программисты вводили в программы финансового учета команды, переводящие на счета этих программистов денежные суммы, или скрывающие денежные суммы от учета, что позволяло незаконно получать их);

разработку и распространение компьютерных вирусов;

преступную небрежность в разработке, изготовлении и эксплуатации программно-вычислительных комплексов, приведшую к тяжким последствиям;

подделку компьютерной информации (продукции) и сдача заказчикам неработоспособных программ, подделка результатов выборов, референдумов;

хищение компьютерной информации (нарушение авторского права и права владения программными средствами и базами данных).

Среди компьютерных преступлений 2-го вида, т.е. использующих компьютер как средство преступления, следует отметить преступления, спланированные на основе компьютерных моделей, например, в сфере бухгалтерского учета.

Для современного состояния правового регулирования сферы, связанной с информатикой, в России в настоящее время наиболее актуальными являются вопросы, связанные с нарушением авторских прав. Большая часть программного обеспечения, использующегося отдельными программистами и пользователями и целыми организациями, приобретена в результате незаконного копирования, т.е. хищения. Назрела потребность узаконить способы борьбы с этой порочной практикой, поскольку она мешает, прежде всего, развитию самой информатики.

Этические аспекты информатики.

Далеко не все правила, регламентирующие деятельность в сфере информатики, можно свести в правовым нормам. Очень многое определяется соблюдением неписаных правил поведения для тех, кто причастен к миру компьютеров. Впрочем, в этом отношении информатика ничуть не отличается от любой другой сферы деятельности человека в обществе.

Как и в любой другой большой и разветвленной сфере человеческой деятельности, в информатике к настоящему времени сложились определенные морально-этические нормы поведения и деятельности.

Морально-этические нормы в среде информатиков отличаются от этики повседневной жизни несколько большей открытостью, альтруизмом. Большинство нынешних специалистов-информатиков сформировались и приобрели свои знания и квалификацию благодаря бескорыстным консультациям и содействию других специалистов. Очевидно, поэтому они готовы оказать бескорыстную помощь, дать совет или консультацию, предоставить компьютер для выполнения каких-либо манипуляций с дискетами и т.д. Ярким примером особой психологической атмосферы в среде информатиков является расширяющееся международное движение программистов, предоставляющих созданные ими программные средства для свободного распространения.

Это - положительные аспекты, но есть и отрицательные. Обратим внимание на язык информатиков. Сленг российских информатиков построен на искаженных под русское произношение англоязычных терминах и аббревиатурах, введенных иностранными фирмами - разработчиками компьютеров и программного обеспечения в технической документации. Одновременно формируется и набор сленговых слов, заимствованных из русского языка на основе аналогий и ассоциаций по сходству и смежности (например: архивированный - "утоптанный", компьютер - "железо" или "тачка" и т.д.). С тем, что многие специальные термины пришли к нам из США, приходится мириться. Никто сегодня уже не перейдет от термина "принтер" к аналогичному "автоматическое цифровое печатающее устройство" (которым пользовались не так уж давно). Приживаемости подобных слов в отечественной литературе способствует, в частности, их относительная краткость.

Особую остроту этические проблемы приобретают при работе в глобальных телекоммуникационных сетях. Вскрыть защиту чужой базы данных - уголовное преступление. А можно ли позволять себе нецензурные выражения или прозрачные их эвфемизмы? Коммерческую рекламу в некоммерческой телеконференции? - Независимо от того, предусмотрено за это законом возмездие или нет, порядочный человек этого делать не станет.

Этика - система норм нравственного поведения человека. Порядочный человек не прочтет содержимое дискеты, забытой соседом на рабочем месте, не потому, что это грозит ему наказанием, а потому, что это безнравственный поступок; не скопирует программу в отсутствие ее хозяина не потому, что на него могут подать в суд, а потому, что этот поступок осудят его коллеги. Всякий раз, собираясь совершить сомнительный поступок в сфере профессиональной деятельности, человек должен задуматься, соответствует ли он этическим нормам, сложившимся в профессиональном сообществе.

Философские аспекты информации.

Как ни важно измерение информации, нельзя сводить к нему все связанные с этим понятием проблемы. При анализе информации социального (в широким смысле) происхождения на первый план могут выступить такие ее свойства как истинность, своевременность, ценность, полнота и т.д. Их невозможно оценить в терминах "уменьшение неопределенности" (вероятностный подход) или числа символов (объемный подход). Обращение к качественной стороне информации породило иные подходы к ее оценке. При аксиологическом подходе стремятся исходить из ценности, практической значимости информации, т.е. качественных характеристик, значимых в социальной системе. При семантическом подходе информация рассматривается как с точки зрения формы, так и содержания. При этом информацию связывают с тезаурусом, т.е. полнотой систематизированного набора данных о предмете информации.

Отметим, что эти подходы не исключают количественного анализа, но он становится существенно сложнее и должен базироваться на современных методах математической статистики.

Понятие информации нельзя считать лишь техническим, междисциплинарным и даже наддисциплинарным термином. Информация - это фундаментальная философская категория. Дискуссии ученых о философских аспектах информации надежно показали не сводимость информации ни к одной из этих категорий. Концепции и толкования, возникающие на пути догматических подходов, оказываются слишком частными, односторонними, не охватывающими всего объема этого понятия.

Попытки рассмотреть категорию информации с позиций основного вопроса философии привели к возникновению двух противостоящих концепций - так называемых, функциональной и атрибутивной. "Атрибутисты" квалифицируют информацию как свойство всех материальных объектов, т.е. как атрибут материи. "Функционалисты" связывают информацию лишь с функционированием сложных, самоорганизующихся систем. Оба подхода, скорее всего, неполны. Дело в том, что природа сознания, духа по сути своей является информационной, т.е. сознание суть менее общее понятие по отношению к категории "информация". Нельзя признать корректными попытки сведения более общего понятия к менее общему. Таким образом, информация и информационные процессы, если иметь в виду решение основного вопроса философии, опосредуют материальное и духовное, т.е. вместо классической постановки этого вопроса получается два новых: о соотношении материи и информации и о соотношении информации и сознания (духа).

Можно попытаться дать философское определение информации с помощью указания на связь определяемого понятия с категориями отражения и активности.

Информация есть содержание образа, формируемого в процессе отражения. Активность входит в это определение в виде представления о формировании некоего образа в процессе отражения некоторого субъект-объектного отношения. При этом не требуется указания на связь информации с материей, поскольку как субъект, так и объект процесса отражения могут принадлежать как к материальной, так и к духовной сфере социальной жизни. Однако существенно подчеркнуть, что материалистическое решение основного вопроса философии требует признания необходимости существования материальной среды - носителя информации в процессе такого отражения. Итак, информацию следует трактовать как имманентный (неотъемлемо присущий) атрибут материи, необходимый момент ее самодвижения и саморазвития. Эта категория приобретает особое значение применительно к высшим формам движения материи - биологической и социальной.

Данное выше определение схватывает важнейшие характеристики информации. Оно не противоречит тем знаниям, которые накоплены по этой проблематике, а наоборот, является выражением наиболее значимых.

Современная практика психологии, социологии, информатики диктует необходимость перехода к информационной трактовке сознания. Такая трактовка оказывается чрезвычайно плодотворной, и позволяет, например, рассмотреть с общих позиций индивидуальное и общественное сознание. Генетически индивидуальное и общественное сознание неразрывны и в то же время общественное сознание не есть простая сумма индивидуальных, поскольку оно включает информационные потоки и процессы между индивидуальными сознаниями.

В социальном плане человеческая деятельность предстает как взаимодействие реальных человеческих коммуникаций с предметами материального мира. Поступившая извне к человеку информация является отпечатком, снимком сущностных сил природы или другого человека. Таким образом, с единых методологических позиций может быть рассмотрена деятельность индивидуального и общественного сознания, экономическая, политическая, образовательная деятельность различных субъектов социальной системы.

Данное выше определение информации как философской категории затрагивает не только физические аспекты существования информации, но и фиксирует ее социальную значимость.

Одной из важнейших черт функционирования современного общества выступает его информационная оснащенность. В ходе своего развития человеческое общество прошло через пять информационных революций. Первая из них была связана с введением языка, вторая - письменности, третья - книгопечатания, четвертая - телевидения, и, наконец, пятая - компьютеров (а также магнитных и оптических носителей хранения информации). Каждый раз новые информационные технологии поднимали информированность общества на несколько порядков, радикально меняя объем и глубину знания, а вместе с этим и уровень культуры в целом.

Одна из целей философского анализа понятия информации - указать место информационных технологий в развитии форм движения материи, в прогрессе человечества и, в том числе, в развитии разума как высшей отражательной способности материи. На протяжении десятков тысяч лет сфера разума развивалась исключительно через общественную форму сознания. С появлением компьютеров начались разработки систем искусственного интеллекта, идущих по пути моделирования общих интеллектуальных функций индивидуального сознания.

Информация в физическом мире.

Известно большое количество работ, посвященных физической трактовке информации. Эти работы в значительной мере построены на основе аналогии формулы Больцмана, описывающей энтропию статистической системы материальных частиц, и формулы Хартли.

Заметим, что при всех выводах формулы Больцмана явно или неявно предполагается, что макроскопическое состояние системы, к которому относится функция энтропии, реализуется на микроскопическом уровне как сочетание механических состояний очень большого числа частиц, образующих систему (молекул). Задачи же кодирования и передачи информации, для решения которых Хартли и Шенноном была развита вероятностная мера информации, имели в виду очень узкое техническое понимание информации, почти не имеющее отношения к полному объему этого понятия. Таким образом, большинство рассуждений, использующих термодинамические свойства энтропии применительно к информации нашей реальности, носят спекулятивный характер.

В частности, являются необоснованными использование понятия "энтропия" для систем с конечным и небольшим числом состояний, а также попытки расширительного методологического толкования результатов теории вне довольно примитивных механических моделей, для которых они были получены. Энтропия и негэнтропия - интегральные характеристики протекания стохастических процессов - лишь параллельны информации и превращаются в нее в частном случае.

Информацию следует считать особым видом ресурса, при этом имеется ввиду толкование "ресурса" как запаса неких знаний материальных предметов или энергетических, структурных или каких-либо других характеристик предмета. В отличие от ресурсов, связанных с материальными предметами, информационные ресурсы являются неистощимыми и предполагают существенно иные методы воспроизведения и обновления, чем материальные ресурсы.

Рассмотрим некоторый набор свойств информации:

запоминаемость;

передаваемость;

преобразуемость;

воспроизводимость;

стираемость.

Свойство запоминаемости - одно из самых важных. Запоминаемую информацию будем называть макроскопической (имея ввиду пространственные масштабы запоминающей ячейки и время запоминания). Именно с макроскопической информацией мы имеем дело в реальной практике.

Передаваемость информации с помощью каналов связи (в том числе с помехами) хорошо исследована в рамках теории информации К.Шеннона. В данном случае имеется ввиду несколько иной аспект - способность информации к копированию, т.е. к тому, что она может быть "запомнена" другой макроскопической системой и при этом останется тождественной самой себе. Очевидно, что количество информации не должно возрастать при копировании.

Воспроизводимость информации тесно связана с ее передаваемостью и не является ее независимым базовым свойством. Если передаваемость означает, что не следует считать существенными пространственные отношения между частями системы, между которыми передается информация, то воспроизводимость характеризует неиссякаемость и неистощимость информации, т.е. что при копировании информация остается тождественной самой себе.

Фундаментальное свойство информации - преобразуемость. Оно означает, что информация может менять способ и форму своего существования. Копируемость есть разновидность преобразования информации, при котором ее количество не меняется. В общем случае количество информации в процессах преобразования меняется, но возрастать не может. Свойство стираемости информации также не является независимым. Оно связано с таким преобразованием информации (передачей), при котором ее количество уменьшается и становится равным нулю.

Данных свойств информации недостаточно для формирования ее меры, так как они относятся к физическому уровню информационных процессов.

Подводя итог сказанному в предыдущих шагах, отметим, что предпринимаются (но отнюдь не завершены) усилия ученых, представляющих самые разные области знания, построить единую теорию, которая призвана формализовать понятие информации и информационного процесса, описать превращения информации в процессах самой разной природы. Движение информации есть сущность процессов управления, которые суть проявление имманентной активности материи, ее способности к самодвижению. С момента возникновения кибернетики управление рассматривается применительно ко всем формам движения материи, а не только к высшим (биологической и социальной). Многие проявления движения в неживых - искусственных (технических) и естественных (природных) - системах также обладают общими признаками управления, хотя их исследуют в химии, физике, механике в энергетической, а не в информационной системе представлений. Информационные аспекты в таких системах составляют предмет новой междисциплинарной науки - синергетики.

Высшей формой информации, проявляющейся в управлении в социальных системах, являются знания. Это наддисциплинарное понятие, широко используемое в педагогике и исследованиях по искусственному интеллекту, также претендует на роль важнейшей философской категории. В философском плане познание следует рассматривать как один из функциональных аспектов управления. Такой подход открывает путь к системному пониманию генезиса процессов познания, его основ и перспектив.

Начальные определения информации.

Любая наука начинается со строгих определений используемых ею понятий и терминов. Поэтому было бы вполне разумным начать изложение основ теории информации именно с ее точного определения. Определить какое-либо понятие - значит выразить его через другие понятия, уже определенные ранее. Сложность ситуации, однако, в том, что информация является одной из исходных категорий мироздания, и, следовательно, определение "информации вообще" невозможно свести к каким-то более простым, более "исходным" терминам.

Что касается частных трактовок понятия "информация", то следует отметить значительное их расхождение в различных научных дисциплинах, в технике и на бытовом уровне. Такое положение не следует считать каким-то необычным - можно привести много аналогичных примеров, когда термин имеет и используется во множестве значений: движение, энергия, система, связь, язык и пр. Неоднозначность преодолевается тем, что в каждой "узкой" дисциплине дается свое определение термина - его следует считать частным - и именно оно используется. Но это, безусловно, не дает основания переносить такое определение и применять его вне рамок данной дисциплины. Например, в теоретической механике "связь" определяется как некое внешнее воздействие, ограничивающее возможности перемещения (степени свободы) тела; нет смысла такую трактовку пытаться применять, скажем, в телеграфии или социальных науках.

Аналогична ситуация и с термином "информация": на бытовом уровне и во многих научных дисциплинах он ассоциируется с понятиями сведения, знания, данные, известие, сообщение, управление и др. Общим во всех перечисленных примерах является то, в них существенным и значимым для использования является содержательная сторона информации - с позиций "здравого смысла" это представляется вполне естественным. Однако оценка смысла и ценности одной и той же информации различными людьми, вообще говоря, будет различной; объективная количественная мера смысловой стороны информации отсутствует. С другой стороны, можно привести примеры ситуаций, когда семантическая основа информации роли не играет, точнее, она принимается в виде атрибута (свойства, качества) информации, который не должен изменяться, а для этого следует обеспечить неизменность материального представления информации. По этой причине в ряде теоретических, технических и даже организационных приложений можно просто сосредоточиться на задаче обеспечения неизменности информации в процессах, с ней связанных (в первую очередь, это передача и хранение), а также поиске наилучших условий осуществления этих процессов безотносительно содержания самой информации. Например, задача библиотеки - обеспечить хранение, учет и доступ читателей к любым имеющимся в фонде книгам, независимо от их содержания; действия библиотекарей сводятся к тому, чтобы по формальным признакам - кодам, фамилии автора, названию - отыскать нужную книгу и выдать читателю; при этом содержание, полезность, новизну, значимость и т.п. книги оценивает именно читатель (т.е. лицо, использующее информацию), а не тот, кто ее хранит.

Отделив информацию от ее семантической основы, мы получаем возможность построить определение информации и параллельно ввести ее объективную количественную меру. Будет использован способ определения, который называется операционным и который состоит в описании метода измерения или нахождения значения определяемой величины - такому способу отдается предпочтение в научном знании, поскольку он обеспечивается однозначность и объективность, чего трудно добиться для категорий, не имеющих меры (например, попробуйте определить понятие "доброта"). Открытие такого способа определения информации является одной из главных заслуг теории информации.

Операционное определение информации будет нами рассмотрено позже, поскольку оно требует освоения ряда предшествующих и сопутствующих понятий. Пока же мы обсудим особенность, которой обладает любая информация, - это то, что информация - категория нематериальная. Следовательно, для существования и распространения в нашем материальном мире она должна быть обязательно связана с какой-либо материальной основой - без нее информация не может проявиться, передаваться и сохраняться, например, восприниматься и запоминаться нами. Введем определение:

Материальный объект или среду, которые служат для представления или передачи информации, будем называть ее материальным носителем.

Материальным носителем информации может быть бумага, воздух, лазерный диск, электромагнитное поле и пр. При этом хранение информации связано с некоторой характеристикой носителя, которая не меняется с течением времени, например намагниченные области поверхности диска или буква на бумаге, а передача информации - наоборот, с характеристикой, которая изменяется с течением времени, например амплитуда колебаний звуковой волны или напряжение в проводах. Другими словами, хранение информации связано с фиксацией состояния носителя, а распространение - с процессом, который протекает в носителе. Состояния и процессы могут иметь физическую, химическую, биологическую или иную основу - главное, что они материальны.

Однако не с любым процессом можно связать информацию. В частности, стационарный процесс, т.е. процесс с неизменными в течение времени характеристиками, информацию не переносит. Примером может служить постоянный электрический ток, ровное горение лампы, или равномерный гул - они содержат лишь ту информацию, что процесс идет, т.е. что-то функционирует. Иное дело, если мы будем лампу включать и выключать, т.е. изменять ее яркость, - чередованием вспышек и пауз можно представить и передать информацию (например, посредством азбуки Морзе). Таким образом, для передачи необходим нестационарный процесс, т.е. процесс, характеристики которого могут изменяться; при этом информация связывается не с существованием процесса, а именно с изменением какой-либо его характеристики.

Изменение характеристики носителя, которое используется для представления информации, называется сигналом, а значение этой характеристики, отнесенное к некоторой шкале измерений, называется параметром сигнала.

В таблице 1 приведены примеры процессов, используемых для передачи информации, и связанных с ними сигналов.

Таблица 1. Примеры процессов, используемых для передачи информации |

||

Способ передачи |

Процесс |

Параметры сигнала |

Звук |

Звуковые волны |

Высота и громкость звука |

Радио, телевидение |

Радиоволны |

Частота, амплитуда или фаза радиоволны |

Изображение |

Световые волны |

Частота и амплитуда световых волн |

Телефон, компьютерная сеть |

Электрический ток |

Частота и амплитуда электрических колебаний в линии связи |

Однако одиночный сигнал, как мы увидим в дальнейшем, не может содержать много информации. Поэтому для передачи информации используется ряд следующих друг за другом сигналов.

Последовательность сигналов называется сообщением.

Таким образом, от источника к приемнику информация передается в виде сообщений. Можно сказать, что сообщение выступает в качестве материальной оболочки для представления информации при передаче. Следовательно, сообщение служит переносчиком информации, а информация является содержанием сообщения.

Соответствие между сообщением и содержащейся в нем информацией называется правилом интерпретации сообщения.

Это соответствие может быть однозначным и неоднозначным. В первом случае сообщение имеет лишь одно правило интерпретации. Например, по последовательности точек, тире и пауз в азбуке Морзе однозначно восстанавливается переданная буква. Неоднозначность соответствия между сообщением и информацией возможна в двух вариантах:

одна и та же информация может передаваться различными сообщениями (например, прогноз погоды может быть получен по радио, из газеты, по телефону и пр.);

одно и то же сообщение может содержать различную информацию для разных приемников (примером может служить передача в 1936 г. по радио фразы "Над всей Испанией безоблачное небо", которое для непосвященных людей имело смысл прогноза погоды, а для знакомых с правилом интерпретации - сигналом к началу военных действий).

Обсудим следующее исходное понятие - информационный процесс. Вообще термин "процесс" применяется в тех случаях, когда некоторое качество, характеризующее систему или объект, меняется с течением времени в результате внешних воздействий или каких-то внутренних причин. Какие атрибуты могут изменяться с течением времени у нематериальной информации? Очевидно, только ее содержание и материальная оболочка, посредством которого информация представлена, т.е. сообщение. В связи с этим примем следующее определение:

Информационный процесс - это изменение с течением времени содержания информации или представляющего его сообщения.

Различных видов информационных процессов оказывается немного:

порождение (создание) новой информации;

преобразование информации (т.е. порождение новой информации в результате обработки имеющейся);

уничтожение информации;

передача информации (распространение в пространстве).

На самом деле все перечисленные события происходят не непосредственно с самой информацией, а с сообщением, т.е. ее материальной оболочкой. И с этих позиций возможны лишь два типа процессов: изменение сообщения с сохранением содержащейся в нем информации и изменение сообщения, сопровождающееся преобразованием информации. К процессам первого типа относится передача информации без потерь и обратимая перекодировка; к процессам второго типа - создание-уничтожение, необратимая перекодировка, передача с потерями, обработка с появлением новой информации.

Отдельно следует остановиться на хранении информации. Как уже было сказано, хранение связывается с фиксацией параметра материального носителя, который далее с течением времени не меняется. Следовательно, запись информации на носитель (непосредственно момент фиксации параметра) и ее последующее считывание подпадают под определение информационного процесса, но само хранение - нет. Хранение следовало бы назвать информационным состоянием, однако, такое понятие в информатике не используется.

С передачей информации связана еще одна пара исходных сопряженных понятий - источник и приемник информации.

Источник информации - это субъект или объект, порождающий информацию и представляющий ее в виде сообщения.

Приемник информации - это субъект или объект, принимающий сообщение и способный правильно его интерпретировать.

В этих определениях сочетание "субъект или объект" означает, что источники и приемники информации могут быть одушевленными (человек, животные) или неодушевленными (технические устройства, природные явления). Для того чтобы объект (или субъект) считался источником информации, он должен не только ее породить, но и иметь возможность инициировать какой-то нестационарный процесс и связать информацию с его параметрами, т.е. создать сообщение. Например, если человек что-то придумал, но держит это в своем мозге, он не является источником информации; однако он им становится, как только свою идею изложит на бумаге (в виде текста, рисунка, схемы и пр.) или выскажет словами.

В определении приемника информации важным представляется то, что факт приема сообщения еще не означает получение информации; информация может считаться полученной только в том случае, если приемнику известно правило интерпретации сообщения. Другими словами, понятия "приемник сообщения" и "приемник информации" не тождественны. Например, слыша речь на незнакомом языке, человек оказывается приемником сообщения, но не приемником информации.

Для связи с внешним миром у человека, как известно, имеются пять органов чувств. Следовательно, воспринимать сообщение мы можем только посредством одного из них (или группой органов). Это не означает, однако, что человек не может использовать для передачи и приема информации какие-то иные процессы, им не воспринимаемые, например радиоволны. В этом случае человек-источник использует промежуточное устройство, преобразующее его сообщение в радиоволны - радиопередатчик, а человек-приемник - другое промежуточное устройство - радиоприемник, преобразующий радиоволны в звук. Такой подход заметным образом расширяет возможности человека в осуществлении передачи и приема информации.

Промежуточные устройства-преобразователи получили название технические средства связи, а в совокупности с соединяющей их средой они называются линией связи. К ним относятся телеграф, телефон, радио и телевидение, компьютерные телекоммуникации и пр. При использовании таких средств возникает необходимость преобразования сообщения из одного вида в другой без существенной для получателя потери информации, а также увязки скорости передачи сообщения (т.е. интервала следования и величины отдельных сигналов) с возможностями линии связи и приемника. Обе эти проблемы оказываются центральными в теории информации.

Формы представления информации.

В предыдущем шаге было сказано, что передача информация производится с помощью сигналов, а самим сигналом является изменение некоторой характеристики носителя с течением времени. При этом в зависимости от особенностей изменения этой характеристики (т.е. параметра сигнала) с течением времени выделяют два типа сигналов: непрерывные и дискретные.

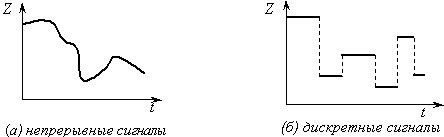

Сигнал называется непрерывным (или аналоговым), если его параметр может принимать любое значение в пределах некоторого интервала.

Если обозначить Z – значение параметра сигнала, а t – время, то зависимость Z(t) будет непрерывной функцией (рис.1(а)).

Рис.1.

Непрерывные и дискретные сигналы

Рис.1.

Непрерывные и дискретные сигналы

Примерами непрерывных сигналов являются речь и музыка, изображение, показание термометра (параметр сигнала – высота столба спирта или ртути – имеет непрерывный ряд значений) и пр.

Сигнал называется дискретным, если его параметр может принимать конечное число значений в пределах некоторого интервала.

Пример дискретных сигналов представлен на рис. 1(б). Как следует из определения, дискретные сигналы могут быть описаны дискретным и конечным множеством значений параметров {Z}. Примерами устройств, использующих дискретные сигналы, являются часы (электронные и механические), цифровые измерительные приборы, книги, табло и пр.

Поскольку последовательность сигналов есть сообщение, качество прерывности-непрерывности сигналов переносится и на сообщение – существуют понятия непрерывное сообщение и дискретное сообщение. Очевидно, что дискретным будет считаться сообщение, построенное из дискретных сигналов. Гораздо меньше оснований приписывать данное качество самой информации, поскольку информация – категория нематериальная и не может обладать свойством дискретности или непрерывности. С другой стороны, одна и та же информация, как уже было сказано, может быть представлена посредством различных сообщений, в том числе и отличающихся характером сигналов. Например, речь, которую мы слышим, можно записать в аналоговом виде с помощью магнитофона, а можно и законспектировать посредством дискретного набора букв. По этой причине в информатике существуют и используются сочетания непрерывная информация и дискретная информация. Их нужно понимать только как сокращение полных фраз: информация, представленная посредством непрерывных сигналов и информация, представленная посредством дискретных сигналов – именно в таком контексте эти понятия будут использоваться в дальнейшем изложении. Поэтому когда заходит речь о видах информации, правильнее говорить о формах ее представления в сообщении или о видах сообщений.

Принципиальным и важнейшим различием непрерывных и дискретных сигналов является то, что дискретные сигналы можно обозначить, т.е. приписать каждому из конечного числа возможных значений сигнала знак, который будет отличать данный сигнал от другого.

Знак – это элемент некоторого конечного множества отличных друг от друга сущностей.

Природа знака может любой – жест, рисунок, буква, сигнал светофора, определенный звук и т.д. Природа знака определяется носителем сообщения и формой представления информации в сообщении.

Вся совокупность знаков, используемых для представления дискретной информации, называется набором знаков. Таким образом, набор есть дискретное множество знаков.

Набор знаков, в котором установлен порядок их следования, называется алфавитом.

Следовательно, алфавит – это

упорядоченная совокупность знаков.

Порядок следования знаков в алфавите

называется лексикографическим.

Благодаря этому порядку между знаками

устанавливаются отношения больше–меньше:

для двух знаков

![]() <

<

![]() ,

если порядковый номер у

в

алфавите меньше, чем у

.

,

если порядковый номер у

в

алфавите меньше, чем у

.

Примером алфавита может служить совокупность арабских цифр 0,1…9 – с его помощью можно записать любое целое число в системах счисления от двоичной до десятичной. Если в этот алфавит добавить знаки "+" и "–", то им можно будет записать любое целое число, как положительное, так и отрицательное. Наконец, если добавить знак разделителя разрядов ("." или ","), то такой алфавит позволит записать любое вещественное число.

Поскольку при передаче сообщения параметр сигнала должен меняться, очевидно, что минимальное количество различных его значений равно двум и, следовательно, алфавит содержит минимум два знака – такой алфавит называется двоичным. Верхней границы числа знаков в алфавите не существует; примером могут служить иероглифы, каждый из которых обозначает целое понятие, и общее их количество исчисляется десятками тысяч.

Знаки, используемые для обозначения фонем человеческого языка, называются буквами, а их совокупность – алфавитом языка.

Сами по себе знак или буква не несут никакого смыслового содержания. Однако такое содержание им может быть приписано – в этом случае знак будет называться символом. Например, силу в физике принято обозначать буквой F – следовательно, F является символом физической величины сила в формулах. Другим примером символов могут служить пиктограммы, обозначающие в компьютерных программах объекты или действия.

Таким образом, понятия "знак", "буква" и "символ" нельзя считать тождественными, хотя весьма часто различия между ними не проводят, поэтому в информатике существуют понятия "символьная переменная", "кодировка символов алфавита", "символьная информация" – во всех приведенных примерах вместо термина "символьный" корректнее было бы использовать "знаковый" или "буквенный".

Представляется важным еще раз подчеркнуть, что понятия знака и алфавита можно отнести только к дискретным сообщениям.

Преобразование сообщений.

Вернемся к обсуждению информационных процессов, связанных с преобразованием одних сигналов в другие. Ясно, что технически это осуществимо. Ранее сигналы и их последовательности – сообщения – были названы нами «материальными оболочками для информации», и, естественно, встает вопрос: при изменении «оболочки» что происходит с его содержимым, т.е. с информацией? Попробуем найти ответ на него.

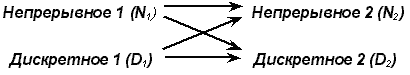

Поскольку имеются два типа сообщений, между ними, очевидно, возможны четыре варианта преобразований:

Рис.1.

Варианты преобразований

Рис.1.

Варианты преобразований

Осуществимы и применяются на практике все четыре вида преобразований. Рассмотрим примеры устройств и ситуаций, связанных с такими преобразованиями, и одновременно попробуем отследить, что при этом происходит с информацией.

Примерами устройств, в которых

осуществляется преобразование типа

N1![]() N2,

являются микрофон (звук преобразуется

в электрические сигналы); магнитофон и

видеомагнитофон (чередование областей

намагничивания ленты превращается в

электрические сигналы, которые затем

преобразуются в звук и изображение);

телекамера (изображение и звук превращаются

в электрические сигналы); радио- и

телевизионный приемник (радиоволны

преобразуются в электрические сигналы,

а затем в звук и изображение); аналоговая

вычислительная машина (одни электрические

сигналы преобразуются в другие).

Особенностью данного варианта

преобразования является то, что оно

всегда сопровождается частичной потерей

информации. Потери связаны с помехами

(шумами), которые порождает само

информационное техническое устройство

и которые воздействуют извне. Эти помехи

примешиваются к основному сигналу и

искажают его. Поскольку параметр сигнала

может иметь любые значения (из некоторого

интервала), то невозможно отделить

ситуации: был ли сигнал искажен или он

изначально имел такую величину. В ряде

устройств искажение происходит в силу

особенностей преобразования в них

сообщения, например в черно-белом

телевидении теряется цвет изображения;

телефон пропускает звук в более узком

частотном интервале, чем интервал

человеческого голоса; кино- и

видеоизображение оказываются плоскими,

они утратили объемность.

N2,

являются микрофон (звук преобразуется

в электрические сигналы); магнитофон и

видеомагнитофон (чередование областей

намагничивания ленты превращается в

электрические сигналы, которые затем

преобразуются в звук и изображение);

телекамера (изображение и звук превращаются

в электрические сигналы); радио- и

телевизионный приемник (радиоволны

преобразуются в электрические сигналы,

а затем в звук и изображение); аналоговая

вычислительная машина (одни электрические

сигналы преобразуются в другие).

Особенностью данного варианта

преобразования является то, что оно

всегда сопровождается частичной потерей

информации. Потери связаны с помехами

(шумами), которые порождает само

информационное техническое устройство

и которые воздействуют извне. Эти помехи

примешиваются к основному сигналу и

искажают его. Поскольку параметр сигнала

может иметь любые значения (из некоторого

интервала), то невозможно отделить

ситуации: был ли сигнал искажен или он

изначально имел такую величину. В ряде

устройств искажение происходит в силу

особенностей преобразования в них

сообщения, например в черно-белом

телевидении теряется цвет изображения;

телефон пропускает звук в более узком

частотном интервале, чем интервал

человеческого голоса; кино- и

видеоизображение оказываются плоскими,

они утратили объемность.

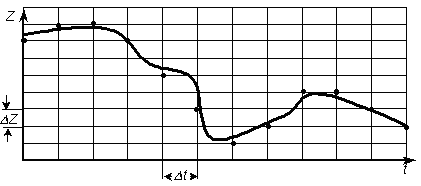

Теперь обсудим общий подход к преобразованию типа N D. С математической точки зрения перевод сигнала из аналоговой формы в дискретную означает замену описывающей его непрерывной функции времени Z(t) на некотором отрезке [t1, t2] конечным множеством (массивом) {Zi, ti} (i изменяется от 0 до n, где n – количество точек разбиения временного интервала). Подобное преобразование называется дискретизацией непрерывного сигнала и осуществляется посредством двух операций: развертки по времени и квантования по величине сигнала.

Развертка по времени состоит

в том, что наблюдение за значением

величины Z производится не непрерывно,

а лишь в определенные моменты времени

с интервалом

![]() :

:

![]()

Квантование по величине – это отображение вещественных значений параметра сигнала в конечное множество чисел, кратных некоторой постоянной величине – шагу квантования ( Z).

Совместное выполнение обоих операций эквивалентно нанесению масштабной сетки на график Z(t), как показано на рисунке 2. Далее, в качестве пар значений {Zi, ti} выбираются узлы сетки, расположенные наиболее близко к Z(ti). Полученное таким образом множество узлов оказывается дискретным представлением исходной непрерывной функции. Таким образом, любое сообщение, связанное с ходом Z(t), может быть преобразовано в дискретное, т.е. представлено посредством некоторого алфавита.

Рис.2.

Дискретизация аналогового сигнала за

счет операций развертки по времени и

квантования по величине

Рис.2.

Дискретизация аналогового сигнала за

счет операций развертки по времени и

квантования по величине

При такой замене довольно очевидно, что чем меньше n (больше t), тем меньше число узлов, но и точность замены Z(t) значениями Zi будет меньшей. Другими словами, при дискретизации может происходить потеря части информации, связанной с особенностями функции Z(t). На первый взгляд кажется, что увеличением количества точек n можно улучшить соответствие между получаемым массивом и исходной функцией, однако полностью избежать потерь информации все равно не удастся, поскольку n – величина конечная. Ответом на эти сомнения служит так называемая теорема отсчетов, доказанная в 1933 г. В.А.Котельниковым (по этой причине ее иногда называют его именем), значение которой для решения проблем передачи информации было осознано лишь в 1948 г. после работ К.Шеннона. Теорема, которую мы примем без доказательства, но результаты будем в дальнейшем использовать, гласит:

Непрерывный сигнал можно полностью отобразить и точно воссоздать по последовательности измерений или отсчетов величины этого сигнала через одинаковые интервалы времени, меньшие или равные половине периода максимальной частоты, имеющейся в сигнале.

Уточнения теоремы Шеннона.

Перечислим ограничения, не учитываемые теоремой Шеннона.

Теорема касается только тех линий связи, в которых для передачи используются колебательные или волновые процессы. Это не должно восприниматься как заметное ограничение, поскольку действие большинства практических устройств связи основано именно на этих процессах.

Любое подобное устройство использует не весь спектр частот колебаний, а лишь какую-то его часть; например, в телефонных линиях используются колебания с частотами от 300 Гц до 3400 Гц. Согласно теореме отсчетов определяющим является значение верхней границы частоты – обозначим его

.

.

Смысл теоремы в том, что дискретизация не приведет к потере информации и по дискретным сигналам можно будет полностью восстановить исходный аналоговый сигнал, если развертка по времени выполнена в соответствии со следующим соотношением:

![]() (1)

(1)

Можно перефразировать теорему отсчетов:

Развертка по времени может быть осуществлена без потери информации, связанной с особенностями непрерывного (аналогового) сигнала, если шаг развертки не будет превышать t, определяемый в соответствии с (1).

Например, для точной передачи

речевого сигнала с частотой до

=

4000 Гц при дискретной записи должно

производиться не менее 8000 отсчетов в

секунду; в телевизионном сигнале

![]() 4

МГц, следовательно, для его точной

передачи потребуется около 8000000 отсчетов

в секунду.

4

МГц, следовательно, для его точной

передачи потребуется около 8000000 отсчетов

в секунду.

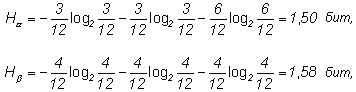

Однако, помимо временной развертки, дискретизация имеет и другую составляющую – квантование. Какими соображениями определяется шаг квантования Z? Любой получатель сообщения – человек или устройство – всегда имеют конечную предельную точность распознавания величины сигнала. Например, человеческий глаз в состоянии различить около 16 миллионов цветовых оттенков; это означает, что при квантовании цвета нет смысла делать большее число градаций. При передаче речи достаточной оказывается гораздо меньшая точность – около 1%; следовательно, для амплитуды звуковых колебаний Z 0,01·Zmax, а алфавит для обозначения всех градаций громкости должен содержать 100 знаков. Мы приходим к заключению, что шаг квантования определяется чувствительностью приемного устройства.

Указанные соображения по выбору шага развертки по времени и квантования по величине сигнала лежат в основе оцифровки звука и изображения. Примерами устройств, в которых происходят такие преобразования, являются сканер, модем, устройства для цифровой записи звука и изображения, лазерный проигрыватель, графопостроитель. Термины "цифровая запись", "цифровой сигнал" следует понимать как дискретное представление с применением двоичного цифрового алфавита.

Таким образом, преобразование сигналов типа N D, как и обратное D N, может осуществляться без потери содержащейся в них информации.

Преобразование типа D1 D2 состоит в переходе при представлении сигналов от одного алфавита к другому – такая операция носит название перекодировка и может осуществляться без потерь. Примерами ситуаций, в которых осуществляются подобные преобразования, могут быть: запись-считывание с компьютерных носителей информации; шифровка и дешифровка текста; вычисления на калькуляторе.

Таким образом, за исключением N1 N2 в остальных случаях оказывается возможным преобразование сообщений без потерь содержащейся в них информации. При этом на первый взгляд непрерывные и дискретные сообщения оказываются равноправными. Однако на самом деле это не так. Сохранение информации в преобразованиях N D и D N обеспечивается именно благодаря участию в них дискретного представления. Другими словами, преобразование сообщений без потерь информации возможно только в том случае, если хотя бы одно из них является дискретным. В этом проявляется несимметричность видов сообщений и преимущество дискретной формы. К другими ее достоинствам следует отнести:

высокая помехоустойчивость;

простота и, как следствие, надежность и относительная дешевизна устройств по обработке информации;

точность обработки информации, которая определяется количеством обрабатывающих элементов и не зависит от точности их изготовления;

универсальность устройств.

Последнее качество – универсальность – оказывается следствием того обстоятельства, что любые дискретные сообщения, составленные в различных алфавитах, посредством обратимого кодирования можно привести к единому алфавиту. Это позволяет выделить некоторый алфавит в качестве базового (из соображений удобства, простоты, компактности или каких-либо иных) и представлять в нем любую дискретную информацию. Тогда устройство, работающее с информацией в базовом алфавите, оказывается универсальным в том отношении, что оно может быть использовано для переработки любой иной исходной дискретной информации. Таким базовым алфавитом, как мы увидим в дальнейшем, является двоичный алфавит, а использующим его универсальным устройством – компьютер.

Несимметричность непрерывной и дискретной информации имеет более глубокую основу, чем просто особенности представляющих сигналов. Дело в том, что информация, порождаемая и существующая в природе, связана с материальным миром – это размеры, форма, цвет и другие физические, химические и прочие характеристики и свойства объектов. Данная информация передается, как было сказано, посредством физических и иных взаимодействий и процессов. Бессмысленно ставить вопросы: для чего существует такая информация и кому она полезна? Эту природную информацию можно считать хаотической и неупорядоченной, поскольку никем и ничем не регулируется ее появление, существование, использование. Чаще всего она непрерывна по форме представления. Напротив, дискретная информация – это информация, прошедшая обработку – отбор, упорядочение, преобразование; она предназначена для дальнейшего применения человеком или техническим устройством. Дискретная информация даже может не иметь прямого отношения к природе и материальным объектам, например представления и законы математики. Другими словами, дискретная – это уже частично осмысленная информация, т.е. имеющая для кого-то смысл и значение и, как следствие, более высокий (с точки зрения пользы) статус, нежели непрерывная, хаотичная. Однако в информатике, как было сказано, этот смысл не отслеживается, хотя и подразумевается. Эту же мысль можно выразить иначе: информатика имеет дело не с любой информацией и не с информацией вообще, а лишь с той, которая кому-то необходима; при этом не ставятся и не обсуждаются вопросы "Зачем она нужна?" и "Почему именно эта?" – это определяет потребитель информации.