- •4. Основные сведения о нейронных сетях

- •4.1. Введение

- •Каждый нейрон, входящий в нейронную сеть и представленный на рис. 1 в виде кружка, участвует в преобразовании входных сигналов, так что выходной сигнал зависит от алгоритма работы всех нейронов.

- •4.2. Модель нервной клетки (нейрона)

- •Лекция 24

- •4.3. Математическая модель нейрона

- •4.4. Многослойная нейронная сеть

- •4.5. Обучение нейронной сети

- •Лекция 25

- •4.6. Обратное распространение ошибки

- •Лекция 26

- •Если q – й нейрон расположен в k–ом скрытом слое (рис. 8), то согласно (17а) при замене r на q , 2 на k, 1 на k-1 и I на r,

- •4.7. Аппроксимация функций (моделирование) с помощью нейронных сетей (персептронов)

- •Нейронная сеть с радиальными базисными функциями

- •Cтруктура нейронной сети с радиально базисными функциями (рбф сети)

- •Методы обучения рбф сети

- •Лекция 27

- •Моделирование (идентификация) нелинейных динамических процессов (объектов)

- •3. Применение нейронных сетей (нс) для управления

- •3.1. Нейросетевые адаптивные системы управления

- •3.1.1. Нейросетевая технология адаптивной линеаризации обратной связью

- •3.1.2. Нейросетевое прямое и косвенное адаптивное управление на основе желаемой (эталонной) модели

- •Лекция 28

- •5. Синтез нейронных нечетких сетей

- •5.1. Введение

- •Адаптивные нейронные нечеткие системы инференции (anfis)

- •Структура anfis

- •Алгоритм обучения anfis

- •Генетические алгоритмы

- •Лекция 29

- •Генетические нечеткие системы (Извлечение нечетких знаний с помощью генетических алгоритмов)

- •Проектирование нечетких систем

- •Классификация генетических нечетких систем

- •4.6. Обратное распространение ошибки

Лекция 28

5. Синтез нейронных нечетких сетей

5.1. Введение

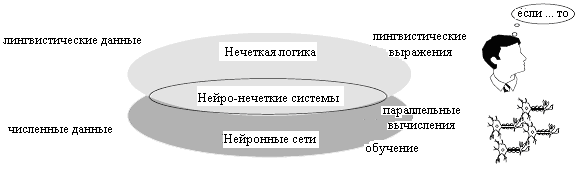

Различные типы интеллектуальных систем имеет свои особенности, например, по возможностям обучения, обобщения и выработки результатов, что делает их наиболее пригодными для решения одних классов задач и менее пригодными для других.

Например, нейронные сети хороши для задач идентификации объектов, но весьма неудобны для объяснения, как они такую идентификацию осуществляют. Они могут автоматически приобретать знания, но процесс их обучения зачастую происходит достаточно медленно, а анализ обученной сети весьма сложен (обученная сеть представляет обычно черный ящик для пользователя). При этом какую-либо априорную информацию (знания эксперта) для ускорения процесса ее обучения в нейронную сеть ввести невозможно.

Системы с нечеткой логикой, напротив, хороши для объяснения получаемых с их помощью выводов, но они не могут автоматически приобретать знания для использования их в механизмах вывода. Необходимость разбиения универсальных множеств (универсумов) на отдельные области, как правило, ограничивает количество входных переменных в таких системах небольшими значениями.

Вообще говоря, теоретически, системы с нечеткой логикой и искусственные нейронные сети подобны друг другу, однако, в соответствии с изложенным выше, на практике у них имеются свои собственные достоинства и недостатки. Данное соображение легло в основу создания аппарата нечетких нейронных сетей, в которых выводы делаются на основе аппарата нечеткой логики, но соответствующие функции принадлежности подстраиваются с использованием алгоритмов обучения нейронных сетей, например, алгоритма обратного распространения ошибки. Такие системы не только используют априорную информацию, но могут приобретать новые знания, являясь логически прозрачными.

Адаптивные нейронные нечеткие системы инференции (anfis)

Рассмотрим нечеткие нейронные сети, которые в англоязычной литературе получили название ANFIS (Adaptive Neuro-Fuzzy Inference System). ANFIS имеет структуру, которая по своим функциям эквивалентна нечеткой системе логического вывода, построенной с помощью нечетких базовых правил типа Такаги - Сугено. Грубо говоря, ANFIS является методом для настройки сформулированных базовых правил, точнее параметров соответствующих этим правилам функций принадлежности, с помощью алгоритмов обучения, основанных на комплекте обучающих (образцовых) данных. Такие алгоритмы позволяют адаптировать (приспосабливать) базовые правила к обучающим данным.

Структура anfis

Предположим без потери общности, что имеется два входа u1 и u2, и один выход y. Предположим также, что используется набор базовых правил типа Такаги-Сугено первого порядка, состоящий из двух правил

Если u1 есть A1 и u2 есть B1 , то y1=c11 u1 + c12 u2+c10 , (1)

Если u1 есть A2 и u2 есть B2 , то y2=c21 u1 + c22 u2+c20 . (2)

Между

прочим, нечеткий контроллер с такими

правилами может осуществлять интерполяцию

выходов двух линейных контроллеров.

Если степень истинности (возбуждающая

сила) правил равна

![]() и

и

![]() соответственно

для конкретных значений входов u1

и u2,

то выход

вычисляется как средневзвешенное

значение

соответственно

для конкретных значений входов u1

и u2,

то выход

вычисляется как средневзвешенное

значение

![]() .

(3)

.

(3)

Соответствующая нечеткая нейронная сеть показана на рис. 1.

Рис.1

Дадим описание слоев в этой сети.

Каждый нейрон в слое с номером 1 является адаптируемым с параметрической активационной функцией, роль которой выполняет соответствующая функция принадлежности

.

Выход этого нейрона представляет собой

степень, с которой данный вход

удовлетворяет функции принадлежности,

т. е.

.

Выход этого нейрона представляет собой

степень, с которой данный вход

удовлетворяет функции принадлежности,

т. е.

или

или

.

Примером функции принадлежности

является колоколообразная

функция

.

Примером функции принадлежности

является колоколообразная

функция

,

(4)

,

(4)

где {a, b, c} есть множество параметров. При изменении значений этих параметров изменяется форма колоколообразной функции принадлежности. Параметры этого слоя называют параметрами предпосылок (условий).

Каждый узел в слое 2 является фиксированным узлом, выход которого равен произведению всех поступающих на него сигналов. В общем случае, может быть использована любая другая нечеткая операция И, например, минимум. Выход каждого узла представляет собой степень истинности i-го правила

![]()

.

Каждый узел в слое 3 является фиксированным узлом, который вычисляет отношение степени истинности i-го правила и суммы степеней истинности всех правил

i=1,2

(5)

i=1,2

(5)

Таким путем осуществляется нормализация степени истинности.

Каждый узел в слое 4 является адаптивным слоем с выходным сигналом

![]() ,

i=1,2

,

,

i=1,2

,

где

![]() есть нормализованная

степень истинности, получаемая с выхода

слоя 3 и {

есть нормализованная

степень истинности, получаемая с выхода

слоя 3 и {![]() ,

,

![]() ,

,

![]() }

есть множество параметров этого узла.

Параметры этого слоя называются

параметрами

заключения.

}

есть множество параметров этого узла.

Параметры этого слоя называются

параметрами

заключения.

Каждый узел в слое 5 есть фиксированный узел, который суммирует все поступающие на него сигналы.

Легко обобщить структурную схему ANFIS, представленную на рис. 1, на базу правил, состоящую из более, чем двух правил.