- •Качество и надежность программного обеспечения

- •Лекция 1. Введение. Основные стандарты и термины по качеству программного обеспечения. Метрики и критерии качества программных продуктов. Составляющие качества программных продуктов.

- •Общие термины

- •Лекция 2. Классификация видов сложности программных продуктов. Метрические характеристики программ по м.Холстеду

- •Оценивание качества разработки программ на основе метрик Холстеда. Измеримые свойства алгоритмов

- •Длина программы

- •4. Объем программы

- •Потенциальный объем V*

- •Лекция 3. Уровень программ. Интеллектуальное содержание программы.

- •1. Уровень программы

- •2. Вывод уравнения уровня программы

- •3. Определение интеллектуального содержания программ

- •Лекция 4. Работа в программировании. Уровни языков программирования. Метрика числа ошибок в программе.

- •5 S 20 в сек

- •Значение уровня языка

- •Лекция 5. Метрики структурной сложности программ.

- •Где pi – количество вершин ветвления в I-том маршруте без учета последней вершины

- •M5 1 – 3 – 4 – 6 – 8 – 14 независимые

- •Лекция 6. Методы и средства измерения характеристик программ. Аппаратные измерительные мониторы.

- •Лекция 7. Программные измерительные мониторы.

- •Лекция 8. Понятие корректности программ.

- •II. Эталоны и методы проверки корректности.

- •Лекция 9. Аналитическая проверка корректности программ. Верификация программ.

- •Invk (x1, … , xn),

- •Invt1 (x1, … , xn): p ; invt2 (x1, … , xn): q ; invt3 (x1, … , xn) ; … ,

- •U: invr(x1, … , xn) u0

- •Лекция 10. Тестирование программных продуктов

- •1. Основные понятия процесса тестирования

- •2. Объекты тестирования

- •3. Категории тестов для различных объектов тестирования

- •Лекция 11. Виды, критерии и методы тестирования. Методы структурного тестирования программ

- •1. Тестирование на основе потока управления

- •2. Тестирование на основе потока данных

- •Лекция 12. Методы функционального тестирование программных продуктов

- •1. Метод эквивалентного разбиения

- •1.1. Выделение классов эквивалентности

- •1.2. Построение теста

- •2. Анализ граничных значений

- •3. Метод функциональных диаграмм

- •4. Метод, основанный на предположении об ошибке

- •Лекция 13. Основные показатели надежности программного обеспечения (по). Математические модели оценки надежности по.

- •13.1. Основные показатели надежности программного обеспечения (по).

- •13.2. Математические модели оценки надежности по.

- •Модель Джелинского-Моранды.

- •Модель Шика-Уолвертона.

- •Лекция 14. Модели, основанные на методе "посева" и разметки ошибок, и модели на основе учета структуры входных данных

- •Модель Нельсона. Применение последовательного анализа Вальда для снижения количества прогонов программы.

- •Лекция 15. Методы повышения надежности программ и оценка эффективности их применения.

- •15.1 Влияние избыточности на повышение надежности программ

- •Эффективность применения избыточности для повышения надежности комплексов программ

- •Влияние оперативного контроля и восстановления на производительность эвм.

- •Методы программного восстановления

- •Методы обеспечения надежности комплексов программ при сопровождении

- •Литература

Лекция 14. Модели, основанные на методе "посева" и разметки ошибок, и модели на основе учета структуры входных данных

Методы

оценки надежности программ, основанные

на моделях "посева" и разметки

ошибок, рассмотрены на примере трех

моделей: Милза, Бейзина и простой

эвристической модели. Согласно методике,

предложенной Милзом, программа изначально

“засевается” известным количеством

некоторых ошибок - M. Главное предположение

модели в том, что "засеянные" ошибки

распределены таким же образом, как и

естественные ошибки программы, и,

следовательно, вероятность обнаружения

для "засеянной" ошибки такая же,

как и для естественной. После этого

начинается процесс тестирования ПО.

Пусть во время тестирования было

обнаружено (m+v) ошибок, из которых m ошибок

было искусственно "засеяно", а v

ошибок содержалось в ПО изначально.

Тогда, согласно методу максимального

правдоподобия, начальное количество

ошибок в программе можно оценить

следующим образом: ![]() .

.

Серьезным недостатком этой модели является предположение об одинаковости распределения сгенерированных и естественных ошибок, которое невозможно проверить, особенно на более поздних стадиях разработки ПО, когда многие простые ошибки (такие, как синтаксические ошибки, например) уже исправлены, и только наиболее сложные для обнаружения ошибки еще остаются в ПО.

Теперь рассмотрим модель Бейзина. Пусть программный продукт содержит Nk команд. Из этих Nk команд произвольно выбираются n команд, и в каждую из этих n команд заносится ошибка. После этого для тестирования случайным образом выбирается r команд. Если в процессе тестирования было случайным образом обнаружено m “засеянных” и v естественных ошибок, это означает, что, согласно методу максимального правдоподобия, начальное количество ошибок в программе можно оценить следующим образом:

![]() где

скобками ][ обозначена целая часть числа.

где

скобками ][ обозначена целая часть числа.

При использовании такой процедуры уровень пометки (т.е. среднее количество помеченных команд) должен превышать 20, чтобы полученную оценку можно было считать достаточно объективной. Эти процедуры могут применяться на любой стадии после того, как написание кода программы закончено.

Теперь рассмотрим простую эвристическую модель. Эта модель была предложена Б. Руднером. Она позволяет избавиться от главного недостатка модели Милза. Здесь тестирование производится параллельно, двумя независимыми группами разработчиков ПО.

Пусть

![]() и

и ![]() - количество ошибок, обнаруженных,

соответственно, первой и второй группами,

а

- количество ошибок, обнаруженных,

соответственно, первой и второй группами,

а ![]() - количество общих ошибок, то есть

обнаруженных обеими группами, первой

и второй. Начальное количество ошибок,

содержащихся в программе, можно оценить,

используя гипергеометрическое

распределение и метод максимального

правдоподобия

- количество общих ошибок, то есть

обнаруженных обеими группами, первой

и второй. Начальное количество ошибок,

содержащихся в программе, можно оценить,

используя гипергеометрическое

распределение и метод максимального

правдоподобия

![]()

Модели, основанные на использовании структуры входных данных

В основе методов, использующих структуру входных данных, лежит модель, предложенная Нельсоном, которая начала применяться на практике только после ее доработки, связанной с применением последовательного анализа Вальда. Также к этой группе относится модель, разработанная фирмой IBM.

Модель Нельсона. Применение последовательного анализа Вальда для снижения количества прогонов программы.

Модель, предложенная Е. Нельсоном, основана на использовании структуры входных данных программы. В простейшем случае набор входных данных Ei, произвольно выбранный из пространства входных данных E, имеет равную априорную вероятность с другими наборами, входящими в E, и это дает оценку вероятности отказа по формуле (13.5).

Если

рассмотреть также и случай различных

вероятностей ![]() для

каждого набора данных, то оценка (13.5)

изменится следующим образом.

для

каждого набора данных, то оценка (13.5)

изменится следующим образом.

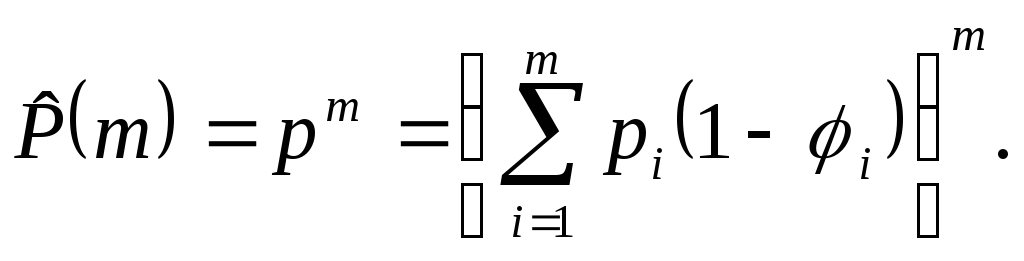

![]()

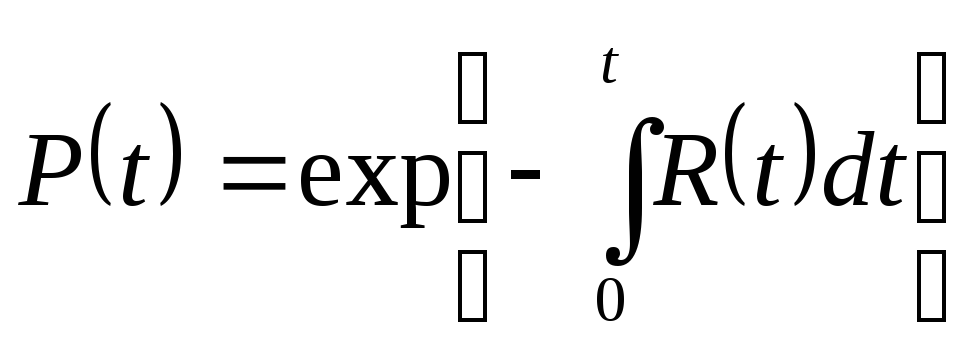

что позволяет записать следующее выражение для вероятности успешного прогона:

![]() (14.1)

(14.1)

Тогда вероятность успешного выполнения m прогонов, при условии, что набор входных данных для каждого прогона выбирается независимо и в соответствии с распределением, заданным формулой (14.1), будет равна:

(14.2)

(14.2)

Модель (14.2) позволяет дать следующее определение надежности ПО: надежность ПО – это вероятность его m безотказных прогонов.

Следующим шагом в развитии этой модели будет признать, что, как правило, предположение о том, что выбор входных данных происходит независимо для каждого прогона, на практике неверно. Исключение могут составлять только последовательности прогонов с постепенным увеличением значения входной переменной, или с использованием определенной последовательности процедур (как в системах реального времени).

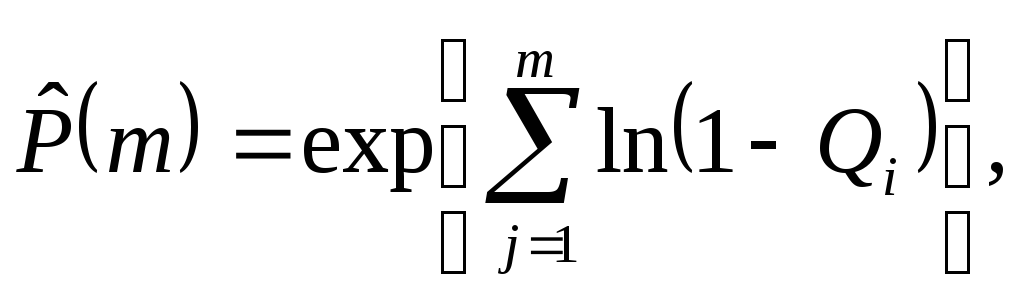

Принимая во внимание эти обстоятельства, необходимо переопределить распределение (14.1) в терминах вероятностей pij выбора набора данных Ei для j-того прогона программы из некоторой последовательности прогонов. Тогда вероятность отказа на j-том прогоне будет

![]()

Соответственно, вероятность безотказного выполнения m прогонов можно оценить следующим выражением:

![]()

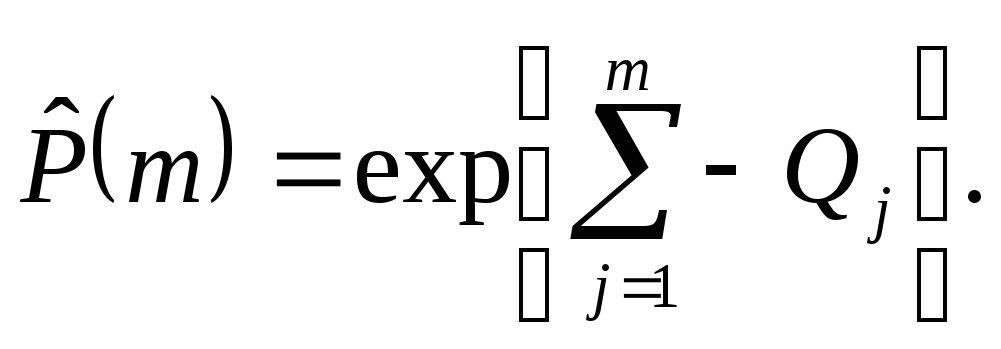

Это

выражение можно записать в виде

и

если Qi<<1,

тогда

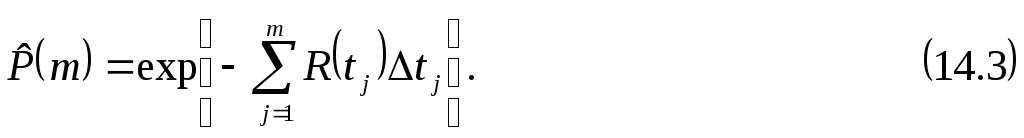

Обозначим

![]() - время выполнения j-того прогона

программы, и

- время выполнения j-того прогона

программы, и ![]() -

суммарное время, потраченное на выполнение

j прогонов, и будем использовать следующее

выражение для функции риска

-

суммарное время, потраченное на выполнение

j прогонов, и будем использовать следующее

выражение для функции риска

![]()

тогда мы имеем

Если

![]() ,

то сумма превращается в интеграл, и

формула (14.3) превращается в фундаментальное

отношение (13.2):

,

то сумма превращается в интеграл, и

формула (14.3) превращается в фундаментальное

отношение (13.2):

основного правила надежности.

При

использовании модели Нельсона на

практике встречаются две категории

трудностей. Первая связана с нахождением

![]() - параметров распределения входных

данных. Вторая связана с необходимостью

выполнения значительного количества

прогонов программы (десятки и сотни

тысяч) для получения приемлемой точности

для соответствующих оценок вероятности

(отказа или безотказной работы). Последняя

проблема решается применением хорошо

известного в статистике метода

последовательного анализа, предложенного

Вальдом.

- параметров распределения входных

данных. Вторая связана с необходимостью

выполнения значительного количества

прогонов программы (десятки и сотни

тысяч) для получения приемлемой точности

для соответствующих оценок вероятности

(отказа или безотказной работы). Последняя

проблема решается применением хорошо

известного в статистике метода

последовательного анализа, предложенного

Вальдом.

Модель, разработанная специалистами компании IBM.

Во время эксплуатации пользователем текущей версии ПО разработчики, как правило, занимаются активным сопровождением этого программного продукта, то есть вносят некоторые улучшения или исправления в данную версию, не дожидаясь, пока пользователь этого потребует. И это сопровождение может включать в себя также добавление новых функций в ПО. С некоторого момента, когда разработчик считает свою задачу выполненной, начинается, так называемое, пассивное сопровождение, когда исправления вносятся уже только по запросу пользователя.

В течение сопровождения в ПО вносится значительное количество новых ошибок в каждой новой версии, вместе с доработками, изменениями и исправлениями, что требует исправлений также и в следующей версии. Разработчики известной компании IBM попытались предсказать количество подобных исправлений от версии к версии, основываясь на большом количестве экспериментальных данных, собранных в ходе сопровождения операционной системы OS/360. Модель, предложенная специалистами IBM, основана на наблюдении за ходом разработки этого программного продукта, и на гипотезе о статистической стабильности зависимости между параметрами, характеризующими различные версии системы. В качестве основной единицы измерения сложности ПО был выбран программный модуль. Были стандартизованы правила создания модулей.

Объем

i-той версии выражается количеством

модулей Mi, входящих в данную версию. При

выпуске i –той версии системы изменялся

параметра СИМi

(количества старых исправляемых модулей),

и добавление некоторого числа новых

модулей НМi

, так что ![]() .

.

При доработке i-й версии (в период подготовки (i+1)-й) происходит дальнейшая коррекция модулей. Эти исправленный модули делятся на две группы: первая группа характеризуется параметром MИMi – многократно изменяемые модули (10 или более исправлений на модуль), и вторая группа – ИMi, модули с числом исправлений меньше 10. Эта классификация необходима для упрощения вычислений, а также из-за того факта, что небольшое число исправлений характерно для большинства модулей.

Также необходимо отметить, что группа ИM не требуют особых средств отладки, в то время как группа MИM может потребовать некоторых дополнительных усилий при отладке.

В ходе анализа истории сопровождения OS/360 фирмы IBM было установлено, что существует значительная зависимость между параметрами, характеризующими масштабы изменений и (соответственно) уровень содержания ошибок (в группах ИM и MCM), и параметрами, характеризующими сложность и объем следующей версии (СИМ, НМ). В применении к OS/VS1 это соотношение выглядело следующим образом.

![]() (14.7)

(14.7)

![]() (14.8)

(14.8)

Если предположить, что термины “исправление” и “ошибка” идентичны, то тогда модель для оценивания общего количества ошибок в программе, предложенная специалистами из IBM и основанная на приведенных выше объяснениях, записывается следующим образом:

![]() (14.9)

(14.9)

где ИЗМi - общее количество исправлений, внесенное в модули (или, другими словами, общее количество ожидаемых ошибок), а коэффициенты 23 и 2 – среднее количество исправлений на модуль для групп MИM и ИM, соответственно.

Прогноз основывается на запланированном количестве исправлений в старых модулях и на количестве добавляемых модулей (СИМi, НМi) для реализации новых требуемых функций ПО. Если количество действительно внесенных исправлений меньше, чем предсказанное количество исправлений, то можно сделать вывод, что в ПО существует еще некое количество необнаруженных ошибок. Модель фирмы IBM позволяет сделать следующие выводы:

на этапе пассивного сопровождения ПО (ИMi = 0, СИМi невелико) количество исправляемых модулей и количество исправлений внутри модулей быстро убывает от версии к версии;

количество ожидаемых ошибок в следующей версии может увеличится по сравнению с прошлой версией, если достаточно много старых модулей было изменено (СИМ), и/или было добавлено много новых модулей (НМ).

Добавление новых модулей оказывает более сильное влияние на рост числа новых ошибок, чем исправления, вносимые в старые модули; в то же время, если есть возможность создать новый модуль вместо изменения старых модулей (5 или более), то это снижает ожидаемое количество ошибок. Другими словами, на некотором этапе сопровождения ПО изменение уже существующих модулей теряет свою эффективность, и требуется добавление вместо этого нового модуля.