- •Билеты по информатике. Герасимов и.В. I семестр.

- •Объекты информации, сообщения, процессы. Объяснить суть объекта информации (энтропия).

- •Понятие сигнала (передача символа).

- •Спектры звуков

- •Спектры импульсных сигналов

- •5. Канал передачи данных без помех (кодер, декодер).

- •6. Оценка количества информации в сообщении.

- •7. Числовая интерпретация двоичного слова.

- •8. Логическая интерпретация двоичного слова. Представление множеств двоичными словами.

- •12. Основное назначение ос. Ос как модель pc для пользователя.

- •13. Основные функции ос.

- •14. Организация данных. Понятие файловой системы.

- •15. Фон-неймановская модель компьютера.

- •16. Модель открытой информационной системы. Общая характеристика корпоративной сети etunet.

- •17.Сервер сети. Назначение, виды, архитектура, основные функции.

- •18. Способы доступа к ресурсам сервера. Архитектура клиент – сервер

- •19. Клиент сети. Назначение, основные функции, организация доступа к ресурсам сети.

- •22. Текстовый редактор.

- •23.Нелинейная организация текста (гипертекст).

- •Замечания.

- •25. Высказывание. Структура логики высказывания.

- •Логические законы и правила

- •27. Гипотеза о физической символьной системе(ф.С.С.).

- •Абстрактная вычислительная машина Тьюринга.

- •11. Взаимодействующие аспекты знака (синтаксический, семантический, прагматический).

6. Оценка количества информации в сообщении.

Информация – получение информации это снятие неопределенности.

Количество информации в 1 бит мы получаем при проведении опыта в результате опыта с двумя равновероятными исходами.

Количество информации, полученное в результате проведения опыта с N-равновероятными исходами равно:

I=log 2 (N).

[I]=[1 бит]. Бит – это количество информации, снимающее неопределенность в одном опыте с двумя равновероятными исходами.

Пусть имеем множество из М элементов. Это множество может представлять собой ансамбль сигналов или алфавит канала передачи данных. При получении сообщения из N элементов мы получаем количество информации (при условии равновероятности появления каждого элемента):

I=N*log 2(M).

I= - N*log 2(P).

Очевидно, что вероятность появления буквы: Р=1/M.

Эта мера количества информации называется мерой Хартли.

В условиях, когда появление следующего символа неравновероятно, количество информации, несомое одной буквой, больше, если вероятность ее появления меньше. И наоборот. Среднее количество информации, несомое одной буквой:

![]()

![]()

Пример 1:

Рассмотрим крайний случай, когда мы точно знаем, что следующий символ будет именно таким: то есть Р=1:

I~log2 (1)=0.

Пример 2:

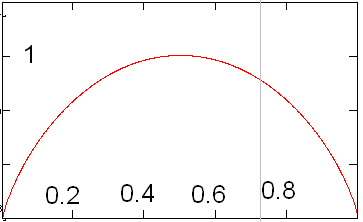

Пусть имеем опыт с двумя неравновероятными исходами (взаимоисключающими), то есть: 1=Р1+Р2

I=-P1log2(P1)-(1-P1)log2(1-P1)

График этой функции приведен ниже:

Смысл его в том, что среднее количество информации, приходящееся на одну переданную/полученную букву максимален в том и только том случае, когда появление букв этого алфавита равновероятно. Частный случай, когда вероятность появления одной из букв стремится к нулю (единице), среднее количество информации на принятый символ стремится к нулю, что иллюстрируется примером.

7. Числовая интерпретация двоичного слова.

Пусть имеем некоторое

множество натуральных чисел (для

примера):

Порядок элементов множества не важен. Нам нужно сопоставить каждому элементу этого множества некоторое двоичное слово. Очевидно, что нам понадобится слово длиной не менее 4 букв (двоичных). Также очевидно, что правил соответствия будет N!, где N – количество элементов множества. Одно из правил соответствия называется двоичная позиционная система счисления. Число в любой позиционной системе счисления в десятичную переводится по формуле:

![]()

Где р – основание системы счисления, соответственно b – цифра, а i – позиция данной цифры в слове (числе).

Тогда получаем взаимнооднозначное соответствие между элементами исходного множества и двоичными словами.

Но данное правило не единственно!

Существует также так называемый дополнительный код числа.

Разряд слова с наибольшим номером определяет знак числа: реально получаем, что в дополнительном коде вес цифры в этом разряде равен I=-bi, где i – номер позиции, а b – цифра в данной позиции.

Пример 1:

1=0001

7=0111

-7=1001

то есть дополнительный код получается(ДК) по правилу:

Инвертирование (то есть замена 1 на 0 и 0 на1) каждого бита прямого кода числа.

Добавление к полученному единицы.

Смысл введения ДК заключается в упрощении реализации арифметических операций с положительными и отрицательными числами, так как можно использовать одно устройство (сумматор двоичных чисел) для вычитания и сложения. В самом деле

|

7 |

0111 |

|

-7 |

1001 |

|

0 |

0000 |