1.03 Количество информации как мера уменьшения.

...docИнформатика. Лекция «Количество информации как мера уменьшения неопределённости знаний»

ЛЕКЦИЯ

Тема: Количество информации как мера уменьшения неопределённости знаний

Алфавитный подход к определению количества информации

План:

Количество информации как мера уменьшения неопределённости знаний

Алфавитный подход к определению количества информации

1. Количество информации как мера уменьшения неопределённости знаний

Информация и знания. Человек получает информацию из окружающего мира с помощью органов чувств, анализирует ее и выявляет существенные закономерности с помощью мышления, хранит полученную информацию в памяти. Процесс систематического научного познания окружающего мира приводит к накоплению информации в форме знаний (фактов, научных теорий и так далее). Таким образом, с точки зрения процесса познания информация может рассматриваться как знания.

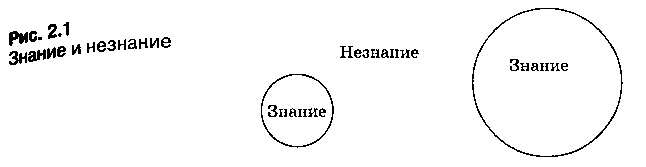

Процесс познания можно наглядно изобразить в виде расширяющегося круга знания (такой способ придумали ещё древние греки). Вне этого круга лежит область незнания, а окружность является границей между знанием и незнанием. Парадокс состоит в том, что чем большим объемом знаний обладает человек (чем шире круг знаний), тем больше он ощущает недостаток знаний (тем больше граница нашего незнания, мерой которого в этой модели является длиной окружности) — рис. 1.

Рис. 1. Знание и незнание

Так, объем знаний выпускника школы гораздо больше, объем знаний первоклассника, однако и граница его незнания существенно больше. Действительно, первоклассник ничего не знает о законах физики и поэтому не осознает недостаточности своих знаний, тогда как выпускник школы при подготовке к экзаменам по физике может обнаружить, что существуют физические законы, которые он не знает или не понимает.

Информацию, которую получает человек, можно считать мерой уменьшения неопределенности знаний. Если некоторое сообщение приводит к уменьшению неопределенности наших знаний, то можно говорить, что такое сообщение содержит информацию.

Например, после сдачи экзамена по информатике вы мучаетесь неопределенностью, вы не знаете, какую оценку получили. Наконец, экзаменационная комиссия объявляет результаты экзамена, и вы получаете сообщение, которое приносит полную определенность, теперь вы знаете свою оценку. Происходит переход от незнания к полному знанию, значит, сообщение экзаменационной комиссии содержит информацию.

Уменьшение неопределенности знаний.

Получение информации можно связать с уменьшением неопределённости знания. Это позволяет количественно измерять информацию, что чрезвычайно важно для информатики.

Рассмотрим вопрос об определении количества информации более подробно на конкретных примерах.

Пример.

Дано. Пусть у нас имеется монета, которую мы бросаем на ровную поверхность. С равной вероятностью произойдет одно из двух возможных событий — монета окажется в одном из двух положений: «орел» или «решка».

Решение. Можно говорить, что события равновероятны, если при возрастающем числе опытов количества выпадений «орла» и «решки» постепенно сближаются. Например, если мы бросим монету 10 раз, то «орел» может выпасть 7 раз, а «решка» — 3 раза, если бросим монету 100 раз, то «орел» может выпасть 60 раз, а «решка» — 40 раз, если бросим монету 1000 раз, то «орёл» может выпасть 520 раз, а «решка» — 480 и так далее.

В итоге при очень большой серии опытов количества выпадений «орла» и «решки» практически сравняются.

Перед броском существует неопределенность наших знаний (возможны два события), и, как упадет монета, предсказать невозможно. После броска наступает полная определенность, так как мы видим (получаем зрительное сообщение) что монета в данный момент находится в определенном положении (например, «орел»). Это сообщение приводит к уменьшению неопределенности наших знаний в два раза, так как до броска мы имели два вероятных события, а после броска — только одно, то есть в два раза меньше (рис. 2.)

Рис. 2. Возможные и произошедшие события

В окружающей действительности достаточно часто встречаются ситуации, когда может произойти некоторое количество равновероятных событий. Так, при бросании равносторонней четырехгранной пирамиды существуют 4 равновероятных события, а при бросании шестигранного игрального кубика — 6 равновероятных событий.

Чем больше количество возможных событий, тем больше начальная неопределенность и соответственно тем большее количество информации будет содержать сообщение о результатах опыта.

Единицы измерения количества информации.

Для количественного выражения любой величины необходимо определить единицу измерения. Так, для измерения длины в качестве единицы выбран метр, для измерения массы - килограмм и так далее. Аналогично, для определения количества информации необходимо ввести единицу измерения.

За единицу количества информации принимается такое количество информации, которое содержит сообщение, уменьшающее неопределенность в два раза. Такая единица названа «бит».

Бит – это двоичный разряд, который может принимать значение 0 или 1.

1 бит – это наименьшая единица измерения информации.

Если вернуться к опыту с бросанием монеты, то здесь неопределенность как раз уменьшается в два раза и, следовательно, полученное количество информации равно 1 биту.

Байт – это восемь подряд записанных битов. В информатике это наиболее употребляемая единица измерения информации, причём,

1 байт = 23 битов = 8 битов.

Пример. Одним байтом можно закодировать значение одного символа из 256 возможных. То есть одна буква, или цифра, или знак препинания, или другой символ и даже пробел – это 1 байт информации. Например, слово «информация» содержит 10 байт информации, а в битах это будет 10 · 8 = 80 бит.

В информатике система образования кратных единиц измерения количества информации несколько отличается от принятых в большинстве наук. Традиционны метрические системы единиц, например Международная система единиц (СИ)1, в качестве множителей кратных единиц используют коэффициент 10n, где п = 3, 6, 9 и так далее, что соответствует десятичным приставкам Кило (103), Мега (106), Гига (109) и так далее.

Компьютер оперирует числами не в десятичной, а в двоичной системе счисления, поэтому в кратных единицах измерения количества информации используется коэффициент 2n.

Так, кратные байту единицы измерения количества информации вводятся следующим образом:

1 Кбайт = 210 байт = 1024 байт;

1 Мбайт = 210 Кбайт = 1024 Кбайт;

1 Гбайт = 210 Мбайт = 1024 Мбайт.

Пример. Если на странице учебника помещается примерно 50 строк, а в каждой строке примерно 60 символов, то страница учебника, полностью заполненная текстом, имеет информационный объем 3 000 байт (около 3 Кб). Если в учебнике 250 страниц, то его объем информации будет равен 750 Кб.

Количество возможных событий и количество информации.

Существует формула, которая связывает между собой количество возможных событий N и количество информации I:

N=2I (1)

По этой формуле можно легко определить количество возможных событий, если известно количество информации.

Например, если мы получили 4 бита информации, то количество возможных событий составляло:

N = 24 = 16.

Наоборот, для определения количества информации, если известно количество событий, необходимо решить показательное уравнение относительно I.

Например, в игре «Крести-нолики» на поле 8 x 8 перед первым ходом существует 64 возможных события (64 различных варианта расположения «крестика»), тогда уравнение принимает вид: 64 = 2I.

Так как 64 = 26, то получим: 26 = 2I.

Таким образом, I = 6 битов, то есть количество информации, полученное вторым игроком после первого хода первого игрока, составляет 6 битов.

2. Алфавитный подход к определению количества информации

При определении количества информации на основе уменьшения неопределенности наших знаний мы рассматриваем информацию с точки зрения содержания, ее понятности и новизны для человека. С этой точки зрения в опыте по бросанию монеты одинаковое количество информации содержится и в зрительном образе упавшей монеты, и в коротком сообщении «Орел», и в длинной фразе «Монета упала на поверхность земли той стороной вверх, на которой изображен орел».

Однако, при хранении и передаче информации с помощью технических устройств целесообразно отвлечься от содержания информации и рассматривать ее как последовательность знаков (букв, цифр, кодов цветов точек изображения и так далее).

Набор символов знаковой системы (алфавит) можно рассматривать как различные возможные состояния (события). Тогда, если считать, что появление символов в сообщении равновероятно, по формуле (1) можно рассчитать, какое количество информации несет каждый символ.

Так, в русском алфавите, если не использовать букву ё, количество событий (букв) будет равно 32. Тогда: 32 = 2I, откуда I = 5 битов.

Каждый символ несет 5 битов информации (его информационная емкость равна 5 битов). Количество информации в сообщении (Iс) можно подсчитать, умножив количество информации, которое несет один символ (I), на количество символов (K) в сообщении:

Iс = I × K. (2)

Количество информации, которое содержит сообщение, закодированное с помощью знаковой системы, равно количеству информации, которое несет один знак, умноженному на количество знаков.

Формула Шеннона

Существует множество ситуаций, когда возможные события имеют различные вероятности реализации. Например, если монета несимметрична (одна сторона тяжелее другой), то при ее бросании вероятности выпадения «орла» и «решки» будут различаться.

Формулу для вычисления количества информации в случае различных вероятностей событий предложил К. Шеннон в 1948 году. В этом случае количество информации определяется по формуле:

![]() ,

(3)

,

(3)

где I — количество информации;

N — количество возможных событий;

рi — вероятность выбора i-го события.

Для частного, но широко распространенного и рассмотренного выше случая, когда события равновероятны (рi = 1/N), величину количества информации I можно рассчитать по формуле (формула Хартли):

![]() (4)

(4)

Например, пусть при бросании несимметричной четырехгранной пирамидки вероятности отдельных событий будут равны:

![]()

Тогда количество информации, которое мы получим после реализации одного из них, можно рассчитать по формуле (3):

I = - (1/2*log21/2 + 1/4*log21/4 + 1/8*log21/8 + 1/8*log21/8) битов =

= (1/2*log22 + 1/4*log24 + 1/8*log28 + 1/8*log28) битов =

= (1/2 + 2/4 + 3/8 + 3/8) битов = 14/8 битов = 1,75 бита.

Этот подход к определению количества информации называется вероятностным.

При бросании симметричной четырехгранной пирамидки вероятности отдельных событий равны между собой:

![]()

Количество информации, которую мы получим после бросания симметричной пирамидки, можно рассчитать по формуле (4):

![]()

Таким образом, при бросании симметричной пирамидки, когда события равновероятны, мы получим большее количество информации (2 бита), чем при бросании несимметричной пирамидки, когда события неравновероятны (1,75 бита).

Количество информации, которую мы получаем, достигает максимального значения, если события равновероятны.

ЗНАТЬ

ЗНАТЬ

В технике (теория кодирования и передачи сообщений) под количеством информации понимают количество кодируемых, передаваемых или хранимых символов.

Бит — двоичный знак двоичного алфавита {0, 1}.

Бит — минимальная единица измерения информации.

Байт — это восьмиразрядный двоичный код, с помощью которого можно представить один символ.

Байт — единица количества информации в системе СИ.

Единицы измерения информации в вычислительной технике

1 бит |

минимальная единица измерения информации |

1 байт |

= 8 битов |

1 Кб (килобайт) |

= 210байтов = 1024 байта ≈ 1 тысяча байтов |

1 Мб (мегабайт) |

= 210 Кб = 220 байтов ≈ 1 миллион байтов |

1 Гб (гигабайт) |

= 210 Мб = 230 байтов ≈ 1 миллиард байтов |

Информационный объем сообщения (информационная емкость сообщения) — количество информации в сообщении, измеренное в битах, байтах или производных единицах (килобайтах, мегабайтах и так далее).

В теории информации количеством информации называют числовую характеристику сигнала, которая не зависит от его формы и содержания и характеризует уменьшение неопределенности после получения сообщения в виде данного сигнала. В этом случае количество информации зависит от вероятности получения сообщения о том или ином событии.

Для абсолютно достоверного события (событие обязательно произойдет, поэтому его вероятность равна 1) количество информации в сообщении о нем равно 0. Чем невероятнее событие, тем большее количество информации несет сообщение о нем. Лишь при равновероятных ответах ответ «да» или «нет» несет один бит информации.

Количество информации при вероятностном подходе можно вычислить, пользуясь следующими формулами.

1. Формула Хартли:

I = log 2 N или 2I = N,

где N — количество равновероятных событий (число возможных выборов), i — количество информации.

2. Модифицированная формула Хартли:

I = log 2 (1/p) = - log 2 p ,

где р — вероятность наступления каждого из N возможных равновероятных событий.

3. Формула Шеннона:

,

где I — количество информации, приходящееся на один символ алфавита;

N — количество возможных событий;

рi — вероятность выбора i-го события.

Контрольные вопросы

Какие существуют единицы измерения информации?

Что является наименьшей единицей измерения информации?

Наиболее употребляемая единица измерения информации.

Как зависит количество информации от количества возможных событий?

В каком случае количество информации, полученной о событии, достигает максимального значения?

Почему количество информации в сообщении удобнее оценивать не по степени увеличения знания об объекте, а по степени уменьшения неопределённости наших знаний о нём?

Как определяется единица измерения количества информации?

1 СИ (SI, фр. Système International d’Unités) – международная система единиц, современный вариант метрической системы. СИ является наиболее широко используемой системой единиц в мире, как в повседневной жизни, так и в науке и технике. В настоящее время СИ принята в качестве законной системы единиц большинством стран мира и почти всегда используется в области науки, даже в тех странах, в которых в повседневной жизни используются традиционные единицы.