- •1. Определение и 2 направления развития искусственного интеллекта

- •2. Основные направления исследований в области ии

- •3)Моделирования биологических систем.

- •4. Условия для разработки и внедрения экспертных систем. Задачи, подходящие для создания экспертной системы.

- •Различие прототипов эс.

- •3. Интеллектуальные системы и признак структурированности задач.

- •Этапы проектирования эс: выбор проблемы. Коллектив разработчиков эс.

- •7. Основные программные блоки экспертной системы.

- •8. Этапы проектирования эс: оценка, стыковка и поддержка.

- •9. Различия бд и баз знаний

- •10. Продукционная модель знаний

- •11. Диагностические эс байесовского типа.

- •12. Семантические сети.

- •13. Фреймы.

- •14. Схема машины логического вывода. Особенности вывода на знаниях.

- •Стратегии получения знаний (извлечение, приобретение и формирование знаний).

- •Психологический аспект извлечения знаний.

- •Контактный слой:

- •Процедурный слой:

- •Когнитивный слой:

- •Лингвистический аспект извлечения знаний, общий код.

- •Проблема общего кода

- •Понятийная структура

- •Словарь пользователя

- •Текстологические и пассивные методы извлечения знаний.

- •Гносеологический аспект извлечения знаний, проблемы применения критериев научного знания.

- •Активные групповые методы извлечения знаний.

- •Активные индивидуальные методы извлечения знаний.

- •22. Структурирование знаний. Объектно–структурный подход и его свойства. Объектно-структурный анализ знаний о предметной области.

- •23. Алгоритм формирования поля знаний.

- •Уровни реализации моделей нейронных сетей (нс). Нейрокомпьютер. Сравнение архитектуры фон Неймана и архитектуры нейрокомпьютера.

- •Структура и свойства искусственного нейрона.

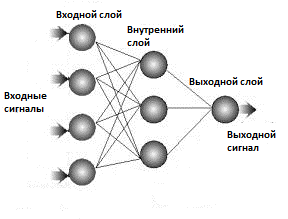

- •26. Типы нейронных сетей и типы нейронов в многослойной нс. Оценка числа нейронов в скрытых слоях.

- •27. Классы задач, решаемые нс. Примеры использования нс в различных предметных областях.

- •28. Определение и схема процесса обучения нс. От чего зависит качество обучения нс?

- •29. Алгоритм обратного распространения ошибки.

- •30. Обучение без учителя. Алгоритм Хебба.

- •Понятие самоорганизующейся нс. Настройка числа нейронов в скрытых слоях многослойной нс в процессе обучения.

- •1. Алгоритмы сокращения.

- •2. Конструктивные алгоритмы.

- •32. Нс с обратными связями (сеть Хопфилда и сеть Хемминга).

- •33. Когнитрон. Неокогнитрон.

- •34. Генетические алгоритмы. Отжиг.

- •35. Нечеткая логика. Лингвистическая переменная.

- •Основные понятия теории нечетких множеств: функция принадлежности, нечеткая переменная, нечеткое число.

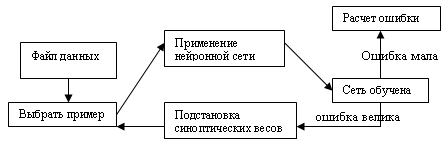

28. Определение и схема процесса обучения нс. От чего зависит качество обучения нс?

Обучение НС состоит в подборе значений синаптических весов и смещений при условии минимизации функции ошибки.

Обучение – это итерационная процедура.

Обучение – это задачи многомерной оптимизации (пример: найти глобальный минимум)

Схема обучения:

Качество обучения нейронной сети зависит от:

Количества примеров обучающей выборки

На сколько полно эти примеры описывают задачу

29. Алгоритм обратного распространения ошибки.

Алгоритм обратного распространения ошибки является одним из методов обучения многослойных нейронных сетей прямого распространения, называемых также многослойными персептронами.

Данный алгоритм относится к алгоритмам обучения с учителем. Для обучения сети, так же как и для однослойного персептрона, необходимо иметь множество пар векторов {xs, ds}, s = 1…S, где {xs} = {x1,…, хs} – множество входных векторов x, {ds} = {d1,…, ds} – множество эталонов выходных векторов. Совокупность пар {xs, ds} образуют обучающее множество. Количество элементов S в обучающем множестве должно быть достаточным для обучения сети, чтобы под управлением алгоритма сформировать набор параметров сети, дающий нужное отображение x → y. Количество пар в обучающем множестве не регламентируется. Если элементов слишком много или мало, сеть не обучится и не решит поставленную задачу. Выберем один из векторов х и подадим его на вход сети. На выходе получится некоторый вектор y. Тогда ошибкой сети можно считать Еs = ||ds – ys|| для каждой пары (xs, ds).

Алгоритмом обучения минимизируется суммарная квадратичная ошибка, которая имеет вид:

![]()

Где j – число нейронов в выходном слое сети.

Задача обучения ставится так: подобрать такие значения параметров сети, чтобы ошибка Е была минимальной для данного обучающего множества.

Алгоритм обратного распространения ошибки следующий:

1. Инициализировать сеть. Весовым коэффициентам и смещениям (порогам) сети присваиваются малые случайные значения.

2. Выбрать очередную обучающую пару (вектор) из обучающего множества и подать его (входной вектор) на вход сети.

3. Вычислить выход сети y(x)

4. Вычислить разность между выходом сети и требуемым значением для данного вектора (требуемым выходом)

5. Если была допущена ошибка при классификации выбранного вектора, то подкорректировать последовательно веса сети сначала между выходным и скрытым слоями, затем между скрытыми и входным (для минимизации ошибки).

6. Повторять шаги с 1 по 4 для каждого вектора обучающего множества до тех пор, пока ошибка на всем множестве не достигнет приемлемого уровня.

30. Обучение без учителя. Алгоритм Хебба.

В данном случае значения выходов заранее не известны.

Процесс обучения без учителя строится на том же принципе, что и обучение с учителем – подстраивании синаптических весов. Подстройка синапсов может происходить только на основании информации, доступной в нейроне, то есть его состояния и уже имеющихся весовых коэффициентов.

Рассмотрим метод обучения Хебба.

Веса по данному методу изменяются исходя из формулы:

![]()

где

![]() - выходное значение нейрона I

слоя n-1,

- выходное значение нейрона I

слоя n-1,

![]() - выходное значение j-го

нейрона слоя n,

α- коэффициент скорости обучения. n

- здесь и далее, номер слоя сети, t

– номер операции.

- выходное значение j-го

нейрона слоя n,

α- коэффициент скорости обучения. n

- здесь и далее, номер слоя сети, t

– номер операции.

При обучении данным методом усиливаются связи между возбужденными нейронами, что видно из второго слагаемого формулы. Как видно из формулы сильнее всего обучаются те синапсы, которые наиболее динамично изменились в сторону увеличения.

Алгоритм обучения Хебба выглядит следующим образом:

1. При инициализации сети всем весовым коэффициентам присваиваются небольшие случайные значения (положительные и отрицательные).

2. На входы подается выбранный случайным образом образ и сигналы возбуждения распространяются по всем слоям.

Для каждого нейрона рассчитывается сумма входных сигналов.

3. На основании полученных выходных значений нейронов по выше написанной формуле происходит коррекция весовых коэффициентов.

4. Цикл с шага 2, пока выходные значения сети сами не стабилизируются с заданной точностью.