- •Космические

- •1.Обобщенная структурная схема одноканальной рспи

- •Корреляционная функция

- •3.Основы теории информации. Количество информации, заключенной в одном дискрете (символе)

- •3.1 Информационные характеристики дискретных сообщенй

- •3.2 Скорость передачи информации, пропускная способность дискретного канала связи

- •3.4 Скорость передачи информации, пропускная способность канала связи при передачи непрерывных сообщений

- •4. Оптимальные приемники в системах передачи цифровой информации

- •Сверточные коды в рспи

- •Декодирование ск

- •2.Б) Бессиндромное декодирование ск:

- •Применение пс-сигналов в системах передачи цифровой информации

- •Когерентный прием пс-сигналов с дфМн и ортогонал.Информац.Модуляцией

- •Особенность некогерентного приема пс-символов

- •Быстрый поиск

- •Оценка времени поиска псп (последовательный метод поиска)

- •Применение ансамбля пс сигналов для передачи цифровой информации

3.Основы теории информации. Количество информации, заключенной в одном дискрете (символе)

a 1,

a2,

a3,…

aм

1,

a2,

a3,…

aм

алфавит сообщения

м -объем алфавита

I (ai) =f (Рi)

Рi – вероятные появления ai сигнала

Рi = Р(ai)

I (ai , bj) =f (Рi)+f(Рj)=f [P(ai , bj)]= f (Рi Рj)

Возьмем производную по Рi

f 1(Рi)=Pj f 1(Рi Рj)

Pi f 1=(Рi)= Pi Pj f 1(Рi Рj)=K – const

Pi f 1 =K

f 1(Рi)=к/ Рi

f (Рi)=Кln Рi+с с- постоянная интегрирования

Р i=1

I (ai)=0

i=1

I (ai)=0

Р i=0

Кln

1+с

=0

i=0

Кln

1+с

=0

С=0

I (ai )= Кln Рi

1= Кln

![]()

К=![]()

I (ai )= log2 Рi (бит)

I

(ai1,

ai2,…

ail)=![]() Рi

Рi

3.1 Информационные характеристики дискретных сообщенй

I (А ) – количество информации в фазе, приходящееся на один символ

1) I

(А )=![]() (ai1,

ai2,…

ail)

log2

Р

(ai1,

ai2,…

ail)

log2

Р![]() -

символы зависимые между собой.

-

символы зависимые между собой.

2) Если существует связь между символами ai и aj

I

(А )=![]() (ai

,aj)

log2

Р

(ai

,aj)

log2

Р![]() (бит)

(бит)

3) Если все символы алфавита взаимонезависимы, то

I

(А )=![]() Рi

log2

Рi=Н(А)

- энтропия источника дискретных сообщений

Рi

log2

Рi=Н(А)

- энтропия источника дискретных сообщений

Н(А) - количество информации в среднем приходящееся на 1 символ алфавита при их взаимной независимости

4) Если символы взаимно независимы и равной вероятности появления, то

![]()

Нmax (A)= log2 m – максимальная энтропия

m – объем алфавита

5 )

)

![]() =1-

=1-![]()

относительная скорость передачи информации

При прохождении канала связи КС:

А

А

ai канал bj

j=I,

m

ai канал bj

j=I,

m

связи

связи

i=I,m

B

i=I,m

B

n (t)

КС:

-

Симметричные и несимметричные

-

С памятью и без памяти

Наиболее характерные КС – несимметричные без памяти КС

6) взаимное количество информации в среднем на один символ на выходе КС:

I

(А; В )=

Н(А )-Н

(А/В )=

Н (В )-Н

(В/А )

(А; В )=

Н(А )-Н

(А/В )=

Н (В )-Н

(В/А )

условная энтропия

I (А; В)= Н(А )-Н (А/В )= Н (В )-Н (В/А )

Н(А ) – это источники сообщения

Н(В

)=![]() (bj

) log2

Р(bj)

(bj

) log2

Р(bj)

если канал связи симметричный без памяти:

m=m1

Р(bj)

=![]() (ai

,aj)=

(ai

,aj)=

![]() (ai)

Р (bj/

ai

)

(ai)

Р (bj/

ai

)

Условная энтропия – количество информации в среднем приходящийся на искаженный символ

Н (А/В

)=![]() (ai

, bj)

log2

Р(ai

, bj)

(ai

, bj)

log2

Р(ai

, bj)

Н (В/А

)=

Н (В/А

)=![]() (ai)·

Р (bj/

ai

)log2

Р (bj/

ai

)

(ai)·

Р (bj/

ai

)log2

Р (bj/

ai

)

Р (bj/ ai )= Рош, i ≠ j

1 – Рош= Рпр, i = j

Н (А )

кодирование источника сообщения

неравномерное

(А )

кодирование источника сообщения

неравномерное

Н макс

(А )

равномерное кодирование

макс

(А )

равномерное кодирование

3.2 Скорость передачи информации, пропускная способность дискретного канала связи

Пи – производительность источника

Пи=![]() =Vn·

Н(А )

(бит/с)

=Vn·

Н(А )

(бит/с)

Vn – скорость передаваемых символов (cим/c)

(количество символов в единицу времени)

Н(А ) – энтропия

В канале без помех:

R=Пи=

Vn·

Н(А )=![]() Н(А )

(бит/с)

Н(А )

(бит/с)

Vn = 1/Тс

Тс - длительность символа

R – скорость передачи информации

R макс=Ск= Vк· Нмакс(А) (бит/с) – максимальная скорость передачи информации в КС

Ск – пропускная способность дискретного канала связи

R=![]() [Н(В)-Н(В/А)]

(бит/с)

[Н(В)-Н(В/А)]

(бит/с)

Ск

=![]() [Нмакс(В)-Н(В/А)]

(бит/с)

[Нмакс(В)-Н(В/А)]

(бит/с)

Нмакс(В)= log2 m= Нмакс(А) – для симметричного канала связи без памяти

a 1

, a2

m=2 («0» и

«1»)

1

, a2

m=2 («0» и

«1»)

Н(А

)

=![]() Рj

log2

Рi

=Р(a1)

log2

Р(a1)

- Р(a2)

log2

Р(a2)=

Рj

log2

Рi

=Р(a1)

log2

Р(a1)

- Р(a2)

log2

Р(a2)=

= Р1 log2 Р1 –(1- Р1) log2 (1- Р1)

H(A)

Нмакс=1

Для бинарного канала с помехами:

R =1/ Тс [- Р1 logР1-(1-Р1) log2 (1-P1)+ Рoш log2 Рош+(1-Рош) log2 (1-Pош)]

Н (В/А

)=![]() (ai)·

Р (bj/

ai

)log2

Р (bj/

ai

) = Рoш

log2

Рош-(1-Рош)

log2

(1-Pош)

(ai)·

Р (bj/

ai

)log2

Р (bj/

ai

) = Рoш

log2

Рош-(1-Рош)

log2

(1-Pош)

пропускная способность канала

Ск

![]()

![]() [1+

Рoш

log2

Рoш

+(1-Рош)

log2

(1-Pош)]

[1+

Рoш

log2

Рoш

+(1-Рош)

log2

(1-Pош)]

Если m>2

Н (В/А

)=![]() (ai

) Р(bj/

ai

) log2

Р (bj/

ai

)=-(m-1)

Рoш

log2

Рoш

–

(ai

) Р(bj/

ai

) log2

Р (bj/

ai

)=-(m-1)

Рoш

log2

Рoш

–

-(1-Рош) log2 (1-Pош)

3.3 Количество информации передаваемой непрерывным сообщением

Х(t) – непрерывное сообщение как случайный процесс

Р(х) – плотность распределения Х(t)

х1, х2, ….. хm

t1, t2, ….. tm

∆= ti- ti-1

В соответствии с теоремой Котельникова

∆=![]() (n=2+8),

(n=2+8),

![]() -

верхняя

граничная частота

-

верхняя

граничная частота

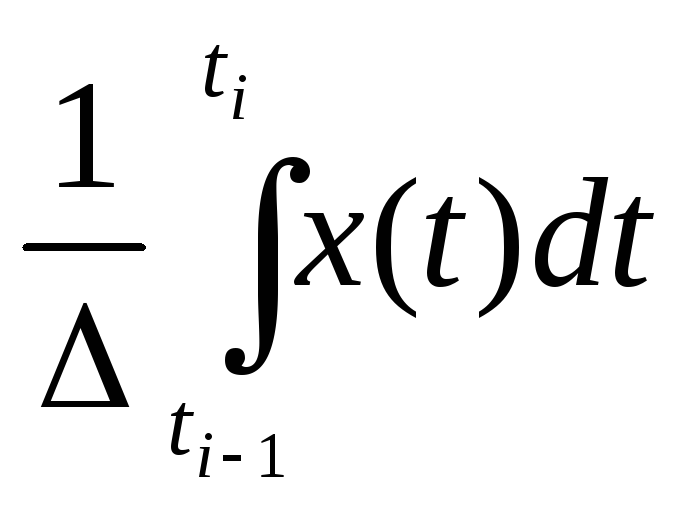

хi=

х i

Pi=P(xi)=

P(xi)·

∆ x,

∆ x

– ошибка измерения.

i

Pi=P(xi)=

P(xi)·

∆ x,

∆ x

– ошибка измерения.

xi – усредненное значение амплитуды

I

(x)=![]() P(xi)

· ∆ xi

log2

Р ( xi)·

∆ xi=

P(xi)

· ∆ xi

log2

Р ( xi)·

∆ xi=![]() P(xi)

· ∆ xi

log2

Р ( xi)-

P(xi)

· ∆ xi

log2

Р ( xi)-

![]() ∆

xi

log2

∆ xi

=

∆

xi

log2

∆ xi

=![]() P(xi)

· ∆ xi

log2

Р ( xi)-

log2∆

xi

P(xi)

· ∆ xi

log2

Р ( xi)-

log2∆

xi

I1(x)=lim

I (x)=-

![]() P(x) log2

Р

(x)dx- log2∆

x

P(x) log2

Р

(x)dx- log2∆

x

∆ xi

0

∆ xi

0

m ∞

m ∞

1 )

I1(x)=-

)

I1(x)=-

![]() P(x) log2

Р

(x)dx- log2∆

x (бит)

P(x) log2

Р

(x)dx- log2∆

x (бит)

h

(x)

h

(x)

дифференциальная энтропия источника непрерывных сообщений

h (x) – это количество информации в среднем приходящееся на одну выборку непрерывного сообщения

∆ x – ошибка

2 )

hмакс

(x)=

log2

)

hмакс

(x)=

log2![]()

P(x)=![]() lxp

lxp![]()

mx – мат.ожидание

X

(x(t)) КС У(у(t))

X

(x(t)) КС У(у(t))

n(t)

y(t) = x(t)+ n(t)

I(x;у)= h (x)- h (x/у)= h (у)- h (у/x)

h

(у/x)=

-![]()

![]() P(x,

у) log

Р (у/x)

dx

dу-

условная диф. энтропия - количество

информации в среднем приходящейся на

выборку шумового случайного процесса

P(x,

у) log

Р (у/x)

dx

dу-

условная диф. энтропия - количество

информации в среднем приходящейся на

выборку шумового случайного процесса

Если n(t) – нормальный случайный процесс, x(t) – норм.случ.процесс, то и у(t) – будет нор.случ.процесс

Е сли

n(t)

σ2n

сли

n(t)

σ2n

x(t)

σ2x

x(t)

σ2x

y(t)

σ2y

y(t)

σ2y

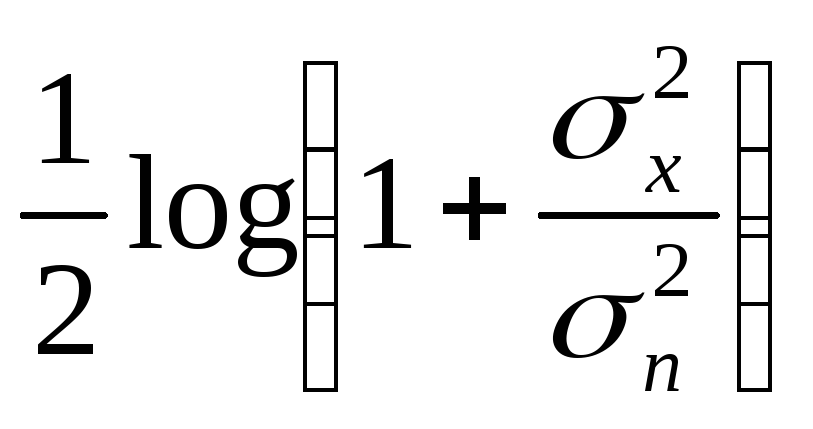

σ2y= σ2x+ σ2n

h

(у/x)=

log2![]()

h

(у)= log2![]()

I(x,у)=

log2![]() -

log2

-

log2![]() =

= (бит/с)

(бит/с)