- •1.Введение

- •2.Метрология

- •2.1 Физические величины и их единицы

- •2.1.1 Основные определения

- •2.1.2 Международная система единиц (си)

- •2.2 Воспроизведение и передача размера единиц

- •2.2.1 Эталоны единиц физических величин

- •2.2.2 Поверка и калибровка средств измерений

- •2.3 Основные вопросы измерений и средств измерений

- •2.3.1 Классификация измерений

- •2.3.2 Основные характеристики измерений.

- •2.3.3 Классификация средств измерений

- •2.4 Теория погрешностей и математическая обработка результатов измерений

- •2.4.1. Основные понятия и виды погрешностей

- •2.4.2 Вероятностный подход к описанию погрешностей

- •2.4.3 Основные законы распределения случайных погрешностей

- •Белый шум

- •Розовый шум

- •Броуновский (красный, коричневый) шум

- •Синий (голубой) шум

- •Фиолетовый шум

- •Серый шум

- •Оранжевый шум

- •Красный шум

- •Чёрный шум

- •Допуск в машиностроении

- •Линейные размеры, углы, качество поверхности, свойства материала, технические характеристики

- •Предельное отклонение угла конуса

- •Допуск формы и расположение поверхностей

- •Квалитет

- •Формальные определения

- •Определение по Шеннону

- •Определение с помощью собственной информации

- •Свойства

- •Математические свойства

- •Эффективность

- •Вариации и обобщения

- •Взаимная энтропия

- •4.1. Основные понятия и виды обратной связи в усилителях.

Квалитет

Квалитет является мерой точности. С увеличением квалитета точность понижается (допуск увеличивается).

-

Допуск по квалитету обозначается буквами IT с указанием номера квалитета, например IT8 — допуск по 8-му квалитету.

-

Квалитеты с 01 до 4-го используются для изготовления калибров и контркалибров.

-

Квалитеты от 5-го до 12-го применяют для изготовления деталей, образующих сопряжения (ГЦС).

-

Квалитеты от 13-го до 18-го используют для параметров деталей, не образующих сопряжений и не оказывающих определяющего влияния.

-

-

Основная закономерность построения допусков размеров (допуск обозначается IT = International tolerance),

-

IT, мкм = K * i,

-

где K — квалитет (число единиц допуска), i — единица допуска, мкм.

-

-

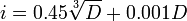

На диаметры от 1 до 500 мм единица допуска функционально связана с номинальным размером

,

мкм.

,

мкм.

-

Соответствующие значения допуска регламентируются стандартом на допуски и посадки (Limits and Fits) ISO 286-1:1988 [2], а также ГОСТ 25346-89. [3].

Энтропия Шеннона .

Информацио́нная энтропи́я — мера неопределённости или непредсказуемости информации, неопределённость появления какого-либо символа первичного алфавита. При отсутствии информационных потерь численно равна количеству информации на символ передаваемого сообщения.

Например, в последовательности букв, составляющих какое-либо предложение на русском языке, разные буквы появляются с разной частотой, поэтому неопределённость появления для некоторых букв меньше, чем для других. Если же учесть, что некоторые сочетания букв (в этом случае говорят об энтропии n-ого порядка, см. ниже) встречаются очень редко, то неопределённость ещё более уменьшается.

Для иллюстрации понятия информационной энтропии можно также прибегнуть к примеру из области термодинамической энтропии, получившему название демона Максвелла. Концепции информации и энтропии имеют глубокие связи друг с другом, но, несмотря на это, разработка теорий в статистической механике и теории информации заняла много лет, чтобы сделать их соответствующими друг другу.

Энтропия — это количество информации, приходящейся на одно элементарное сообщение источника, вырабатывающего статистически независимые сообщения.

|

|

Формальные определения

Информационная двоичная энтропия для независимых случайных событий x с n возможными состояниями (от 1 до n, p — функция вероятности) рассчитывается по формуле:

![]()

Эта

величина также называется средней

энтропией сообщения.

Величина

![]() называется

частной энтропией,

характеризующей только i-e

состояние.

называется

частной энтропией,

характеризующей только i-e

состояние.

Таким образом, энтропия события x является суммой с противоположным знаком всех произведений относительных частот появления события i, умноженных на их же двоичные логарифмы[1]. Это определение для дискретных случайных событий можно расширить для функции распределения вероятностей.

Определение по Шеннону

Шеннон предположил, что прирост информации равен утраченной неопределённости, и задал требования к её измерению:

-

мера должна быть непрерывной; то есть изменение значения величины вероятности на малую величину должно вызывать малое результирующее изменение функции;

-

в случае, когда все варианты (буквы в приведённом примере) равновероятны, увеличение количества вариантов (букв) должно всегда увеличивать значение функции;

-

должна быть возможность сделать выбор (в нашем примере букв) в два шага, в которых значение функции конечного результата должно являться суммой функций промежуточных результатов.

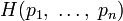

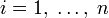

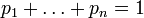

Поэтому функция энтропии H должна удовлетворять условиям:

-

определена

и непрерывна для всех

определена

и непрерывна для всех

,

где

,

где

для

всех

для

всех

и

и

.

(Нетрудно видеть, что эта функция зависит

только от распределения вероятностей,

но не от алфавита.)

.

(Нетрудно видеть, что эта функция зависит

только от распределения вероятностей,

но не от алфавита.) -

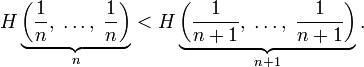

Для целых положительных n, должно выполняться следующее неравенство:

-

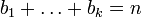

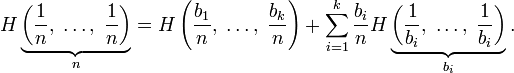

Для целых положительных bi, где

,

должно выполняться равенство:

,

должно выполняться равенство:

Шеннон показал, что единственная функция, удовлетворяющая этим требованиям, имеет вид:

![]()

где K — константа (и в действительности нужна только для выбора единиц измерения).

Шеннон

определил, что измерение энтропии (![]() ),

применяемое к источнику информации,

может определить требования к минимальной

пропускной способности канала, требуемой

для надёжной передачи информации в виде

закодированных двоичных чисел. Для

вывода формулы Шеннона необходимо

вычислить математическое

ожидание «количества информации»,

содержащегося в цифре из источника

информации. Мера энтропии Шеннона

выражает неуверенность реализации

случайной переменной. Таким образом,

энтропия является разницей между

информацией, содержащейся в сообщении,

и той частью информации, которая точно

известна (или хорошо предсказуема) в

сообщении. Примером этого является

избыточность

языка — имеются

явные статистические закономерности

в появлении букв, пар последовательных

букв, троек и т. д.

(см. цепи

Маркова).

),

применяемое к источнику информации,

может определить требования к минимальной

пропускной способности канала, требуемой

для надёжной передачи информации в виде

закодированных двоичных чисел. Для

вывода формулы Шеннона необходимо

вычислить математическое

ожидание «количества информации»,

содержащегося в цифре из источника

информации. Мера энтропии Шеннона

выражает неуверенность реализации

случайной переменной. Таким образом,

энтропия является разницей между

информацией, содержащейся в сообщении,

и той частью информации, которая точно

известна (или хорошо предсказуема) в

сообщении. Примером этого является

избыточность

языка — имеются

явные статистические закономерности

в появлении букв, пар последовательных

букв, троек и т. д.

(см. цепи

Маркова).

Определение энтропии Шеннона связано с понятием термодинамической энтропии. Больцман и Гиббс проделали большую работу по статистической термодинамике, которая способствовала принятию слова «энтропия» в информационную теорию. Существует связь между термодинамической и информационной энтропией. Например, демон Максвелла также противопоставляет термодинамическую энтропию информации, и получение какого-либо количества информации равно потерянной энтропии.