МИНИСТЕРСТВО НАУКИ И ОБРАЗОВАНИЯ УКРАИНЫ

Одесский Государственный Экологический Университет

Кафедра Информационных Технологий

ДОКЛАД

на тему:

Вероятностные нейронные сети

Выполнили

студенты гр. К-51

Ковтюк Р.М.

Волокхатюк Р.М.

Одеса 2011

План

Введение

1.Принципы работы вероятностной нейронной сети

2.Архитектура вероятностной нейронной сети

3.Модификации вероятностных нейронных сетей

Заключение

Список использованной литературы

Введение

Вероятностная нейронная сеть была разработана Дональдом Спехтом

Вероятностные нейронные сети (PNN) - вид нейронных сетей для задач классификации, где плотность вероятности принадлежности классам оценивается посредством ядерной аппроксимации. Один из видов так называемых байесовых сетей.

При решении задач классификации выходы сети можно с пользой интерпретировать как оценки вероятности того, что элемент принадлежит некоторому классу, и сеть фактически учится оценивать функцию плотности вероятности. Аналогичная полезная интерпретация может иметь место и в задачах регрессии - выход сети рассматривается как ожидаемое значение модели в данной точке пространства входов. Это ожидаемое значение связано с плотностью вероятности совместного распределения входных и выходных данных.

Задача оценки плотности вероятности (p.d.f.) по данным имеет давнюю историю в математической статистике и относится к области байесовой статистики. Обычная статистика по заданной модели говорит нам, какова будет вероятность того или иного исхода (например, что на игральной кости шесть очков будет выпадать в среднем одном случае из шести). Байесова статистика переворачивает вопрос вверх ногами: правильность модели оценивается по имеющимся достоверным данным. В более общем плане, байесова статистика дает возможность оценивать плотность вероятности распределений параметров модели по имеющимся данных. Для того, чтобы минимизировать ошибку, выбирается модель с такими параметрами, при которых плотность вероятности будет наибольшей.

При решении задачи классификации можно оценить плотность вероятности для каждого класса, сравнить между собой вероятности принадлежности различным классам и выбрать наиболее вероятный. На самом деле именно это происходит, когда мы обучаем нейронную сеть решать задачу классификации - сеть пытается определить (т.е. аппроксимировать) плотность вероятности.

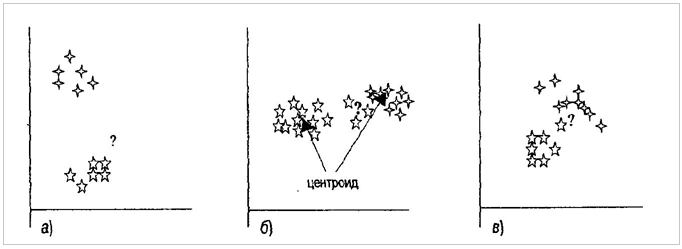

1.Принципы работы внс

В сети PNN образцы классифицируются на основе оценок их близости к соседним образцам. Расстояние до соседних образцов является важным фактором при классификации нового образца, но важными являются и особенности распределения соседних образцов. Статистические методы используют ряд критериев, на основе которых принимается решение о том, к какому из классов отнести еще неклассифицированный образец (рис.1). Одним из методов, на основе которого можно принять решение о классе нового образца, является вычисление центроида каждого класса (т.е. усредненной характеристики размещения всех образцов в классе). Такой метод прекрасно подходит для распределений, подобных показанному на рис.1а, но может приводить к ошибкам классификации при распределениях, подобных показанным на рис. 1б. Альтернативный простой и часто применяемый критерий классификации основан на использовании "ближайшего соседа", для неклассифицированного образца ищется ближайший образец с известным классом, и неклассифицированный образец относится к тому же классу. Но, опять же, такой метод тоже не всегда работает, что иллюстрирует рис. 1в. Более "изощренные" методы в дополнение к рассмотрению расстояния учитывают плотность распределения соседних образцов

Рис. 1. Не использующие управление методы классификации точек. В случае а) неизвестный экземпляр, обозначенный знаком "?", кажется принадлежащим классу *; в этом случае метод центроида правильно определяет класс. В случае б) неизвестный экземпляр кажется принадлежащим классу в этом случае метод центроида даст неверный результат. В случае в) неизвестный экземпляр кажется принадлежащим классу +: ближайший "сосед" этого экземпляра не является представителем класса *. В данном случае правильная классификация зависит от учета особенностей распределения соседних образцов

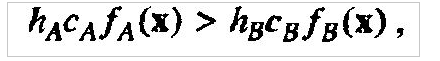

В основу классификации в сети PNN положено использование методов Байеса. Идея состоит в том, что для каждого образца можно принять решение на основе выбора наиболее вероятного класса из тех, которым мог бы принадлежать этот образец. Такое решение требует оценки функции плотности вероятностей для каждого класса. Эта оценка получается в результате рассмотрения учебных данных. Формальным правилом является то, что класс с наиболее плотным распределением в области неизвестного экземпляра будет иметь преимущество по сравнению с другими классами. Точно так же будет иметь преимущество и класс с высокой априорной вероятностью или высокой ценой ошибки классификации. Для двух классов А и В в соответствии с данным правилом выбирается класс А, если:

где h обозначает априорную вероятность, с — цену ошибки классификации, a f(x) — функцию плотности вероятностей. Вообще говоря, оценка стоимости ошибки классификации требует хорошего знания приложения, но во многих приложениях цена ошибки классификации и априорные вероятности выбираются одинаковыми для всех классов.

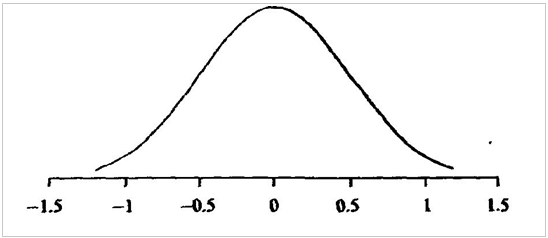

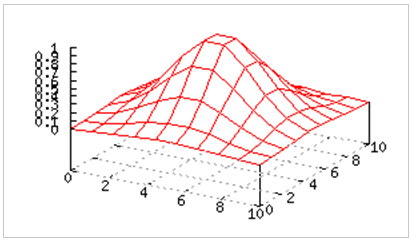

Игнорирование цены ошибки и априорных вероятностей все же не избавляет от необходимости оценки функции плотности распределения вероятностей. Оценить эту функцию можно с помощью метода Парцена, в котором используется весовая функция, имеющая центр в точке, представляющей учебный образец. Такая весовая функция называется функцией потенциала или ядром. Чаше всего в качестве ядра используется функция Гаусса. Форма этой функции в случае одной переменной показана на рис. 2. Для двух переменных (т.е. в двумерном случае) функция имеет форму колокола, как показано на рис. 3.

Рис. 2. Функция Гаусса одной переменной

Рис. 3. Функция Гаусса двух переменных

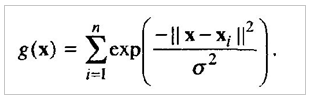

Чтобы построить функцию распределения класса, для каждого вектора рассматривается функция Гаусса с центром в точке, соответствующей этому вектору. Затем функции Гаусса для всех векторов суммируются, в результате чего получается нужная функция распределения. Оценка функции распределения в одномерном случае для данных, принадлежащих одному классу. На этот раз использовалась более простая форма функции Гаусса, а именно:

Параметр q задает ширину функций и определяет их влияние