МИНИСТЕРСТВО ЗДРАВООХРАНЕНИЯ РОССИЙСКОЙ ФЕДЕРАЦИИ

ГБОУ ВПО «ПЕРМСКАЯ ГОСУДАРСТВЕННАЯ

ФАРМАЦЕВТИЧЕСКАЯ АКАДЕМИЯ»

КАФЕДРА ФИЗИКИ И МАТЕМАТИКИ

Информатика Базовая часть

Учебно-методическое пособие

Пермь – 2013

Учебно-методическое пособие составил старший преподаватель кафедры физики и математики И.А.Чурилов.

Рецензент:

заведующий кафедрой физической и коллоидной химии ПГФА

профессор В.Л.Гейн.

Рекомендовано к изданию Ученым Советом ПГФА,

протокол №

Содержание

ВВЕДЕНИЕ ………………………………………………………………….. 4

ИСТОРИЯ ВЫЧИСЛИТЕЛЬНОЙ ТЕХНИКИ.

ЭТАПЫ РАЗВИТИЯ ЭВМ ………………………………………………… 5

ТЕОРИЯ ИНФОРМАЦИИ …………………………………..…………… 10

Определение информации .……………………………………………….. 10

Свойства информации .………………………………………………….… 10

Операции с данными ………………………………………………………. 11

Количественные характеристики информации.

Вероятностный и объемный подходы ..…………………………….……. 12

Синтаксическая, семантическая

и прагматическая меры информации …………………………………….... 14

ФОРМЫ ПРЕДСТАВЛЕНИЯ ИНФОРМАЦИИ в ЭВМ.

СИСТЕМЫ СЧИСЛЕНИЯ ………………………………………………… 16

ЛОГИЧЕСКИЕ ОСНОВЫ ЭВМ …….…………………………………….. 20

Алгебра логики. Логические высказывания ……………………………… 20

Булева алгебра. Основные логические операции …………………………21

Составление таблиц истинности для

сложных логических высказываний ……………………………….….…… 25

Упрощение логических высказываний …………………………………….27

СПИСОК ЛИТЕРАТУРЫ ……………….………………………………… 31

Введение

В данном учебно-методическом пособии рассмотрены классические положения и методы информатики, сыгравшие значительную роль в становлении этой науки в её современном виде, способствовавшие развитию вычислительной техники и программирования и приложению их к различным сферам человеческой деятельности. Материал представлен в объеме, соответствующем содержанию дисциплины «Информатика» для студентов, обучающихся по специальности «Фармация», в соответствии с Федеральным государственным образовательным стандартом высшего профессионального образования. Пособие предназначено для использования в качестве основного источника знаний при изучении предмета информатики студентами фармацевтической академии. Кроме того, оно полезно для самостоятельной подготовки студентов в период проверки остаточных знаний, так как в пособии в максимально краткой форме изложен материал, занимающий в учебниках по информатике десятки страниц и, как правило, разбросанный по разным разделам.

В разделе «История вычислительной техники. Этапы развития ЭВМ» рассмотрена периодизация процесса накопления знаний, приведшего к появлению в середине XX века вычислительных машин, сходных по принципам устройства с современными компьютерами. Отобраны и приведены важные исторические факты, насколько это возможно в небольшом издании, так как на тему истории вычислительной техники можно написать большую книгу.

В разделе «Теория информации» приведено несколько определений информации, рассмотрены количественные и качественные ее характеристики и свойства. Приведены сведения о мерах информации: синтаксической, семантической, прагматической. Рассмотрены два подхода к измерению количества информации: вероятностный (энтропийный) и объемный. Приведены формулы Хартли и Шеннона, определены единицы количества информации. Даны определения понятий «сигнал» и «данные», рассмотрены операции с данными.

В разделе «Формы представления информации в ЭВМ. Системы счисления» рассмотрены распространённые в вычислительной технике двоичная, восьмеричная и шестнадцатеричная системы счисления, их связь с традиционной десятичной системой. На примерах разобраны способы перевода чисел из одной системы счисления в другую.

В разделе «Логические основы ЭВМ» рассмотрены алгебра логики и булева алгебра, на базе которых проектируют логические элементы вычислительной техники. Даны определения и приведены примеры логических высказываний. Рассмотрены основные операции алгебры логики – инверсия, конъюнкция, дизъюнкция, а также импликация и эквиваленция, элементы И-НЕ и ИЛИ-НЕ. На примере продемонстрирована методика построения таблиц истинности сложных логических высказываний. Разобраны методы упрощения логических высказываний на основе применения законов логики. Законы логики сведены в наглядную таблицу.

История вычислительной техники. Этапы развития ЭВМ

В истории вычислительной техники можно выделить следующие этапы: домеханический, механический, электромеханический, электронный. Счетное устройство древних арабов – абак – относится к домеханическомуэтапу. ВXVIIвеке французский ученый Блез Паскаль создал первую суммирующую машину, ознаменовав началомеханическогоэтапа в истории вычислительной техники. Эта машина была воспринята современниками как курьез. Первое широко востребованное механическое вычислительное устройство – арифмометр – было создано немецким математиком Лейбницем в концеXVIIвека. Прародителем автоматических цифровых вычислительных машин стала аналитическая машина Чарльза Бэббиджа, которым была высказана мысль о предварительной записи порядка действий машины для последующей автоматической реализации их в программе. Бэббидж предложил использовать для записи и ввода программ в машину перфокарты, которые в то время применялись для управления ткацкими станками. Помощником Бэббиджа стала дочь английского поэта Байрона Ада Лавлейс, которую можно считать исторически первым программистом. Она теоретически разработала некоторые приемы управления последовательностью вычислений, использующиеся в программировании по сей день, и описала важнейшую конструкцию любого современного языка программирования - цикл. В аналитическую машину были заложены принципы, впоследствии ставшие фундаментальными для вычислительной техники:

1) автоматическое выполнение операций,

2) работа по вводимой «на ходу» программе (программа должна вводиться в исполнительное устройство со скоростью, соизмеримой со скоростью выполнения операций),

3) необходимость специального устройства - памяти - для хранения данных (Бэббидж назвал его «складом»).

Бэббидж спроектировал свое детище в 1822 году. В течение 30 последующих лет конструируя и совершенствуя свою машину, он натолкнулся на невозможность её реализации на базе механической техники. Вместе с тем до появления первого электромотора оставалось почти полвека, а первой электронной радиолампы - почти век. Революционные идеи Бэббиджа настолько опередили свое время, что были в значительной мере забыты и переоткрыты в следующем столетии.

Электромеханический этап развития вычислительной техники стартовал в 30-е годы XX века с началом работ по созданию релейных машин, в которых наряду с механическими конструкциями стали применяться электромеханические реле. Это позволило реализовать автоматически действующие вычислительные устройства. В 1944 году под руководством Говарда Айкена - американского математика и физика - на фирме IBM (International Business Machines) была запущена машина «Марк‑1», впервые реализовавшая идеи Бэббиджа (хотя разработчики, по-видимому, не были с ними знакомы). Для представления чисел в ней были использованы механические элементы (счетные колеса), для управления - электромеханические. Одна из самых мощных релейных машин РВМ-1 была построена в СССР в начале 50-х годов под руководством Н.И.Бессонова; она выполняла до 20 умножений в секунду с достаточно длинными двоичными числами. Однако век релейных машин оказался недолог, очень скоро они были вытеснены электронными машинами, гораздо более производительными и надежными.

Подлинная революция в вычислительной технике произошла в связи с изобретением электронных устройств. Электронный этап её развития отсчитывается с конца 30-х годов XX века, когда одновременно в США, Германии, Великобритании и СССР начались работы по созданию автоматических вычислительных машин, техническую основу которых составляли бы электронные лампы. К этому времени электронные лампы уже широко применялись в радиотехнических и радиопередающих устройствах.

Первой действующей электронной вычислительной машиной (ЭВМ) стала ENIAC (США, 1945 – 1946 годы). Руководили ее созданием Джон Моучли и Преспер Эккерт, продолжившие работу своего предшественника Джорджа Атанасова. Машина содержала порядка 18 тысяч электронных ламп, множество электромеханических элементов. Ее энергопотребление составляло 150 кВт.

Работы над созданием ЭВМ в Великобритании связаны прежде всего с именем Алана Тьюринга - математика, внесшего также большой вклад в теорию алгоритмов и теорию кодирования.

Первая отечественная ЭВМ - МЭСМ («малая электронно-счетная машина») - была создана в 1951 году под руководством Сергея Александровича Лебедева, крупнейшего советского конструктора вычислительной техники, впоследствии академика, лауреата государственных премий, руководившего созданием многих отечественных ЭВМ. Рекордной среди них и одной из лучших в мире для своего времени была БЭСМ-6 («большая электронно-счетная машина, 6-я модель»), созданная в середине 60-х годов и долгое время бывшая базовой машиной в обороне, космических и научно-технических исследованиях в СССР. Кроме машин серии БЭСМ выпускались ЭВМ других серий - «Минск», «Урал», М‑20, «Мир» и другие, созданные под руководством И.С.Брука и М.А.Карцева, Б.И.Рамеева, В.М.Глушкова, Ю.А.Базилевского и других отечественных конструкторов и теоретиков информатики.

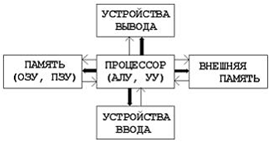

Огромный вклад в теорию и практику создания электронной вычислительной техники на начальном этапе ее развития внес один из крупнейших американских математиков Джон фон Нейман. Им были сформулированы шесть принципов функционирования вычислительной системы. Совокупность этих принципов породила классическую архитектуру ЭВМ, которая носит название архитектуры фон Неймана.

Принципы фон Неймана:

1) принцип использования двоичной системы счисления для представления команд и данных,

принцип программного управления,

принцип однородности памяти,

принцип адресности памяти,

принцип последовательного программного управления,

принцип условного перехода.

Архитектура фон Неймана

В истории вычислительной техники существует своеобразная периодизация ЭВМ по поколениям. Первоначально в ее основу был положен физико-технологический принцип: машину относят к тому или иному поколению в зависимости от используемых в ней физических элементов или технологии их изготовления. Границы поколений размыты, так как в действительности в одно и то же время выпускались машины разных уровней. Когда приводят даты, относящиеся к поколениям, то обычно имеют в виду период промышленного производства.

|

ЭВМ |

Элементная база |

|

ЭВМ первого поколения |

электронно-вакуумные лампы |

|

ЭВМ второго поколения |

дискретные полупроводниковые приборы (транзисторы) |

|

ЭВМ третьего поколения |

интегральные схемы |

|

ЭВМ четвертого поколения |

сверхбольшие интегральные схемы |

Вместе с тем физико-технологический принцип не является единственным при определении принадлежности той или иной ЭВМ к поколению. Следует считаться и с уровнем программного обеспечения, и с быстродействием, и с прочими факторами.

Персональные компьютеры относятся к ЭВМ четвертого поколения. Создание персонального компьютера неразрывно связано с изобретением в 1970 году Эдвардом Хоффом микропроцессора Intel 4004. Эта интегральная микросхема по своим функциям была аналогична блоку центрального процессора большой ЭВМ. Микропроцессор Intel 4004 интегрировал 2250 транзисторов, был производительнее первой ЭВМ ENIAC и в десятки тысяч раз дешевле современных ему больших ЭВМ. Недостатком микропроцессора Intel 4004 являлась его низкая разрядность – всего 4 бита. Первый восьмиразрядный микропроцессор Intel 8008 (3500 транзисторов, тактовая частота 500 кГц) был выпущен в 1973 году. Его усовершенствованная версия Intel 8080 стала основой первого коммерческого компьютера Altair, сконструированного в 1974-1975 годах Эдвардом Робертсом из компании MITS. В 1975 году для этого компьютера Полом Алленом и Биллом Гейтсом был создан интерпретатор языка Basic.

Началом эры массового распространения компьютеров стал 1976 год, когда появился компьютер Apple, разработанный американскими инженерами Стивом Возняком и Стивом Джобсом. За несколько лет было продано 2 миллиона экземпляров Apple, то есть впервые в мировой практике компьютер стал устройством массового производства.

Вскоре лидерство в этой области захватила фирма IBM. В 1981 году группой специалистов во главе с Джоном Эстриджем и главным конструктором Льюисом Эггебрехтом был создан получивший впоследствии широкую известность персональный компьютер IBM PC. Он базировался на микропроцессоре Intel 8088 с тактовой частотой 4,77 МГц. В 1983 году появилась следующая модель – IBM PC XT (eXTended), а в 1984 году – IBM PC AT (Advanced Technologies). Компьютер IBM PC AT использовал микропроцессор Intel 80286 с тактовой частотой 6-8 МГц. Он содержал также математический сопроцессор Intel 80287 и чипсет – набор системной логики на интегральных микросхемах сверхвысокой степени интеграции. Первый представитель другой ветви персональных компьютеров – Apple Macintosh – был представлен в том же 1984 году.

В последующие годы персональные компьютеры семейства IBM PC создавались на базе 32-разрядных (в настоящее время – 64-разрядных) процессоров и соответствующих чипсетов.

Большой популярности и повсеместному распространению персональных компьютеров способствовал принцип открытой архитектуры. Он подразумевает возможность расширения базовых функций компьютера путем интеграции с ним дополнительных устройств. Для этого требуется, чтобы архитектура компьютера была модульной и сведения о ней были доступны производителям оборудования. С появлением PC AT компания IBM сделала достоянием гласности принципы построения нового компьютера и тем самым стимулировала сторонних разработчиков к его совершенствованию.

Принцип открытой архитектуры обеспечил персональному компьютеру семейства IBMPCследующие преимущества:

открытые стандарты расширения возможностей компьютера,

возможность разработки плат расширения сторонними производителями,

простота подключения новых устройств,

возможность наращивания функций компьютера в соответствии с потребностями пользователя,

возможность варьирования конфигурации компьютера в соответствии с решаемыми задачами.

Несмотря на большую популярность, персональные компьютеры не являются единственными современными представителями ЭВМ. Для решения сложных вычислительных задач требуются гораздо более мощные системы. Вот схема классификации компьютеров, учитывающая их производительность, размеры и функциональное назначение:

Теория информации

Определение информации

В настоящее время нет единого подхода к определению понятия «информация». В каждой предметной области, будь то математика, кибернетика, философия, психология, естественные и гуманитарные науки, техника и связь, информацию определяют, исходя из целей исследований в данной области или практического применения. Наиболее краткими являются следующие определения.

Информация – это сведения, устраняющие или уменьшающие неопределенность.

Информация – это отражение внешнего мира с помощью знаков или сигналов.

Информация – это продукт взаимодействия данных и адекватных им методов.

Первое определение отражает вероятностный подход к понятию информации, развитый американским математиком Клодом Шенноном в середине XX века. Этот подход будет рассмотрен ниже в связи с введением термина «количество информации». Второе и третье определения включают два важных понятия информатики – сигнал и данные.

Сигнал – изменяющийся во времени физический процесс (например, электромагнитная волна), посредством которого осуществляется передача информации от источника к получателю. Сигналы бывают непрерывные и дискретные. Часто используют иную терминологию, называя непрерывные сигналы аналоговыми, а дискретные – цифровыми. В компьютерах используются цифровые сигналы.

Данные – это сигналы, зарегистрированные на материальном носителе.

Информация передается в виде сообщений, определяющих ее форму и представление. Средой передачи информации могут быть воздух, электрический или волоконно-оптический кабель, электромагнитное поле и иные среды. В качестве носителей информации используются различные материальные предметы, например: бумага, магнитные и оптические диски, полупроводниковые элементы.

Свойства информации

Информация, как и всякий объект, обладает рядом свойств.

Объективность информации подразумевает отсутствие искажений со стороны воспринимающего субъекта, независимость источника информации от ее получателя. Объективность информации является величиной относительной, так как прием и обработка информации всегда вносят в нее субъективный элемент.

Полнота информации определяет достаточность данных для принятия решений.

Достоверность характеризует неразрывность связи с источником информации, отсутствие ошибок (шума), вызванных влиянием посторонних объектов.

Адекватность – это соответствие реальному состоянию объекта информации.

Доступность – возможность получить информацию.

Актуальность – соответствие текущему состоянию объекта информации.

Перечисленные свойства являются характеристиками качества информации.

В технике выделяют еще несколько свойств, важных при осуществлении передачи, обработки и хранения информации.

Запоминаемость – возможность отобразить информацию на внешнем носителе.

Передаваемость характеризует способность информации сохраняться в ходе транспортировки и копирования.

Воспроизводимость – неизменность содержания информации после переноса ее на иной носитель.

Преобразуемость – способность информации менять способ и форму своего существования. Копируемость – свойство, связанное с преобразованием информации, при котором ее количество не меняется. В общем случае количество информации в процессах преобразования меняется, но возрастать не может. Стираемость - свойство, связанное с преобразованием информации, при котором ее количество уменьшается и становится равным нулю.

Перечисленные свойства информации тесно связаны с методами ее обработки. Обработка информации – процесс планомерного изменения ее содержания или формы представления. Для реализации этого процесса с помощью автоматических или автоматизированных систем информация должна быть представлена в виде данных. Обработка данных включает следующие операции.

Операции с данными

Ввод (сбор) — накопление данных с целью обеспечения достаточной полноты для принятия решений.

Формализация — приведение данных, поступающих из разных источников, к одинаковой форме для повышения доступности.

Фильтрация — отсеивание лишних данных, в которых нет необходимости, для повышения достоверности и адекватности.

Сортировка — упорядочивание данных по заданному признаку с целью удобства использования.

Архивация — организация хранения данных в удобной и доступной форме.

Защита — осуществление комплекса мер, направленных на предотвращение утраты, несанкционированных воспроизведения и модификации данных.

Транспортировка — прием и передача данных участниками информационного процесса.

Преобразование — перевод данных из одной формы в другую или из одной структуры в другую.

Перечисленные операции воздействуют на качество и количество информации.

Количественные характеристики информации.

Вероятностный и объемный подходы

Наряду с качественными, информация обладает также количественными характеристиками. Важной задачей является измерение количества информации.

В отношении определения количества информации существуют два основных подхода – вероятностный и объемный.

Вероятностный подход связан с определением информации как меры устранения неопределенности в отношении исхода некоторого события. Пусть событие имеет N возможных вариантов реализации. Неопределенность исхода события характеризуется величиной, называемой энтропия. Обозначим H1 и H2 энтропию соответственно до и после того, как событие произошло. Количество информации, полученное в результате события, равно I = H1 – H2. Если исход события дал конкретный и определенный результат, то H2 = 0, и количество информации равно первоначальной энтропии: I = H1. В этом случае говорят, что произошедшее событие устранило неопределенность.

Количество информации I зависит от энтропии H, которая, в свою очередь, определяется числом N возможных состояний системы. Энтропия H связана с N некоторой функциональной зависимостью f:

H = f (N).

Определение вида этой зависимости является важной задачей. В теории информации получена и обоснована формула H = log k N. Если основание логарифма k = 2, то

H = log 2 N .

Это формула Хартли. Она соответствует двоичной форме представления информации, принятой в компьютерной технике и во многих сетях связи.

В формуле Хартли H = 1, если N = 2. Отсюда следует, что единицей считается количество информации, полученное в результате проведения опыта, в котором возможны два различных равновероятных исхода. Если неопределенность полностью снимается опытом, то количество информации равно

I = log 2 2 = 1 .

Эта единица называется бит.

Существует несколько определений бита, но все они сходны между собой.

Бит - количество информации, необходимое для определения различий двух равновероятных событий.

Бит - количество информации, которое содержит сообщение, уменьшающее неопределенность знания в 2 раза.

Наряду с битом, используются и другие единицы измерения количества информации – нат, трит и дит (хартли). Переход к этим единицам осуществляется заменой в формуле Хартли основания логарифма соответственно на числа e (2,71828…), 3 и 10.

I = ln N [нат] ,

I = log 3 N [трит] ,

I = lg N [дит] .

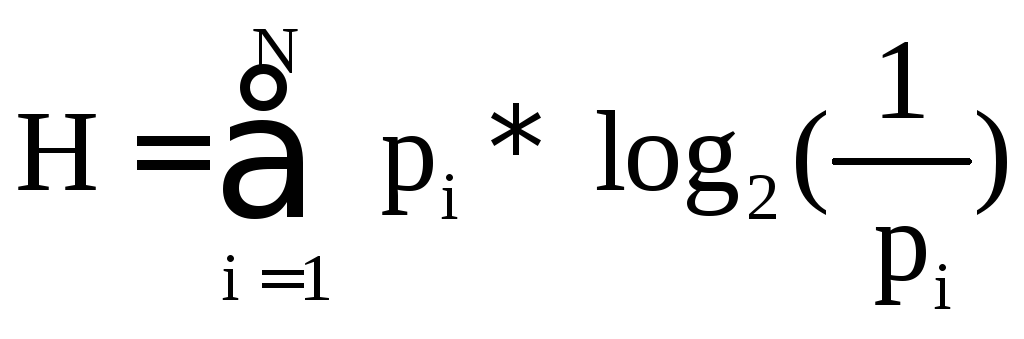

Можно преобразовать формулу Хартли, чтобы в нее входило не число N возможных вариантов исхода события, а вероятности их реализации. Для набора из N вариантов вероятность pi каждого исхода, если все варианты равновероятны, равна 1/N. На долю каждого исхода приходится одна N-я часть общей неопределенности опыта: 1/N * log 2 N = pi * log 2 (1/pi) . Тогда энтропия равна

,

,

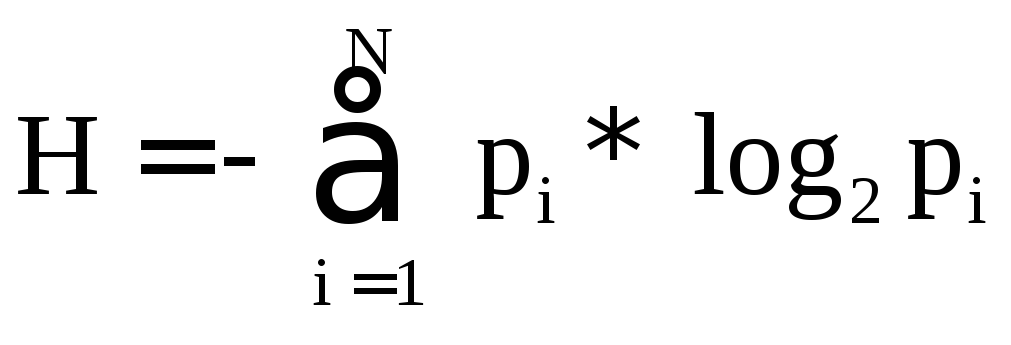

или, избавляясь от дроби в показателе логарифма,

.

.

Это формула Шеннона. Она же применяется, если вероятности возможных вариантов исхода события неодинаковы. Различие вероятностей уменьшает неопределенность, так как энтропия как мера информации максимальна, если все варианты исхода события равновероятны.

Таким образом, в общем случае вероятностного подхода количество информации рассчитывается по формуле

I = – (p1 log2 p1 + p2 log2 p2 + … + pN log2 pN) .

К объемному подходу привели практические работы по созданию ЭВМ. Поскольку в компьютерах используется двоичная система счисления, базовой единицей количества информации является бит. 1 бит требуется для представления двух цифр двоичной системы счисления – 0 и 1. С помощью этих цифр формируются все информационные сообщения в ЭВМ, следовательно, объем любого их них составляет целое число бит. В этом заключается отличие от вероятностного подхода, который допускает дробное число бит в сообщении.

Особенности архитектуры ЭВМ, в частности, процессора и памяти, увеличение их быстродействия, возможность оперировать большими объемами данных потребовало ввода новых единиц количества информации, больших, чем бит. В результате были введены байт и слово, а также кратные им величины.

Наиболее употребительной единицей количества информации является байт.

1 байт = 8 бит

В настоящее время 1 байт представляет минимальный адресуемый объем памяти в компьютере. Ниже в таблице приведены кратные байту единицы количества информации, используемые при работе с большими объемами данных.

1 Килобайт = 210 байт = 1024 байт

1 Мегабайт = 210 Кбайт = 1024 Кб = 220 байт

1 Гигабайт = 210 Мбайт = 1024 Мб = 230 байт

1 Терабайт = 210 Гбайт = 1024 Гб = 240 байт

1 Петабайт = 210 Тбайт = 1024 Тб = 250 байт

1 Экзабайт = 210 Пбайт = 1024 Пб = 260 байт

1 Зеттабайт = 210 Эбайт = 1024 Эб = 270 байт

1 Йоттабайт = 210 Збайт = 1024 Зб = 280 байт

Процессор оперирует порциями информации, называемыми словами. Простое слово равно 2 байтам, двойное слово – 4 байтам, расширенное слово – 8 байтам.