ДС Радиооптика_1 / Литература ч.1 / История техники связи

.pdf

294 |

ПИОНЕРЫ ИНФОРМАЦИОННОГО ВЕКА. История развития теории связи |

|

|

теоремы кодирования для марковских источников сообщений на общий класс эргоди- ческих источников, А. Файнстейна [30] и Дж. Вольфовица [31], которые в своих работах, выполненных после 1953 г., дали строгое, основанное на теории меры, доказательство теоремы кодирования каналов связи с шумом. Этими учеными были математически строго доказаны и обобщены теоремы кодирования для разных моделей дискретных и непрерывных источников сообщений и каналов связи.

В нашей стране важные в принципиальном отношении работы были выполнены академиком А.Н. Колмогоровым [32]. В одной из своих работ он ввел определение взаимной информации, которое, в отличие от подхода К. Шеннона, основывалось на теории рекурсивных функций [33]. Другой крупный отечественный математик членкорреспондент АН СССР А.Я. Хинчин доказал ряд результатов теории информации для случая, когда источники сообщения описываются стационарной марковской цепью. Ему принадлежит также строгое аксиоматическое обоснование теории информации, и он получил ряд важных асимтотических результатов этой теории [34, 35]. Обоснованию понятия взаимной информации и разработке методов ее вычисления были посвящены работы А.Н. Колмогорова и его учеников — профессоров И.М. Гельфанда, А.М. Яглома, Р.Л. Добрушина и М.С. Пинскера [36—41].

Р.Л. Добрушин ввел понятие информационной стабильности пар случайных переменных и установил общие условия, при которых справедливы теоремы К. Шеннона для каналов связи. М.С. Пинскером были разработаны критерии информационной устойчивости широкого класса случайных величин и процессов [39—41].

Особое место в развитии теории информации занимают работы крупного отече- ственного ученого Р.Л. Стратоновича. В своей книге [42], в которую вошли его работы 1965—1975 гг., он изложил проблемы теории информации с привлечением положений статистической термодинамики и теории оптимальных статистических решений. Им была также создана теория ценности хартлиевского, больцмановского и шенноновского количества информации.

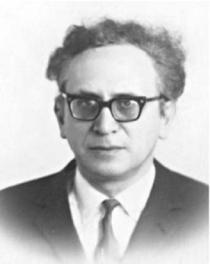

Марк Семенович ПИНСКЕР

Марк Семенович Пинскер — один из крупнейших отечественных ученых в области теории информации, родился 24 апреля 1925 г. После окончания механикоматематического факультета МГУ в 1949 г. работал в одном из научно-исследовательских институтов, а затем до 1955 г. —преподавал математику в средних школах. С 1955 г. начал работать в Лаборатории по разработке проблем проводной связи АН СССР, которая с 1961 г. стала Институтом проблем передачи информации.

Глава 4. Создание и развитие теории информации |

295 |

|

|

Â1958 г. М.С. Пинскер защитил кандидатскую, а в 1964 г. — докторскую диссертации

âобласти физико-математических наук. В 1973 г. ему было присвоено ученое звание профессора. Им было подготовлено более 20 кандидатов и пять докторов наук.

М.С. Пинскер принадлежит к научной школе выдающегося математика ХХ столетия академика А.Н. Колмогорова, который привлек в 50-х гг. его внимание к проблемам теории информации. Пинскеру принадлежат многие важные научные результаты в области теории связи, которые отражены в многочисленных публикациях (он опубликовал более 150 статей в ведущих научных журналах). Полученные им результаты охватывают широкий круг сложнейших проблем теории связи, а также математической статистики и эргодической теории, которые инициировали большое количество новых работ, выполненных другими учеными.

Âсередине 50-х гг. М.С. Пинскером независимо от другого крупного отечественного ученого А.М. Яглома были получены основополагающие результаты в теории оптимальной фильтрации и экстраполяции случайных процессов, которая нашла широкое применение в теории оптимального приема сигналов.

Фундаментальные результаты по теории информации были установлены М.С. Пинскером в начале 60-х гг. ХХ в. Они отражены в его работе «Информация и информационная устойчивость случайных величин и процессов» (Проблемы передачи информации. 1960. Вып. 7), которая получила мировую известность и была издана в 1964 г. в США. В ней были получены формулы, определяющие количество информации и скорость создания информации гауссовских случайных величин и процессов, а также определены критерии информационной устойчивости.

Ряд работ М.С. Пинскера (выполненных в середине 60-х гг. в соавторстве с И.А. Овсееви- чем) посвящен исследованию методов передачи сигналов по каналам со случайно изменяющимися параметрами. В этих работах были определены пропускная способность таких каналов, скорость передачи информации и т.д.

Совместно с Р.Л. Добрушиным им был получен важный результат — наличие у канала памяти увеличивает его пропускную способность. Цикл работ М.С. Пинскера (выполненных

â70—90-х гг. совместно с А.К. Горбуновым и Л.Б. Софманом) был посвящен различным обобщениям классического определения ε-энтропии и изучению их свойств. В этих работах рассматривались, в частности, общие свойства ε-энтропии сообщений и скоростей созда-

ния сообщений источником без предвосхищения, с прогнозом и с задержкой. Был исследован случай гауссовских и марковских источников сообщений.

Начиная с конца 70-х гг. М.С. Пинскер занимался проблемами кодирования и передачи информации в многокомпонентных системах связи. К ним относятся широковещательные системы связи и системы с многостанционным доступом, которые будут рассмотрены далее. Им было получено точное выражение для области пропускной способности широковещательного канала. Он определил также пропускную способность стационарных гауссовских широковещательных каналов, установил границы пропускной способности для дискретных каналов с многостанционным доступом при асимметричной связи.

Âначале 80-х гг. М.С. Пинскер (совместно с С.Ю. Ефроймовичем) начал рассмотрение проблем определения асимптотически достаточной статистики для оценки параметров сигналов. Определение этой статистики основывалось на использовании шенноновской информации об оцениваемом параметре, содержащейся в принятом сигнале. Он получил важные

296 |

ПИОНЕРЫ ИНФОРМАЦИОННОГО ВЕКА. История развития теории связи |

|

|

результаты, связанные с непараметрическим оцениванием параметров сигналов, а в начале 80-х гг. предложил непараметрический алгоритм оценки параметров сигнала, принимаемого на фоне шума, который быстро сводился к оптимальному с увеличением размерности выборки отсчетов принимаемого сигнала. Эти результаты М.С. Пинскера сыграли значи- тельную роль в развитии непараметрических методов оценки параметров сигнала, принимаемого на фоне шума, инициировав многочисленные работы адаптивных методов оценки параметров сигналов.

М.С. Пинскер исследовал (совместно с В.В. Преловым и С. Верду) влияние слабого дополнительного негауссовского шума на скорость создания сообщений стационарным гауссовским процессом и на пропускную способность гауссовского канала.

Значительны результаты, полученые М.С. Пинскером в области теории кодирования. Он был одним из первых, кто дал точную формулировку проблемы сложности в теории кодирования и получил ряд выдающихся асимптотических результатов. Исследуя каскадные коды, в которых в качестве внутреннего и внешнего используются сверточные коды, он доказал, что для любых таких кодов сложность их декодирования растет линейно с ростом длины, если кодовая скорость меньше пропускной способности канала связи. К важным результатам, полученным М.С. Пинскером в области теории кодирования, относится доказательство существования кодов, у которых кодовое расстояние и сложность кодирования растут линейно с увеличением их длины, а также существование кодов, для которых

ñувеличением их длины линейно растут кодовое расстояние, сложность декодирования и количество исправляемых ошибок. М.С. Пинскер построил последовательность кодов, для которых кодовое расстояние удовлетворяет границе Варшамова—Гильберта, а сложность декодирования не растет экспоненциально. М.С. Пинскер предложил и исследовал методы кодирования для обобщенных моделей каналов со случайными ошибками. Совместно

ñЛ.А. Бассалыго, С.И. Гельфандом и Р. Алсведе М.С. Пинскером были исследованы методы кодирования сообщений, когда при кодировании имеется определенная информация о возникающих в каналах ошибках. Им были проанализированы коды, корректирующие не только ошибки, но и дефекты (выпадения и вставки символов), определены длины кодов, корректирующих ошибки на локализованных позициях.

Важные результаты М.С. Пинскер получил в области теории коммутации каналов связи, предложив новый метод оценки сложности оптимального концентратора и неблокирующих схем коммутации. Он указал на принципиально новые способы построения коммутационных схем и разработал способ построения оптимальной неблокирующей схемы коммутации, имеющей наименьшую сложность.

М.С. Пинскер был всемирно признанным ученым. За научные заслуги в 1978 г. он стал лауреатом премии имени К. Шеннона, присужденной ему Институтом инженеров по электротехнике и электронике (IEEE), а в 1996 г. был награжден IEEE только что учрежденной медалью им. Р. Хемминга.

Марк Семенович Пинскер скончался 28 декабря 2003 г. в Москве.

Вычисления пропускной способности каналов связи. Отечественные и зарубежные ученые вели теоретические исследования, в которых развивались строгие методы вычисления пропускной способности каналов связи. В результате были получены приближенные, а в ряде случаев и точные формулы пропускной способ-

Глава 4. Создание и развитие теории информации |

297 |

|

|

ности векторных гауссовских каналов, каналов связи с замираниями уровня принимаемого сигнала, асинхронного канала связи с синхросимволом, безошибочно воспроизводимым на выходе канала. Развивались асимптотические методы вычисления пропускной способности для разных моделей каналов связи, рассматривались модели каналов связи с памятью, с негауссовским шумом, каналы с выпадением символов и т.п. Такие исследования в нашей стране были выполнены учеными Института проблем передачи информации Б.С. Цыбаковым [43], Л.П. Цареградским [44], И.А. Овсеевичем, Р.Л. Добрушиным, М.С. Пинскером, В.В. Преловым [45]. Исследования в данном направлении выполнялись и американскими учеными [46].

Вычисления надежности передачи сообщений по каналам связи. Значительное число исследований было посвящено определению асимптотических формул для показателя надежности связи E(R) для различных моделей каналов связи:

E(R) = − lim{log Pe [(2nR ,n)]}/ n,

n→∞

ãäå Pe[(2nR, n)] — вероятность ошибочного приема кодовой комбинации оптимального кода длины n (оптимальный код обеспечивает передачу информации со скоростью R по каналу связи).

Эти исследования важны тем, что они перекинули мост между двумя фундаментальными направлениями теории связи — теорией потенциальной помехоустойчивости и теорией информации. Это позволило получить доказательства теорем кодирования канала связи конструктивным путем, рассматривая задачу оптимального приема при наличии шума многопозиционных (2nR-позиционных) сигналов. Кроме того, что важно с практической точки зрения, они давали возможность, сравнивая показатели надежности конкретного кода, выбранного при проектировании системы связи, и оптимального кода, определить целесообразность применения выбранного кода.

Первым для непрерывного гауссовского канала подобное исследование выполнил в 1950 г. знаменитый американский ученый С.О. Райс [47]. Он ввел метод случайного кодирования и определил среднее значение функции E(R) для случайно выбранного кода, что давало оценку сверху функции E(R) для оптимального кода. В данном направлении работали многие крупные ученые: А. Файнштейн, рассмотревший [48] в 1955 г. подобную задачу как для непрерывного, так и для дискретного канала связи, и К. Шеннон, существенно уточнивший в 1959 г. результаты С.О. Райса и предложивший метод оценки снизу значения функции E(R).

Важные результаты были получены Р.Л. Добрушиным [49], рассмотревшим, в частности, каналы связи, в которых происходит стирание передаваемых символов, и видными американскими учеными П. Элайсом и Р. Фано. Эффективные методы получения нижней границы для E(R) были разработаны в 1967 г. выдающимися американскими учеными в области теории информации К. Шенноном, Р. Галлагером и Э. Берлекампом [50].

298 |

ПИОНЕРЫ ИНФОРМАЦИОННОГО ВЕКА. История развития теории связи |

|

|

Роберт ГАЛЛАГЕР

Роберт Галлагер родился 29 мая 1931 г. в Филадельфии, штат Пенсильвания (США). В 1953 г. он закончил Пенсильванский университет и получил степень бакалавра. Дальнейшее образование продолжил в Массачусетском технологическом институте (МТИ), где в 1957 г. получил степень магистра, в 1960 г. — — докторскую степень. Р. Галлагер — выдающийся американский ученый в области теории связи и ее применений, профессор электросвязи МТИ, член совета директоров Лаборатории информационных систем, а также систем, предназначенных для принятия решений, почетный член Института инженеров по электротехнике и электронике (IEEE). Он провел фундаментальные исследования в области беспроводных сетей, высокоскоростных сетей передачи данных, теории информации и теории сетей передачи дан-

ных. В центре его научных интересов проблемы передачи информации в системах с множественным доступом, теории информации, проблемы передачи информации по оптическим каналам связи, построения эффективных сетей передачи данных, стохастические процессы.

После завершения образования он в течение двух лет работал в знаменитой Белллаборатории, а позже в течение двух лет проходил военную службу в одной из корпораций. Работа, представленная им на соискание докторской степени, называлась «Коды с малой плотностью проверок на четность»»и была опубликована в 1963 г. [51]. В следующем году она была переведена на русский язык, а в 1974 г. — перепечатана в Сборнике фундаментальных работ в области теории информации, изданном Институтом инженеров по электротехнике и электронике (IEEE) под редакцией Э. Берлекампа. Эта работа не утратила своей актуальности и сегодня. В 1998 г. она была отмечена юбилейной золотой наградой Общества теории информации IEEE.

Ряд научных работ Р. Галлагера связан с теоремой кодирования каналов связи. Его статья «Простой вывод теоремы кодирования и ее применение», опубликованная в 1965 г., была отмечена в 1966 г. премией IEEE им. Бакера и в 1998 г. еще одной юбилейной золотой наградой Секции теории информации IEEE. Совместно с К. Шенноном и Э. Берлекампом в 1968 г. была опубликована фундаментальная статья, в которой предложен метод определения нижней границы вероятности ошибки кодирования в дискретном канале без памяти. В этом же году Р. Галлагером была написана и издана фундаментальная работа «Теория информации и надежная связь»,» которая является одной из лучших в мировой литературе монографий в данной области [52]. В 1974 г. под редакцией видных отечественных ученых М.С. Пинскера и Б.С. Цыбакова она была переведена на русский язык. Уже в течение многих лет эта книга остается одним из лучших учебников по теории информации и ее применениям.

Глава 4. Создание и развитие теории информации |

299 |

|

|

С середины 70-х гг. научные интересы Р. Галлагера перемещаются в область цифровых сетей передачи данных. В 1987 г. (в соавторстве с Д. Бертсекасом) в издательстве PrenticeHall выходит книга «Сети передачи данных»»[53], которая в 1989 г. под редакцией Б.С. Цыбакова издается на русском языке. В этой книге развивается теория массового обслуживания, используемая для проектирования систем множественного доступа и алгоритмов маршрутизации в сетях передачи данных. Рассматриваются вопросы организации связи в сетях с множественным доступом, таких как локальные сети, спутниковые сети и радиосети, а также вопросы маршрутизации и управления в сетях связи потоками данных. Второе издание этой книги вышло в 1992 г.

Â90-õ годах в центре научных интересов Р. Галлагера вновь оказываются проблемы теории информации и случайных процессов. В 1996 г. в издательстве Kluwer выходит его учебник «Дискретные стохастические процессы»»[54].

Профессор Р. Галлагер с 1979 г. — член Национальной инженерной академии, с 1992 г. — Национальной академии наук США, с 1999 г. — почетный член Американской академии искусств и наук. В течение многих лет он входит в совет управляющих Секции теории информации IEEE, в 1971 г. — ее президент, а с 1989 по 1992 г. — председатель Консультативного комитета по сетевым вопросам и инфраструктуре сетей связи. Галлагер активно участвовал в работе ряда других комитетов.

За фундаментальные научные исследования в области теории информации и теории кодирования он награжден многими престижными наградами IEEE. В 1993 г. ему была вручена награда МТИ как выдающемуся педагогу.

Â1962 г. Р. Галлагер участвовал в основании компании «Codex Corporation», вошедшей позже в состав одной из крупнейших в мире компаний в области связи «Motorola».»В течение многих лет он научный консультант этой компании. Его фундаментальные исследования квадратурной амплитудной модуляции и детектирования легли в основу разработки модемов на скорость 9600 бит/с, выпуск которых обеспечил коммерческий успех этой компании. Он же научный— консультант ряда других компаний и автор пяти патентов на изобретения.

Вычисления эпсилон-энтропии источников сообщений. Большинство видов информационных сообщений являются аналоговыми (например, источники аудио- и видеосигналов и др.). Для передачи таких сообщений в современных системах связи необходимо их преобразование в цифровой вид. Основу преобразования дает теорема В.А. Котельникова и ряд изобретений, сделанных в конце 30-х — середине 40-х гг. ХХ в., — изобретение импульсно-кодовой (ИКМ) и дельта-модуляции. Скорость цифрового потока, формируемого при таком преобразовании, тем выше, чем выше точ- ность, с которой требуется передать информационное сообщение по каналу связи.

Современная теория информации позволяет определить один из важнейших для оптимального проектирования любой системы связи параметров — скорость создания информации R(ε) источником сообщения или, как ее назвал в одной из своих работ академик А.Н. Колмогоров в 1956 г., ε-энтропию источника. В задачах теории связи на вход такого источника поступает аналоговый сигнал α(t) с определенными статисти- ческими характеристиками, а на его выходе заданной точностью ε формируется сигнал α*(t), который и передается по каналу связи. Впервые задача определения функции R(ε) была решена К. Шенноном в 1948 г. В 1959 г. он вернулся к этой проблеме.

300 |

ПИОНЕРЫ ИНФОРМАЦИОННОГО ВЕКА. История развития теории связи |

|

|

Знание R(ε) позволяет при анализе конкретных алгоритмов преобразования аналоговых сигналов в цифровую форму выбрать те из них, которые близки к оптимальным и могут при заданной точности воспроизведения этих сигналов передавать их по каналам связи со скоростью, близкой к R(ε).

В течение второй половины ХХ в. над созданием методов определения R(ε) для источников информации с разными статистическими характеристиками работали многие ученые. В работах отечественных ученых М.С. Пинскера, Б.С. Цыбакова, Л.А. Бассалыго, Р.Л. Добрушина, В.В. Прелова и др. [40, 55—57] была определена ε-энтропия для стационарных и нестационарных источников. Этой же теме посвящен ряд работ американских ученых Т. Дж. Гоблика, T. Бергера, Дж. Зива, С. Верду и др. [58—62], которые рассмотрели важные задачи передачи по гауссовским каналам связи сигналов от гауссовских источников сообщений.

§ 4. Разработка методов кодирования источников

Основополагающая статья К. Шеннона инициировала огромное число работ, в которых предлагались и исследовались различные алгоритмы кодирования источ- ников как аналоговых, так и дискретных сообщений. Эти алгоритмы представляют самостоятельный интерес. Они ценны также тем, что заложенные в них идеи могут составлять комбинации, давая эффективные инженерные решения конкретных задач, встречающихся на практике. Алгоритмы кодирования источников (или, что то же самое, алгоритмы устранения избыточности или сжатия данных) направлены на то, чтобы в наибольшей степени сократить количество бинарных знаков, приходящихся в среднем на один символ, поступающий от источника сообщений на вход кодера.

Алгоритмы кодирования могут быть классифицированы по двум критериям. Следует различать алгоритмы кодирования во-первых, без потерь и, во-вторых, с потерями информации, поступающей от источника сообщений. Первый тип алгоритмов применим только к дискретным сигналам и позволяет на выходе декодера всегда однозначно определить символ, поступивший от источника, а второй — определить этот символ с определенной ошибкой. В последнем случае должна быть задана мера искажений или критерий верности воспроизведения сигнала. Ко второму типу алгоритмов относятся все алгоритмы кодирования источников аналоговых сообщений. Алгоритмы кодирования дискретных источников могут быть как первого, так и второго типа. К первому типу относятся, например, алгоритмы кодирования Шеннона— Фано, Хаффмена, кодирования длин серий и др. Ко второму — импульсно-кодовая (ИКМ) и дельта-модуляция.

Согласно другому критерию классификации имеется четыре типа алгоритмов, каждый из которых характеризуется тем, что кодируется одновременно в последовательности либо одинаковой, либо разной длины символов, поступающих от источ- ника, и эти последовательности преобразуются в коды, имеющие либо фиксированную, либо переменную длину. Например, алгоритм кодирования Хаффмена преобразует последовательность символов одной длины в коды, длина которых пропорциональна log(1/pi), ãäå pi — вероятность появления i-й последовательности символов на входе кодера.

Глава 4. Создание и развитие теории информации |

301 |

|

|

4.1. Кодирование дискретных источников

К. Шенноном был предложен субоптимальный алгоритм кодирования (алгоритм Шеннона—Фано) дискретных источников, позволяющий сократить избыточ- ность передаваемых по каналу связи сообщений за счет того, что символам, появляющимся в передаваемой последовательности с большей частотой, присваивались более короткие кодовые комбинации. Предложенный алгоритм обладал свойством префиксности, т.е. ни одна из кодовых комбинаций, соответствующая определенному символу, не являлась началом любой другой кодовой комбинации. Префиксный код позволял однозначно восстановить переданную последовательность символов по принятой кодовой последовательности. Данное направление теории информации

âпоследующие годы получило значительное развитие в работах многих отечественных и зарубежных ученых.

Â1952 г. в США Д. Хаффмен — ученик профессора Р. Фано создал алгоритм построения оптимального неравномерного кода [1], в котором длина i-кодовой комби-

нации пропорциональна log(1/pi), ãäå pi — вероятность ее появления. До Д. Хаффмена такой код пытался построить Л. Крафт — другой ученик Р. Фано. Он не достиг в этом успеха, однако в 1949 г. им была доказана весьма важная теорема [2], известная

âтеории информации как неравенство Крафта. Эта теорема определяла условия, которым должны удовлетворять длины кодовых комбинаций неравномерного префиксного (однозначно декодируемого) кода. Б. МакМилан в 1956 г. доказал, что это условие гарантирует однозначное разделение и декодирование неравномерного кода. Позже Дж. Л. Дубом и А.И. Хинчиным было доказано, что средняя длина кодовой комбинации любого кода, удовлетворяющего условиям теоремы Крафта, не может быть меньше энтропии источника сообщений.

Метод кодирования источника, предложенный Д. Хаффменом, получил широкое применение для решения различных технических задач. Одно из них связано с сокращением избыточности компьютерных файлов, содержащих символы, закодированные восьмизначным ASCII-кодом. Согласно стандарту, обычно используются только 128 комбинаций этого кода, отображающих символы алфавита, цифры, знаки препинания, ряд служебных символов и т.п. Статистика содержания компьютерных файлов показывает, что в них 96% текста составляет 31 наиболее часто используемый символ, как, например, буквы а, б, в и т.д. Применяя подход Хаффмена, можно сократить избыточность файлов, используя для кодирования наиболее часто встречающихся символов пятизначные кодовые комбинации 00000, 00001, …, 11110. Для кодирования остальных символов следует использовать 13-значные кодовые комбинации, первыми пятью знаками которых является комбинация 11111. Такое построение кода позволяет добиться однозначного декодирования символов, закодированных короткими и

длинными кодовыми комбинациями. Среднее число бит, приходящихся на один символ, при этом составляет 0,96 Ч 5 + 0,04 Ч 13 = 5,32. Таким образом, сокращение избыточности при таком простом методе кодирования составляет 8/5,32 = 1,5 раза.

Другой распространенный метод кодирования источника — это кодирование длин серий одинаковых символов. Впервые такой метод был предложен [3] американским ученым А.Е. Лаймелом в 1951 г. В нашей стране этот метод предлагали и исследовали профессора И.И. Цуккерман [4] (1958 г.) и Э.Л. Блох [5] (1959 г.).

302 |

ПИОНЕРЫ ИНФОРМАЦИОННОГО ВЕКА. История развития теории связи |

|

|

Суть метода кодирования длин серий можно пояснить следующим примером. Пусть кодируется следующая последовательность, состоящая из 45 символов, 000000010011000001100000011000110000000100001. Как видно, вероятность появления символа 0 в данной последовательности велика, и поэтому в ней часто встречаются длинные серии 0. Выберем в данном случае максимальную длину серии 0, равную семи (в данном случае для кодирования длины серии достаточно трехзначного кода). В приведенной последовательности подчеркнуты серии из семи или меньшего числа 0, заканчивающиеся 1. Этим последовательностям присваивается трехзначный двоичный код, определяющий число содержащихся в них нулей. Код 000 присвоен символу 1, если перед ним нули отсутствуют. В результате такого кодирования эта последовательность будет представлена с помощью всего 33 символов следующим образом 111 000 010 000 101 000 110 000 111 000 100. Сокращение избыточности в данном случае составит 45/33 = 1,36 раза. Следует отметить, что с уменьшением вероятности появления символа 1 на выходе источника сообщения увеличивается максимальная длина серии 0, для которой выбирается код. При этом сокращение избыточности становится более существенным.

Новое направление теории кодирования дискретных источников дал в 1965 г. академик А. Н. Колмогоров. Он ввел термин «универсальное» кодирование [6], обозначающее кодирование источников сообщений, статистические характеристики которых (как это обычно бывает на практике) априорно неизвестны. Создатель универсальных кодов, избыточность которых минимальна для целого класса источников сообщений, — отечественный ученый Б.М. Фитингоф [7]. Развитие данного направления (начало 60-х — конец 80-х гг.) связано с работами отечественных ученых Б.Я. Рябко, Р.Е. Кричевского, В.К. Трофимова, Ю.М. Штарькова, В.Ф. Бабкина и др. За рубежом важные исследования были выполнены Р. Галлагером, П. Элайсом, Л. Дэвисоном, Я. Зивом и др.

Были разработаны «адаптивные» коды, занимающие промежуточное положение между универсальными и специально подобранными для определенного источника кодами. Адаптивные алгоритмы кодирования основаны на предварительном измерении параметров статистических моделей, описывающих поведение источников сообщений, и на дальнейшем кодировании сообщений с учетом этих параметров. Для этого в последовательности определенной длины, поступающей от источника сообщений, определяется частота появления в ней отдельных информационных символов. Эта информация, во-первых, используется для кодирования данных символов, например методом Хаффмена, и, во-вторых, сообщается об измеренных параметрах моделей на приемный конец линии связи, где их используют для декодирования принимаемых сообщений. Впервые задача адаптивного кодирования источника была рассмотрена в 1968 г. отечественным ученым Р.Е. Кричевским [8]. В США исследования в данном направлении в 1973 г. провел Т.М. Ковер [9]. В середине 80-х гг. эта проблема для источников с пуассоновской статистикой передаваемых символов изучались В.К. Трофимовым и Ю.М. Штарьковым.

Важные для построения универсальных кодов результаты были получены В.И. Левенштейном [10] и Б.Я. Рябко [11]. Левенштейн предложил (1968 г.) метод построения монотонного префиксного кода для записи натуральных чисел, а Б.Я. Рябко исследовал (1979 г.) метод кодирования так называемых монотонных источников, относительно ко-

Глава 4. Создание и развитие теории информации |

303 |

|

|

торых известно лишь то, что вероятности появления р(Аi) отдельных символов Аi на выходе источника связаны соотношением р(Аi) ≥ ð(Àj), если i < j. Эти результаты были им применены [12] при разработке метода кодирования источника, названного «сжатием с помощью стопки книг» (1980 г.). Несколько позднее этот же метод независимо открыл известный американский ученый П. Элайс, назвавший его «кодированием по степени новизны» [13]. Суть данного метода в следующем. По линии связи должно быть передано слово X из алфавита А, буквы которого А1, À2, …, ÀN отождествлены с числами 1, 2, …, N. На приемном и передающем концах имеются идентичные списки, которые в начальный момент содержат все указанные выше числа в порядке возрастания. При появлении в слове очередной буквы Аi по линии связи передается монотонный код номера позиции, занимаемой в списке данной буквой. Это позволяет однозначно декодировать переданную букву. Вслед за этим на передающем и на приемном концах ставят букву Аi на первую позицию и увеличивают на единицу номера букв, стоящих на позициях от 1 до i. Номера букв, стоящих на позициях от i + 1 до N остаются неизменными. Монотонный префиксный код устроен так, что более близкие к началу списка буквы получают более короткие коды. В результате часто повторяющиеся буквы, оказываются в процессе передачи в начале списка и имеют более короткие кодовые комбинации. Доказано [13], что данный метод кодирования по своей эффективности близок к методу кодирования Хаффмена. Этот метод легко приспосабливается к возможным изменениям статистических характеристик источника сообщений и поэтому назван локально адаптивным [14].

Превосходный алгоритм универсального кодирования источника был предложен в 1976— 1978 гг. израильскими учеными Я. Зивом и А. Лемпелем [15]. Этот алгоритм (алгоритм LZ) нашел широкое применение для сжатия текстовых файлов и файлов изображений в компьютерной технике, позволяя достичь весьма высокой степени сжатия файлов (до пяти раз). Информационным элементом в файлах является байт-блок из восьми бинарных знаков. Число блоков равно 28 = 256. Для кодирования файлов выбирают К-блоки из 12 бинарных знаков. Общее число различных К-блоков составляет 212 = 4096. Различным байтам присваивают первые 256 К-блоков. Алгоритм работает следующим образом. При кодировании поступающих с выхода источника байтов используют первые 256 позиций кодовой таблицы и, кроме того, в процессе кодирования анализируются сначала пары символов, состоящие из символа, кодируемого в данный момент, и ему предшествующего. Этим парам присваиваются К-блоки, в которых записаны их номера. Они последовательно дополняют кодовую таблицу, и если в ходе передачи вновь появляется такая пара символов, то ей с помощью кодовой таблицы присваивают 12-разрядный блок К. При кодировании соответствующие этой паре два байта (16 бит) заменяются одним К-блоком (12 бит), и в данном случае коэффициент сжатия составляет 16/12 = 1,33. В процессе кодирования и анализа в кодовую таблицу заносятся под определенными номерами появляющиеся вновь комбинации из трех, четырех и т.д. последовательно поступающих с выхода источника байтов. При повторном появлении таких комбинаций из трех, четырех и т.д. байтов (24, 32 и т.д. бита) они кодируются также одним К-блоком (12 бит). При этом коэффициент сжатия увеличивается и составляет 24/12 = 2, 32/12 = 2,66 и т.д.

После заполнения всей кодовой таблицы, имеющей 4096 позиций, процесс кодирования начинается заново. Это позволяет при кодировании источника адаптироваться к изменению статистических характеристик появления отдельных байтов в кодируемых файлах.