- •Об авторе

- •Предисловие

- •Для кого эта книга

- •О чем эта книга

- •Что вам потребуется при чтении этой книги

- •Условные обозначения

- •От издательства

- •Глава 1. Обзор алгоритмов

- •Что такое алгоритм

- •Этапы алгоритма

- •Определение логики алгоритма

- •Псевдокод

- •Использование сниппетов

- •Создание плана выполнения

- •Введение в библиотеки Python

- •Библиотеки Python

- •Реализация Python с помощью Jupyter Notebook

- •Методы разработки алгоритмов

- •Параметры данных

- •Параметры вычислений

- •Анализ производительности

- •Анализ пространственной сложности

- •Анализ временной сложности

- •Оценка эффективности

- •Выбор алгоритма

- •«О-большое»

- •Проверка алгоритма

- •Точные, приближенные и рандомизированные алгоритмы

- •Объяснимость алгоритма

- •Резюме

- •Глава 2. Структуры данных, используемые в алгоритмах

- •Структуры данных в Python

- •Список

- •Кортеж

- •Словарь

- •Множество

- •DataFrame

- •Матрица

- •Абстрактные типы данных

- •Вектор

- •Стек

- •Очередь

- •Базовый принцип использования стеков и очередей

- •Дерево

- •Резюме

- •Глава 3. Алгоритмы сортировки и поиска

- •Алгоритмы сортировки

- •Обмен значений переменных в Python

- •Сортировка пузырьком

- •Сортировка вставками

- •Сортировка слиянием

- •Сортировка Шелла

- •Сортировка выбором

- •Алгоритмы поиска

- •Линейный поиск

- •Бинарный поиск

- •Интерполяционный поиск

- •Практическое применение

- •Резюме

- •Глава 4. Разработка алгоритмов

- •Знакомство с основными концепциями разработки алгоритма

- •Вопрос 1. Даст ли разработанный алгоритм ожидаемый результат?

- •Вопрос 2. Является ли данный алгоритм оптимальным способом получения результата?

- •Вопрос 3. Как алгоритм будет работать с большими наборами данных?

- •Понимание алгоритмических стратегий

- •Стратегия «разделяй и властвуй»

- •Стратегия динамического программирования

- •Жадные алгоритмы

- •Практическое применение — решение задачи коммивояжера

- •Использование стратегии полного перебора

- •Использование жадного алгоритма

- •Алгоритм PageRank

- •Постановка задачи

- •Реализация алгоритма PageRank

- •Знакомство с линейным программированием

- •Практическое применение — планирование производства с помощью линейного программирования

- •Резюме

- •Глава 5. Графовые алгоритмы

- •Представление графов

- •Типы графов

- •Особые типы ребер

- •Эгоцентрические сети

- •Анализ социальных сетей

- •Введение в теорию сетевого анализа

- •Кратчайший путь

- •Создание окрестностей

- •Показатели центральности

- •Вычисление показателей центральности с помощью Python

- •Понятие обхода графа

- •BFS — поиск в ширину

- •DFS — поиск в глубину

- •Практический пример — выявление мошенничества

- •Простой анализ мошенничества

- •Анализ мошенничества методом сторожевой башни

- •Резюме

- •Глава 6. Алгоритмы машинного обучения без учителя

- •Обучение без учителя

- •Обучение без учителя в жизненном цикле майнинга данных

- •Современные тенденции исследований в области обучения без учителя

- •Практические примеры

- •Алгоритмы кластеризации

- •Количественная оценка сходства

- •Иерархическая кластеризация

- •Оценка кластеров

- •Применение кластеризации

- •Снижение размерности

- •Метод главных компонент (PCA)

- •Ограничения PCA

- •Поиск ассоциативных правил

- •Примеры использования

- •Анализ рыночной корзины

- •Ассоциативные правила

- •Оценка качества правила

- •Алгоритмы анализа ассоциаций

- •Практический пример — объединение похожих твитов в кластеры

- •Тематическое моделирование

- •Кластеризация

- •Алгоритмы обнаружения выбросов (аномалий)

- •Использование кластеризации

- •Обнаружение аномалий на основе плотности

- •Метод опорных векторов

- •Резюме

- •Глава 7. Традиционные алгоритмы обучения с учителем

- •Машинное обучение с учителем

- •Терминология машинного обучения с учителем

- •Благоприятные условия

- •Различие между классификаторами и регрессорами

- •Алгоритмы классификации

- •Задача классификации

- •Оценка классификаторов

- •Этапы классификации

- •Алгоритм дерева решений

- •Ансамблевые методы

- •Логистическая регрессия

- •Метод опорных векторов (SVM)

- •Наивный байесовский алгоритм

- •Алгоритмы регрессии

- •Задача регрессии

- •Линейная регрессия

- •Алгоритм дерева регрессии

- •Алгоритм градиентного бустинга для регрессии

- •Среди алгоритмов регрессии победителем становится...

- •Практический пример — как предсказать погоду

- •Резюме

- •Глава 8. Алгоритмы нейронных сетей

- •Введение в ИНС

- •Эволюция ИНС

- •Обучение нейронной сети

- •Анатомия нейронной сети

- •Градиентный спуск

- •Функции активации

- •Инструменты и фреймворки

- •Keras

- •Знакомство с TensorFlow

- •Типы нейронных сетей

- •Перенос обучения

- •Практический пример — использование глубокого обучения для выявления мошенничества

- •Методология

- •Резюме

- •Глава 9. Алгоритмы обработки естественного языка

- •Знакомство с NLP

- •Терминология NLP

- •Библиотека NLTK

- •Мешок слов (BoW)

- •Эмбеддинги слов

- •Окружение слова

- •Свойства эмбеддингов слов

- •Рекуррентные нейросети в NLP

- •Использование NLP для анализа эмоциональной окраски текста

- •Практический пример — анализ тональности в отзывах на фильмы

- •Резюме

- •Глава 10. Рекомендательные системы

- •Введение в рекомендательные системы

- •Типы рекомендательных систем

- •Рекомендательные системы на основе контента

- •Рекомендательные системы на основе коллаборативной фильтрации

- •Гибридные рекомендательные системы

- •Ограничения рекомендательных систем

- •Проблема холодного старта

- •Требования к метаданным

- •Проблема разреженности данных

- •Предвзятость из-за социального влияния

- •Ограниченные данные

- •Области практического применения

- •Практический пример — создание рекомендательной системы

- •Резюме

- •Глава 11. Алгоритмы обработки данных

- •Знакомство с алгоритмами обработки данных

- •Классификация данных

- •Алгоритмы хранения данных

- •Стратегии хранения данных

- •Алгоритмы потоковой передачи данных

- •Применение потоковой передачи

- •Алгоритмы сжатия данных

- •Алгоритмы сжатия без потерь

- •Практический пример — анализ тональности твитов в режиме реального времени

- •Резюме

- •Глава 12. Криптография

- •Введение в криптографию

- •Понимание важности самого слабого звена

- •Основная терминология

- •Требования безопасности

- •Базовое устройство шифров

- •Типы криптографических методов

- •Криптографические хеш-функции

- •Симметричное шифрование

- •Асимметричное шифрование

- •Практический пример — проблемы безопасности при развертывании модели МО

- •Атака посредника (MITM)

- •Избежание маскарадинга

- •Шифрование данных и моделей

- •Резюме

- •Глава 13. Крупномасштабные алгоритмы

- •Введение в крупномасштабные алгоритмы

- •Определение эффективного крупномасштабного алгоритма

- •Терминология

- •Разработка параллельных алгоритмов

- •Закон Амдала

- •Гранулярность задачи

- •Балансировка нагрузки

- •Проблема расположения

- •Запуск параллельной обработки на Python

- •Разработка стратегии мультипроцессорной обработки

- •Введение в CUDA

- •Кластерные вычисления

- •Гибридная стратегия

- •Резюме

- •Глава 14. Практические рекомендации

- •Введение в практические рекомендации

- •Печальная история ИИ-бота в Твиттере

- •Объяснимость алгоритма

- •Алгоритмы машинного обучения и объяснимость

- •Этика и алгоритмы

- •Проблемы обучающихся алгоритмов

- •Понимание этических аспектов

- •Снижение предвзятости в моделях

- •Решение NP-трудных задач

- •Упрощение задачи

- •Адаптация известного решения аналогичной задачи

- •Вероятностный метод

- •Когда следует использовать алгоритмы

- •Практический пример — события типа «черный лебедь»

- •Резюме

Эмбеддинги слов |

269 |

7. Теперь спрогнозируем результаты контрольного набора:

y_pred = classifier.predict(X_test)

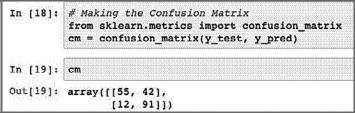

8. Матрица ошибок выглядит следующим образом (рис. 9.3).

Рис. 9.3

Исходя из матрицы ошибок, мы можем оценить ошибочность классификации.

ЭМБЕДДИНГИ СЛОВ

В предыдущем разделе мы узнали, как выполняется NLP с помощью мешка слов в качестве абстракции для входных текстовых данных. Одним из глав ных достижений в NLP является возможность создания значимого числово го представления слов в виде плотных векторов. Эта техника называется эмбеддингами слов (word embedding). Йошуа Бенжио впервые ввел этот термин в своей статье «A Neural Probabilistic Language Model» («Нейронновероятностная языковая модель»). Любое слово в задаче NLP можно рас сматривать как категориальный объект. Сопоставление каждого слова со списком чисел, представленных в виде вектора, называется эмбеддингом слов.

Иначе говоря, это методология преобразования слов в действительные чис ла. Особенность эмбеддинга состоит в том, что он использует плотный вектор, в отличие от традиционных подходов, применяющих разреженные векторы.

Существует две проблемы‚ связанные с использованием BoW для NLP:

zz Потеря семантического контекста. При токенизации данных их контекст теряется. Слово может иметь разные значения в зависимости от того, где именно оно используется в предложении. Это становится еще более важным при интерпретации сложных особенностей человеческой речи, например юмора или сарказма.

270 |

Глава 9. Алгоритмы обработки естественного языка |

zz Разреженный входной вектор. При токенизации каждое слово становится признаком (как мы убедились на предыдущем примере). Это приводит к раз реженным структурам данных.

Окружение слова

Ключевое понимание того, как представлять для алгоритма текстовые данные (в частности, отдельные слова или лексемы), приходит из лингвистики. В эм беддингах мы обращаем внимание на окружение (neighbourhood) каждого слова. Оно помогает определить значение и важность слова. Окружение слова — это набор других слов, находящихся рядом с данным и задающих его контекст.

Обратите внимание, что в BoW слово теряет свой контекст, так как он зависит от окружения, в котором слово находится.

Свойства эмбеддингов слов

Хорошие эмбеддинги слов обладают следующими четырьмя свойствами.

zz Они плотные. По своей сути эмбеддинги являются факторными моделями. Таким образом, каждый компонент вектора эмбеддинга представляет собой величину некоторого (скрытого) признака. Обычно мы не знаем, что пред ставляет собой этот признак; однако у нас будет очень мало (если вообще будут) нулей, которые могут стать причиной разреженного ввода.

zz Имеют низкую размерность. Эмбеддинги имеют предопределенную размер ность (выбранную в качестве гиперпараметра). В предыдущем примере ис пользования BoW нам потребовалось |V| входов для каждого слова, так что общий размер входных данных составил | V | * n, где n — количество слов, которые мы используем в качестве входных данных. В эмбеддингах слов размер ввода будет d * n, где d обычно составляет от 50 до 300. Учитывая тот факт, что объем больших текстовых массивов часто намного превышает 300 слов, мы значительно экономим на размере входных данных. Это, как мы видели, может привести к повышению точности при меньшем общем количестве экземпляров данных.

zz Содержат семантику области. Это свойство, вероятно, самое неожиданное, но при этом и самое полезное. При правильном обучении эмбеддинги полу чают информацию о содержании своей предметной области.

zzИх легко обобщать. Эмбеддинги способны улавливать обобщенные абстракт ные шаблоны. Например, мы можем обучать эмбеддинги на кошках, оленях,