- •Об авторе

- •Предисловие

- •Для кого эта книга

- •О чем эта книга

- •Что вам потребуется при чтении этой книги

- •Условные обозначения

- •От издательства

- •Глава 1. Обзор алгоритмов

- •Что такое алгоритм

- •Этапы алгоритма

- •Определение логики алгоритма

- •Псевдокод

- •Использование сниппетов

- •Создание плана выполнения

- •Введение в библиотеки Python

- •Библиотеки Python

- •Реализация Python с помощью Jupyter Notebook

- •Методы разработки алгоритмов

- •Параметры данных

- •Параметры вычислений

- •Анализ производительности

- •Анализ пространственной сложности

- •Анализ временной сложности

- •Оценка эффективности

- •Выбор алгоритма

- •«О-большое»

- •Проверка алгоритма

- •Точные, приближенные и рандомизированные алгоритмы

- •Объяснимость алгоритма

- •Резюме

- •Глава 2. Структуры данных, используемые в алгоритмах

- •Структуры данных в Python

- •Список

- •Кортеж

- •Словарь

- •Множество

- •DataFrame

- •Матрица

- •Абстрактные типы данных

- •Вектор

- •Стек

- •Очередь

- •Базовый принцип использования стеков и очередей

- •Дерево

- •Резюме

- •Глава 3. Алгоритмы сортировки и поиска

- •Алгоритмы сортировки

- •Обмен значений переменных в Python

- •Сортировка пузырьком

- •Сортировка вставками

- •Сортировка слиянием

- •Сортировка Шелла

- •Сортировка выбором

- •Алгоритмы поиска

- •Линейный поиск

- •Бинарный поиск

- •Интерполяционный поиск

- •Практическое применение

- •Резюме

- •Глава 4. Разработка алгоритмов

- •Знакомство с основными концепциями разработки алгоритма

- •Вопрос 1. Даст ли разработанный алгоритм ожидаемый результат?

- •Вопрос 2. Является ли данный алгоритм оптимальным способом получения результата?

- •Вопрос 3. Как алгоритм будет работать с большими наборами данных?

- •Понимание алгоритмических стратегий

- •Стратегия «разделяй и властвуй»

- •Стратегия динамического программирования

- •Жадные алгоритмы

- •Практическое применение — решение задачи коммивояжера

- •Использование стратегии полного перебора

- •Использование жадного алгоритма

- •Алгоритм PageRank

- •Постановка задачи

- •Реализация алгоритма PageRank

- •Знакомство с линейным программированием

- •Практическое применение — планирование производства с помощью линейного программирования

- •Резюме

- •Глава 5. Графовые алгоритмы

- •Представление графов

- •Типы графов

- •Особые типы ребер

- •Эгоцентрические сети

- •Анализ социальных сетей

- •Введение в теорию сетевого анализа

- •Кратчайший путь

- •Создание окрестностей

- •Показатели центральности

- •Вычисление показателей центральности с помощью Python

- •Понятие обхода графа

- •BFS — поиск в ширину

- •DFS — поиск в глубину

- •Практический пример — выявление мошенничества

- •Простой анализ мошенничества

- •Анализ мошенничества методом сторожевой башни

- •Резюме

- •Глава 6. Алгоритмы машинного обучения без учителя

- •Обучение без учителя

- •Обучение без учителя в жизненном цикле майнинга данных

- •Современные тенденции исследований в области обучения без учителя

- •Практические примеры

- •Алгоритмы кластеризации

- •Количественная оценка сходства

- •Иерархическая кластеризация

- •Оценка кластеров

- •Применение кластеризации

- •Снижение размерности

- •Метод главных компонент (PCA)

- •Ограничения PCA

- •Поиск ассоциативных правил

- •Примеры использования

- •Анализ рыночной корзины

- •Ассоциативные правила

- •Оценка качества правила

- •Алгоритмы анализа ассоциаций

- •Практический пример — объединение похожих твитов в кластеры

- •Тематическое моделирование

- •Кластеризация

- •Алгоритмы обнаружения выбросов (аномалий)

- •Использование кластеризации

- •Обнаружение аномалий на основе плотности

- •Метод опорных векторов

- •Резюме

- •Глава 7. Традиционные алгоритмы обучения с учителем

- •Машинное обучение с учителем

- •Терминология машинного обучения с учителем

- •Благоприятные условия

- •Различие между классификаторами и регрессорами

- •Алгоритмы классификации

- •Задача классификации

- •Оценка классификаторов

- •Этапы классификации

- •Алгоритм дерева решений

- •Ансамблевые методы

- •Логистическая регрессия

- •Метод опорных векторов (SVM)

- •Наивный байесовский алгоритм

- •Алгоритмы регрессии

- •Задача регрессии

- •Линейная регрессия

- •Алгоритм дерева регрессии

- •Алгоритм градиентного бустинга для регрессии

- •Среди алгоритмов регрессии победителем становится...

- •Практический пример — как предсказать погоду

- •Резюме

- •Глава 8. Алгоритмы нейронных сетей

- •Введение в ИНС

- •Эволюция ИНС

- •Обучение нейронной сети

- •Анатомия нейронной сети

- •Градиентный спуск

- •Функции активации

- •Инструменты и фреймворки

- •Keras

- •Знакомство с TensorFlow

- •Типы нейронных сетей

- •Перенос обучения

- •Практический пример — использование глубокого обучения для выявления мошенничества

- •Методология

- •Резюме

- •Глава 9. Алгоритмы обработки естественного языка

- •Знакомство с NLP

- •Терминология NLP

- •Библиотека NLTK

- •Мешок слов (BoW)

- •Эмбеддинги слов

- •Окружение слова

- •Свойства эмбеддингов слов

- •Рекуррентные нейросети в NLP

- •Использование NLP для анализа эмоциональной окраски текста

- •Практический пример — анализ тональности в отзывах на фильмы

- •Резюме

- •Глава 10. Рекомендательные системы

- •Введение в рекомендательные системы

- •Типы рекомендательных систем

- •Рекомендательные системы на основе контента

- •Рекомендательные системы на основе коллаборативной фильтрации

- •Гибридные рекомендательные системы

- •Ограничения рекомендательных систем

- •Проблема холодного старта

- •Требования к метаданным

- •Проблема разреженности данных

- •Предвзятость из-за социального влияния

- •Ограниченные данные

- •Области практического применения

- •Практический пример — создание рекомендательной системы

- •Резюме

- •Глава 11. Алгоритмы обработки данных

- •Знакомство с алгоритмами обработки данных

- •Классификация данных

- •Алгоритмы хранения данных

- •Стратегии хранения данных

- •Алгоритмы потоковой передачи данных

- •Применение потоковой передачи

- •Алгоритмы сжатия данных

- •Алгоритмы сжатия без потерь

- •Практический пример — анализ тональности твитов в режиме реального времени

- •Резюме

- •Глава 12. Криптография

- •Введение в криптографию

- •Понимание важности самого слабого звена

- •Основная терминология

- •Требования безопасности

- •Базовое устройство шифров

- •Типы криптографических методов

- •Криптографические хеш-функции

- •Симметричное шифрование

- •Асимметричное шифрование

- •Практический пример — проблемы безопасности при развертывании модели МО

- •Атака посредника (MITM)

- •Избежание маскарадинга

- •Шифрование данных и моделей

- •Резюме

- •Глава 13. Крупномасштабные алгоритмы

- •Введение в крупномасштабные алгоритмы

- •Определение эффективного крупномасштабного алгоритма

- •Терминология

- •Разработка параллельных алгоритмов

- •Закон Амдала

- •Гранулярность задачи

- •Балансировка нагрузки

- •Проблема расположения

- •Запуск параллельной обработки на Python

- •Разработка стратегии мультипроцессорной обработки

- •Введение в CUDA

- •Кластерные вычисления

- •Гибридная стратегия

- •Резюме

- •Глава 14. Практические рекомендации

- •Введение в практические рекомендации

- •Печальная история ИИ-бота в Твиттере

- •Объяснимость алгоритма

- •Алгоритмы машинного обучения и объяснимость

- •Этика и алгоритмы

- •Проблемы обучающихся алгоритмов

- •Понимание этических аспектов

- •Снижение предвзятости в моделях

- •Решение NP-трудных задач

- •Упрощение задачи

- •Адаптация известного решения аналогичной задачи

- •Вероятностный метод

- •Когда следует использовать алгоритмы

- •Практический пример — события типа «черный лебедь»

- •Резюме

242 |

Глава 8. Алгоритмы нейронных сетей |

Функции активации

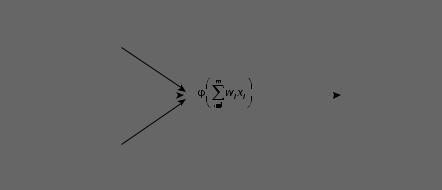

Функция активации формулирует, каким образом входные данные для конкрет ного нейрона будут обработаны для получения выходных данных.

Как показано на следующей схеме‚ каждый нейрон в нейронной сети имеет функцию активации, которая определяет то, как будут обрабатываться входные данные (рис. 8.6).

1

2

x |

|

Функция активации |

|

|||||

w |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

x |

w |

|

|

|

|

|

y |

|

|

|

|

|

|

||||

|

|

|

|

|

|

|||

|

|

|

|

|

|

|

|

|

|

. |

wm |

|

xm |

|

m |

|

Рис. 8.6

На схеме мы видим, что результаты, полученные в процессе работы функции активации‚ передаются на выход. Функция задает критерии интерпретации входных значений для генерации выходных данных.

Для одних и тех же входных значений разные функции активации будут вы давать разные результаты. При решении задач с использованием нейронных сетей важно правильно выбирать функцию активации.

Рассмотрим несколько функций активации более подробно.

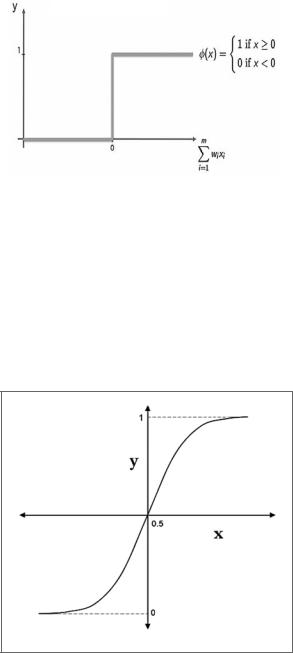

Пороговая функция

Самая простая из возможных функций активации — пороговая функция (threshold function). Выходные данные пороговой функции являются двоичными: 0 или 1. Она будет генерировать 1 в качестве выходного сигнала, если какое-либо вход ное значение больше 1. Это проиллюстрировано на следующей схеме (рис. 8.7).

Обратите внимание, что как только во взвешенных суммах входных данных обнаруживается какой-либо сигнал, выход (y) становится 1. Это делает функцию

Обучение нейронной сети |

243 |

|

|

|

|

|

|

|

Рис. 8.7

пороговой активации очень чувствительной. Она склонна к ошибочному сра батыванию при малейшем сигнале на входе из-за сбоя или какого-либо шума.

Сигмоидная функция

Сигмоидную функцию (sigmoid function) можно рассматривать как улучшенный вариант пороговой. При работе с этой функцией активации мы получаем кон троль над ее чувствительностью (рис. 8.8).

Рис. 8.8

244 |

Глава 8. Алгоритмы нейронных сетей |

Сигмоидная функция y определяется так:

Ее можно реализовать на Python следующим образом:

def sigmoidFunction(z): return 1/ (1+np.exp(-z))

Снижая чувствительность функции активации, мы делаем сбои на входе менее разрушительными. Обратите внимание, что вывод сигмоидной функции акти вации по-прежнему двоичный, то есть 0 или 1.

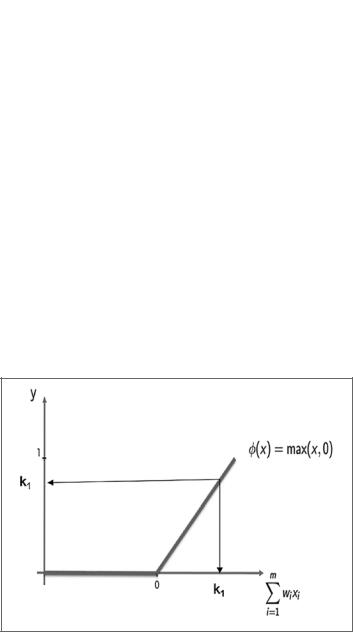

ReLU

Первые две функции активации, представленные в этой главе, преобразуют набор входных переменных в двоичные выходные данные. ReLU (rectified linear unit; блок линейной ректификации) — это функция активации, которая при нимает набор входных переменных и преобразует их в один непрерывный вывод. В нейронных сетях ReLU обычно используется в скрытых слоях, чтобы не пре образовывать непрерывные переменные в категориальные.

На следующей схеме представлен график функции активации ReLU (рис. 8.9).

Рис. 8.9

Обучение нейронной сети |

245 |

Обратите внимание, что x ≤ 0 означает, что y = 0. Таким образом‚ любой сигнал со входа, который равен или меньше нуля, преобразуется в нулевой выход:

Как только x становится больше нуля, функция равна x.

Функция ReLU является одной из наиболее часто используемых функций ак тивации в нейронных сетях. Ее можно реализовать на Python следующим об разом:

def ReLU(x): if x<0:

return 0 else:

return x

Теперь рассмотрим функцию Leaky ReLU, основанную на ReLU.

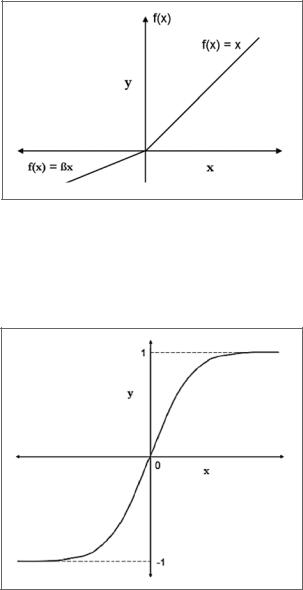

Leaky ReLU

В ReLU отрицательное значение для x приводит к нулевому значению для y. Это означает, что в процессе теряется часть информации, что удлиняет циклы обучения, особенно в начале обучения. Функция активации Leaky ReLU (ReLU с утечкой) избавляется от этой проблемы. Для Leaky ReLU применимо следу ющее:

График функции показан на следующей схеме (рис. 8.10).

Здесь β — параметр со значением меньше единицы.

Функцию можно реализовать на Python следующим образом:

def leakyReLU(x,beta=0.01): if x<0:

return (beta*x) else:

return x

Существуют три способа указать значение β:

zz Указать значение по умолчанию для β.

246 |

Глава 8. Алгоритмы нейронных сетей |

zz Сделать βпараметром в нашей нейронной сети и позволить нейронной сети определять значение (параметрическая ReLU).

zz Сделать β случайным значением (рандомизированная ReLU).

Рис. 8.10

Гиперболический тангенс (tanh)

Функция tanh аналогична сигмоидной функции, но она способна выдавать от рицательный сигнал. Это показано на следующей схеме (рис. 8.11).

Рис. 8.11