- •Об авторе

- •Предисловие

- •Для кого эта книга

- •О чем эта книга

- •Что вам потребуется при чтении этой книги

- •Условные обозначения

- •От издательства

- •Глава 1. Обзор алгоритмов

- •Что такое алгоритм

- •Этапы алгоритма

- •Определение логики алгоритма

- •Псевдокод

- •Использование сниппетов

- •Создание плана выполнения

- •Введение в библиотеки Python

- •Библиотеки Python

- •Реализация Python с помощью Jupyter Notebook

- •Методы разработки алгоритмов

- •Параметры данных

- •Параметры вычислений

- •Анализ производительности

- •Анализ пространственной сложности

- •Анализ временной сложности

- •Оценка эффективности

- •Выбор алгоритма

- •«О-большое»

- •Проверка алгоритма

- •Точные, приближенные и рандомизированные алгоритмы

- •Объяснимость алгоритма

- •Резюме

- •Глава 2. Структуры данных, используемые в алгоритмах

- •Структуры данных в Python

- •Список

- •Кортеж

- •Словарь

- •Множество

- •DataFrame

- •Матрица

- •Абстрактные типы данных

- •Вектор

- •Стек

- •Очередь

- •Базовый принцип использования стеков и очередей

- •Дерево

- •Резюме

- •Глава 3. Алгоритмы сортировки и поиска

- •Алгоритмы сортировки

- •Обмен значений переменных в Python

- •Сортировка пузырьком

- •Сортировка вставками

- •Сортировка слиянием

- •Сортировка Шелла

- •Сортировка выбором

- •Алгоритмы поиска

- •Линейный поиск

- •Бинарный поиск

- •Интерполяционный поиск

- •Практическое применение

- •Резюме

- •Глава 4. Разработка алгоритмов

- •Знакомство с основными концепциями разработки алгоритма

- •Вопрос 1. Даст ли разработанный алгоритм ожидаемый результат?

- •Вопрос 2. Является ли данный алгоритм оптимальным способом получения результата?

- •Вопрос 3. Как алгоритм будет работать с большими наборами данных?

- •Понимание алгоритмических стратегий

- •Стратегия «разделяй и властвуй»

- •Стратегия динамического программирования

- •Жадные алгоритмы

- •Практическое применение — решение задачи коммивояжера

- •Использование стратегии полного перебора

- •Использование жадного алгоритма

- •Алгоритм PageRank

- •Постановка задачи

- •Реализация алгоритма PageRank

- •Знакомство с линейным программированием

- •Практическое применение — планирование производства с помощью линейного программирования

- •Резюме

- •Глава 5. Графовые алгоритмы

- •Представление графов

- •Типы графов

- •Особые типы ребер

- •Эгоцентрические сети

- •Анализ социальных сетей

- •Введение в теорию сетевого анализа

- •Кратчайший путь

- •Создание окрестностей

- •Показатели центральности

- •Вычисление показателей центральности с помощью Python

- •Понятие обхода графа

- •BFS — поиск в ширину

- •DFS — поиск в глубину

- •Практический пример — выявление мошенничества

- •Простой анализ мошенничества

- •Анализ мошенничества методом сторожевой башни

- •Резюме

- •Глава 6. Алгоритмы машинного обучения без учителя

- •Обучение без учителя

- •Обучение без учителя в жизненном цикле майнинга данных

- •Современные тенденции исследований в области обучения без учителя

- •Практические примеры

- •Алгоритмы кластеризации

- •Количественная оценка сходства

- •Иерархическая кластеризация

- •Оценка кластеров

- •Применение кластеризации

- •Снижение размерности

- •Метод главных компонент (PCA)

- •Ограничения PCA

- •Поиск ассоциативных правил

- •Примеры использования

- •Анализ рыночной корзины

- •Ассоциативные правила

- •Оценка качества правила

- •Алгоритмы анализа ассоциаций

- •Практический пример — объединение похожих твитов в кластеры

- •Тематическое моделирование

- •Кластеризация

- •Алгоритмы обнаружения выбросов (аномалий)

- •Использование кластеризации

- •Обнаружение аномалий на основе плотности

- •Метод опорных векторов

- •Резюме

- •Глава 7. Традиционные алгоритмы обучения с учителем

- •Машинное обучение с учителем

- •Терминология машинного обучения с учителем

- •Благоприятные условия

- •Различие между классификаторами и регрессорами

- •Алгоритмы классификации

- •Задача классификации

- •Оценка классификаторов

- •Этапы классификации

- •Алгоритм дерева решений

- •Ансамблевые методы

- •Логистическая регрессия

- •Метод опорных векторов (SVM)

- •Наивный байесовский алгоритм

- •Алгоритмы регрессии

- •Задача регрессии

- •Линейная регрессия

- •Алгоритм дерева регрессии

- •Алгоритм градиентного бустинга для регрессии

- •Среди алгоритмов регрессии победителем становится...

- •Практический пример — как предсказать погоду

- •Резюме

- •Глава 8. Алгоритмы нейронных сетей

- •Введение в ИНС

- •Эволюция ИНС

- •Обучение нейронной сети

- •Анатомия нейронной сети

- •Градиентный спуск

- •Функции активации

- •Инструменты и фреймворки

- •Keras

- •Знакомство с TensorFlow

- •Типы нейронных сетей

- •Перенос обучения

- •Практический пример — использование глубокого обучения для выявления мошенничества

- •Методология

- •Резюме

- •Глава 9. Алгоритмы обработки естественного языка

- •Знакомство с NLP

- •Терминология NLP

- •Библиотека NLTK

- •Мешок слов (BoW)

- •Эмбеддинги слов

- •Окружение слова

- •Свойства эмбеддингов слов

- •Рекуррентные нейросети в NLP

- •Использование NLP для анализа эмоциональной окраски текста

- •Практический пример — анализ тональности в отзывах на фильмы

- •Резюме

- •Глава 10. Рекомендательные системы

- •Введение в рекомендательные системы

- •Типы рекомендательных систем

- •Рекомендательные системы на основе контента

- •Рекомендательные системы на основе коллаборативной фильтрации

- •Гибридные рекомендательные системы

- •Ограничения рекомендательных систем

- •Проблема холодного старта

- •Требования к метаданным

- •Проблема разреженности данных

- •Предвзятость из-за социального влияния

- •Ограниченные данные

- •Области практического применения

- •Практический пример — создание рекомендательной системы

- •Резюме

- •Глава 11. Алгоритмы обработки данных

- •Знакомство с алгоритмами обработки данных

- •Классификация данных

- •Алгоритмы хранения данных

- •Стратегии хранения данных

- •Алгоритмы потоковой передачи данных

- •Применение потоковой передачи

- •Алгоритмы сжатия данных

- •Алгоритмы сжатия без потерь

- •Практический пример — анализ тональности твитов в режиме реального времени

- •Резюме

- •Глава 12. Криптография

- •Введение в криптографию

- •Понимание важности самого слабого звена

- •Основная терминология

- •Требования безопасности

- •Базовое устройство шифров

- •Типы криптографических методов

- •Криптографические хеш-функции

- •Симметричное шифрование

- •Асимметричное шифрование

- •Практический пример — проблемы безопасности при развертывании модели МО

- •Атака посредника (MITM)

- •Избежание маскарадинга

- •Шифрование данных и моделей

- •Резюме

- •Глава 13. Крупномасштабные алгоритмы

- •Введение в крупномасштабные алгоритмы

- •Определение эффективного крупномасштабного алгоритма

- •Терминология

- •Разработка параллельных алгоритмов

- •Закон Амдала

- •Гранулярность задачи

- •Балансировка нагрузки

- •Проблема расположения

- •Запуск параллельной обработки на Python

- •Разработка стратегии мультипроцессорной обработки

- •Введение в CUDA

- •Кластерные вычисления

- •Гибридная стратегия

- •Резюме

- •Глава 14. Практические рекомендации

- •Введение в практические рекомендации

- •Печальная история ИИ-бота в Твиттере

- •Объяснимость алгоритма

- •Алгоритмы машинного обучения и объяснимость

- •Этика и алгоритмы

- •Проблемы обучающихся алгоритмов

- •Понимание этических аспектов

- •Снижение предвзятости в моделях

- •Решение NP-трудных задач

- •Упрощение задачи

- •Адаптация известного решения аналогичной задачи

- •Вероятностный метод

- •Когда следует использовать алгоритмы

- •Практический пример — события типа «черный лебедь»

- •Резюме

42 |

Глава 1. Обзор алгоритмов |

сортировку списка за пару секунд. Таким образом, в случае большого объема входных данных имеет смысл приложить усилия: выполнить анализ произво дительности и выбрать алгоритм, который будет эффективно решать требуе мую задачу.

«О-большое»

«О-большое» используется для количественной оценки производительности алгоритмов по мере увеличения размера входных данных. Это одна из самых популярных методик, используемых для проведения анализа наихудшего сце нария. В этом разделе мы обсудим различные типы «О-большого».

Константная временная сложность (O(1))

Если выполнение алгоритма занимает одинаковое количество времени не зависимо от размера входных данных, то про него говорят, что он выполня ется постоянное время. Такая сложность обозначается как O(1). В качестве примера рассмотрим доступ к n-му элементу массива. Независимо от раз мера массива для получения результата потребуется одно и то же время. Например, следующая функция вернет первый элемент массива (ее сложность O(1)):

def getFirst(myList): return myList[0]

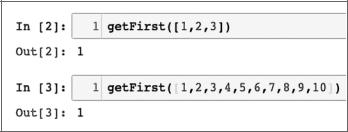

Выходные данные показаны ниже (рис. 1.7):

Рис. 1.7

zz Добавление нового элемента в стек с помощью push или удаление элемента из стека с помощью pop. Независимо от размера стека добавление или уда ление элемента займет одно и то же время.

Анализ производительности |

43 |

zz Доступ к элементу хеш-таблицы.

zzБлочная (иначе называемая корзинная или карманная) сортировка (Bucket sort).

Линейная временная сложность (O(n))

Считается, что алгоритм имеет линейную временную сложность, обознача емую O(n), если время выполнения прямо пропорционально размеру входных данных. Простой пример — добавление элементов в одномерную структуру данных:

def getSum(myList): sum = 0

for item in myList: sum = sum + item

return sum

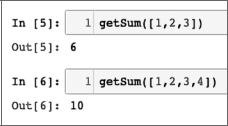

Взгляните на основной цикл алгоритма. Число итераций в основном цикле линейно увеличивается с увеличением значения n, что приводит к сложности O(n) на рис. 1.8.

Рис. 1.8

Ниже приведены некоторые другие примеры операций с массивами:

zz Поиск элемента.

zz Нахождение минимального значения среди всех элементов массива.

Квадратичная временная сложность (O(n2))

Считается, что алгоритм выполняется за квадратичное время, если время вы полнения алгоритма пропорционально квадрату размера входных данных. На пример, простая функция, которая суммирует двумерный массив, выглядит следующим образом:

44 |

|

Глава 1. Обзор алгоритмов |

def getSum(myList): |

|

|

sum = 0 |

|

|

for row |

in myList: |

|

for |

item in |

row: |

sum += item return sum

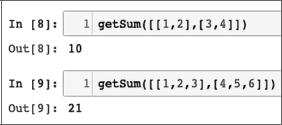

Обратите внимание на вложенный цикл внутри основного цикла. Этот вложен ный цикл и придает коду сложность O(n2) (рис. 1.9).

Рис. 1.9

Другим примером квадратичной временной сложности является алгоритм сор тировки пузырьком (представленный в главе 3).

Логарифмическая временная сложность (O(logn))

Считается, что алгоритм выполняется за логарифмическое время, если время выполнения алгоритма пропорционально логарифму размера входных данных. С каждой итерацией размер входных данных уменьшается в несколько раз. Примером логарифмической временной сложности является бинарный поиск. Алгоритм бинарного поиска используется для поиска определенного элемента в одномерной структуре данных, такой как список в Python. Элементы в струк туре данных должны быть отсортированы в порядке убывания. Алгоритм би нарного поиска реализован в функции с именем searchBinary следующим об разом:

def searchBinary(myList,item): first = 0

last = len(myList)-1 foundFlag = False

while( first<=last and not foundFlag): mid = (first + last)//2

Анализ производительности |

45 |

if myList[mid] == item : foundFlag = True

else:

if item < myList[mid]: last = mid - 1

else:

first = mid + 1 return foundFlag

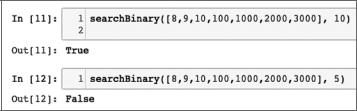

Работа основного цикла подразумевает тот факт, что список упорядочен. На каждой итерации список делится пополам, пока не будет получен результат (рис. 1.10):

Рис. 1.10

Определив функцию, мы переходим к поиску определенного элемента в стро ках 11 и 12. Алгоритм бинарного поиска более подробно обсуждается в гла ве 3.

Обратите внимание, что среди четырех последних представленных типов вре менной сложности O(n2) имеет худшую производительность, а O(logn) — луч шую. Фактически производительность O(logn) можно рассматривать как золо той стандарт производительности любого алгоритма (что, однако, не всегда достижимо). С другой стороны, O(n2) не так плох, как O(n3), но все же алгорит мы этого типа нельзя использовать для больших данных, поскольку временная сложность ограничивает объем данных, которые они способны обработать за разумное количество времени.

Чтобы понизить сложность алгоритма, мы можем пожертвовать точностью и использовать приближенный алгоритм.

Весь процесс оценки производительности алгоритмов носит итерационный характер, как показано на рис. 1.11.