- •Методические указания

- •Для подготовки к Госэкзамену

- •Тема Кодирование информации

- •Помехозащищенные коды.

- •Экономичные коды.

- •Вероятность ошибочного приема кода

- •Примеры решения задач

- •Тема Преобразование информации Первичные преобразователи

- •Квантование сигналов

- •Примеры решения задач

- •Тема Передача информации по каналам связи. Физический уровень.

- •Логический уровень.

- •Конкретные типы дискретных каналов.

- •Примеры решения задач

- •Тема Конечные автоматы

- •Примеры решения задач

- •Тема Дискретные цепи Маркова

- •Примеры решения задач

- •Тема Системы массового обслуживания Одноканальная смо с очередью

- •Многоканальная смо без очереди

- •Многоканальная смо с очередью.

- •Примеры решения задач

- •Тема Моделирование случайных факторов Моделирование непрерывных случайных величин

- •Моделирование потоков событий

- •Примеры решения задач

Логический уровень.

Модели дискретных каналов передачи.

Н а

логическом уровне может быть построена

модель дискретного канала, которая

отражает процесс передачи элементов

кода по этому каналу. В общем случае

дискретный канал имеет на входе множество

символов кодаХс энтропией источникаН(Х), а на выходе множество символовY с энтропиейH(Y).

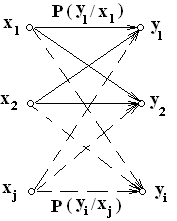

Модель такого канала можно изобразить

в виде графа, в узлах которого расположены

символы кода, а дуги отображают вероятности

перехода из одного символа в другой.

Количество символов конечно и определяется

основанием системы счисления кода на

входе канала. Вероятности переходов

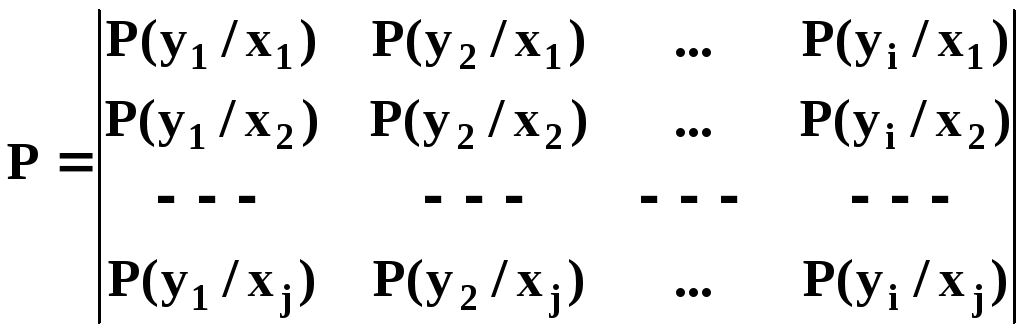

могут быть записаны в виде матрицы.

Элемент матрицыP(yi/xj)определяет появление на выходе символаyiпри подаче на вход символаxj.

а

логическом уровне может быть построена

модель дискретного канала, которая

отражает процесс передачи элементов

кода по этому каналу. В общем случае

дискретный канал имеет на входе множество

символов кодаХс энтропией источникаН(Х), а на выходе множество символовY с энтропиейH(Y).

Модель такого канала можно изобразить

в виде графа, в узлах которого расположены

символы кода, а дуги отображают вероятности

перехода из одного символа в другой.

Количество символов конечно и определяется

основанием системы счисления кода на

входе канала. Вероятности переходов

могут быть записаны в виде матрицы.

Элемент матрицыP(yi/xj)определяет появление на выходе символаyiпри подаче на вход символаxj.

Вероятности, связывающие символы с одинаковыми индексами, называются вероятностями прохождения, остальные –вероятности трансформации.

Для определенных соотношений между вероятностями, входящими в данную матрицу можно выделить симметричныеканалы, у которых элементы, входящие в строки и столбцы, являются перестановками одних и тех же чисел.

По основанию системы счисления кода на входе канала различают двоичные, десятичные и другие каналы.

Пропускная способность канала на логическом уровне определяется количеством бит на один символ (знак) и не связана со временем. Количество информации, передаваемое одним символом, составит

Imax= Hmax(Y) – Hmin(Y/X).

Если n– количество символов на входе канала,m– количество символов на выходе канала, слагаемые можно подсчитать так.

Максимальная энтропия выходного сигнала:

![]() , где

, где![]()

Энтропия шумов:

![]()

Конкретные типы дискретных каналов.

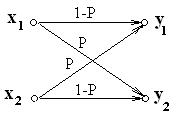

Двоичный симметричный канал с шумом.

При наличии шума (помех) в канале передачи входной символ xjпереходит в символyiс вероятностьюP(yi/xj). Обозначим вероятность искажения символаР

Вероятность его прохождения будет равна P(yi/xj)приi = j, что для двоичного канала составит1 – Р.

Граф симметричного двоичного канала, и матрица вероятностей будут иметь вид.

![]()

Количество информации, передаваемое одним символом по такому каналу, составит при равновероятных входных символах Imax= 1 – Hmin(Y/X), т.к. выше было показано, что в этом случаеHmax(Y) = 1.

Находим условную энтропию:

H(Y/X) = -(1-P)log2(1-P)-Plog2P

Следовательно:

I = 1 + (1-P)log2(1-P) + Plog2P

Если P(x1) P(x2),тоHmax(Y) вычисляется по общей формуле

![]()

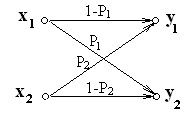

Несимметричный двоичный канал с шумом

Здесь вероятность искажения символа x1равнаР1, а вероятность искажения символаx2равнаР2.

Граф несимметричного двоичного канала, и матрица вероятностей будут иметь вид.

![]()

Количество информации, передаваемое символом по каналу:

I = H (Y) – H (Y/X)

При этом максимальная энтропия в выходных сигналах рассчитывается по формуле полной энтропии: H(Y) = -Р(у1)log2Р(у1) - Р(у2)log2Р(у2)

Энтропия шумов вычисляется по формуле условной энтропии:

H(Y/Х) = -Р(х1)[Р(у1/х1)log2Р(у1/х1)+Р(у2/х1)log2Р(у2/х1)] -

- Р(х2)[Р(у1/х2)log2Р(у1/х2) + Р(у2/х2)log2Р(у2/х2)]

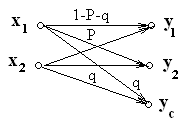

Двоичный канал передачи со стиранием.

Для уменьшения вероятности трансформации символов в каналах с помехами (шумами), используют каналы со стиранием. В таких каналах в приемном устройстве существует специальная зона стирания, при попадании в которую формируется символ стирания. Не следует думать, что при попадании в зону стирания входной символ пропадает совсем. В данном случае вместо трансформированного (ошибочного) символа вырабатывается новый символ – символ неопределенности. Во многих случаях это позволяет легче исправить искажения информации. На выходе двоичного канала со стиранием будут присутствовать уже не два, а три символа.

О бозначим

вероятность стирания символаq,

и рассмотрим граф канала со стиранием

и соответствующую матрицу вероятностей.

бозначим

вероятность стирания символаq,

и рассмотрим граф канала со стиранием

и соответствующую матрицу вероятностей.

![]()

Найдем количество информации, передаваемое одним символом по такому каналу. При наличии символов стирания понятие равновероятности символов на выходе канала не имеет смысла, поэтому энтропия на выходе канала определится так:

![]()

где P(yi)– вероятность возникновения на выходе канала символаyi.

Для равновероятных символов на входе канала и одинаковой вероятности их искажения Римеют место следующие соотношения.

Р(х1) = Р(х2) = 1/2

Р(у1) = Р(х1)Р(у1/х1) + Р(х2)Р(у1/х2) = (1-Р-q)/2 + Р/2 = (1-q)/2

Р(у2) = Р(у1)

Р(уС) = Р(х1)Р(уС/х1) + Р(х2)Р(уС/х2) = q/2 + q/2 = q

Отсюда

H(Y) = (1-q)[1-log2(1-q)]-qlog2q

Соответственно условная энтропия в общем виде:

![]()

Или для рассматриваемого канала:

H(Y/Х) = -(1-Р-q)log2(1-P-q) + Рlog2Р + qlog2q

Отсюда количество информации, передаваемое одним символом по каналу со стиранием при равновероятных входных сигналах и одинаковой вероятности их искажения:

I = (1-q)[1-log2(1-q)] + (1-Р-q)log2(1-P-q) + Рlog2Р