- •Перечень билетов с вопросами, выносимых на экзамен

- •3. Спектральная факторизация. Связь параметров ар-модели с фильтрами линейного предсказания. Алгоритм Левинсона. Коэффициенты отражения.

- •4Свойства спектральной плотности мощности авторегрессионного процесса. Спектральное оценивание на основе метода максимальной энтропии. Автокорреляционное обобщение ар-оценки.

- •5. Ар-оценивание параметров. Групповая оценка ар-параметров. Геометрический алгоритм. Гармонический алгоритм (Берга).

- •15. Базисные функции частотно-временного анализа

- •Непрерывное вейвлет-преобразование

5. Ар-оценивание параметров. Групповая оценка ар-параметров. Геометрический алгоритм. Гармонический алгоритм (Берга).

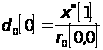

Геометрический алгоритм.

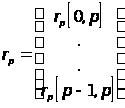

Ошибки линейного предсказания вперед и назад определяются соответственно следующими выражениями:

![]()

![]()

Рекурсивные выражения, связывающие

ошибки линейного предсказания моделей

порядков p и p-1, определяются

простой подстановкой ![]() и

и![]() в

рекурсивное соотношение для

авторегрессионных параметров:

в

рекурсивное соотношение для

авторегрессионных параметров:

![]()

![]()

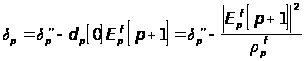

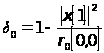

Несложно показать, что коэффициент отражения обладает следующим свойством (является коэффициентом частной корреляции между ошибками линейного предсказания вперед и назад) :

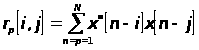

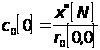

Используя оценки взаимной корреляции и автокорреляции ошибок предсказания вперед и назад, получим :

Таким образом, геометрический алгоритм

использует алгоритм Левинсона, в котором

вместо обычного коэффициента отражения,

вычисляемого по известной автокорреляционной

функции, используется его оценка ![]()

Окончательный вид выражений геометрического алгоритма :

![]() , где n=1,2,..p-1

, где n=1,2,..p-1

![]()

![]() ,

,![]()

![]() , где

, где![]()

Гармонический алгоритм Берга.

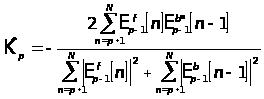

Алгоритм Берга идентичен геометрическому, однако оценка коэффициента отражения находится из других соображений, а именно : при каждом значений параметра p в нем минимизируется арифметическое среднее мощности ошибок линейного предсказания вперед и назад (то есть выборочная дисперсия ошибки предсказания):

Приравнивая производные к нулю, имеем

оценку для ![]() :

:

Некоторым обобщением является взвешивание среднего квадрата ошибки предсказания для уменьшения частотного смещения, наблюдаемого при использовании базового метода Берга:

что приводит к следующей оценке :

Оценивание линейного предсказания по методу наименьших квадратов.

Налагая ограничения на авторегрессионные

параметры, с тем чтобы они удовлетворяли

рекурсивному выражению метода Левинсона,

в методе Берга происходит минимизация

по одного параметра - коэффициента

отражения ![]() .

Более общий подход состоит в минимизации

одновременно по всем коэффициентам

линейного предсказания.

.

Более общий подход состоит в минимизации

одновременно по всем коэффициентам

линейного предсказания.

Итак, пусть для оценивания авторегрессионных

параметров порядка p используются

последовательность данных ![]() .Оценка

линейного предсказания вперед

порядка p для отсчета

.Оценка

линейного предсказания вперед

порядка p для отсчета![]() будет

иметь форму:

будет

иметь форму:

![]()

где ![]() -

коэффициенты линейного предсказания

вперед порядка p.

-

коэффициенты линейного предсказания

вперед порядка p.

Ошибка линейного предсказания :

![]()

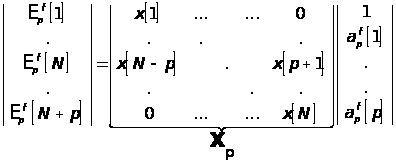

В матричном виде это выражение записывается как :

и соотношение для ошибки :

Однако если рассматривать, в котором минимизируется следующая, невзвешенная выборочная дисперсия :

то матрица ![]() принимает

теплицевый вид (далее ее будем

обозначать

принимает

теплицевый вид (далее ее будем

обозначать![]() ).

).

Нормальные уравнения, минимизирующие средний квадрат ошибки имеют следующий вид:

Элементы эрмитовой матрицы ![]() имеют

вид корреляционных форм

имеют

вид корреляционных форм

, где

, где![]()

Таким образом, авторегрессионные

параметры могут быть получены в результате

решения нормальных уравнений. Рассмотрим

алгоритм, который в решении нормальных

уравнений учитывает тот факт, что

эрмитова матрица ![]() получена

как произведение двух теплицевых и в

результате этого сводит количество

вычислений к

получена

как произведение двух теплицевых и в

результате этого сводит количество

вычислений к![]() .

При использовании алгоритма Холецкого потребовалось

бы

.

При использовании алгоритма Холецкого потребовалось

бы![]() операций.

операций.

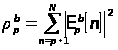

Ошибки линейного предсказания вперед и назад p-ого порядка

![]()

![]()

Здесь вектор данных ![]() ,

вектор коэффициентов линейного

предсказания вперед

,

вектор коэффициентов линейного

предсказания вперед![]() и

вектор линейного предсказания

назад

и

вектор линейного предсказания

назад![]() определяется

следующими выражениями:

определяется

следующими выражениями:

,

, ,

,

На основе отсчетов измеренных комплексных

данных ![]() ковариационный метод

линейного предсказания

позволяет раздельно минимизировать

суммы квадратов ошибок линейного

предсказания вперед и назад:

ковариационный метод

линейного предсказания

позволяет раздельно минимизировать

суммы квадратов ошибок линейного

предсказания вперед и назад:

,

,

что приводит к следующим нормальным уравнениям :

,

,

Введем необходимые для дальнейшего определения :

,

,

исходя из вида ![]() и

и![]() можно

записать :

можно

записать :

,

, ,

,

где вектор столбцы ![]() и

и![]() даются

выражениями :

даются

выражениями :

,

,

Важными также являются следующие выражения :

![]()

![]()

Пара векторов-столбцов ![]() и

и![]() определяются

из выражений :

определяются

из выражений :

![]()

![]()

Аналогично определяются вектора ![]() и

и![]() ,

а также

,

а также![]() и

и![]() через

матрицы

через

матрицы![]() и

и![]() .

.

Процедура, используемая для обновления порядка вектора линейного предсказания вперед выглядит следующим образом :

, где

, где , в

котором

, в

котором

![]()

![]()

Соответствующий вид имеет процедура обновления порядка для вектора предсказания назад:

, где

, где ,

,

![]()

Векторы ![]() и

и![]() должны

удовлетворять следующим рекурсиям

обновления порядка:

должны

удовлетворять следующим рекурсиям

обновления порядка:

Используя тот факт, что ![]() является

эрмитовой матрицей имеем следующие

выражения для

является

эрмитовой матрицей имеем следующие

выражения для![]() и

и![]() :

:

Введем скалярные множители

![]()

![]()

Соответствующие рекуррентные выражения

для ![]() и

и![]() имеют

следующий вид :

имеют

следующий вид :

Наконец, еще одна рекурсия обновления

порядка необходима для вектора ![]() :

:

Обновление временного индекса в векторе коэффициентов линейного предсказания вперед осуществляется в соответствии с выражением :

Выражение для обновления временного индекса у квадрата ошибки линейного предсказания вперед :

Аналогичным образом обновление временного индекса в векторе коэффициентов линейного предсказания назад ведется в соответствии с выражением :

Выражение для обновления временного индекса у квадрата ошибки линейного предсказания назад :

,

,

где комплексный скаляр ![]() удовлетворяет

выражениям :

удовлетворяет

выражениям :

![]()

Соответствующие рекурсии по временному

индексу для действительных

скаляров ![]() и

и![]() даются

следующими выражениями:

даются

следующими выражениями:

,

,

Начальные условия необходимы для того, чтобы начать рекурсивное решение с порядка равного нулю:

![]() ,

,![]() ,

,![]() ,

,

,

, ,

,

,

,

Экспериментальные результаты приведены в соответствующем разделе.

9. Методы оценивания частоты, основанные на анализе собственных значений. Метод MUSIC

Ключевой операцией в методах, основанных на анализе собственных значений, является разделение информации, содержащейся в автокорреляционной матрице или матрице данных, на два векторных подпространства - подпространство сигнала и подпространство шума. В этих подпространствах можно определять различные функции от векторов сигнала и шума для получения оценок частоты. Однако эти оценки не сохраняют мощность анализируемого процесса и, следовательно, не являются оценками истинной СПМ. Далее будет рассмотрен метод классификации множественных сигналов.

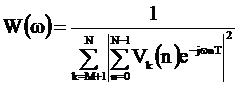

Основная формула практически всех методов оценивания частоты, основанных на анализе собственных значений имеет следующий вид:

![]() ,

здесь

,

здесь

![]() -

собственные значения автокорреляционной

матрицы, упорядоченные по степени их

убывания; главные собственные вектора

-

собственные значения автокорреляционной

матрицы, упорядоченные по степени их

убывания; главные собственные вектора![]() (

(![]() ),

соответствующие собственным значениям

),

соответствующие собственным значениям![]() .На

собственные векторы

.На

собственные векторы![]() натянуто подпространство шума матрицы

натянуто подпространство шума матрицы![]() и

всем им соответствует одно и то же

собственное значение

и

всем им соответствует одно и то же

собственное значение![]() .

На главные собственные векторы

.

На главные собственные векторы![]() натянуто

подпространство сигнала матрицы

натянуто

подпространство сигнала матрицы![]() .

.

Разложение автокорреляционной матрицы

на собственные значения можно двумя

способами использовать для получения

спектральных оценок или, точнее говоря,

улучшенных процедур оценок частоты.

Сохранение одной лишь информации,

соответствующей собственным векторам

пространства сигнала, то есть формирование

для матриц

![]() аппроксимации

пониженного порядка, эффективно

способствует увеличению отношения

сигнал/шум, поскольку устраняет вклад

мощности компонент подпространства

шума. Этот факт лежит в основе процедур

оценок частоты главных компонент

(подпространства сигнала). Свойство

инвариантных прямых подпространств

(подпространств шума и сигнала) положено

в основу процедур оценок частоты в

подпространстве шума.

аппроксимации

пониженного порядка, эффективно

способствует увеличению отношения

сигнал/шум, поскольку устраняет вклад

мощности компонент подпространства

шума. Этот факт лежит в основе процедур

оценок частоты главных компонент

(подпространства сигнала). Свойство

инвариантных прямых подпространств

(подпространств шума и сигнала) положено

в основу процедур оценок частоты в

подпространстве шума.

Метод MUSIC

Метод

MUSIC (MUltiple SIgnal Classification) предназначен для

спектрального анализа сигналов,

представляющих собой сумму нескольких

синусоид (в общем случае – нескольких

комплексных экспонент) с белым шумом.

Целью спектрального анализа подобных

сигналов, как правило, является не расчёт

спектра как такового, а определение

частот и уровней (амплитуд и мощностей)

гармонических составляющих. Метод MUSIC

предназначен именно для этого, поэтому

получаемая с его помощью зависимости

уровня сигнала от частоты называется

псевдоспектром (pseudo spectrum).

В основе

метода лежит анализ собственных чисел

и собственных вектором корреляционной

матрицы сигнала. Мы рассмотрим основные

идеи.

Итак, пусть сигнал представляет

собой сумму M комплексных экспонент,

начальные фазы которых случайны, с белым

шумом:

.

.![]() –

отсчёты белого шума;

–

отсчёты белого шума;![]() –

амплитуда, частоты и начальные фазы

комплексной экспоненты, содержащейся

в сигнале, Т – период дискретизации.

–

амплитуда, частоты и начальные фазы

комплексной экспоненты, содержащейся

в сигнале, Т – период дискретизации.![]() –

равномерно распределены в

интервале

–

равномерно распределены в

интервале![]() .

Корреляционная

функция такого сигнала будет иметь

вид:

.

Корреляционная

функция такого сигнала будет иметь

вид: .

единичная

ими функция

.

единичная

ими функция

![]() –

дисперсия шума

–

дисперсия шума![]() .

Далее

из отсчётов корреляционной функции

формируется корреляционной матрицы

размера

.

Далее

из отсчётов корреляционной функции

формируется корреляционной матрицы

размера![]() ,

причём размер матрицы должен превышать

число комплексных экспонент

,

причём размер матрицы должен превышать

число комплексных экспонент![]() .

Анализируя

собственные числа и собственные вектора

такой корреляционной матрицы, можно

показать, что наименьшее собственное

число равно

.

Анализируя

собственные числа и собственные вектора

такой корреляционной матрицы, можно

показать, что наименьшее собственное

число равно![]() ,

и оно имеет кратность

,

и оно имеет кратность![]()

![]() ,

а остальные M собственных чисел

превышают

,

а остальные M собственных чисел

превышают![]() ,

а их конкретные значения зависят от

амплитуд и частот комплексных

экспонент.

Собственные

векторы, соответствующие M наибольшим

собственным числам представляют собой

линейные комбинации комплексных

экспонент, содержащихся в сигнале.

Множество всех таких линейных комбинаций

называется сигнальным подпространством

(signal subspace), а упомянутые векторы образуют

базис в этом подпространстве.

Оставшиеся

,

а их конкретные значения зависят от

амплитуд и частот комплексных

экспонент.

Собственные

векторы, соответствующие M наибольшим

собственным числам представляют собой

линейные комбинации комплексных

экспонент, содержащихся в сигнале.

Множество всех таких линейных комбинаций

называется сигнальным подпространством

(signal subspace), а упомянутые векторы образуют

базис в этом подпространстве.

Оставшиеся![]() собственных

векторов ортогональны всем комплексным

экспонентам, содержащимся в сигнале.

Эти векторы образуют базис шумового

подпространства (noise subspace).

Спектр

комплексной экспоненты, рассчитанный

аналитически, представляет собой

дельта-функцию, расположена на собственной

частоте. Чтобы получить бесконечные

выбросы на частотах

собственных

векторов ортогональны всем комплексным

экспонентам, содержащимся в сигнале.

Эти векторы образуют базис шумового

подпространства (noise subspace).

Спектр

комплексной экспоненты, рассчитанный

аналитически, представляет собой

дельта-функцию, расположена на собственной

частоте. Чтобы получить бесконечные

выбросы на частотах![]() ,

псевдоспектр по методу MUSIC рассчитывается

следующим образом:

,

псевдоспектр по методу MUSIC рассчитывается

следующим образом: .

Здесь

.

Здесь![]() –

n-ый элемент k-ого собственного вектора

корреляционной матрицы. Векторы

пронумерованы по убыванию соответствующих

им собственных чисел.

Таким образом,

внешняя сумма по k от

–

n-ый элемент k-ого собственного вектора

корреляционной матрицы. Векторы

пронумерованы по убыванию соответствующих

им собственных чисел.

Таким образом,

внешняя сумма по k от![]() до

N задаёт участие в вычислениях

только шумовых собственных

векторов. Внутренняя сумма представляет

собой вычисления спектра собственного

вектора на частоте

до

N задаёт участие в вычислениях

только шумовых собственных

векторов. Внутренняя сумма представляет

собой вычисления спектра собственного

вектора на частоте![]() .

Шумовые собственные векторы ортогональны

всем комплексным экспонентам с

частотами

.

Шумовые собственные векторы ортогональны

всем комплексным экспонентам с

частотами![]() ,

содержащимся в сигнале. Поэтому при

,

содержащимся в сигнале. Поэтому при![]() все

внутренние суммы стремятся к нулю,

т.е.

все

внутренние суммы стремятся к нулю,

т.е.![]() .

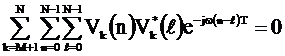

Сами частоты можно получить, приравняв

к нулю знаменатель:

.

Сами частоты можно получить, приравняв

к нулю знаменатель: .

Раскроем

квадрат модуля:

.

Раскроем

квадрат модуля: .

Теперь

видно, что левая часть полученного

выражения в конечном счёте представляет

собой полином относительно

.

Теперь

видно, что левая часть полученного

выражения в конечном счёте представляет

собой полином относительно![]() степени

степени![]() .

Те корни этого полинома, которые лежат

на единичной окружности, равны

.

Те корни этого полинома, которые лежат

на единичной окружности, равны![]() и

для расчёта их частот остаётся вычислить

аргументы этих комплексных чисел и

разделить их на T.

Всё сказанное

относится к идеализированной модели

сигнала и аналитически полученной

корреляционной функции. В реальных

ситуациях, когда сигнал не вполне

соответствует модели ( ), а его корреляционная

матрица оценивается по результатам

наблюдений (к тому же зачастую без

возможности усреднения по нескольким

наблюдениям), результаты оказываются

несколько иными: пики в ( ) имеют конечную

высоту, а корни полинома не строго лежат

на единичной окружности. Однако, если

сигнал близок к модели, метод MUSIC даёт

хорошие результаты.

и

для расчёта их частот остаётся вычислить

аргументы этих комплексных чисел и

разделить их на T.

Всё сказанное

относится к идеализированной модели

сигнала и аналитически полученной

корреляционной функции. В реальных

ситуациях, когда сигнал не вполне

соответствует модели ( ), а его корреляционная

матрица оценивается по результатам

наблюдений (к тому же зачастую без

возможности усреднения по нескольким

наблюдениям), результаты оказываются

несколько иными: пики в ( ) имеют конечную

высоту, а корни полинома не строго лежат

на единичной окружности. Однако, если

сигнал близок к модели, метод MUSIC даёт

хорошие результаты.

Метод гармонического разложения Писаренко.