3110

.pdf

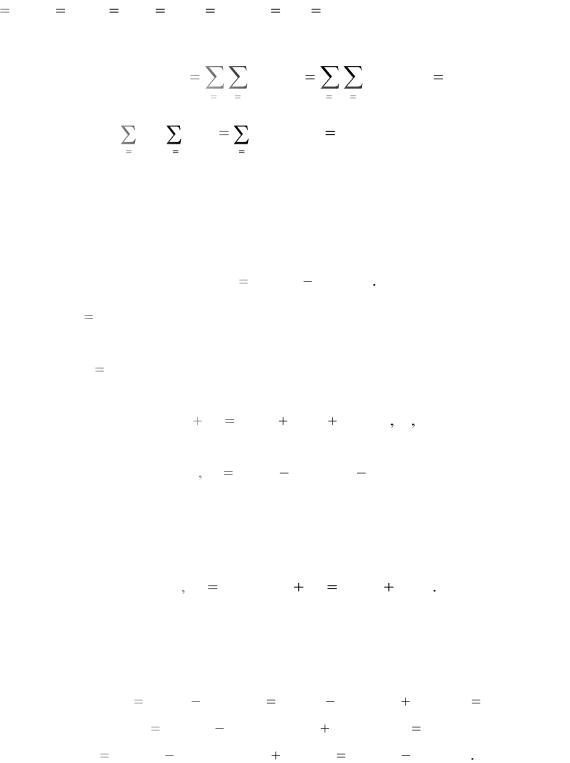

M ( X ) |

xk pk |

x1 p1 x2 p2 ... |

xk pk ... |

(7.1) |

|

k |

|

|

|

Если число значений |

СВ X |

конечно, то M (X ) |

в (7.1) задается конечной |

|

суммой. Если число значений бесконечно, то M (X ) в (7.1) есть сумма ряда. Если X – непрерывная и дифференцируемая случайная величина, а f X (s)

– плотность ее распределения, то математическое ожидание случайной величины находится по формуле

M ( X ) |

sfX (s) ds |

(7.2) |

Если все значения непрерывной случайной величины принадлежат отрез- |

||

ку [a b] , то f X (s) 0, s [a,b] и формулу можно записать так: |

|

|

|

b |

|

M ( X ) |

sf X (s) ds |

|

|

a |

|

Математическое ожидание еще называют средним значением случайной величины. Правильность такой терминологии подтверждает следующее рассуждение.

Пусть проведено N опытов, в каждом из которых возникает некоторое значение СВ X . Например, с помощью определенной процедуры измеряется влажность семян, поступивших на элеватор, для чего в различных местах делаются пробы. Ясно, что результаты опытов будут отличаться друг от друга, а значение влажности зерна есть случайная величина, распределенная (от зерна к зерну) по некоторому закону. Естественно, что в качестве величины влажности всей массы зерна разумнее всего принять среднее арифметическое значений влажности, полученных из опыта. Эту величину называют выборочным средним и обозначают X B . Причем, если опыты проводились в разных случайно взятых местах, то чем больше опытов проведено, тем точнее выборочная средняя будет приближать истинное значение средней влажности зерна в элеваторе.

Значение, возникающее в первом опыте, |

обозначим X1 , во втором – |

X 2 и т.д., |

||

значение в последнем опыте обозначим |

X N . Набор значений {X1 X 2 |

X N } |

на- |

|

зывается (случайной) выборкой значений случайной величины X , а число |

N |

|||

называется объемом выборки. |

|

|

|

|

Предположим для простоты, что X |

есть дискретная случайная величина |

|||

и пусть |

x1 x2 xn – все ее возможные значения, причем N намного больше, |

|||

чем n . |

Тогда перечисленные значения будут неизбежно повторяться в прово- |

|||

31

димых опытах. Обозначим через mi |

количество повторений xi в N опытах, |

|||

i 1 2 n . Тогда в силу свойства устойчивости частоты |

||||

p P(X |

x ) lim |

mi |

. |

|

|

||||

i |

i |

N |

N |

|

|

|

|||

|

|

|

|

|

Отсюда получаем, что среднее арифметическое значений СВ X , полученных в N опытах (выборочное среднее) при N , стремящемся к бесконечности, приближается к математическому ожиданию СВ X . Действительно,

|

|

|

|

|

|

X1 X2 |

|

X N |

|

m1 x1 |

m2 x2 |

mn xn |

|||

|

|

X B |

|||||||||||||

|

|

|

|

N |

|

|

N |

|

|

||||||

|

|

|

|

|

|

|

|

|

|

|

|

||||

x1 |

m1 |

x2 |

m2 |

xn |

mn |

x1 p1 |

x2 p2 |

xn pn M (X ) |

|||||||

N |

|

N |

|

N |

|

||||||||||

Подчеркнем, что M (X ) есть постоянная (не случайная) величина, вокруг |

|||||||||||||||

которой колеблются значения СВ X . При этом, |

если эти колебания незначи- |

||||||||||||||

тельны (СВ X почти не случайна), как, например, напряжение в электросети, то M (X ) есть наилучшая константа, которой можно на практике заменить случайную величину.

Но как измерить величину случайности (непостоянства) величины X ? Для этой цели как раз и служат дисперсия D( X ) и среднее квадратическое отклонение ( X ) .

По определению дисперсия СВ X равна математическому ожиданию неотрицательной СВ ( X M ( X ))2 , то есть математическому ожиданию квадрата отклонения СВ от ее среднего значения M (X ) :

D(X ) M ((X M (X ))2 ) |

(7.3) |

Среднеквадратическое отклонение равно, по определению, корню квадратному из дисперсии:

( X )

D( X )

D( X )

Как правило, среднее квадратическое отклонение более наглядно, чем дисперсия выражает степень разброса случайной величины вокруг ее математического ожидания. Дело в том, что если X – это, например, расстояние в метрах, то D( X ) имеет размерность квадратных метров (что неудобно), а среднее квадратическое отклонение выражает разброс снова в метрах.

32

Если СВ X дискретна и имеет закон распределения, заданный табл. 6.1,

то СВ ( X M ( X ))2 |

тоже дискретна и имеет следующий закон распределения |

||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

Таблица 7.1 |

||

|

|

|

|

|

|

|

|

|

|

|

|||||

|

( X M ( X ))2 |

|

(x M ( X ))2 |

(x |

2 |

M ( X ))2 |

… |

(x M ( X ))2 |

… |

|

|||||

|

|

|

|

1 |

|

|

|

|

|

|

k |

|

|

|

|

|

pi |

|

|

p1 |

|

p2 |

|

|

|

… |

pk |

|

… |

|

|

|

Отсюда по формуле (7.1) получаем, что дисперсия дискретной случайной |

||||||||||||||

величины X равна |

|

|

|

|

|

|

|

|

|

|

|

||||

|

D(X ) |

(x M (X ))2 |

p (x M (X ))2 |

p (x M (X ))2 |

p |

||||||||||

|

|

|

i |

i |

1 |

|

|

|

1 |

2 |

|

2 |

|

|

|

|

|

i |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Аналогично по формуле (7.2) дисперсия непрерывной и дифференцируе- |

||||||||||||||

мой случайной величины X с функцией плотности f X (s) равна |

|

|

|

||||||||||||

|

|

|

|

D( X ) |

(s M ( X ))2 f |

X |

(s) ds |

|

|

|

|||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

7.2. Свойства математического ожидания и дисперсии

Определение 7.1. Будем говорить, что случайные величины независимы, если вероятность появления значений одной из них не зависит от того, какие значения приняли другие случайные величины.

Например, если два спортсмена одновременно стреляют по мишени, то количество очков, выбитых одним, не зависит от того, сколько очков выбил другой.

Наоборот, рост и вес случайно взятого человека есть зависимые случайные величины.

Суммой Х+Y случайных величин Х и Y называется случайная величина, значения которой равны сумме наблюдаемых значений величин Х и Y.

Произведением XY случайных величин Х и Y называется случайная величина, значения которой равны произведению наблюдаемых значений

величин Х и Y.

Пусть X Y Z – случайные величины и C – константа (неслучайная величина).

Теорема 7.1. Для математического ожидания справедливы следующие правила (свойства):

1. Математическое ожидание константы равно самой константе:

33

M (C) C

2. Константу можно выносить за знак математического ожидания:

M (CX ) CM (X )

3. Математическое ожидание суммы случайных величин равно сумме их математических ожиданий:

M (X Y Z) M (X ) M (Y ) M (Z)

4. Если случайные величины независимы, то математическое ожидание произведения равно произведению их математических ожиданий:

M (XYZ) M (X )M (Y )M (Z)

Доказательство. Два первых утверждения очевидны (докажите самостоятельно). Остальные достаточно доказать для двух случайных величин, которые, для простоты, будем считать дискретными.

|

Пусть X принимает значения x1 x2 |

xn |

с вероятностями p1 |

p2 |

pn , а |

|||||||||

Y принимает значения y1 y2 |

|

ym |

с вероятностями q1 |

q2 |

qm . Обозначим че- |

|||||||||

рез |

pij |

вероятность |

одновременного |

появления |

значений |

xi |

и y j : |

|||||||

pij |

P((X xi )(Y |

y j )) . Легко видеть, что |

|

|

|

|

|

|

||||||

|

|

|

|

m |

|

n |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

pij |

pi |

pij |

q j |

|

|

|

|

(7.4) |

|

|

|

|

j |

1 |

|

i 1 |

|

|

|

|

|

|

|

|

Действительно, так как события (Y |

y j ) |

j |

1 2 |

m образуют полную |

|||||||||

группу несовместных событий, то по формуле полной вероятности |

|

|

||||||||||||

|

|

|

m |

|

|

m |

|

|

|

|

|

|

|

|

|

|

|

|

pi j |

|

P(( X xi )(Y y j )) |

|

|

|

|

||||

|

|

|

j |

1 |

|

j 1 |

|

|

|

|

|

|

|

|

|

|

m |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

P(Y y j )P( X xi (Y y j )) |

P( X xi ) |

pi |

|

|

|||||||

|

|

j |

1 |

|

|

|

|

|

|

|

|

|

|

|

|

Вторая из формул (7.4) доказывается аналогично. |

|

|

|

|

|||||||||

|

Перейдем теперь непосредственно к подсчету математического ожидания |

|||||||||||||

суммы X |

Y . Так как СВ X |

Y принимает значения xi |

y j |

с вероятностью pi j |

||||||||||

, то согласно определению (формула (7.1)) с учетом (7.4) имеем |

|

|

||||||||||||

|

|

|

|

n m |

|

|

|

n m |

|

n m |

|

|

|

|

|

|

M ( X Y ) |

|

(xi |

y j ) pij |

xi pij |

|

y j pij |

|

|

||||

|

|

|

|

i 1 j 1 |

|

i 1 j 1 |

|

i 1 j 1 |

|

|

|

|||

|

|

n |

m |

m |

n |

|

n |

m |

|

|

|

|

|

|

|

|

xi |

pij |

y j |

|

pij |

xi pi |

y j q j |

M ( X ) M (Y ) |

|

|

|||

|

|

i 1 |

j 1 |

j 1 |

i 1 |

|

i 1 |

j 1 |

|

|

|

|

|

|

|

|

|

|

|

|

|

34 |

|

|

|

|

|

|

|

что и требовалось доказать. |

|

|

|

|

|

|

|

||

Если |

случайные |

величины |

X |

и |

Y |

независимы, |

то |

||

pij P(( X |

xi )(Y y j )) |

P( X |

xi )P(Y y j ) |

pi q j (вероятность произведения не- |

|||||

зависимых событий равна произведению их вероятностей). Отсюда |

|

||||||||

|

|

n |

m |

n |

m |

|

|

|

|

|

M ( XY ) |

|

xi y j pij |

|

xi y j pi q j |

|

|

||

|

|

i |

1 |

j 1 |

i 1 |

j 1 |

|

|

|

|

n |

m |

|

n |

|

|

|

|

|

|

xi pi |

y j q j |

|

xi pi M (Y ) |

|

M ( X )M (Y ) |

|

|

|

|

i 1 |

j 1 |

|

i 1 |

|

|

|

|

|

Теорема доказана.

Теперь рассмотрим дисперсию.

Теорема 7.2. Для дисперсии справедливы следующие правила (свойства): 1. Для вычисления дисперсии, кроме формулы (7.3), применима формула

D( X ) M ( X 2 ) [M ( X )]2 |

(7.5) |

2. D(X ) 0 тогда и только тогда, когда X есть константа (не случайная величина).

3.D(CX ) C2 D( X ) .

4.Для произвольных случайных величин X и Y справедлива формула

D(X Y ) D(X ) |

D(Y ) |

2cov(X Y ) |

(7.6) |

|

где величина |

|

|

|

|

cov(X Y ) |

M[(X |

M (X ))(Y M (Y ))] |

(7.7) |

|

называется ковариацией случайных величин |

X и Y или корреляционным мо- |

|||

ментом случайных величин X и Y . |

|

|

|

|

5. Если случайные величины X и Y независимы, то |

|

|||

cov(X Y ) |

0 и D(X |

Y ) |

D(X ) D(Y ) |

|

Доказательство. Начнем с рассмотрения первого свойства. Применяя свойства математического ожидания, доказанные в теореме 7.1, и формулу

(7.3), имеем

D( X ) M (( X M ( X ))2 ) M ( X 2 |

2XM ( X ) |

M ( X )2 ) |

M ( X 2 ) M (2M ( X ) X ) M (M ( X )2 ) |

||

M ( X 2 ) 2M ( X )M ( X ) M ( X )2 |

M ( X 2 ) |

[M ( X )]2 |

Свойства 2 и 3 легко проверяются на основе уже доказанных свойств математического ожидания и формул (7.2) или (7.4).

Для доказательства свойства 4 составим по формуле (7.3) выражение для

35

D(X Y ) :

D( X Y ) |

M (( X Y M ( X Y ))2 ) |

M (( X Y M ( X ) M (Y ))2 ) |

||||||

M ((( X |

M ( X ) |

(Y |

M (Y ))2 ) M (( X |

M ( X ))2 |

(Y |

M (Y ))2 |

||

2( X |

M ( X ))(Y |

M (Y ))) |

M (( X |

M ( X ))2 ) M ((Y |

M (Y ))2 |

|||

2M ((X M (X ))(Y M (Y ))) |

D(X ) |

D(Y ) |

2cov(X Y ) |

|||||

Легко проверить, что кроме формулы (7.7) для вычисления cov(X Y ) при- |

||||||||

менима также формула |

|

|

|

|

|

|

|

|

|

cov(X Y ) |

M (XY ) |

M (X )M (Y ) |

|

(7.8) |

|||

Отсюда, с учетом свойства 4 из теоремы 7.1, получаем, что для независи- |

||||||||

мых случайных величин |

X |

и Y |

cov(X Y ) 0 , |

и, следовательно, свойство 5, а с |

||||

ним и теорема 7.2 полностью доказаны. |

|

|

|

|

||||

7.3. Коэффициент корреляции как мера линейной зависимости

случайных величин

Согласно определению случайные величины независимы, если закон распределения каждой из них не меняется от того, какие значения приняли в опыте другие случайные величины.

Наоборот, если закон распределения СВ Y меняется в зависимости от того, какие именно значения принимает в опыте СВ X , то говорят, что СВ X и Y зависимы или что между ними имеет место стохастическая (статистическая) зависимость. Более того, если математическое ожидание СВ Y меняется по неко-

торому закону g(x) |

в зависимости от появившегося в опыте значения x СВ X , |

|||

то |

говорят, |

что |

между |

СВ X и Y есть регрессионная зависимость |

M (Y |

X x) |

g(x) , заданная функцией g(x) . Функцию g(x) называют функцией |

||

регрессии Y по X , а M (Y |

X x) – условным математическим ожиданием слу- |

|||

чайной величины Y при X |

x . |

|||

|

Рассмотрим опыт, в котором у случайно взятого человека измеряются его |

|||

рост – X и вес – Y . Ясно, что в этом опыте совместно появляются две СВ X и Y . Что можно сказать про их зависимость?

Легко заметить, что между случайными величинами X – рост человека и

Y– вес человека существует стохастическая зависимость. Действительно, если

вэксперименте оказался человек роста 190 см, то вероятность того, что его вес

36

будет выше среднего намного больше, чем для человека с ростом 155 см. Более того, в результате экспериментов и статистических наблюдений установлено,

что с увеличением роста X |

средний вес людей – то есть M (Y X |

x) меняется |

||

почти по линейному закону: |

M (Y X x) kx |

b . Таким образом, между весом и |

||

ростом человека существует линейная регрессионная |

зависимость. |

Такая зави- |

||

симость называется корреляционной. |

|

|

|

|

Следует понимать, что формула M (Y X |

x) kx |

b не может предсказать |

||

вес Y конкретного человека с ростом x . Его вес по-прежнему остается случайной величиной. Но средний рост таких людей будет близок к kx b .

Крайний случай регрессионной (корреляционной) зависимости – это функциональная зависимость, когда только одна из величин X и Y является случайной, а другая меняется в строгом соответствии с изменением первой:

Y f (X ) .

Согласно свойству 5 из теоремы 7.2, если величина cov(X Y ) отлична от нуля, то случайные величины X Y зависимы. Однако величина cov(X Y ) , взятая сама по себе в отрыве от других числовых характеристик, не может сказать ничего о степени (или, как еще говорят, "тесноте") зависимости случайных вели-

чин X и Y . Так для чисел |

0 и |

0 степень зависимости X и Y такая же, |

|

как и между X и Y , хотя cov( |

X |

Y ) |

cov(X Y ) . Другим недостатком кова- |

риации cov(X Y ) является наличие у нее размерности, которая здесь совершенно неуместна.

Эти недостатки преодолевает безразмерная величина

r( X Y ) |

cov( X Y ) |

|

|

||

( X ) (Y ) |

||

|

называемая коэффициентом корреляции случайных величин X и Y .

Теорема 7.3. Для коэффициента корреляции справедливы следующие

свойства: |

|

|

|

|

1. Справедливо неравенство |

1 |

r( X Y ) |

1. |

|

2. r(X Y ) 1 тогда и только тогда, когда между |

X и Y имеет место |

|||

линейная функциональная связь Y |

kX |

b . |

|

|

Доказательство. Рассмотрим функцию |

s(t) D(tX |

Y ) , где t – любое |

||

число. Так как дисперсия случайной величины всегда неотрицательна и согласно свойству 2 теоремы 7.2 равна нулю тогда и только тогда, когда случайная

величина есть константа, мы имеем неравенство D(tX |

Y ) 0. Причем равенст- |

во 0 возможно тогда и только тогда, когда t X Y |

b const или Y tX b . |

То есть, если между X и Y имеет место линейная функциональная связь.

37

Согласно свойству 4 теоремы 7.2 и формуле (7.6)

s(t) D(tX Y ) |

D(tX ) 2cov(tX Y ) |

D(Y ) |

D( X )t2 |

2cov( X Y )t D(Y ) |

0 . |

То есть – это квадратный трехчлен относительно величины t . Так как квадратный трехчлен неотрицателен в том и только том случае, если его дискриминант D( X )D(Y ) меньше или равен 0, то отсюда получаем неравенства

|

|

|

|

|

|

|

cov( X Y ) |

|

|

cov( X Y ) |

D( X ) D(Y ) |

или |

r(X Y ) |

1 |

|||||

|

|||||||||

( X ) (Y ) |

|||||||||

|

|

|

|

|

|

|

|

||

При этом, согласно сказанному выше, равенство возможно тогда и только |

|||||||||

тогда, когда случайные величины |

X и Y |

связаны линейной функциональной |

|||||||

зависимостью. Теорема доказана. |

|

|

|

|

|||||

Более внимательное рассмотрение коэффициента корреляции показывает, |

|||||||||

что r(X Y ) может равняться нулю не только тогда, когда случайные величины независимы, но и тогда, когда они зависимы.

Случайные величины называются некоррелированными, если их коэффициент корреляции равен нулю. Случайные величины называются коррелированными, если их коэффициент корреляции отличен от нуля.

Суммируя все сказанное, говорят, что величина коэффициента корреляции служит мерой линейной зависимости между X и Y (от функциональной при

r(X Y ) |

1, до полного отсутствия линейной регрессионной зависимости при |

r( X Y ) |

0 . Отметим, что чем ближе по модулю величина коэффициента корреля- |

ции к единице, тем сильнее (теснее) линейная регрессионная зависимость между X и Y . Например, если 0, 7 , то это свидетельствует о достаточно выраженной (тесной) линейной регрессионной зависимости между X и Y .

7.4.Метод наименьших квадратов

Вэтом пункте мы покажем, как на основе метода наименьших квадратов выясняется наилучшая аппроксимация (приближение) одной СВ величины с помощью другой величины (вообще говоря, не обязательно случайной). В результате нам удастся получить формулу линейной составляющей для наилучшей аппроксимации СВ Y с помощью СВ X.

Для начала ответим на вопрос: какой нужно взять константу C, чтобы математическое ожидание квадрата отклонения СВ Z от C было минимальным? Иными словами, нам нужно найти минимум функции

38

(C) M ((Z C)2) M (Z 2) 2CM (Z) C2

по переменной C. В этом и состоит метод наименьших квадратов (МНК). Беря производную по C и приравнивая ее к нулю, получаем C M (Z ) . То есть наилучшая аппроксимация СВ Z одним числом получается тогда, когда это число есть математическое ожидание самого Z. При этом наименьшее ожидаемое отклонение оказывается равным

(M(Z)) M((Z M (Z))2) D(Z) ,

то есть дисперсии Z. |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||

|

Пусть теперь у нас есть две СВ ― X , Y , возникающие |

в одном опыте. |

|||||||||||||||||||||||||

Спрашивается: |

как |

надо |

|

выбрать |

константы |

k, |

C, |

чтобы функция |

|||||||||||||||||||

(k,C) M((Y kX |

|

C)2) была минимальна? Из решения предыдущей задачи |

|||||||||||||||||||||||||

следует, что C |

M (Y - kX ) |

|

M (Y ) - kM (X ) . Поэтому нам остается найти ми- |

||||||||||||||||||||||||

нимум по k следующей функции: |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||||||

|

(k) M((Y M(Y) k(X M(X )))2) D(Y) k2D(X ) |

|

2k cov(X,Y) . |

||||||||||||||||||||||||

Приравнивая к нулю производную по k |

|

и решая получившееся уравнение, на- |

|||||||||||||||||||||||||

ходим: |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

k |

cov(X ,Y ) |

|

|

cov(X ,Y ) |

|

( y) |

|

|

|

r(X ,Y ) |

( y) |

, |

|

|||||||||||

|

|

|

|

D(x) |

|

|

|

|

|

|

(x) ( y) |

|

(x) |

|

|

(x) |

|

||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|||||||||

где r(X,Y) – коэффициент корреляции СВ X и Y. |

|

|

|

|

|

|

|||||||||||||||||||||

|

Таким образом, наибольшая составляющая СВ Y, линейно зависящая от |

||||||||||||||||||||||||||

СВ X , имеет вид y(X ) r(X ,Y ) |

|

(Y ) |

(X |

|

M (X )) |

M (Y ) . |

|

|

|||||||||||||||||||

|

|

|

|

|

|||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

( X ) |

|

|

|

|

|

|

|

|

|

|

|

|

|

|

Посчитаем: как изменится дисперсия СВ Y после удаления из нее y( X )? |

||||||||||||||||||||||||||

Учитывая тождество D(Z) |

|

|

(Z)2, верное для любой СВ Z , имеем: |

||||||||||||||||||||||||

D(Y |

y(X )) |

M ((Y |

|

M (Y ) |

k(X |

M (X )))2) |

D(Y ) |

k 2D(X ) |

2k cov(X ,Y ) |

||||||||||||||||||

|

D(Y ) |

r(X ,Y ) |

|

(Y ) |

2 |

D( X ) |

2r( X ,Y ) |

|

(Y ) |

cov( X ,Y ) |

|||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

||||||||||||||||

|

|

(X ) |

|

|

|

|

( X ) |

||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||||

D(Y ) |

(r(X ,Y ))2 D(Y ) |

2r(X ,Y ) |

cov( X ,Y ) |

|

(Y )2 |

|

|

D(Y ) |

r( X ,Y )2 D(Y ). |

||||||||||||||||||

|

|

(X ) (Y ) |

|

|

|

||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

|

||||

То есть D(Y |

y(x)) |

|

D(Y )(1 |

|

(r( X ,Y ))2 ) . Иными словами, при r(X ,Y ) 1 со- |

||||||||||||||||||||||

ответствующая дисперсия равна нулю и, значит, между X |

и |

Y имеет место |

|||||||||||||||||||||||||

функциональная зависимость Y=y(X). Наоборот, если r(X ,Y ) |

|

0 , то СВ X и Y |

|||||||||||||||||||||||||

|

|

|

|

|

|

|

|

|

|

|

|

|

|

39 |

|

|

|

|

|

|

|

|

|

|

|

||

не коррелированны – между X и Y нет линейной зависимости. При этом стохастическая и регрессионная зависимость между X и Y могут быть.

8. Основные законы распределения случайных величин

Среди бесчисленного множества законов распределения случайных величин существуют несколько, которые наиболее часто встречаются на практике и играют фундаментальную роль, как в самой теории, так и в ее практическом применении. Среди дискретных законов распределения СВ несомненно важнейшими являются биномиальное (распределение Бернулли) и пуассоновское (закон редких явлений) распределения. Среди непрерывных СВ – равномерное распределение и нормальное распределение, которое еще называют распределением Гаусса или Гаусса-Лапласа.

8.1. Биномиальное распределение

Случайная величина, распределенная по биномиальному закону, возникает в испытаниях Бернулли, и мы фактически уже с ней встречались в разделе 5. Пусть проводится серия из n испытаний Бернулли, в каждом из которых с вероятностью p может произойти событие A . Случайная величина X p n , равная

числу появлений события A в n испытаниях Бернулли, как раз и есть пример случайной величины, распределенной по биномиальному закону. Случайная

величина |

X |

p n |

принимает значения |

0, 1, 2,..., n с вероятностями |

|

|

|

|

|

|

|

p0 p1 p2 |

|

pn , которые вычисляются по формуле Бернулли |

|||

|

|

|

p |

Ck pk qn k |

k 0 1 2 n |

|

|

|

k |

n |

|

где q 1 |

p есть вероятность противоположного A события. Числа p и n на- |

||||

зываются параметрами случайной величины X p n . Это распределение называ-

ется биномиальным потому, что по формуле бинома Ньютона, раскрывающей n -ю степень суммы двух чисел, имеем

1 ( p q)n |

n |

C k pk qn k |

n |

|

|

|

p |

k |

. |

||

k |

0 |

n |

k 0 |

|

|

|

|

|

Найдем числовые характеристики случайной величины X p n . Это можно сделать непосредственно по формулам (7.1) и (7.3), но проще поступить иначе.

40