Теория информации и кодирования. Поздышева О.В

.pdfМИНИСТЕРСТВО ОБРАЗОВАНИЯ И НАУКИ РОССИЙСКОЙ ФЕДЕРАЦИИ

ФГБОУ ВО «Воронежский государственный технический университет»

О.В. Поздышева

ТЕОРИЯ ИНФОРМАЦИИ И КОДИРОВАНИЯ

Утверждено учебно-методическим советом университета в качестве учебного пособия

Воронеж 2017

УДК 681.3 (075,8) ББК 32.97я7

П 471

Поздышева О.В. Теория информации и кодирования: учеб. пособие [Электронный ресурс]. – Электрон. текстовые, граф. данные (2,91 МБ) / О.В. Поздышева. – Воронеж : ФГБОУ ВО «Воронежский государственный технический университет», 2017. – 1 электрон. опт. диск (CD-ROM). – Систем. требо-

вания: ПК 500 и выше ; 256 Мб ОЗУ ; Windows XP ; SVGA с разрешением 1024x768 ; Adobe Acrobat; CD-ROM ; мышь. –

Загл. с экрана.

В учебном пособии рассматриваются модели сигналов, основы теории информации и кодирования, а также эффективные методы приема и обработки информации.

Издание соответствует требованиям Федерального государственного образовательного стандарта высшего образования по специальности 10.05.01 «Компьютерная безопасность», дисциплине «Теория информации»; специальностям 10.05.02 «Информационная безопасность телекоммуникационных систем», 10.05.03 «Информационная безопасность автоматизированных систем», дисциплине «Теория информации и кодирования».

Табл. 11. Ил. 60. Библиогр.: 14 назв.

Рецензенты: АО «Концерн «Созвездие» (д-р техн. наук, проф. Н.Н. Толстых);

д-р техн. наук, проф. О.Н.Чопоров

©Поздышева О.В., 2017

©ФГБОУ ВО «Воронежский государственный технический университет», 2017

ВВЕДЕНИЕ

Базовым понятием любой информационной системы, является понятие информации. Информация трактуется как осведомленность. В широком смысле информация – это отражение реального мира, в узком – сведения, являющиеся объектом хранения, преобразования и передачи.

Теория информации – это наука о получении, накоплении, преобразовании, отображении и передачи информации.

В теории информации в обобщенном виде можно выде-

лить три основных направления:

1.Статистическая теория – оценивает информацию с точки зрения мер неопределенности. В этой теории оперируют понятием энтропии, которая учитывает вероятностные свойства и характеристики информационных элементов.

2.Семантическая теория – занимается изучением смысловых характеристик информации (ценность, содержательность информации).

3.Структурная теория – рассматривает структуру построения информационных сообщений, массивов и их измерения подсчетом информационных элементов или комбинаторным методом.

Возникновение теории информации, как науки, связано с появлением работы К. Шеннона «Математическая теория связи» в 1948 году. А в 1933 году Котельников предложил теорию представления непрерывной функции в виде её дискретных отсчетов.

Основной формой представления информации является сообщение. Под сообщением понимают информацию, представленную в определенной форме и подлежащую передаче. Сообщение может быть как непрерывным, так и дискретным. Сообщение само по себе передаваться не может. Теория сообщений изучает различные способы представления, различения сообщений с помощью формализованных знаков или символов

испособы преобразования этих сообщений.

3

Носителем сообщений является сигнал. Сигнал – это материальный переносчик сообщений, т.е. это физическая величина, у которой один или несколько параметров изменяются в соответствии с отображаемым или предаваемым сообщением. Теория сигналов изучает эффективные способы формирования, обнаружения, различения и оценки параметров сигналов с учетом их свойств и свойств среды передачи сигналов (наличие шумов, помех и т.д.). А также, позволяет оптимизировать характеристики подсистем и минимизировать расходы на передачу сообщений.

Термин «информация» относится к числу наиболее часто употребляемых. Он широко используется в лингвистике, психологии, биологии, философии и других науках. Однако в разных областях знаний в него вкладывают разный смысл. Информация отображает организацию материи. При этом она не только пассивно характеризует структуру материи, но и может ее воспроизвести. Антиподом информации, которая характеризует структуру материи является энтропия.

Существует достаточно много определений этого понятия, однако наиболее адекватным до последнего времени счи-

тается Шенноновское определение энтропии как меры неопре-

деленности (степени незнания того, что подлежит передаче). Соответственно, цель – это снятие данной неопределенности при передаче информации.

Рассмотрим процесс передачи информации на примере устной речи. Процесс этот многокомпонентный. Условно его можно представить в следующем виде. Первая компонента – физическая (структурная), т.е. для успешного осуществления процесса передачи информации необходимо наличие источника акустического сигнала (голосовых связок человека), среды для распространения акустических колебаний и приемника колебаний (уха). Вторая компонента – сигнальная (чаще статистическая): амплитудно и частотно модулированные акустические колебания. Третья компонента – синтаксическая: необходимо, чтобы собеседники знали хотя бы один общий язык. Четвертая компонента – семантическая, т.е. в передаваемом сооб-

4

щении должно присутствовать содержательное описание объекта или явления, неизвестное получателю информации. Наконец, пятая компонента – прагматическая: необходимо наличие желания (мотивации) передавать и принимать сообщение.

Внастоящее время выделяют три основных формы представления информации:

1. Символьная – это представление информации с помощью каких-либо знаков (букв, цифр и т.д.). Символьная информация является дискретной.

2. Параметрическая – используется для представления количественной информации (температура, давление и т.д.). Данный вид информации может быть представлен как в непрерывном, так и в дискретном виде.

3. Графическая – удобна для отображения информации, которую человек получает непосредственно без какой-либо обработки по зрительному каналу. Подходит для передачи информации о непрерывных сигналах (графики, функции).

Внастоящем пособии термин «информация» используется применительно к описанию так называемых информационных систем [1]. К ним относятся телекоммуникационные и вычислительные сети, автоматизированные системы управления и контроля и т.п. В данном случае понятие количества информации определяется как частота употребления знаков. Количество информации в указанном смысле не отражает ни семантики, ни прагматической ценности информации.

Таким образом, основной задачей при изучении курса теория информации является – решение теоретических вопросов, касающихся повышения эффективности функционирования информационных систем, в частности, систем связи. Курс можно условно разделить на следующие направления:

1) анализ сигналов, как средства передачи информации;

2) анализ информационных характеристик источников сообщения и каналов связи;

3) теорию кодирования;

4) эффективные методы приема и обработки информа-

ции.

5

1. Модели детерминированных сигналов

Для перенесения информации в пространстве и времени она представляется в форме сообщений. Сообщение, вне зависимости от его содержания, всегда отображается в виде сигнала. Построение сигнала по определенным правилам, обеспечивающим соответствие между сообщением и сигналом, называют кодированием. Оно осуществляется с целью повышения надежности и преобразования сигналов к виду, удобному для передачи по каналам связи.

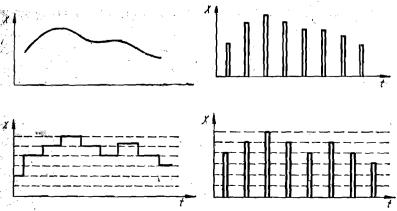

Сигналы могут быть непрерывными и дискретными как по времени, так и по множеству значений, т.е. возможен один из четырех типов сигнала (рис. 1.1):

1)непрерывный (по уровню (множеству значений) и времени) (рис. 1.1, а);

2)непрерывный по уровню, дискретный по времени

(рис. 1.1, б);

3)дискретный по уровню, непрерывный по времени

(рис. 1.1, в);

4)дискретный (по уровню и времени) (рис. 1.1, г).

а) б)

в) г) Рис. 1.1. Типы радиотехнических сигналов

6

Иногда в теории связи рассматривают также сигналы непрерывные по времени и значениям, но дискретные по параметру.

Носителем сигнала всегда является объект или процесс,

однако математическая модель сигнала абстрагируется от его физической природы и описывает лишь существенные с точки зрения изучаемого явления черты. Модель сигнала может даже противоречить физическим свойствам реальных объектов. Например, математическая модель сигнала в виде суммы бесконечного числа гармонических функций не может быть реализована на практике, однако эта абстракция позволяет выявить важные закономерности.

Вреальных информационных системах осуществляется передача только той информации, которая не известна получателю. Поэтому можно предсказать лишь вероятность каждого сообщения, а аналитической моделью сигнала, строго говоря, может быть только случайный процесс. Тем не менее, основой для изучения случайных сигналов является анализ детерминированных сигналов, рассматриваемых как элементы множества (ансамбля) реализаций.

Взависимости от методов анализа информационных систем соответственно форме представления операторов применяются те или иные формы представления сигналов. К основным из них следует отнести:

- представление сигнала в виде некоторой функции времени x(t);

- представление сигнала в операторной форме x(р);

- представление сигнала в виде некоторой функции часто-

ты x(ω).

Для анализа прохождения сложного сигнала u(t) через линейную систему его обычно представляют в виде

( ) = |

( ), [ , ], |

(1.1) |

где φk(t) – так называемые базисные функции, а ск – безразмерные коэффициенты. Если базисные функции заданы, u(t)

7

полностью определяется коэффициентами ск , которые называ-

ют дискретным спектром сигнала. За пределами интервала

[t1, t2] сигнал (1.1) считается условно продолжающимся. При рассмотрении ряда задач такое допущение может оказаться неприемлемым.

Для представления сигналов бесконечной длительности используют интеграл:

( ) = |

( )∙ ( , ) |

, |

(1.2) |

Совокупность методов, в которых используется представление сигнала в виде (1.1) и/или (1.2) называют обобщенной спектральной теорией сигналов. При этом рассматриваются частные случаи, различающиеся видом используемых базисных функций. Основное требование, обычно предъявляемое к базисным функциям, - простота вычисления коэффициентов ск.

Как правило, известны предварительные (априорные) знания о сигналах. Либо имеются сведения об ожидаемой вероятности тех или иных сигналов из общего ансамбля сигналов. Например, при передаче текста речи известно, какие буквы используются при передаче, какие буквы, сочетания букв и сочетания слов должны передаваться чаще и какие реже.

Таким образом, предварительные сведения, которыми мы располагаем о сигналах, носят статистический характер. Поэтому для исследования прохождения сигналов через информационные системы следует применять статистические методы. Целесообразность применения статистических методов обусловлена еще и тем, что на сигнал воздействуют помехи, представляющие, как правило, неизвестную функцию времени. Наконец, целесообразность использования статистических методов вызвана тем, что характеристики систем, по которым проходят сигналы, под влиянием разнообразных внешних и внутренних факторов могут изменяться случайным образом.

Случайным процессом называют случайную функцию времени U(t), значения которой в каждый момент времени являются случайной величиной. Случайные процессы, могут

8

быть непрерывными и дискретными как по времени, так и по множеству состояний, т.е. по аналогии с классификацией детерминированных сигналов возможен один из четырех типов случайного процесса.

Для описания свойств случайного процесса может использоваться N-мерная плотность вероятности

pN (U1, U2, ... , UN ; t1, t2 ,... , tN )

системы N случайных величин U1= U(t1), U2 = U(t2) , ... , UN = U(tN), взятых в моменты времени t1, t2, ... , tN. В частности, одномерная плотность вероятности p1(U; t) характеризует распределение случайной величины в произвольный момент времени t, а двумерная плотность p2 (U1, U2; t1, t2) дает вероятность совместной реализации значений случайных величин в произвольные моменты времени t1, t2 . Имеет место соотношение

( ) = |

( |

) . |

Оперирование с плотностью вероятности, в особенности, высокого порядка чрезвычайно трудоемко. Поэтому для характеристики случайного процесса обычно используют моментные функции первого и второго порядка: математическое ожидание, дисперсию и корреляционную функцию.

Математическим ожиданием случайного процесса U(t) называют неслучайную функцию времени mu (t), значение которой в каждый момент времени равно математическому ожиданию случайной величины в соответствующем сечении случайного процесса:

( ) = { ( )} = |

∙ ( ; ) ∙ , |

где p1 (U; t) - одномерная плотность вероятности.

Дисперсией случайного процесса U (t) называют неслучайную функцию времени Du (t), значение которой в каждый момент времени равно дисперсии случайной величины в соответствующем сечении случайного процесса:

9

|

( |

̇ |

̇ |

= |

|

|

|

|

; ) = ( |

) ( ) |

|

|

|

||

|

|

= |

̇ |

̇ |

( |

) ∙ |

, |

|

̇ |

( |

) ( )∙ |

||||

где |

|

|

̇ |

|

( )] . |

|

|

|

( ) = [ ( ) − |

( )] , ( ) = [ ( ) − |

|

||||

Для характеристики связи между двумя случайными процессами, например, U (t) и V (t) рассматривают также функцию взаимной корреляции:

( ) = ̇( ) ̇( ) .

С точки зрения изменчивости указанных характеристик во времени различают стационарные и нестационарные случайные процессы.

Винформационных системах очень часто встречаются случайные процессы, протекающие во времени приблизительно однородно. Эти процессы имеют вид непрерывных случайных колебаний около некоторого среднего значения, причем ни среднее значение, ни характер этих колебаний не претерпевают существенных изменений во времени. Такие процессы называются стационарными. Например, шумы на выходе электронных устройств, случайные колебания в цепях питания и т.д.

Влюбой динамической системе случайный процесс начинается с так называемого переходного процесса и затем переходит в установившийся режим, который с некоторым приближением можно считать стационарным.

Известно два понятия стационарности: стационарность в узком смысле и стационарность в широком смысле.

Процесс U(t) называют стационарным в узком смысле, если описывающие его плотности вероятности не зависят от начала отсчета времени.

Случайный процесс называют стационарным в широком смысле, если

mu(t) = mu = Const,

Du(t) = Du = Const,

Ru(t, t+τ) = Ru(τ),

10