- •1. История цвм, поколения цвм.

- •2. Классификация эвм.

- •3. Принципы работы цвм по Фон-Нейману, основные определения.

- •4. Понятия об архитектуре и структуре цвм.

- •5. Основные технические характеристики цвм.

- •Установка охлаждения;

- •Уменьшение размеров;

- •Оптимизация алгоритмов вычисления.

- •10. Формат числа с плавающей запятой, его особенности.

- •11. Двоично-десятичный формат числа.

- •12. Прямой, обратный и дополнительный коды двоичных чисел, упрощенные правила перевода чисел в обратный и дополнительный коды.

- •13. Модифицированные коды двоичных чисел, их реализация в цвм.

- •27. Система команд процессора, формат команды.

- •28. Упрощенная структурная схема типового 16-разрядного процессора, назначение его частей.

- •31. Понятия о cisc и risc архитектуре процессора, отличия.

- •32. Организация прерываний вычисления в типовом процессоре.

- •34. Поколения процессоров фирмы Intel: характеристики, отличия, основные тенденции.

- •35. Классификация современных процессоров.

- •36. Классификация запоминающих устройств.

- •37. Принципы построения постоянного и оперативного запоминающих устройств.

- •38. Назначение и принципы построения кеш-памяти.

- •39. Принципы построения внешних запоминающих устройств.

- •40. Понятие об интерфейсах современных аппаратных средств вычислительной техники.

- •41. Классификация многопроцессорных вычислительных систем по взаимодействию команд и данных.

- •42. Классификация многопроцессорных вычислительных систем по распределению оперативной памяти.

- •43.Основные методы обслуживания средств вычислительной техники

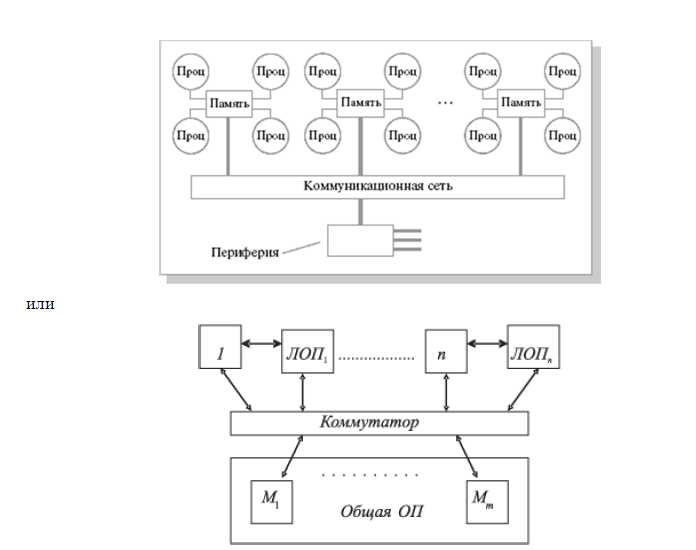

42. Классификация многопроцессорных вычислительных систем по распределению оперативной памяти.

1. SMP-архитектура (symmetric multiprocessing) – симметричная многопроцессорная архитектура, или системы с общей (разделяемой) оперативной памятью (рис. а).

Главной особенностью систем с архитектурой SMP является наличие общей физической памяти, разделяемой всеми процессорами.

Преимущества:

высокая скорость межпроцессорного обмена (через ОП);

возможность реализации любых вычислительных процессов;

простота и универсальность программирования;

высокая эффективность оборудования и относительно невысокая цена и др.

Недостаток: системы с общей памятью плохо масштабируются (шина способна

обрабатывать только одну транзакцию, вследствие чего возникают проблемы разрешения

конфликтов при одновременном обращении нескольких процессоров к одним и тем же

областям общей физической памяти).

2. MPP-архитектура (massive parallel processing) – массивно-параллельная

архитектура, или системы с распределенной памятью (рис. б) Образуют

вычислительные комплексы (ВК) − коллективы ЭВМ с межмашинным обменом для

совместного решения задач.

Распределенные ВК (ВК с распределенные вычисления) - такие, которых

вычислительные средства объединяются по специальным наборам задач, взаимосвязанных по данным. Система строится из отдельных модулей, которые по сути представляют собой полнофункциональные компьютеры. Доступ к банку ОП из данного модуля имеют только процессоры из этого же модуля. Модули соединяются специальными коммуникационными каналами.

Преимущество: хорошая масштабируемость. Практически все рекорды по

производительности на сегодня устанавливаются на машинах именно такой архитектуры,

состоящих из нескольких тысяч процессоров (ASCI Red, ASCI Blue Pacific).

Недостатки:

снижена скорость межпроцессорного обмена, поскольку нет общей среды для

хранения данных;

каждый процессор может использовать только ограниченный объем локального банка памяти;

высокая цена программного обеспечения вследствие указанных архитектурных

недостатков (требуются значительные усилия для того, чтобы максимально

использовать системные ресурсы).

Системами с раздельной памятью являются суперкомпьютеры МВС-1000, IBM RS/6000 SP, SGI/CRAY T3E, системы ASCI, Hitachi SR8000, системы Parsytec. Например, машина CRAY T3E-1200 имеет пиковую производительность 1,2 Gflops, способна масштабироваться до 2048 процессоров.

3. Гибридная архитектура NUMA (nonuniform memory access) – неоднородный

доступ к памяти.

Совмещает достоинства систем с общей памятью: память физически распределена по различным частям системы, но логически она является общей, так что пользователь видит единое адресное пространство. По существу, архитектура NUMA является MPP (массивно-параллельной) архитектурой, где в качестве отдельных вычислительных элементов берутся SMP-узлы (cимметричная многопроцессорная архитектура). Доступ к памяти и обмен данными внутри одного SMP-узла осуществляется через локальную память узла и происходит очень быстро, а к процессорам другого SMP-узла тоже есть доступ, но более медленный и через более сложную систему адресации.

Структурная схема компьютера с гибридной сетью: четыре процессора связываются между собой при помощи кроссбара в рамках одного SMP-узла. Узлы связаны сетью типа «бабочка» (Butterfly):

ЛОП − локальная оперативная память.

Такая структура используется в проекте МВК «Эльбрус-3» и «Эльбрус-3М». Наиболее известными системами архитектуры NUMA являются: HP 9000 V-class, SGI Origin3000, Sun HPC 15000, IBM/Sequent NUMA-Q 2000.

4. Кластерная архитектура МВС.

Классические суперкомпьютеры с векторно-параллельной или массивно-параллельной архитектурой недешевы, поэтому и стоимость подобных систем несравнима со стоимостью систем, находящихся в массовом производстве. Поэтому возникла идея организации МВС из массово выпускаемых компонентов (альтернатива традиционным суперкомпьютерным системам). При выполнении многих прикладных задач такие ВС, даже с небольшим или средним (до 128–256) числом вычислительных модулей, показывают производительность, не уступающую или даже превосходящую производительность традиционных суперкомпьютеров как с распределенной, так и с разделяемой памятью. Они часто создаются из общедоступных компьютеров на базе Intel и недорогих Ethernet-сетей под управлением операционной системы Linux (иногда FreeBSD).

Кластер представляет собой два или более компьютеров (узлов), объединяемые при помощи сетевых технологий на базе шинной архитектуры или коммутатора и

предстающие для пользователя единый информационно-вычислительный ресурс (сеть компьютеров для производства общих вычислений). Это дешевый вариант МРР-архитектуры.

Узел характеризуется тем, что на нем работает единственная копия операционной

системы. В качестве узлов кластера могут быть выбраны серверы, рабочие станции и даже

обычные персональные компьютеры.

Кластерные системы обладают рядом преимуществ:

более низкая стоимость;

короткий цикл разработки;

широкая возможность масштабируемости на базе сетевых технологий (Fast/Gigabit

Ethernet, Myrinet) с шинной архитектурой или с коммутатором;

взаимозаменяемость узлов;

и возможность оперативно использовать наиболее эффективные вычислительные и

коммуникационные компоненты из имеющихся на рынке во время создания системы;

наименьшая стоимость МВС, поскольку собираются на базе стандартных

комплектующих элементов, процессоров, коммутаторов, дисков и внешних устройств.

Кластеризация может осуществляться на разных уровнях компьютерной системы,

включая аппаратное обеспечение, операционные системы, программы-утилиты, системы

управления и приложения. Чем больше уровней системы объединены кластерной

технологией, тем выше надежность, масштабируемость и управляемость кластера.

В кластерах, как правило, используются операционные системы, стандартные для

рабочих станций, чаще всего свободно распространяемые (Linux, FreeBSD), вместе со

специальными средствами поддержки параллельного программирования и балансировки

нагрузки.