- •Введение

- •Формальный нейрон. Типология нейронов. Задача, решаемая нейроном, геометрическая интерпретация.

- •Формальный нейрон.

- •Типология нейронов.

- •Геометрическая интерпретация задачи нейрона.

- •Нейронная сеть. Слой, типология слоёв. Типология нейронных сетей. Основные классы задач, решаемых нейронными сетями.

- •задачи

- •Задача обучения нейронной сети, отличие от задачи обучения нейрона. Проблемы. Примеры алгоритмов и методов обучения.

- •Градиентные методы.

- •Математическое обоснование метода обратного распространения ошибки. Алгоритм обратного распространения ошибки.

- •Вывод формулы для расчёта адаптивного коэффициента обучения в алгоритме обратного распространения ошибки.

- •Вывод формулы для расчёта адаптивного шага обучения для нерекуррентной линейной нейронной сети.

- •Алгоритм послойного обучения. Назначение и отличие от алгоритма обратного распространения ошибки.

- •Алгоритм многократного распространения ошибки. Назначение и отличие от алгоритма обратного распространения ошибки.

- •Задача предсказания числовых последовательностей с помощью нейронных сетей. Особенности устройства нейронных сетей для предсказания числовых последовательностей.

- •Реккурентные нейронные сети. Контекстный нейрон. Обучение. Сеть Элмана. Сеть Джордана.

- •Рециркуляционные нейронные сети. Линейная рециркуляционная сеть. Задача, решаемая линейной рециркуляционной сетью (метод главных компонент).

- •Алгоритмы обучения и функционирования линейной рециркуляционной сети.

- •Релаксационные нейронные сети. Синхронная сеть Хопфилда. Непрерывное и дискретное состояние. Структура, обучение, энергия, функционирование.

- •Сеть Хэмминга. Назначение, обучение и функционирование.

- •Линейная ассоциативная память и ассоциативная память на основе сети Хопфилда. Функционирование, отличие.

- •Двунаправленная ассоциативная память. Назначение, структура, обучение и функционирование.

- •Двунаправленная ассоциативная память. Метод обучения двунаправленной ассоциативной памяти с модифицированной структурой.

- •Сеть адаптивного резонанса. Назначение, структура, обучение и функционирование.

- •СТРУКТУРА APT

- •Функционирование сети APT в процессе классификации

- •ФУНКЦИОНИРОВАНИЕ APT

- •ПРИМЕР ОБУЧЕНИЯ СЕТИ APT

- •ЗАКЛЮЧЕНИЕ

- •Устройство и структура нейронных сетей для решения задач классификации и кластеризации. Правила обучения: WTA и CWTA.

- •Структура когнитрона, неокогнитрона и свёрточных нейронных сетей, отличия. Назначение когнитрона, неокогнитрона и свёрточных нейронных сетей.

- •Обучение

- •НЕОКОГНИТРОН

- •Обобщение

- •Вычисления

- •Обучение

- •Псевдооптическая нейронная сеть. Интерферирующий нейрон, устройство. Назначение, структура и функционирование сети.

- •Машина Больцмана, назначение. Устройство и функционирование.

- •Предетекторы и детекторы. Поле (карта) детекторов. Детекторы новизны и тождества. Схема активного анализа на основе нейроподобных элементов.

- •Аппаратная реализация нейронных сетей. Процедура проектирования систолических массивов (процессоров), на основе структуры сети.

- •Систолические процессоры для двухслойной нейронной сети (первый слой – рецепторы). Эффективность. Предпочтение по эффективности.

- •Систолический массив с разнонаправленными связями. Сравнение по эффективности с процессорами с однонаправленными связями.

- •Матричный систолический процессор. Сравнение по эффективности.

- •Систолические массивы для многослойных нейронных сетей. Структура систолического массива, объединяющего различные систолические процессоры. Эффективность.

- •Систолические массивы для многослойных нейронных сетей. Структура систолического массива, объединяющего идентичные систолические процессоры. Эффективность.

- •Систолические процессоры для реализации релаксационных нейронных сетей (сети Хопфилда).

- •Методы обеспечения отказоустойчивости. Скользящее резервирование.

- •Методы обеспечения отказоустойчивости. Секционированное резервирование. Схема для неоднородного потока входных данных.

- •Нечёткие нейронные сети. Структура, функционирование, обучение.

- •Литература.

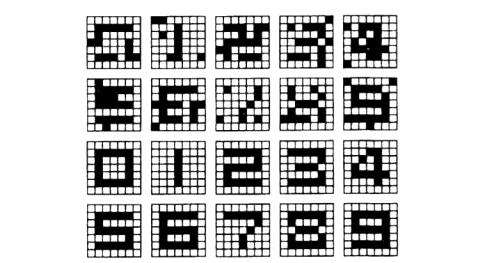

Рис. 20. Тестовые (сверху) и распознанные сетью Хэмминга (снизу) образцы цифр при обработке второй группы искажёшшых входных данных

Единственная проблема, связанная с сетью Хемминга, проявляется в случае, когда зашумленные образы находятся на одинаковом (в смысле Хемминга) расстоянии от двух или более эталонов. В этом случае выбор сетью Хемминга одного из этих эталонов становится совершенно случайным.

Линейная ассоциативная память и ассоциативная память на основе сети Хопфилда. Функционирование, отличие.

Ассоциативная память играет роль системы, определяющей взаимную зависимость векторов. В случае, когда на взаимозависимость исследуются компоненты одного и того же вектора, говорят об ассоциативной памяти. Если же взаимозависимыми оказываются два различных вектора a и b, можно говорить о памяти гетероассоциативного типа. Типичным представителем первого класса является сеть Хопфилда, а второго – сеть Хемминга. Главная задача ассоциативной памяти сводится к запоминанию входных (обучающих) выборок таким образом, чтобы при представлении новой выборки система смогла сгенерировать ответ – какая из запомненных ранее выборок наиболее близка к вновь поступившему образу.

Хопфилд разработал ассоциативную память с непрерывными выходами, изменяющимися в пределах от +1 до –1, соответствующих двоичным значениям 0 и 1, Запоминаемая информация кодируется двоичными векторами и хранится в весах согласно следующей формуле:

wij = ∑(OUTi,d OUTj,d ) |

(129) |

d=1...m |

|

где т – число запоминаемых выходных векторов; d – номер запоминаемого выходного вектора; OUTi,j – i-компонента запоминаемого выходного вектора.

Это выражение может стать более ясным, если заметить, что весовой массив W может быть найден вычислением внешнего произведения каждого запоминаемого вектора с самим собой (если требуемый вектор имеет n компонент, то эта операция образует матрицу размером п х п) и суммированием матриц, полученных таким образом. Это может быть записано в виде

W = ∑Dit Di , |

(130) |

i |

|

где Di – i-й запоминаемый вектор-строка.

Как только веса заданы, сеть может быть использована для получения запомненного выходного вектора по данному входному вектору, который может быть частично неправильным или неполным. Для этого выходам сети сначала придают значения этого входного вектора. Затем входной вектор убирается и сети предоставляется возможность «расслабиться», опустившись в ближайший глубокий минимум. Сеть, идущая по локальному наклону функции энергии, может быть захвачена локальным минимумом, не достигнув наилучшего в глобальном смысле решения.

Двунаправленная ассоциативная память. Назначение, структура, обучение и функционирование.

Обобщением сети Хопфилда на случай двухслойной рекуррентной структуры, позволяющей кодировать множества двух взаимосвязанных векторов, считается двунаправленное ассоциативное запоминающее устройство, называемое ВАМ (англ.: Bidirectorial Associative Memory), предложенное Б. Коско. Его обобщенная структура представлена на рис. 21. Сигналы распространяются в двух направлениях: от входа к выходу и обратно. Функционирование имеет синхронный характер. Это означает, что если в первом цикле сигналы вначале проходят в одну сторону для определения состояния нейронов-получателей, то в следующем цикле они сами становятся источником, высылающим сигналы в обратную сторону. Этот процесс повторяется до достижения состояния равновесия.

Рис. 21. Структура сети ВАМ

Функция активации нейронов имеет пороговый характер: она может быть двоичной со значениями 1 или 0 либо биполярной со значениями ±1. При нулевом сигнале возбуждения нейрона его текущее состояние остается равным предыдущему состоянию. Для обеспечения лучших характеристик сети в режиме распознавания на этапе обучения используются только биполярные сигналы. Матрица весов W, связывающая обе части сети, является действительной и несимметричной. С учетом симметрии связей входного и выходного слоев сети при прямом направлении распространения сигналов веса описываются матрицей W, а при противоположном направлении - матрицей WT. Предположим, что

входные обучающие данные определены в виде множества из т биполярных пар

{(ai, bi)}, где ai = [аi1, аi2,..., ain], bi = [bi1, bi2,..., bip] (векторы-строки). Этому множеству сопоставляется множество биполярных пар {(xi, yi)}, где xi – это

биполярное представление ai (0 → -1, 1 → 1), а yi – биполярное представление bi. В соответствии с определением Б. Коско [11] матрица весов W формируется

на основе множества {(хi, yi)} как матрица корреляции

m |

|

W = ∑xiT yi . |

(131) |

i=1

Показано, что использование биполярных обучающих векторов дает лучшие результаты на стадии распознавания. Определение весов межнейронных связей позволяет проследить процесс стабилизации состояния на обоих концах сети. Если допустить, что начальное состояние сети было задано парой (x0, y0), то процесс двунаправленной обработки сигналов состоит из последовательных циклов

f (x W) = y → f ( y WT ) = x → f (x WT ) = y |

→ |

|

|||||

0 |

1 |

1 |

1 |

1 |

2 |

|

|

|

|

→ f ( y WT ) = x → f (x WT ) = y → |

(132) |

||||

|

|

2 |

2 |

|

2 |

3 |

|

|

|

|

|

||||

... ... ... ... ...

→ f ( y f WT ) = xf → f (xf WT ) = yf

в результате чего формируются две стабильные величины xf и yf , свидетельствующие о достижении стабильного состояния сети. В случае бинарного описания начального состояния в виде (a0, b0) биполярным величинам (xf, yf) сопоставляются бинарные представления (af, bf). Каждой промежуточной точке процесса (xk, yk) можно сопоставить энергетическую функцию Ek, определяемую в виде

E |

= −x WyT . |

(133) |

|

k |

k |

k |

|

Доказано, что каждое очередное изменение состояния переходного процесса ведет к уменьшению значения энергетической функции сети вплоть до достижения локального минимума. Этот минимум достигается за конечное количество итераций, и он имеет значение

Emin = −xf WyTf . |

(134) |

Иными словами, любое другое решение (в том числе и ближайшее, отличающееся лишь на 1 в смысле меры Хемминга от (xf, yf)) будет характеризоваться большим значением энергетической функции. При выполнении некоторых дополнительных условий парой (xf, yf) становится одна из обучающих пар, участвующих в формировании матрицы W, которая наиболее подобна (наиболее близка по мере Хемминга) паре, определившей начальное состояние (x0,

y0).

В качестве примера рассмотрим обучение по правилу Коско сети ВАМ, имеющей 4 входа (векторы x состоят из 4 элементов) и 5 выходов (5-элементные векторы y). Задача сети состоит в запоминании множества из пяти сопряженных векторов x и y, заданных в биполярной форме. Обучающие векторы сгруппированы в приведенные ниже матрицы X и Y. Каждая строка матрицы X

представляет собой один обучающий вектор, сопряженный с соответствующей строкой матрицы Y.

|

1 |

1 |

1 |

1 |

|

|

|

|

|

|

|

|

−1 |

1 |

1 |

1 |

|

|

|

|

|

X = |

|

|

, |

|

(135) |

|

||||

−1 |

−1 |

1 |

1 |

|

|

|

||||

|

|

|

|

|

|

|

|

|

|

|

|

−1 −1 |

−1 |

1 |

|

|

|

|

|

||

|

|

|

−1 |

|

|

|

|

|

|

|

|

−1 |

−1 −1 |

|

|

|

|

||||

|

−1 −1 −1 −1 −1 |

|

|

|

||||||

|

|

|

−1 |

|

|

|

|

|

|

|

Y = |

−1 |

−1 −1 1 |

|

(136) |

|

|||||

−1 |

−1 |

−1 |

1 |

|

1 . |

|

|

|||

|

|

|

|

|

|

|

|

|

|

|

|

−1 −1 |

1 |

1 |

|

1 |

|

|

|

||

|

|

−1 |

1 |

1 |

1 |

|

|

|

|

|

|

|

|

1 |

|

|

|

||||

Матрица |

весов |

|

сети, сформированная |

согласно |

формуле |

W= |

||||

x1T y1 + x2T y2 + x3T y3 + x4T y4 + x5T y5 имеет вид: |

|

|

|

|||||||

|

3 |

1 |

-1 |

−3 |

−5 |

|

|

|

||

|

|

1 |

−1 |

|

|

|

|

|

|

|

W= |

|

−3 −5 −3 |

|

(137) |

|

|||||

|

|

|

|

|

|

. |

|

|

||

|

|

−1 |

−3 |

−5 −3 −1 |

|

|

|

|||

|

−3 −5 −3 −1 1 |

|

|

|

||||||

В режиме распознавания при начальных значениях векторов, совпадающих с использованными при обучении, сеть распознает их безошибочно. Значения

энергии, соответствующие конечному состоянию, равны: E1= - x1Wy2T = - 40, Е2 = - x2Wy2T = -34,

E3 = - x3Wy3T = -32, E4 = - x4Wy4T = -34 и E5 = - x5Wy5T = = - 40. При искажении значений векторов x и y, использовавшихся в процессе распознавания,

спроектированная по алгоритму Коско сеть ВАМ не всегда способна откорректировать эти векторы, и распознает их с определенными погрешностями. Оригинальное решение, предложенное Б. Коско, характеризуется относительно невысоким качеством распознавания. Если размерности векторов x и y обозначить соответственно n и p, то удовлетворительное качество распознавания можно получить при выполнении зависимости m < min(n, p) .

Двунаправленная ассоциативная память. Метод обучения двунаправленной ассоциативной памяти с модифицированной структурой.

Заменим матрицу W расширенной матрицей W вида

ˆ |

=[WWij ] |

|

(138) |

|

Wf |

|

|||

|

|

|

|

ˆ |

при передаче сигнала в направлении от x, и матрицей Wb вида |

||||

ˆ |

T |

Wx |

] , |

(139) |

Wb |

=[W |

|||

при передаче сигнала в направлении от y. Вводимая таким образом поправка разрушает симметрию передачи сигналов в противоположных направлениях. Дополнительные матрицы Wx и Wy конструируются так, что при нормальной

работе алгоритма Коско их влияние нивелируется; они включаются в работу только при возникновении ошибок распознавания.

Пусть p' и n' обозначают количество обучающих пар, для которых в процессе распознавания получены неправильные ответы для векторов y и x соответственно. Индексами y и x будем обозначать процессы, приводящие к формированию ошибочных векторов y и x соответственно. Если (xi, yi) является очередной k-й обучающей парой, для которой f (xiW) ≠ yi, то принимается yik =1, yij = 0 для j ≠ k

(k = 1, 2, ..., p'). Если для (xi, yi) выполняется условие f(xiW) = yi, то yik = 0 для k= 1,2, ...,p'. Компоненты yik образуют вектор yi длиной p'. Аналогичным образом для

процессов, распространяющихся в противоположном направлении, при замене векторов y на x можно получить векторы xi длиной n'. Корректирующие матрицы

Wx и Wy формируются согласно формулам [12]:

m |

|

Wy = ∑xiT yi , |

(140) |

i=1 |

|

m |

|

Wx = ∑yiT xi . |

(141) |

i=1

На следующем шаге создаются матрицы дополнительных узлов сети Ty и Tx, причем

m |

yj , |

|

Ty = ∑qy yTj |

(142) |

|

j=1 |

|

|

m |

xj . |

|

Tx = ∑qx xTj |

(143) |

j=1

Параметры qx и qy подбираются таким образом, чтобы они соответствовали условиям:

qy > n(m −2) −2 mini qy > n(m −2) −2 mini

|

|

, |

(144) |

∑dH (ai , aj ) |

|||

j≠i |

|

|

|

|

|

|

(145) |

∑dH (bi ,bj ) . |

|||

j≠i |

|

|

|

Модифицированная структура сети ВАМ, в которой учитываются связи через матрицы Tx и Ty, представлена на рис. 22. Зачерненные нейроны увеличивают размерность сети, они корректируют неточности функционирования связей, задаваемых матрицей W. После предъявления на вход сети тестовой пары (x0, y0) осуществляется аналогичный протекающему в сети Коско рекуррентный процесс, приводящий к получению конечных значений (xf, yf)

(x0, y0 ) → (x1, y1 ) →...(xf , yf ) ,

Рис. 22. Структура расширенной сети ВАМ

при этом описание отдельных его этапов должно содержать дополнительные связи, показанные на рис. 22. При использовании введенных обозначений получаем

y1 = f (x0W + gy (x0Wy )Ty ) , |

(146) |

|

x1 = f ( y1WT + gx ( y1Wx )Tx ) , |

(147) |

|

…=… |

|

|

yf |

= f (xf −1W + gy (xf −1Wy )Ty ) , |

(148) |

xf |

= f ( yf WT + gy ( y f Wx )Tx ) . |

(149) |

где gx() и gy() обозначают векторы функций активации дополнительных корректирующих нейронов. В алгоритме Ванга эти функции подбираются

Рис. 23. Иллюстрация последовательности распознавания сетью BAM двух сопряжённых образов, предварительно искажённых шумом

следующим образом:

gy (ν) =[gy (ν1), gy (ν2 ),..., gy (νp′)] ,

gx (ν) =[gx (ν1), gx (ν2 ),..., gx (νn′)] ,

где элементы векторов gx и gy определяются выражениями:

g (ν ) = 1 для νi > n −ε1 y i 0 для других ,

g (ν ) = 1 для νi > n −ε2 x i 0 для других .

(150)

(151)

(152)

(153)