- •Вопрос 2. Критерий Сэвиджа принятия решений: характеристики проектной ситуации и выбор варианта.

- •Вопрос 2. Моделирование на макроуровне и микроуровне: общая характеристика математических моделей и виды задач, решаемых на каждом уровне.

- •Компонентные уравнения.

- •2. Топологические уравнения

- •Вопрос 2. Элементы теории графов: основные понятия и определения.

- •Вопрос 2. Аналоговое моделирование. Принцип аналогии.

- •Билет №6

- •Билет №7

- •Вопрос 2. Аналоговое моделирование физических полей. Коэффициенты аналогии, индикаторы аналогии.

- •Вопрос 2. Теория принятия решений: общие положения и область применения. Ситуация выбора решения. Факторы выбора альтернатив и этапы процесса принятия решений.

- •Вопрос 2. Регулярные методы оптимизации: динамическое программирование. Принцип оптимальности Беллмана и рекуррентное соотношение. Примеры задач управления запасами.

- •Вопрос 2. Прямые методы оптимизации: общая характеристика и примеры пассивных и последовательных стратегий поиска.

- •Вопрос 2. Классификация математических моделей в зависимости от степени абстрагирования от структуры и физических свойств объекта.

- •1 .Компонентные и топологические уравнения в моделях макроуровня.

- •Вопрос 2. Прямые методы оптимизации: общая характеристика и примеры пассивных и последовательных стратегий поиска.

- •Вопрос 2. Методы оптимального проектирования. Прямые методы многомерного поиска: классификация; сущность методов покоординатного спуска и градиентного.

- •Вопрос 2. Методы оптимального проектирования. Критерии оптимальности технических объектов. Постановка задач оптимального проектирования.

Вопрос 2. Теория принятия решений: общие положения и область применения. Ситуация выбора решения. Факторы выбора альтернатив и этапы процесса принятия решений.

Т ЕОРИЯ

ПРИНЯТИЯ РЕШЕНИЙ 5.2.1. Основные положения

ЕОРИЯ

ПРИНЯТИЯ РЕШЕНИЙ 5.2.1. Основные положения

Т еория

принятия решений рассматривает задачи,

где существует необходимость принимать

решения в ситуациях, для которых не

удается полностью учесть определяющие

их условия, а также последующее их

влияние.

еория

принятия решений рассматривает задачи,

где существует необходимость принимать

решения в ситуациях, для которых не

удается полностью учесть определяющие

их условия, а также последующее их

влияние.

Теория принятия решений представляет собой набор понятий и систематических методов, позволяющих всесторонне анализировать проблемы принятия решений в условиях неопределенности.

Под ситуацией выбора решения следует понимать все элементы задачи, такие, как состояния исходных данных, варианты решения и их последствия, а также все оказывающие существенное влияние на решение внешние факторы как объективного, так и субъективного характера.

В основе теории принятия решений лежит предположение о том, что выбор альтернатив должен определяться двумя факторами: 1) представлениями лица, принимающего решение о вероятностях различных возможных исходов (последствий), которые могут иметь место при выборе того или иного варианта решения; 2) предпочтениями, отдаваемыми им различным возможным исходам.

Варианты решения определяются, главным образом, параметрами системы или процесса. Факторы, влияющие на принятие решения, находятся в диапазоне от крайне субъективных, определяемых компетенцией и осведомленностью принимающего решение и проявляющихся в ускоренном выборе или затягивании решения, до таких объективных условий, как технические данные, характеристики, методы и всевозможные вспомогательные средства. По затраченным для обработки средствам решения можно разбить на три группы: 1) эмпирические; 2) опирающиеся на некоторые количественные сравнительные оценки; 3) принятые на основании построенной с исчерпывающей полнотой модели.

Для удобства изложения выделим четыре важных этапа процесса принятия решений.

1. Определение альтернативных способов действия. Должен быть задан подходящий набор целей и указаны соответствующие им меры эффективности;

2. Описание вероятностей возможных исходов. При этом требуется, чтобы неопределенность, связанная с альтернативными решениями, была выражена численно через распределение вероятностей. В результате такой операции становится известной вероятность каждого возможного исхода для каждого принятого решения,

Ранжирование предпочтений возможных исходов через их полезность. Для этого выбирают меру эффективности, а затем с ее помощью представляют в числовой форме отношение лица, принимающего решение, к возможным последствиям решения и вероятности возможных исходов.

Рациональный синтез информации, полученной на первых трех этапах. Следует проанализировать и эффективно использовать всю полученную информацию для того, чтобы решить, какой из возможных альтернатив следует отдать предпочтение.

?????????????????????????????????????????????

Билет №12

Минимаксный критерий принятия решений: характеристика проектной ситуации и правило выбора варианта решения. Фото 7 (с 209 б)

Ищем

в-т с макс знач-ем рез-та (мах еi),

считаем, что оц-и еi

хар-т такие вел-ны, как выигрыш.Выбор

оптим в-та производим с пом критерия

:

Мн-во Е0

оптимальных в-тов сост из тех Еi0

, кот принадлежат мн-ву Е всех в-тов и

оц-а еi0

кот-х максимальна среди всех оц-к еi.

:

Мн-во Е0

оптимальных в-тов сост из тех Еi0

, кот принадлежат мн-ву Е всех в-тов и

оц-а еi0

кот-х максимальна среди всех оц-к еi.

Взаимосвязь между основными единичными показателями надёжности: вероятностью безотказной работы, средней наработкой на отказ и интенсивностью отказов (-характеристикой).

ВБР – в-ть того, что в пределах заданной наработки отказ объекта не возникнет. Если Т – время непрерывной исправно А; t – время, за кот необх опр-ть ВБР, то ВБР: P(t)= P{T>=t},t>=0

СНО

– отн-е наработки восстанавливаемого

об-а к математическому ожиданию числа

его отказов в течение этой наработки.

ИО – отн-е числа отказов об-ов в ед-у т-и к среднему числу об-ов, продолжающих исправно работать в данный инт-л т-и.

Все они хар-т надежность невосстанавливаемых об-ов. (для восстанавливаемых наработка рассм-ся только до 1-го отказа) (с 122-130 б)

Билет 14. вопрос 1. Методы многомерной оптимизации: покоординатного спуска и градиентный.

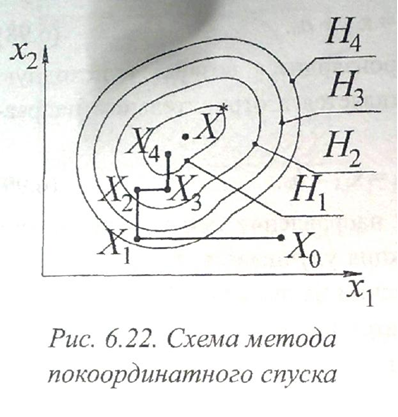

2. Методы покоординатного спуска (метод Гаусса-Зейделя) (иногда их называют релаксационными методами). Эти методы предусматривают последовательную циклическую оптимизацию по каждой из варьируемых переменных х1.

Направление движения к экстремуму выбирается поочередно вдоль каждой из координатных осей управляемых параметров х1

Р![]() ассмотрим

процесс поиска экстремума целевой

функции W(X)

для

n-мерной

задачи оптимизации при X

=

(х1,

х2,…хn).

Предположим, что осуществляется поиск

минимума функции W(х).

Тогда

улучшению ее на шаге (k

+ 1) поиска будет соответствовать условие

ассмотрим

процесс поиска экстремума целевой

функции W(X)

для

n-мерной

задачи оптимизации при X

=

(х1,

х2,…хn).

Предположим, что осуществляется поиск

минимума функции W(х).

Тогда

улучшению ее на шаге (k

+ 1) поиска будет соответствовать условие

И

![]() з

выбранной начальной точки поиска Х0

выполняется

пробный шаг h0

в

положительном направлении одной из

координатных осей (обычно вдоль оси

первого управляемого параметра х1).

В

новой точке Х1

с

координатами Х1

=

(x1,1=x1,0+h0,x2,1=x2,0,…xn,0=xn,0)

вычисляется значение целевой функции

W(Х)

и

сравнивается с ее значением в начальной

точке W(X0).

Если

W(X1)

< W(X0)

это

направление принимается для осуществления

дальнейшего пошагового движения к

экстремуму в соответствии с выражением

з

выбранной начальной точки поиска Х0

выполняется

пробный шаг h0

в

положительном направлении одной из

координатных осей (обычно вдоль оси

первого управляемого параметра х1).

В

новой точке Х1

с

координатами Х1

=

(x1,1=x1,0+h0,x2,1=x2,0,…xn,0=xn,0)

вычисляется значение целевой функции

W(Х)

и

сравнивается с ее значением в начальной

точке W(X0).

Если

W(X1)

< W(X0)

это

направление принимается для осуществления

дальнейшего пошагового движения к

экстремуму в соответствии с выражением

В противном случае производится, возврат в исходную точку Х0 и движение осуществляется в отрицательном направлении оси х1:

![]()

Движение в выбранном направлении оси х1 выполняется до тех пор, пока целевая функция улучшается, т.е. выполняется условие (6.97). При его нарушении на шаге (k + 1) производится возврат в точку x1,k, определяется направление движения вдоль следующей координатной оси x2 и совершаются спуски в направлении, обеспечивающем улучшение целевой функции.

![]()

П![]() осле

осуществления спусков вдоль всей п

осей

первый цикл спусков

N=

1

завершается и начинается новый цикл

N=2.

Если на очередном цикле движение

оказалось невозможным ни по одной из

осей, тогда уменьшается шаг поиска:

осле

осуществления спусков вдоль всей п

осей

первый цикл спусков

N=

1

завершается и начинается новый цикл

N=2.

Если на очередном цикле движение

оказалось невозможным ни по одной из

осей, тогда уменьшается шаг поиска:

Далее поиск экстремума продолжается с уменьшенным шагом. Условие окончания поиска -

![]()

При достижении условия (6.102) поиск прекращается, и полученная точка Хk принимается в качестве искомой экстремальной точки X. Точка Xk при этом находится в некоторой малой окрестности точки локального экстремума X* , ограничиваемой задаваемым минимальным значением шага поиска hmin.

Параметрами алгоритма покоординатного спуска являются ho, hmin и γ. Алгоритм обеспечивает сходимость к решению X* за конечное число итераций, если функция W(X) имеет первую и вторую производные в окрестности экстремума.

П ример

поиска экстремума методом

покоординатного спуска для двумерной

задачи при Х=(х1,х2)

представлен

на рис. 6.22, где показаны два цикла

спусков вдоль осей х1

и

х2

Линии

равных уровней целевой функции W(X)

обозначены

Н1

...,

Н4,

причем Н1<

Н2<

Н3<

Н4,

а минимум ее соответствует точке X*.

Траектория

поиска изображена жирной линией.

ример

поиска экстремума методом

покоординатного спуска для двумерной

задачи при Х=(х1,х2)

представлен

на рис. 6.22, где показаны два цикла

спусков вдоль осей х1

и

х2

Линии

равных уровней целевой функции W(X)

обозначены

Н1

...,

Н4,

причем Н1<

Н2<

Н3<

Н4,

а минимум ее соответствует точке X*.

Траектория

поиска изображена жирной линией.

Движение начато из исходной точки X0. При этом в каждом цикле вдоль каждой из осей выполняется несколько шагов. После достижения точки Х1 значение W(X) начинает возрастать, поэтому произошла смена направления движения. На новом направлении вдоль оси Х2 движение осуществляется к точке Х2 и первый цикл спусков на этом завершается. Затем циклы повторяются, пока не будет выполнено условие прекращения поиска.

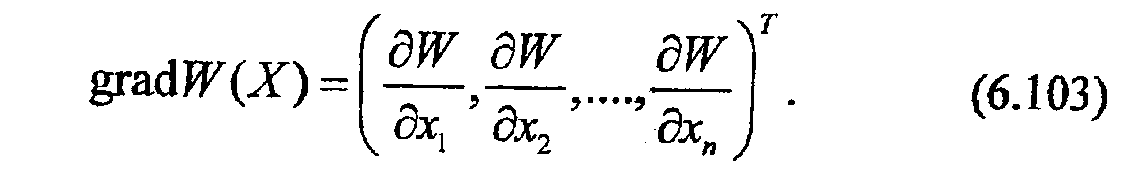

3. Метод градиента

Г радиент

- векторная величина, компонентами

которой являются частные производные

целевой функции по управляемым

параметрам:

радиент

- векторная величина, компонентами

которой являются частные производные

целевой функции по управляемым

параметрам:

Градиент всегда сориентирован в направлении наиболее быстрого изменения функции. Градиентное направление является локально наилучшим направлением поиска при максимизации целевой функции, а антиградиентное - при ее минимизации. Это свойство вектора gradW(X) и используется в методе градиента, определяя вид траектории поиска.

Движение по вектору градиента перпендикулярно линиям уровня поверхности отклика (или перпендикулярно поверхности уровня в гиперпространстве в случае, если число проектных параметров больше двух).

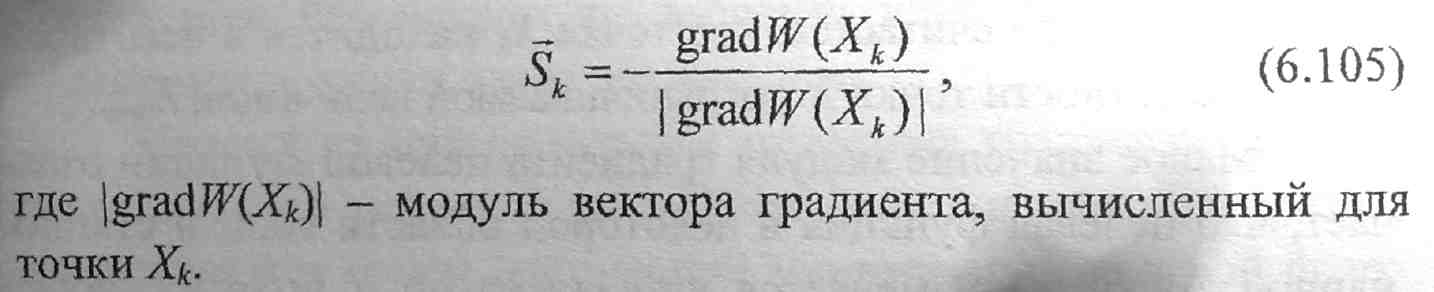

Движение в пространстве управляемых параметров осуществляется в соответствии с выражением

![]()

где hk - шаг поиска; Sк - единичный вектор направления поиска

н а

шаге (k

+ 1),

характеризующий направление градиента

в точке Хk,.

При

минимизации целевой функции вектор Sk

должен

иметь направление, противоположное

направлению вектора градиента,

поэтому для его определения используется

выражение

а

шаге (k

+ 1),

характеризующий направление градиента

в точке Хk,.

При

минимизации целевой функции вектор Sk

должен

иметь направление, противоположное

направлению вектора градиента,

поэтому для его определения используется

выражение

Дадим краткое изложение алгоритма поиска минимума целевой функции W(X). В каждой точке траектории поиска Хk, в том числе в исходной точке Х0 определяется градиент целевой

функции gradW(Xk) и единичный вектор направления Sk выполняется шаг в пространстве управляемых параметров к точке Хк+1 согласно выражению (6.104) и оценивается успешность поиска на основе неравенства (6.97). При этом вычисляется значение целевой функции W(Xk+1) в точке Хк+1 и сравнивается с ее значением W(Xk+1) предыдущей точке Хk.

Если условие (6.97) выполнено, то шаг поиска успешный, поэтому определяется новое направление движения из точки Хk+1 и выполняется следующий шаг в точку Хk+2

При большой кривизне линий равных уровней (т.е. при сложном рельефе поверхности целевой функции), а также вблизи экстремальной точки принятый в начале поиска шаг hk может оказаться слишком большим, и условие (6.97) на очередном шаге не будет выполнено. В этом случае необходимо возвратиться в предыдущую точку hk уменьшить шаг по формуле ™

![]()

где γ в коэффициент уменьшения шага: 0 <γ< 1, и повторить движение в том же направлении, но с меньшим шагом.

Условия окончания поиска методом градиента имеют вид

где ε - малая положительная величина.

При выполнении одного из условий: (6.107) или (6.107)-поиск прекращается, а полученная точка Хk принимается в качестве искомой точки экстремума X. Если поиск прекращен по условию (6.107), то считается, что точка Хk находится в некоторой малой окрестности точки X*, ограничиваемой величиной hmin

Малое значение модуля градиента целевой функции означает, что целевая функция в некоторой области вблизи стационарной точки X* изменяется незначительно и поэтому любая точка в этой области может быть принята в качестве допустимого решения задачи оптимизации.

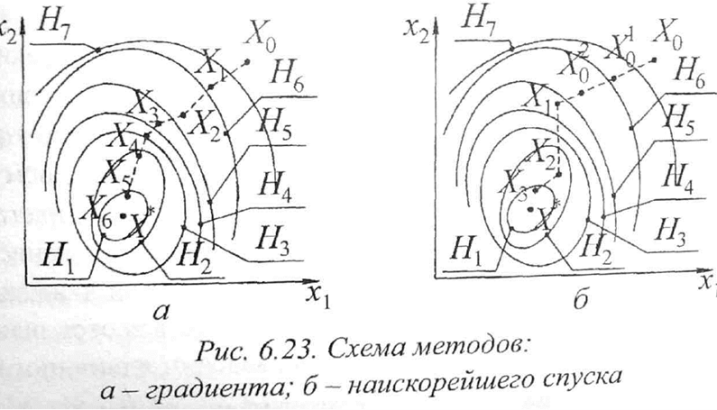

На рис. 6.23, а показан пример поиска минимума целевой функции для двумерной задачи методом градиента. Линии равных уровней целевой функции обозначены H1..., H7, причем H1<Н2<...<Н7 а траектория поиска проходит через точки X0, Х1, Х2… .

Д вижение

в градиентном направлении по

определению должно

приводить к улучшению функции качества

Если это не так и W(Xn+1)

< W(Xn),

можно

предположить, что поиск просто «проскочил»

оптимальную точку. В этом случае следует

уменьшить величину шага и повторить

вычисления.

вижение

в градиентном направлении по

определению должно

приводить к улучшению функции качества

Если это не так и W(Xn+1)

< W(Xn),

можно

предположить, что поиск просто «проскочил»

оптимальную точку. В этом случае следует

уменьшить величину шага и повторить

вычисления.