- •1.1. Повідомлення та інформація

- •1.2. Моделі інформаційних систем

- •1.4. Предмет теорії інформації та кодування

- •2.2. Кількісна міра інформації

- •2.3. Ентропія та її властивості

- •2.4. Безумовна ентропія

- •2.5. Умовна ентропія

- •2.6. Ентропія об'єднання двох джерел

- •3.1. Продуктивність дискретного джерела та швидкість передачі інформації

- •4.1. Квантування сигналів

- •4.2. Інформаційні втрати

- •4.3. Продуктивність неперервного джерела та швидкість передачі інформації

- •IhlilhM

- •4.4. Пропускна здатність . . . .

- •5.1. Класифікація кодів і характеристики їх

- •5.4. Способи подання кодів

- •5.6. Основні теореми кодування для каналів

- •6.1. Класифікація первинних кодів

- •6.2. Нерівномірні двійкові первинні коди

- •6.2.1. Код морзе

- •6.2.2. Число-імпульсні коди

- •6.3. Рівномірні двійкові первинні коди

- •6.3.1. Числові двійкові коди

- •6.3.2. Двійково-десяткові коди

- •6.3.4. Двійково-шістнадцятковий код ;;.-,-.

- •6.3.5. Рефлексні коди

- •7.1. Двійкові коди,

- •7.1.2. Код із перевіркою на непарність

- •7.1.3. Код із простим повторенням

- •7.2. Недвійкові коди, що виявляють помилки

- •7.2.1. Код із перевіркою за модулем q

- •7.2.2. Код із повторенням

- •8"6 90472 "100562 І' • шТрИховє зОбраЖєння кодового сло-

- •8.1. Двійкові групові коди

- •8.1.1. Лінійний систематичний груповий (блоковий) код

- •8.1.2. Коди хеммінга

- •8.1.4. Коди боуза - чоудхурі - хоквінгема

- •8.1.5. Код файра

- •8.1.6. Код із багатократним повторенням

- •8.3.2. Узагальнений код хеммінга

- •8.3.3. Коди боуза - чоудхурі - хоквінгема

- •8.3.4. Коди ріда - соломона

- •8.3.6. Недвійковий ланцюговий код

- •9.1. Вірогідність передачі кодованих повідомлень

- •9.2. Стиснення інформації"

- •9.2.1. Способи стиснення даних при передачі

- •9.2.2. Способи стиснення даних при архівації

- •Збіжного рядка

- •9.3. Збільшення основи коду

- •0Сзезс99е8с0е1с10d1c242d5c3d2c6d8cbd6e8c0

- •VosooooooooooooooooOvJvJ

2.5. Умовна ентропія

Припустимо, що повідомлення а зустрічалося у довгому ланцюзі з N = 1000 повідомлень Іх = 200 разів, повідомлення Ь у цьому самому ланцюзі — /2 = 200 разів, а разом вони зустрілися лише /3 = 50 разів. Скориставшись теорією математичної статистики, можна встановити, що ймовірність появи повідомлення а в цьому ланцюзі р (а) = lxIN = 0,25, а повідомлення b-p(b) = = l2IN = 0,2. Крім того,/? (ab) - l3/N = 0,05. При цьому/? (ab) =

34

*■ р (а)р Ф) = 0,25 • 0,2 = 0,05, що є явною ознакою статистичної иешлсжності повідомлень а та Ь. Саме для таких повідомлень {смуг безумовна ентропія, про яку йшлося вище.

Коли б у цьому прикладі пара ab зустрілася /3 = 30 разів, то ииянилося б, що р (ab) = l3IN = 0,03 < р (а) р (Ь). Це є ознакою порушення статистичної незалежності повідомлень а та Ь, яка відбиває той факт, що вони не «прагнуть» зустрічатися разом у послідовностях повідомлень, тобто поява одного з них дає підставу з більшою впевненістю не очікувати появи іншого, ніж не було б до появи першого повідомлення. Це означає, що ймовірність появи, скажімо, повідомлення b в послідовності відра-іу після появи повідомлення а трохи зменшується, і навпаки, хоча взагалі безумовна ймовірність/? (а) чи/? (Ь) по всій послі-доііпості в цілому є сталою.

і іншого боку, при /3 = 100 маємо/? (ab) = l/N = 0,1 >/? (а)р (b), (|цо даг підставу підозрювати взаємне «тяжіння» а до Ь, і навпаки. Ту і теж проглядається порушення статистичної незалежності, тобто відношення «байдужості» між повідомленнями а Ті Ь. Поява в послідовності одного з них, наприклад а, трохи 'іґшімнуг ймовірність появи повідомлення b відразу за повідомленням а% і навпаки. Проте безумовні ймовірності/? (а) тар (Ь) по послідовності в цілому теж є сталими.

Мірою порушення статистичної незалежності (стану «бай дужості») між повідомленнями а та £ є умовна ймовірність по ний повідомлення а за умови, що вже з'явилося повідомлення b p {alb), або умовна ймовірність появи повідомлення Ь, коли »«• нїлося повідомлення а: р (Ь/а), причому взагалі/? (alb) Ф

і і математичної статистики визначає умовну ймовір-

«• м .-и | >сз безумовні ймовірності/? (а),р (Ь) та сумісну безумов-и і імовірність/? (ab) за законом множення ймовірностей:

р (ab) =p(a)p (bla) =p(b)p (alb). (2.13)

Звідси випливає, що

р (bla) = p (ab) /p (a); p (alb) = p (ab) Ip (b). (2.14)

Зокрема, для статистично незалежних повідомлень а та b (див. вище) маємо

р (bla) = 0,05 / 0,25 = 0,2 = /? (b);

р (alb) = 0,05 / 0,2 = 0,25 = р (а),

міно умовні ймовірності появи повідомлень вироджуються в

І" і УМОВНІ.

35

Тоді для /3 = ЗО згідно з (2.14) знаходимо

р (Ь/а)= 0,03/0,25 = 0,12;/? (alb) = 0,03/0,2 = 0,15, (2.15)

тобто встановлений факт появи повідомлення а зменшує безумовну ймовірність р (Ь) = 0,2 до умовної ймовірності р (Ыа) = = 0,12 появи повідомлення b за умови наявного вже повідомлення а. І навпаки, факт появи повідомлення b зменшує безумовну ймовірністьр (а) = 0,25 до умовної ймовірності/? (alb) = = 0,15 появи повідомлення а за умови наявності повідомлення Ь. Як бачимо, ймовірність появи повідомлення b зменшується на 0,08, а повідомлення а — на 0,1 кожного разу, як інше з них з'явиться в послідовності.

Аналогічно стосовно наведеного вище прикладу з /3 = 100 відповідно до (2.14) маємо

р (Ыа) = 0,1/0,25 = 0,4; р (alb) = 0,1/0,2 = 0,5, (2.16)

що підкреслює згадане вище «тяжіння» а та b одне до одного через підсилення ймовірностей появи їх.

Насправді, при безумовній імовірності, скажімо,/? (Ь) = 0,2 (саме з такою ймовірністю джерело вибирає b серед інших можливих повідомлень у довгому їх ланцюзі), як тільки буде вибрано а9 ймовірність вибору b слідом різко (вдвічі в розглядуваному прикладі) підсилюється до значення умовної ймовірності /? (Ыа) = 0,4 появи повідомлення b за умови наявності повідомлення а. І навпаки, при/? (а) = 0,25 взагалі, як тільки буде виявлено повідомлення b , ймовірність появи повідомлення а слідом або поряд з b різко підсилиться до значення умовної ймовірності /? (alb) = 0,5 згідно з (2.16). Отже, при виявленні одного повідомлення ймовірність появи слідом або поряд із ним статистично зумовленого, зв'язаного повідомлення збільшується [для умов (2.16)] або зменшується [для умов (2.15)].

Ці локальні порушення ймовірностей при статистичній залежності повідомлень не можуть бути непоміченими джерелом. І воно на них реагує відповідним зменшенням або збільшенням кількості інформації в кожному такому повідомленні згідно з (2.5). Звісно й ентропія такого джерела має змінюватися належним чином, причому називається вона умовною, визначається виразом (2.6), але з урахуванням умовних імовірностей повідомлень.

Розрізняють два різновиди умовної ентропії: часткову та загальну. Першу знаходять так:

H(Albj) = ^p(ailbj)\ogp(ailbJ)J = \.J; (2.17)

z rf/H(Blai) = -Zp(bjlai)\ogp(bjlai)J = l...k, (2.18)

J 36

пс А = {a]9a29...9ai9...9ak}9B = {b{9b29 ...9bj9 ...,£,} —алфавіти повідомлень; аі — конкретне повідомлення, відносно якого ви-іначається часткова умовна ентропія Н (ВІа) алфавіту В за умови вибору попереднього повідомлення а;9 bj — конкретне повідомлення, відносно якого обчислюється часткова умовна ентропія Н (А/Ьр алфавіту А за умови вибору попереднього повідомлення b»•; / — номер повідомлення з алфавіту A;j— номер повідомлення з алфавіту В; р (alb), р (Ыа) — умовні ймовірності.

Термін «вибір попереднього» досить умовний, оскільки повідомлення а та b можуть бути рознесені в часі, але знаходитися разом у просторі (як записано вище alb чи Ыа), або бути одночасними чи майже одночасними та рознесеними в просторі (як на рис. 2.1). Ніякі обмеження на алфавіти А та В не накладаються. Вони можуть навіть збігатися (А = В). Тому можна аналізувати і враховувати взаємозв'язок між повідомленнями одного й того самого джерела в одному й тому самому алфавіті повідомлень, рознесеними в часі, але не в просторі (наприклад, на виході джерела А чи В згідно з рис. 2.1). Такі послідовності іумовлених повідомлень називаються ланцюгами Маркова [38, 46, 49].

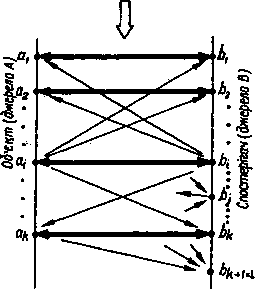

З іншого боку, алфавіти А та В можуть не збігатися (А Ф В), хоча між елементами їх може бути й відповідність. Цю ситуацію відбито на рис. 2.1, де джерело А має свою модель — ансамбль Атг.РА. Оскільки воно може мати к дискретних станів, джерело А виступає як об'єкт спостерігача В і разом із ним утворює нове джерело В, яке має свою модель — ансамбль В та Рв. Між джерелом А та спостерігачем В існує канал зв'язку, в якому діють, умовно кажучи, завади, що порушують процес вибору спостерігачем В повідомлень Ь- є В. Це, в свою чергу, порушує відповідність між повідомленнями аі є А та 6. є В.

Алфавіти АтаВ можуть бути однакового (к = І) і неоднакового (к Ф І) обсягів. Звичайно розглядають ситуації, коли к - І ибо к < І. Система спостереження зк = 1 має природне пояснення. Тут спостерігач В повинен реагувати своїм повідомленням bf (і = 1 ... І) на кожний стан джерела А, висловлений повддомлен-нмм а. (і = 1 ... к). При цьому діє принцип перетворення а{ —> Ь[9 <h ~» Ь2, ..., а і —> Ьі9 ..., ак —> Ьк, коли кожному повідомленню аі джерела А відповідає повідомлення b( джерела В. Цю модель юбражено на рис. 2.4, за винятком елемента bl із В, де / = к + 1. Ma рисунку виділено напрямки взаємооднозначної відповідно-і\\А<=>В.

Як вгадувалося вище, завади порушують вибір повідомлень hf джерелом В. За цих обставин, якщо джерелом А вибрано пев-мг повідомлення аі9 якому має відповідати повідомлення Ь- при

37

Завади j = /, TO ДЖЄрЄЛО В МОЖЄ Вибрати

будь-яке повідомлення bj при j = = 1 ... А:з імовірністю/? (bj/a), причому умовна ймовірність правильного вибору (тут воно має смисл перетворення аі -> Ь) дорівнює р (btla). Решта виборів будуть помилковими з умовними ймовірностями р (bj/a) при j Ф і. Це дає змогу дослідити систему спостереження, передачі, перетворення, збирання, збереження інформації з боку спостерігача В.

Рис. 2.4

Водночас таку систему можна дослідити з позицій спостерігача В. Для цього потрібно знати факт вибору джерелом В певного повідомлення bj. Після встановлення такого факту можна з умовною ймовірністю/? (я/6) сказати, що об'єкт А знаходиться в стані аг Це твердження може бути правильним при / =j або неправильним при / Ф].

Існують певні ситуації, за яких систему доводиться ускладнювати, вибираючи / > к (частіше / = к + 1, див. рис. 2.4). При цьому повідомлення Ь[ не відповідає ніякому повідомленню аі (і ФІ),з.є ознакою та повідомленням про особливий стан спостерігача В, який відмовляється від вибору якогось певного повідомлення bj (j = 1 ... к) у відповідь на повідомлення я,- (і = 1 ... к). Цей стан спостерігача називається стиранням повідомлення. Відбувається воно з умовною ймовірністю/? (Ь^а), якщо стан я;. джерела А відомо. Якщо ж, навпаки, відомим є стан стирання повідомлення bf джерела В, то з умовною ймовірністю/? (я/6/) можна вважати, що джерело А знаходилося в стані я.. Коли ж / = 1 ... к тау' = 1 ... ... к, все відбувається аналогічно вищерозглянутій моделі без Ь{ = = Ьк+Х у складі джерела В, тобто коли / = к.

Згадаємо ще також про те, що крім статистичного зв'язку між парами повідомлень у довгих послідовностях (рознесення в часі) або в складених системах (рознесення в просторі) часто спостерігається статистичний зв'язок між трьома, чотирма й більше повідомленнями, що зумовлює наявність умовної ентропії більш високого порядку [3, 42].

Тепер повернемося знову до часткової умовної ентропії і будемо дотримуватися моделі системи спостереження, показаної на рис. 2.4 без стирання, тобто коли / = к. Звернемося до фізичного змісту умовної ентропії. Як і при визначенні безумовної ентропії, часткова умовна ентропія є математичним сподіванням значення р (а(/Ьр або/? (bj/a). Це поняття відбиває середню за повним алфа-

вітом кількість інформації, що припадає на одне повідомлення цього алфавіту (джерела). Тому Н (АІЬр в (2.17) є питомою кількістю інформації джерела А за умови, що вже встановлено, факт вибору джерелом В певного повідомлення bj, H (В/а) в (2.18) — питомою кількістю інформації джерела В за умови, що вже відомо стан джерела А. Іншими словами, Н (Alb) — це середня кількість інформації, яка містилася в будь-якому повідомленні джерела А, якщо джерело В вибрало повідомлення bj (j = 1 ... к), а Н (В/а) — середня кількість інформації, здобутої після вибору джерелом В будь-якого свого повідомлення, коли відомо, що джерело А знаходилося в стані я; (/ = 1 ... к). Часткова умовна ентропія визначається як статистичне усереднення за методом зваженої суми (2.17), (2.18) по індексу і= 1 ... А:абоу= 1 ...& відповідно. Ураховуючи викладене вище, загальну умовну ентропію можна визначити так: якщо часткова умовна ентропія джерела А відносно конкретного повідомлення bj дорівнює Н (Alb), a розподіл імовірностей Рв джерела В задано ансамблем Візгв = = {р (Ь\\ .-,/? (Ь), ...,/? (Ьк)}, то цілком природно обчислити середнє по j значення Н (A/bj) за всіма у як статистичне усереднення методом зваженої суми, тобто

H(A/B) = Zp(bj)H(A/bj), (2.19)

J де Я (А І В) — загальна умовна ентропія джерела А відносно

джерела В. Це питома (середньостатична) кількість інформації, що припадає на будь-яке повідомлення джерела А, якщо відомо його статистичну взаємозалежність із джерелом В.

Аналогічно (2.19) загальна умовна ентропія джерела В відносно джерела А визначається виразом

Н(ВІА) = ^р(аі)Н(В/аі), (2.20)

і

що є питомою (середньостатичною) кількістю інформації, яка припадає на будь-яке повідомлення джерела В, якщо відомо його статистичну взаємозалежність із джерелом А.

Вирази (2.19) і (2.20) є операціями згортки за індексом, внаслідок якої операція (2.19) «поглинає» індексу, а операція (2.20) — Індекс і.

З урахуванням (2.13), (2.17), (2.18) вирази (2.19) і (2.20) набувають вигляду

H(A/B) = -Zp(bj)Zp(ai/bj)\ogp(ai/bJ) =

j і

= -2 S P(bj)P(<*i I bj) log p(a • /bj)= (2.21)

= -llp(ai/bj)\ogp(ai/bj);

J і

38

39

р(ахІЬх)

р(ах/Ь2)

... p(ax/bj)

... р(ах/Ьк)

■ . р(а2ІЬк)

(2.22)

(2.23)

• J

^-TLPifiilbnbgpibjIa,).

' J

Р(В/А) =

Загалом статистична залежність джерела В від джерела А відбивається матрицею прямих переходів повідомлень аі (і = 1 ... к) джерела А в повідомлення Ь- (/ = 1 ... А:) джерела В:

А |

"~ в |

Ь\ 1 *>2 І"- | bj 1-І 6* |

|

в, \а2 \аі |

р(Ьх1а^ р(Ь2Іа{) ... pibjla^ ... /> (Vai)| |

р (6,/а2) pjfij/a^ ... p(bjla2) ... р(ЬкІа2)\ рф./а) рЩа) ... р (bj/a,) ... РФкШ РФМ) рФ21ак) ... р(Ь/ак) ... р (Ьк1ак)\ |

На головній діагоналі цієї матриці розміщено умовні ймовірності прямої відповідності типу ах —> 6,, ..., ак —> Ьк, які характеризують правильний вибір джерелом В своїх повідомлень (тобто відповідно до повідомлень джерела А). Решта ймовірностей відповідають неправильному вибору повідомлень джерелом В.

Матриця (2.23) відбиває вплив завад у каналі між джерелом А та спостерігачем В (див. рис. 2.1). Якщо завади непомітні або зовсім відсутні, то маємо однозначну відповідність а( —> Ь{ з умовної ймовірності р (Ь^а,) = 1 для / = 1 ... к. Решта ймовірностей р (bJaj) = 0 для всіх j Ф і.

Кожний рядок у (2.23) є спотвореним розподілом імовірностей Рв появи повідомлення bj є В. Джерело В має розподіл безумовних імовірностей Рв. Врахування статистичного впливу повідомлення а і є А спотворює цей розподіл (або уточнює його) і дає новий розподіл імовірностей Р (2?/д,) для /-го рядка матриці. Саме тому виконується закон нормування

j Статистична залежність джерела А від джерела В відбивається матрицею зворотних переходів типу а{ <— Ьр складеною з умовних імовірностей р (ctj/b):

40

Р(А/В) =

р(а,/Ьк) . р(акІЬк)

p(a2/bx) p(a2/b2) ... p(a2/bj) р{а])ьх) p(ai)b1) ... Piajbj)

(2.25)

[р(ак lbx) p{aklb2) ... р(ак /bj) . = P(Albj),i=l...k.

Вона відображає к розміщених стовпцями варіантів спотворених первинних розподілів імовірностей ансамблю А:, які відчувають на собі статистичний вплив повідомлень b} (J' - 1 ... к), вибраних джерелом В. Саме тому для кожного такого розподілу

(2.26)

lp(ai/bj)^\J=l...k.

Таким чином, якщо задано ансамбль А та матрицю прямих переходів (2.23), то, враховуючи (2.13), можна знайти сумісні безумовні ймовірності р (я,, Ь) = р фр я,), взявши з ансамблю А безумовні ймовірності РА = {р (а,)}, і = 1 ... к. Виконавши згортку по і, дістанемо такий розподіл безумовних імовірностей PB=ip(bp}J=l...k:

(2.27)

p(bJ) = Yp(aibjlJ=l...k.

Звідси за формулою, подібною до (2.8), визначаємо безумовну ентропію

Н(В) = -tpibjVogpibj). (2.28)

Звичайно, цю ентропію можна знайти безпосередньо за (2.8), скориставшись значенням/? (я,) з ансамблю А. У мовні ентропії як часткові, так і загальні можна визначити за наявними даними {р (д.)}, {р (bJa)} та/?(яД). Взагалі треба виділити розподіл сумісних імовірностей Р(А,В)=[р (я,, *,)}, за яким можна дістати розподіл Рв згорткою по і (2.27), або розподіл РА згорткою за j:

p(ai)=ip(aibJ),i=l...k, (2.29)

7=1

після чого легко знайти розподіли умовних імовірностей для матриць (2.23) та (2.25) на підставі (2.14). Маючи ці дані, можна визначити всі розглянуті різновиди ентропії: Я (А) за (2.8), // (В) за (2.28), Я (АІЬ) за (2.17), Я (ВІа) за (2.18), Я (А/В) за (2.21)іЯ(/3/Л)за(2.22).

41

(2.30)

Нехай задано таку матрицю Р (а.у bp сумісних імовірностей появи повідомлень двох джерел А та В (див. рис. 2.1) з алфавітами а. та Ь, де / = 1,2, Зтау=1,2,3(А; = /=3):

ОД 0

0 0,1 ОД 0,1

J 1

2. З

P(ahbj)=

0,1 0,1 ОД

1 2 З

Оскільки р (ab) -нормування

- безумовні ймовірності, для них виконується закон

X !>(*/*/) = 1. /=іу=1

0 + | + | = | = l = p(^/62) + /?(a2/62) + /?(a3/^2) приу = 2;

0,25 + 0,25 + 0,5 = | = 1 = /?(д1/63) + /?(а2^з) + /7(а3/^з) ПРИУ = 3-Отже, кожний рядок (2.33) є розподілом повідомлень я., спотвореним Через статистичний вплив повідомлень be В [пор. із (2.32)]:

ОД 0 0,1

J 1

\2 =

з

"2/3 0 0,25

0 2/3 0,25

1/3 1/3 0,5

0,3 0,3 0,4

p(bj/ai) =

(2.34)

J)_ ОД ^1_

0,3 0,3 0,4

0,1 0?j_ ОД

L0,3 0,3 0,4 J

1 2 З

(2.31)

(2.33)

0,2 + 0 + 0,1 = 0,3 = /? (£,) приу = 1; 0 + 0,2 + 0,1 = 0,3 = р ф2) приу = 2; 0,1 + 0,1 + 0,2 = 0,4 = /? (63) приу = 3.

Перевіримо нормування:

р (Ь})+р(Ь2) +p(b3) = 0,3 + 0,3 + 0,4 = 1.

Окрема згортка по стовпцях (за у) без зміни / «поглинає» алфавіт Ь і дає безумовну ймовірність/? (я.), тобто ймовірнісну міру для джерела А:

(2.32)

0,2 + 0 + 0,1 =0,3=/? (а,) при /= 1; 0 + 0,2 + 0,1 = 0,3 =/? (а2) при і = 2;

0,1 + 0,1 + 0,2 = 0,4 =/? (я3) при /: Перевіряємо нормування:

/? (ах) + /? (я2) + р (а3) = 0,3 + 0,3 + 0,4 = 1. З урахуванням (2.14) на підставі (2.30) дістаємо таку матрицю умов-

них імовірностей:

0,2 0 0,1

2/3 0 1/3' |

У 1 |

0 2/3 1/3 |

2 |

0,25 0,25 0,5 |

3 |

ojojoj

м-/^)=

0,3 0,3 0,3

од_^од

L0,4 0,4 0,4. 1 2 З

Перевірка на виконання закону нормування (2.26) дає позитивну відповідь, тобто

І+0+з" = І = 1 = Р(а\,ьО+Р(а2/ьО + Р(аз/ьО приу= 1; ,

Перевірка виконання закону нормування (2.24) дає позитивну відповідь, тобто

2/3 + 0 + 1/3 = З/З = 1 = р (bja) + p (b2lax) + p (bja) при і =1; 0 + 2/3+1/3 = 3/3 = 1=/? (bja2) + /? (b2/a2) + p (b3la2) при і =2; 0,25 + 0,25 + 0,5 = 1 = р (Z?,/a3) + p (bja3) + /? ф3/аъ) при і =3.

Таким чином, кожний стовпець (2.34) є розподілом повідомлень Ь., спотвореним через статистичний вплив повідомлень а. є А [пор. із (2.31)]. Тепер, маючи дані (2.32), за (2.8) розрахуємо безумовну ентропію джерела А:

Я (А)= -(0,3 log 0,3 + 0,3 log 0,3 + 0,4 log 0,4)= = 1,57095 біт/повідомлення.

Аналогічно, маючи дані (2.31), за (2.28) обчислимо безумовну ентропію джерела В:

Я (В) = -(0,3 log 0,3 + 0,3 log 0,3 + 0,4 log 0,4) = = 1,57095 біт/повідомлення.

У розглядуваному прикладі Я (В) = Н (А) тому, що збігаються розподіли безумовних імовірностей. До речі, максимального значення Я (А) та И (В) досягли б при рівноймовірному розподілі ймовірностей, тобто при р (а) = 1/3 та/? (/?.) = 1/3 для і J є {1, 2, 3}.

Тоді було б

"шах И) = "max (*) = -lOg (1/*) = lOg к = log 3 =

= 1,58496 біт/повідомлення.

Як бачимо, максимальна ентропія перевищує значення безумовної ентропії при нерівномірному розподілі ймовірностей.

Часткова умовна ентропія джерела А за (2.17) з урахуванням (2.33) становитиме

Я {АІЬХ) = -[(2/3) log (2/3) + 0 log 0 + (1/3) log (1/3)] = 0,91829 біт/повідомлення;

42

43

H

(A/b2)

=

-[0 log

0

+ (2/3) log

(2/3)

+ (1/3) log

(1/3)]

= = 0,91829

біт/повідомлення;

H

(A/b2)

=

-[0 log

0

+ (2/3) log

(2/3)

+ (1/3) log

(1/3)]

= = 0,91829

біт/повідомлення;

H (A/b2) = -(0,25 log 0,25 + 0,25 log 0,25 + 0,5 log 0,5) =

= 1,5 біт/повідомлення.

Загальна умовна ентропія джерела А відносно джерела В згідно з (2.19) або (2.21)

Н (А/В) = 0,3 Н (Afbx) + *0,3 Я (А/Ь2) + 0,4 Я (А1ЪЪ) = = 2-0,3 0,91829 + 0,4 ■ 1,5 = 1,15097 біт/повідомлення.

Часткова умовна ентропія джерела В за (2.18) з урахуванням (2.34) становитиме

Я (В/е,) = -[(2/3) log (2/3) + 0 log 0 + (1/3) log (1/3)] =

= 0,91829 біт/повідомлення;

Я (В/а2) = -[0 log 0 + (2/3) log (2/3) + (1/3) log (1/3)] =

= 0,91829 біт/повідомлення;

Я\ВІаг) = -(0,25 log 0,25 + 0,25 log 0,25 + 0,5 log 0,5) =

= 1,5 біт/ повідомлення.

Загальна умовна ентропія джерела В відносно джерела А згідно з (2.20) або (2.22)

Н\ВІА) = 0,3 • 2 • 0,91829 + 0,4 • 1,5 = 1,15097 біт/повідомлення.

Відзначимо окремо такі властивості умовної ентропії:

1. Якщо джерела повідомлень Атз.В статистично незалежні, то умовна ентропія джерела А відносно джерела В дорівнює безумовній ентропії джерела А й навпаки:

Н(А/В) = Н(А);Н(В/А) = Н(В).

2. Якщо джерела повідомлень А та. В настільки статистично взаємозв'язані, що виникнення одного з повідомлень спричи нює безумовну появу іншого, то умовні ентропії їх дорівнюють нулю:

Н(А/В) = Н(В/А) = 0.

Ентропія джерела взаємозалежних повідомлень (умовна ентропія) менша від ентропії джерела незалежних повідомлень (безумовна ентропія).

Максимальну ентропію мають джерела взаємонезалежних рівноимовірних повідомлень, умовна ентропія яких дорівнює нулю, а ймовірність появи символів алфавіту р = \/к, де к — кількість повідомлень в алфавіті.