- •1 Задачи анализа;

- •2 Задачи синтеза;

- •3 Задачи идентификации.

- •Основные задачи теории кс

- •1. Задачи анализа;

- •2. Задачи синтеза;

- •3. Задачи идентификации.

- •2. Высокой интенсивностью взаимодействия и вытекающим отсюда требованием уменьшения времени ответа.

- •Функционирование кс

- •Основные задачи теории вычислительных систем

- •Общая характеристика методов теории вычислительных систем

- •3. Классификация вычислительных систем

- •Характеристики производительности и надежности кс

- •Характеристики надежности кс

- •1 Холодное резервирование. Работает только основной канал.

- •2 Нагруженный резерв. Включены оба канала (резервный канал занимается посторонними задачами). Время перехода на основную задачу меньше чем в холодном резерве.

- •Общая характеристика методов теории вычислительных систем

- •Характеристики производительности кс

- •1. Номинальная производительность ;

- •2. Комплексная производительность ;

- •3. Пакеты тестовых программ spec XX

- •Характеристики надежности кс

- •1 Холодное резервирование. Работает только основной канал.

- •2 Нагруженный резерв. Включены оба канала (резервный канал занимается посторонними задачами). Время перехода на основную задачу меньше чем в холодном резерве.

- •4) Указывается начальное состояние системы;

- •8) Находятся показатели качества вс на основе найденных вероятностей состояния системы.

- •Анализ надежности кс со сложной структурой

- •2.Расчет надежности кс

- •2. Для каждой вершины можно вычислить среднее количество попаданий вычислительного процесса в эту вершину по формуле

- •1. Разбить множество операторов на классы:

- •Модели вычислительных систем как систем массового обслуживания

- •1 Общие понятия и определения

- •Например m/m/1

- •2 Параметры систем массового обслуживания

- •Модели массового обслуживания вычислительных систем|

- •1. Представление вычислительной системы в виде стохастической сети

- •2. Потоки заявок

- •3. Длительность обслуживания заявок

- •Характеристики одноканальных смо

- •Многопроцессорные системы

- •5. Характеристики бесприоритетных дисциплин обслуживания

- •1) В порядке поступления (первой обслуживается заявка, поступившая раньше других);

- •2) В порядке, обратном порядку поступления заявок (первой обслуживается заявка, поступившая позже других);

- •3) Наугад, т. Е. Путем случайного выбора из очереди.

- •6. Характеристики дисциплины обслуживания с относительными приоритетами заявок

- •3.8. Характеристики дисциплин обслуживания со смешанными приоритетами

- •§ 3.9. Обслуживание заявок в групповом режиме

- •§ 3.10. Смешанный режим обслуживания заявок

- •§ 3.11. Диспетчирование на основе динамических приоритетов

- •§ 3.12. Оценка затрат на диспетчирование

- •1.Определяется интенсивность потока заявок I в смо Si из системы алгебраических уравнений

- •2.Вычисляются коэффициенты передач для каждой смо

- •3.Определяется среднее время обслуживания Ui заявки в смо Si :

- •6.Для моделирующей сети в целом характеристики п.5 определяются как

- •2.Расчет характеристик мультипроцессорной системы

- •1) Имеет доступ к общей памяти;

- •1.Средняя длина очереди заявок, ожидающих обслуживания в системе:

- •3. Среднее время пребывания заявок в системе :

- •Основные задачи теории кс

- •1. Задачи анализа;

- •2. Задачи синтеза;

- •3. Задачи идентификации.

- •1) С неограниченным временем пребывания заявок;

- •2) С относительными ограничениями на время пребывания заявок;

- •3) С абсолютными ограничениями на время пребывания заявок;

- •2.4. Контроллеры и сетевые комплексы ge Fanuc

- •Модели 311,313/323, 331

- •Коммуникационные возможности серии 90-30

- •2.4.3. Контроллеры VersaMax

- •2.4.4. Программное обеспечение

- •Общая характеристика протоколов и интерфейсов асу тп

- •2. Протоколы и интерфейсы нижнего уровня.

- •2. Основные технические характеристики контроллеров и программно-технических комплексов

- •Требования к корпоративной сети

- •2) Одновременное решение различных задач или частей одной задачи;

- •3) Конвейерная обработка информации.

- •1. Суть проблемы и основные понятия

- •1.1 Главные этапы распараллеливания задач

- •1.2 Сведения о вычислительных процессах

- •1.3 Распределенная обработка данных

- •1. Классификации архитектур параллельных вычислительных систем

- •1.1 Классификация Флинна

- •1. Процессоры

- •Память компьютерных систем

- •Простые коммутаторы

- •Простые коммутаторы с пространственным разделением

- •Составные коммутаторы

- •Коммутатор Клоза

- •Баньян-сети

- •Распределенные составные коммутаторы

- •Коммутация

- •Алгоритмы выбора маршрута

- •Граф межмодульных связей Convex Exemplar spp1000

- •Граф межмодульных связей мвс-100

- •3. Граф межмодульных связей мвс-1000

- •1. Построения коммуникационных сред на основе масштабируемого когерентного интерфейса sci

- •2. Коммуникационная среда myrinet

- •3. Коммуникационная среда Raceway

- •4. Коммуникационные среды на базе транспьютероподобных процессоров

- •1. Структура узла

- •2. Пакеты и свободные символы

- •3. Прием пакетов

- •4. Передача пакетов

- •5. Управление потоком

- •1. Структура адресного пространства

- •2. Регистры управления и состояния

- •3. Форматы пакетов

- •Когерентность кэш-памятей

- •1. Организация распределенной директории

- •2. Протокол когерентности

- •3. Алгоритм кэширования.

- •1 . Основные характеристики

- •1.2. Происхождение

- •1.3. Механизм когерентности

- •1. 4. Предназначение

- •1. 5. Структура коммуникационных сред на базе sci

- •1. 6. Физическая реализация

- •1. 7. Обозначение каналов

- •2. Реализация коммуникационной среды

- •2.1. На структурном уровне коммуникационная среда состоит из трех компонентов, как показано на рис. 2.1:

- •Масштабируемый когерентный интерфейс sci

- •Сетевая технология Myrinet

- •Коммуникационная среда Raceway

- •Коммуникационные среды на базе транспьютероподобных процессоров

- •1.Информационные модели

- •1.2. Мультипроцессоры

- •1.3. Мультикомпьютеры

- •Сравнительный анализ архитектур кс параллельного действия.

- •Архитектура вычислительных систем

- •Smp архитектура

- •Симметричные мультипроцессорные системы (smp)

- •Mpp архитектура

- •Массивно-параллельные системы (mpp)

- •Гибридная архитектура (numa)

- •Системы с неоднородным доступом к памяти (numa)

- •Pvp архитектура

- •Параллельные векторные системы (pvp)

- •1. Системы с конвейерной обработкой информации

- •1.2 Мультипроцессоры uma с много- ступенчатыми сетями

- •Мультипроцессоры numa

- •Мультипроцессор Sequent numa-q

- •Мультикомпьютеры с передачей сообщений

- •1. Общая характеристика кластерных систем.

- •2.Особенности построения кластерных систем.

- •Планирование работ в cow.

- •Без блокировки начала очереди (б); заполнение прямоугольника «процессоры-время» (в). Серым цветом показаны свободные процессоры

- •Общие сведения

- •Общие сведения

- •Логическая структура кластера

- •Логические функции физического узла.

- •Устройства памяти

- •Программное обеспечение

- •Элементы кластерных систем

- •1.1. Характеристики процессоров

- •Рассмотрим в начале процессор amd Opteron/Athlon 64.

- •Примеры промышленых разработок

- •Кластерные решения компании ibm

- •Диаграмма большого Linux-кластера.

- •Аппаратное обеспечение

- •Вычислительные узлы, выполняющие основные вычислительные задачи, для которых спроектирована система.

- •Программное обеспечение

- •Кластерные решения компании hp

- •Кластерные решения компании sgi

- •Производительность операций с плавающей точкой

- •Производительность памяти

- •Производительность системы ввода/вывода Linux

- •Масштабируемость технических приложений

- •Системное программное обеспечение

- •Архитектура san

- •Компоненты san

- •Примеры решений на основе san

- •San начального уровня

- •San между основным и резервным центром

- •Практические рекомендации

- •Построение san

- •Заключение

- •Принципы построения кластерных архитектур.

- •Оценки производительности параллельных систем

- •1) Имеет доступ к общей памяти;

- •2) Имеет общий доступ к устройствам ввода-вывода;

- •3) Управляется общей операционной системой, которая обеспечивает требуемое взаимодействие между процессорами и выполняемыми им программами как на аппаратном, так и на программном уровне.

- •4 Вероятность того, что в момент поступления очередной заявки все n процессоров заняты обслуживанием

- •Выбор коммутационного компонента.

- •Проблема сетевой перегрузки.

- •1. Обзор современных сетевых решении для построения кластеров.

- •1000-Мега битный вариант Ethernet

- •Организация внешней памяти

- •Эффективные кластерные решения

- •Концепция кластерных систем

- •Разделение на High Avalibility и High Performance системы

- •3. Проблематика High Performance кластеров

- •Проблематика High Availability кластерных систем

- •Смешанные архитектуры

- •6.Средства реализации High Performance кластеров

- •7.Средства распараллеливания

- •8.Средства реализации High Availability кластеров

- •9.Примеры проверенных решений

- •Архитектура san

- •Компоненты san

- •Примеры решений на основе san

- •San начального уровня

- •San между основным и резервным центром

- •Практические рекомендации

- •Построение san

- •Заключение

- •Symmetrix десять лет спустя

- •Матричная архитектура

- •Средства защиты данных

- •Ревизионизм и фон-неймановская архитектура

- •Литература

- •Связное программное обеспечение для мультикомпьютеров

- •1. Синхронная передача сообщений.

- •2. Буферная передача сообщений.

- •Планирование работ в cow

- •Средства распараллеливания

- •7.Средства распараллеливания

- •2. Кластерн ый вычислительн ый комплекс на основе интерфейса передачи сообщений

- •2.2 Программная реализация интерфейса передачи сообщений

- •2.3 Структура каталога mpich

- •2.4 «Устройства» mpich

- •2.5 Выполнение параллельной программы

- •2.6 Особенности выполнения программ на кластерах рабочих станций

- •2.7 Тестирование кластерного комплекса

- •Параллельная виртуальная машина

- •3 Кластерн ый вычислительн ый комплекс на основе пАраллельной виртуальной машины

- •3.1 Параллельная виртуальная машина

- •3.1.1 Общая характеристика

- •3.1.2 Гетерогенные вычислительные системы

- •3.1.3 Архитектура параллельной виртуальной машины

- •3.2 Настройка и запуск параллельной виртуальной машины

- •3.3 Структура каталога pvm

- •3.4 Тестирование параллельной виртуальной машины

- •На рисунке 3.2 представлена диаграмма, отображающая сравнение производительности коммуникационных библиотек mpi и pvm.

- •3.5 Сходства и различия pvm и mpi

- •4 . Кластерн ый вычислительн ый комплекса на основе программного пакета openMosix

- •4.1 Роль openMosix

- •4.2 Компоненты openMosix

- •4.2.1 Миграция процессов

- •4.2.2 Файловая система openMosix (oMfs)

- •4.3 Планирование кластера

- •4.4 Простая конфигурация

- •4.4.1 Синтаксис файла /etc/openmosix.Map

- •4.4.2 Автообнаружение

- •4. 5. Пользовательские утилиты администрирования openMosix

- •4. 6. Графические средства администрирования openMosix

- •4. 6.1 Использование openMosixView

- •4. 6.1.2 Окно конфигурации. Это окно появится после нажатия кнопки “cluster-node”.

- •4. 6.1.3 Окно advanced-execution. Если нужно запустить задания в кластере, то диалог "advanced execution" может сильно упростить эту задачу.

- •4.6.1.4 Командная строка. Можно указать дополнительные аргументы командной строки в поле ввода вверху окна. Аргументы приведены в таблице 9.2.

- •4. 6.2.2 Окно migrator. Этот диалог появляется, если кликнуть на каком-либо процессе из окна списка процессов.

- •4. 6.2.3 Управление удалёнными процессами. Этот диалог появляется при нажатии кнопки “manage procs from remote”

- •4.5.3 Использование openMosixcollector

- •4. 6.4 Использование openMosixanalyzer

- •4. 6.4. 1 Окно load-overview. Здесь отображается хронология нагрузки openMosix.

- •4. 6.4. 2 Статистическая информация об узле

- •4.5.4.3 Окно memory-overview. Здесь представляется обзор использования памяти (Memory-overview) в openMosixanalyzer.

- •4. 6.4.4 Окно openMosixhistory

- •4. 6.5 Использование openMosixmigmon

- •4.6 Список условных сокращений

- •Перечень ссылок

- •Общие сведения

- •2. Создание Windows-кластера

- •Суперкомпьютерная Программа "скиф"

- •Описание технических решений

- •Направления работ

- •Основные результаты

- •Кластер мгиу

- •Содержание

- •Понятие о кластере

- •Аппаратное обеспечение

- •Пропускная способность и латентность

- •1. Определение распределенной системы

- •2.1. Соединение пользователей с ресурсами

- •2.2. Прозрачность

- •Прозрачность в распределенных системах

- •2.3. Открытость

- •2.4. Масштабируемость

- •3.1. Мультипроцессоры

- •3.2. Гомогенные мультикомпьютерные системы

- •3.3. Гетерогенные мультикомпьютерные системы

- •4. Концепции программных решений рс

- •4.1. Распределенные операционные системы

- •4.2. Сетевые операционные системы

- •4.3. Программное обеспечение промежуточного уровня

- •5. Модель клиент-сервер рс

- •5.1. Клиенты и серверы

- •5.2. Разделение приложений по уровням

- •5.3. Варианты архитектуры клиент-сервер

- •Формы метакомпьютера

- •Настольный суперкомпьютер.

- •2. Интеллектуальный инструментальный комплекс.

- •Сетевой суперкомпьютер.

- •Проблемы создания метакомпьютера

- •Сегодняшняя архитектура метакомпьютерной среды

- •Взаимосвязь метакомпьютинга с общими проблемами развития системного по

- •5. Модель клиент-сервер рс

- •5.1. Клиенты и серверы

- •5.2. Разделение приложений по уровням

- •5.3. Варианты архитектуры клиент-сервер

- •Symmetrix десять лет спустя

- •Матричная архитектура

- •Средства защиты данных

- •Ревизионизм и фон-неймановская архитектура

- •Однородные вычислительные среды

- •Однокристальный ассоциативный процессор сам2000

- •Модели нейронных сетей

- •Модели инс

- •Оптимизационные системы.

- •Неуправляемые системы распознавания образов.

- •Системы feed forward.

- •Элементы нейрологики с позиции аппаратной реализации

- •Реализация нейронных сетей

- •Программные нейрокомпьютеры

- •Программно-аппаратные нейрокомпьютеры

- •Практическое использование инс

Требования к корпоративной сети

Удаленный сбор информации.

Обработка данных.

Сетевое хранение данных и сетевая печать.

Обмен информацией между рабочими станциями.

Требуется централизованное управление, безопасность.

Требуется доступ к специализированным серверам.

Используется объединенная сеть и требуется доступ к глобальной сети.

Возможность ведения архивов и восстановление данных в случае разрушения БД после сбоев.

ПАРАЛЛЕЛЬНАЯ ОБРАБОТКА ИНФОРМАЦИИ

Один из основных факторов, определяющих развитие вычислительной техники в целом и вычислительных систем в частности,—это высокая производительность. Общий метод увеличения производительности — организация параллельной обработки информации, т. с. одновременное решение задач или совмещение во времени этапов решения одной задачи.

Способы организации. Во всем многообразии способов организации параллельной обработки можно выделить три основных направления:

1) совмещение во времени различных этапов разных задач;

2) Одновременное решение различных задач или частей одной задачи;

3) Конвейерная обработка информации.

Первый путь — совмещение во времени этапов решения разных задач—это мультипрограммная обработка информации. Мультипрограммная обработка возможна даже в однопроцессорной ЭВМ и широко используется в современных СОД.

Второй путь — одновременное решение различных задач или частей одной задачи — возможен только при наличии нескольких обрабатывающих устройств, При этом используются те или иные особенности задач или потоков задач, что позволяет осуществить тот или иной параллелизм. Можно выделить несколько типов параллелизма, отражающих эти особенности.

Естественный параллелизм независимых задач заключается в том, что в систему поступает непрерывный поток не связанных между собой задач, т. е. решение любой задачи не зависит от результатов решения других задач. В этом случае использование нескольких обрабатывающих устройств при любом способе ком-плексирования (косвенном или прямом) повышает производительность системы.

Параллелизм независимых ветвей — один из наиболее распространенных типов параллелизма в обработке информации. Суть его заключается в том, что при решении большой задачи могут быть выделены отдельные независимые части—ветви программы, которые при наличии нескольких обрабатывающих устройств могут выполняться параллельно и независимо друг от друга.

Двумя независимыми ветвями программы будем считать такие части задачи, при выполнении которых выполняются следующие условия:

ни одна из входных для ветви программы величин не является выходной величиной другой программы (отсутствие функциональных связей);

для обеих ветвей программы не должна производиться запись в одни и те же ячейки памяти (отсутствие связи по использованию одних и тех же полей оперативной памяти);

условия выполнения одной ветви не зависят от результатов или признаков, полученных при выполнении другой ветви (независимость по управлению);

обе ветви должны выполняться по разным блокам программы (программная независимость).

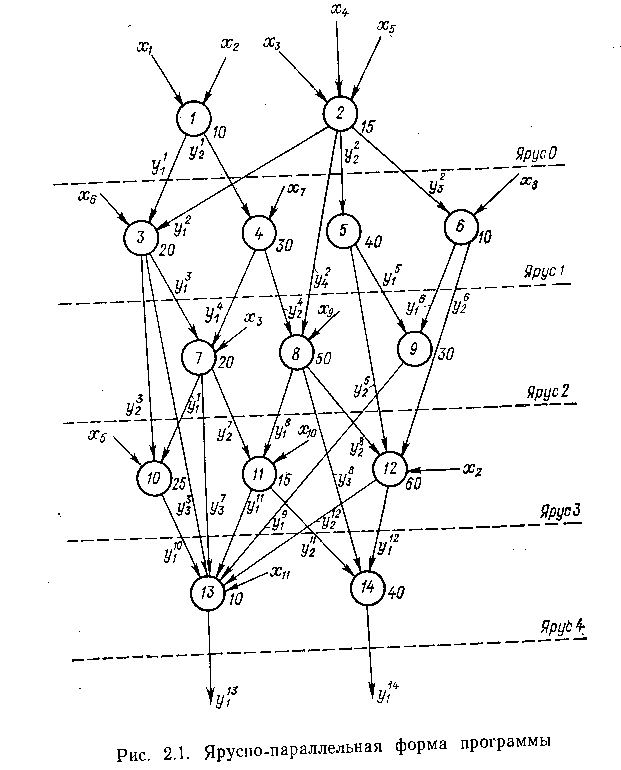

Хорошее представление о параллелизме независимых ветвей дает ярусно-параллельная форма программы, пример которой приведен на рис. 2.1. Программа представлена в виде совокуп-

нести ветвей, расположенных в нескольких уровнях — ярусах. Кружками с цифрами внутри обозначены ветви. Длина ветви представляется цифрой, стоящей около кружка. Стрелками показаны входные данные и результаты обработки. Входные данные обозначаются символом х, выходные данные — символом у. Символы х имеют нижние цифровые индексы, означающие номера входных величин; символы у имеют цифровые индексы и внизу и вверху:

цифра вверху соответствует номеру ветви, при выполнении которой получен данный результат, а цифра внизу означает порядковый номер результата, полученного при реализации данной ветви программы.

Изображенная на рисунке программа содержит 14 ветвей, расположенных на 5 ярусах. Ветви каждого яруса не связаны друг с другом, т. е. результаты решения какой-либо ветви данного пруса не являются входными данными для другой ветви этого же яруса. На этом же графе могут быть изображены и связи по управлению или памяти. В этом случае граф позволяет наглядно показать полностью независимые ветви. Для простоты изображения мы этого не делаем,

На примере этой, в общем достаточно простой программы, можно выявить преимущества вычислительной системы, включающей несколько обрабатывающих устройств, и проблемы, которые при этом возникают.

Примем, что длина i-й ветви представляется числом временных единиц ti, которые требуются для ее исполнения. Тогда нетрудно подсчитать, что для исполнения всей программы потребуется

Т =435единиц времени. Если представить, что программа

выполняется двумя обрабатывающими устройствами, работающими независимо друг от друга, то время решения задачи сократится. Однако это время, как нетрудно видеть, будет различным в зависимости от последовательности выполнения независимых ветвей.

Таким образом, для того чтобы с помощью нескольких обрабатываюших устройств решить задачу, имеющую независимые параллельные ветви, необходима соответствующая организация процесса, которая определяет пути решения задачи и вырабатывает необходимую информацию о готовности каждой ветви.

Заметим, что все это относительно легко реализовать тогда, когда известна достаточно точно длительность выполнения каждой ветви. На практике это бывает крайне редко: в лучшем случае известна приближенная длина ветвей. Поэтому организация оптимального или близкого к оптимальному графика работы является достаточно сложной задачей.

Заметим, что, как правило, трудно избежать некоторых простоев, которые возникают из-за отсутствия исходных данных для выполнения той или иной ветви. Все это приводит в конечном счете к тому, что выигрыш в производительности системы несколько снижается. Следует отметить также и определенные сложности, связанные с выделением независимых ветвей при разработке программ. Вместе с тем при решении многих сложных задач только программирование с выделением независимых ветвей позволяет существенно сократить время решения. В частности, хорошо поддаются параллельной обработке такого типа задачи матричной алгебры, линейного программирования, спектральной обработки сигналов, прямые и обратные преобразования Фурье и др.

Параллелизм объектов или данных имеет место тогда, когда по одной и той же (или почти по одной и той же) программе должна обрабатываться некоторая совокупность данных, поступающих в систему одновременно.

Это могут быть, например, задачи обработки сигналов от ра-диолокационной станции: все сигналы обрабатываются по одной- и той же программе. Другой пример — обработка информации от датчиков, измеряющих одновременно один и тот же параметр и установленных на нескольких однотипных объектах. Программы обработки данных могут быть различного объема и сложности, начиная от очень простых, содержащих несколько операций, до больших программ в сотни и тысячи операций.

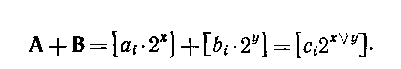

Это могут быть и чисто математические задачи, например задачи векторной алгебры — операции над векторами и матрицами, характеризующиеся некоторой совокупностью чисел. Решение задачи при этом в значительной степени сводится к выполнению одинаковых операций над парами чисел двух аналогичных объектов. Так, например, сложение, двух матриц заключается в сложении соответствующих элементов этих матриц:

Третий путь параллельной обработки информации — конвейерная обработка — может быть реализован в системе и с одним процессором, разделенным на некоторое число последовательно включенных операционных блоков, каждый из которых специализирован на выполнении строго определенной части операции. При этом процессор работает таким образом: когда 1-й операционный блок выполняет (-ю часть /-и операции, (1—1)-й операционный блок выполняет (i-l)-ro часть и+1)-й операции, а ((+1)-й

операционный блок выполняет (i+1) -ю часть 0"—1) -и операции. В результате образуется своего рода конвейер обработки, который хорошо может быть проиллюстрирован следующим простым примером.

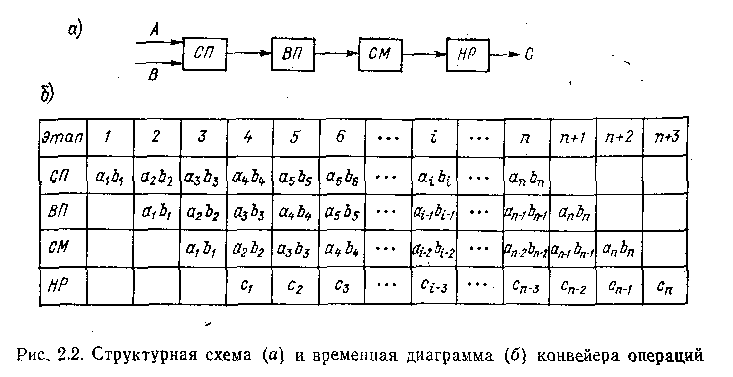

Операцию сложения двух чисел с плавающей запятой можно разделить на четыре последовательно исполняемых этапа, или шага: сравнение порядков (СП); выравнивание порядков—сдвиг мантиссы с меньшим порядком для выравнивания с мантиссой с большим порядком (ВП); сложение мантисс (СМ); нормализация результата (HP). В соответствии с этим в составе процессора предусмотрены четыре операционных блока, соединенных последовательно и реализующих четыре вышеперечисленных шага операции сложения: блоки СП, ВП, СМ и HP (рис. 2.2, а). Примем, что время выполнения каждого шага равно соответственно 60, 100, 140, !00 не. Таким образом, операция сложения будет выполняться последовательностью операционных блоков за время 400 не.

Далее предположим, что возникает задача сложения двух векторов А и В, содержащих по п элементов с плавающей запятой. Очевидно, для решения этой задачи потребуется сложить два

Выполним эти операции на процессоре, организовав обработку данных следующим образом. После того как блок СП выполнит свою часть операции над первой парой операндов, он передает результат в следующий блок — ВП, а в блок СП будет загружена очередная пара операндов. На следующем шаге блок ВП передаст результат выполнения своей части операции в блок СМ и начнет обрабатывать вторую пару операндов и т. д. Каждого из этих этапов одинаково и равно максимальному значению т =140 не. В результате получим конвейер из четырех операционных блоков. Первый результат на выходе конвейера будет получен через 140х4=560 не, т. е. несколько позже, чем если бы время выполнения всех этапов не выравнивалось. Однако все последующие результаты будут выдаваться через каждые 140 нс.

Нетрудно заметить, что чем длиннее цепочка данных и чем на большее число этапов (а следовательно, и операционных блоков) разбивается операция (при той же длительности ее выполнения), тем больший эффект от использования конвейера может быть получен.

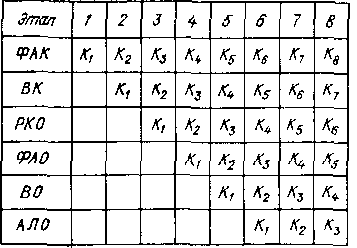

В приведенном выше примере было рассмотрено конвейерное выполнение арифметических операций, но идея конвейера может быть распространена и па выполнение команд. Надо сказать, что конвейер 'команд применяется уже давно в обычных ЭВМ. При этом цикл выполнения команды разбивается на ряд этапов, например формирование адреса команды (ФАК), выборка команды из памяти (ВК), расшифровка кода операции (РКО), формирование адреса операнда (ФАО), выборка операнда из памяти (ВО) и наконец арифметическая или логическая операция (АЛО). В устройстве управления предусматриваются блоки, которые независимо друг от друга и параллельно могут выполнять указанные этапы. Временная диаграмма показана на рис. 2,3. Для простоты время выполнения каждого этапа принято одинаковым (что, вообще говоря, не обязательно и не всегда делается).

Таким образом, если в конвейере арифметических операции происходит параллельная обработка т пар операндов, то в конвейере команд происходит совмещение во время выполнения ; операций (;— число этапов, на которое разбито выполнение команды), что позволяет существенно увеличить производительность такой конвейерной системы.

К сожалению, выигрыш по производительности в к раз практически невозможен, так как может быть получен только при выполнении программы без условных переходов. Наличие условных переходов сразу нарушает работу конвейера и приводит к «холостым» пробегам конвейера, когда по выработанному в команде Ki признаку результата надо перейти к выполнению не Ki+ги команды, а совершенно другой, что вызывает необходимость очистки всех блоков и загрузки их другой операцией.

В реальных ЭВМ и системах применяются различные приемы, позволяющие определять признак перехода возможно раньше, однако совсем исключить влияние условных переходов не удается. Тем не менее для определенных задач, где имеют место цепочки команд без таких переходов, выигрыш в производительности конвейерного процессора команд получается значительным.

Как и в конвейере арифметических операций, выигрыш в производительности получается тем больше, чем длиннее участки программы без условных переходов и чем больше предусматривается независимость этапов (и, следовательно, блоков устройства управления) при выполнении команды.

Разумеется, в вычислительных системах можно одновременно использовать и конвейер команд, и конвейер арифметических операций, и даже несколько параллельно работающих 'конвейеров команд и арифметических операций- В последнем случае может быть получена очень высокая производительность системы. Именно по такому принципу построены самые быстродействующие вычислительные системы, которые будут рассмотрены несколько позже.

ADD

Параллельные программы.