- •1 Задачи анализа;

- •2 Задачи синтеза;

- •3 Задачи идентификации.

- •Основные задачи теории кс

- •1. Задачи анализа;

- •2. Задачи синтеза;

- •3. Задачи идентификации.

- •2. Высокой интенсивностью взаимодействия и вытекающим отсюда требованием уменьшения времени ответа.

- •Функционирование кс

- •Основные задачи теории вычислительных систем

- •Общая характеристика методов теории вычислительных систем

- •3. Классификация вычислительных систем

- •Характеристики производительности и надежности кс

- •Характеристики надежности кс

- •1 Холодное резервирование. Работает только основной канал.

- •2 Нагруженный резерв. Включены оба канала (резервный канал занимается посторонними задачами). Время перехода на основную задачу меньше чем в холодном резерве.

- •Общая характеристика методов теории вычислительных систем

- •Характеристики производительности кс

- •1. Номинальная производительность ;

- •2. Комплексная производительность ;

- •3. Пакеты тестовых программ spec XX

- •Характеристики надежности кс

- •1 Холодное резервирование. Работает только основной канал.

- •2 Нагруженный резерв. Включены оба канала (резервный канал занимается посторонними задачами). Время перехода на основную задачу меньше чем в холодном резерве.

- •4) Указывается начальное состояние системы;

- •8) Находятся показатели качества вс на основе найденных вероятностей состояния системы.

- •Анализ надежности кс со сложной структурой

- •2.Расчет надежности кс

- •2. Для каждой вершины можно вычислить среднее количество попаданий вычислительного процесса в эту вершину по формуле

- •1. Разбить множество операторов на классы:

- •Модели вычислительных систем как систем массового обслуживания

- •1 Общие понятия и определения

- •Например m/m/1

- •2 Параметры систем массового обслуживания

- •Модели массового обслуживания вычислительных систем|

- •1. Представление вычислительной системы в виде стохастической сети

- •2. Потоки заявок

- •3. Длительность обслуживания заявок

- •Характеристики одноканальных смо

- •Многопроцессорные системы

- •5. Характеристики бесприоритетных дисциплин обслуживания

- •1) В порядке поступления (первой обслуживается заявка, поступившая раньше других);

- •2) В порядке, обратном порядку поступления заявок (первой обслуживается заявка, поступившая позже других);

- •3) Наугад, т. Е. Путем случайного выбора из очереди.

- •6. Характеристики дисциплины обслуживания с относительными приоритетами заявок

- •3.8. Характеристики дисциплин обслуживания со смешанными приоритетами

- •§ 3.9. Обслуживание заявок в групповом режиме

- •§ 3.10. Смешанный режим обслуживания заявок

- •§ 3.11. Диспетчирование на основе динамических приоритетов

- •§ 3.12. Оценка затрат на диспетчирование

- •1.Определяется интенсивность потока заявок I в смо Si из системы алгебраических уравнений

- •2.Вычисляются коэффициенты передач для каждой смо

- •3.Определяется среднее время обслуживания Ui заявки в смо Si :

- •6.Для моделирующей сети в целом характеристики п.5 определяются как

- •2.Расчет характеристик мультипроцессорной системы

- •1) Имеет доступ к общей памяти;

- •1.Средняя длина очереди заявок, ожидающих обслуживания в системе:

- •3. Среднее время пребывания заявок в системе :

- •Основные задачи теории кс

- •1. Задачи анализа;

- •2. Задачи синтеза;

- •3. Задачи идентификации.

- •1) С неограниченным временем пребывания заявок;

- •2) С относительными ограничениями на время пребывания заявок;

- •3) С абсолютными ограничениями на время пребывания заявок;

- •2.4. Контроллеры и сетевые комплексы ge Fanuc

- •Модели 311,313/323, 331

- •Коммуникационные возможности серии 90-30

- •2.4.3. Контроллеры VersaMax

- •2.4.4. Программное обеспечение

- •Общая характеристика протоколов и интерфейсов асу тп

- •2. Протоколы и интерфейсы нижнего уровня.

- •2. Основные технические характеристики контроллеров и программно-технических комплексов

- •Требования к корпоративной сети

- •2) Одновременное решение различных задач или частей одной задачи;

- •3) Конвейерная обработка информации.

- •1. Суть проблемы и основные понятия

- •1.1 Главные этапы распараллеливания задач

- •1.2 Сведения о вычислительных процессах

- •1.3 Распределенная обработка данных

- •1. Классификации архитектур параллельных вычислительных систем

- •1.1 Классификация Флинна

- •1. Процессоры

- •Память компьютерных систем

- •Простые коммутаторы

- •Простые коммутаторы с пространственным разделением

- •Составные коммутаторы

- •Коммутатор Клоза

- •Баньян-сети

- •Распределенные составные коммутаторы

- •Коммутация

- •Алгоритмы выбора маршрута

- •Граф межмодульных связей Convex Exemplar spp1000

- •Граф межмодульных связей мвс-100

- •3. Граф межмодульных связей мвс-1000

- •1. Построения коммуникационных сред на основе масштабируемого когерентного интерфейса sci

- •2. Коммуникационная среда myrinet

- •3. Коммуникационная среда Raceway

- •4. Коммуникационные среды на базе транспьютероподобных процессоров

- •1. Структура узла

- •2. Пакеты и свободные символы

- •3. Прием пакетов

- •4. Передача пакетов

- •5. Управление потоком

- •1. Структура адресного пространства

- •2. Регистры управления и состояния

- •3. Форматы пакетов

- •Когерентность кэш-памятей

- •1. Организация распределенной директории

- •2. Протокол когерентности

- •3. Алгоритм кэширования.

- •1 . Основные характеристики

- •1.2. Происхождение

- •1.3. Механизм когерентности

- •1. 4. Предназначение

- •1. 5. Структура коммуникационных сред на базе sci

- •1. 6. Физическая реализация

- •1. 7. Обозначение каналов

- •2. Реализация коммуникационной среды

- •2.1. На структурном уровне коммуникационная среда состоит из трех компонентов, как показано на рис. 2.1:

- •Масштабируемый когерентный интерфейс sci

- •Сетевая технология Myrinet

- •Коммуникационная среда Raceway

- •Коммуникационные среды на базе транспьютероподобных процессоров

- •1.Информационные модели

- •1.2. Мультипроцессоры

- •1.3. Мультикомпьютеры

- •Сравнительный анализ архитектур кс параллельного действия.

- •Архитектура вычислительных систем

- •Smp архитектура

- •Симметричные мультипроцессорные системы (smp)

- •Mpp архитектура

- •Массивно-параллельные системы (mpp)

- •Гибридная архитектура (numa)

- •Системы с неоднородным доступом к памяти (numa)

- •Pvp архитектура

- •Параллельные векторные системы (pvp)

- •1. Системы с конвейерной обработкой информации

- •1.2 Мультипроцессоры uma с много- ступенчатыми сетями

- •Мультипроцессоры numa

- •Мультипроцессор Sequent numa-q

- •Мультикомпьютеры с передачей сообщений

- •1. Общая характеристика кластерных систем.

- •2.Особенности построения кластерных систем.

- •Планирование работ в cow.

- •Без блокировки начала очереди (б); заполнение прямоугольника «процессоры-время» (в). Серым цветом показаны свободные процессоры

- •Общие сведения

- •Общие сведения

- •Логическая структура кластера

- •Логические функции физического узла.

- •Устройства памяти

- •Программное обеспечение

- •Элементы кластерных систем

- •1.1. Характеристики процессоров

- •Рассмотрим в начале процессор amd Opteron/Athlon 64.

- •Примеры промышленых разработок

- •Кластерные решения компании ibm

- •Диаграмма большого Linux-кластера.

- •Аппаратное обеспечение

- •Вычислительные узлы, выполняющие основные вычислительные задачи, для которых спроектирована система.

- •Программное обеспечение

- •Кластерные решения компании hp

- •Кластерные решения компании sgi

- •Производительность операций с плавающей точкой

- •Производительность памяти

- •Производительность системы ввода/вывода Linux

- •Масштабируемость технических приложений

- •Системное программное обеспечение

- •Архитектура san

- •Компоненты san

- •Примеры решений на основе san

- •San начального уровня

- •San между основным и резервным центром

- •Практические рекомендации

- •Построение san

- •Заключение

- •Принципы построения кластерных архитектур.

- •Оценки производительности параллельных систем

- •1) Имеет доступ к общей памяти;

- •2) Имеет общий доступ к устройствам ввода-вывода;

- •3) Управляется общей операционной системой, которая обеспечивает требуемое взаимодействие между процессорами и выполняемыми им программами как на аппаратном, так и на программном уровне.

- •4 Вероятность того, что в момент поступления очередной заявки все n процессоров заняты обслуживанием

- •Выбор коммутационного компонента.

- •Проблема сетевой перегрузки.

- •1. Обзор современных сетевых решении для построения кластеров.

- •1000-Мега битный вариант Ethernet

- •Организация внешней памяти

- •Эффективные кластерные решения

- •Концепция кластерных систем

- •Разделение на High Avalibility и High Performance системы

- •3. Проблематика High Performance кластеров

- •Проблематика High Availability кластерных систем

- •Смешанные архитектуры

- •6.Средства реализации High Performance кластеров

- •7.Средства распараллеливания

- •8.Средства реализации High Availability кластеров

- •9.Примеры проверенных решений

- •Архитектура san

- •Компоненты san

- •Примеры решений на основе san

- •San начального уровня

- •San между основным и резервным центром

- •Практические рекомендации

- •Построение san

- •Заключение

- •Symmetrix десять лет спустя

- •Матричная архитектура

- •Средства защиты данных

- •Ревизионизм и фон-неймановская архитектура

- •Литература

- •Связное программное обеспечение для мультикомпьютеров

- •1. Синхронная передача сообщений.

- •2. Буферная передача сообщений.

- •Планирование работ в cow

- •Средства распараллеливания

- •7.Средства распараллеливания

- •2. Кластерн ый вычислительн ый комплекс на основе интерфейса передачи сообщений

- •2.2 Программная реализация интерфейса передачи сообщений

- •2.3 Структура каталога mpich

- •2.4 «Устройства» mpich

- •2.5 Выполнение параллельной программы

- •2.6 Особенности выполнения программ на кластерах рабочих станций

- •2.7 Тестирование кластерного комплекса

- •Параллельная виртуальная машина

- •3 Кластерн ый вычислительн ый комплекс на основе пАраллельной виртуальной машины

- •3.1 Параллельная виртуальная машина

- •3.1.1 Общая характеристика

- •3.1.2 Гетерогенные вычислительные системы

- •3.1.3 Архитектура параллельной виртуальной машины

- •3.2 Настройка и запуск параллельной виртуальной машины

- •3.3 Структура каталога pvm

- •3.4 Тестирование параллельной виртуальной машины

- •На рисунке 3.2 представлена диаграмма, отображающая сравнение производительности коммуникационных библиотек mpi и pvm.

- •3.5 Сходства и различия pvm и mpi

- •4 . Кластерн ый вычислительн ый комплекса на основе программного пакета openMosix

- •4.1 Роль openMosix

- •4.2 Компоненты openMosix

- •4.2.1 Миграция процессов

- •4.2.2 Файловая система openMosix (oMfs)

- •4.3 Планирование кластера

- •4.4 Простая конфигурация

- •4.4.1 Синтаксис файла /etc/openmosix.Map

- •4.4.2 Автообнаружение

- •4. 5. Пользовательские утилиты администрирования openMosix

- •4. 6. Графические средства администрирования openMosix

- •4. 6.1 Использование openMosixView

- •4. 6.1.2 Окно конфигурации. Это окно появится после нажатия кнопки “cluster-node”.

- •4. 6.1.3 Окно advanced-execution. Если нужно запустить задания в кластере, то диалог "advanced execution" может сильно упростить эту задачу.

- •4.6.1.4 Командная строка. Можно указать дополнительные аргументы командной строки в поле ввода вверху окна. Аргументы приведены в таблице 9.2.

- •4. 6.2.2 Окно migrator. Этот диалог появляется, если кликнуть на каком-либо процессе из окна списка процессов.

- •4. 6.2.3 Управление удалёнными процессами. Этот диалог появляется при нажатии кнопки “manage procs from remote”

- •4.5.3 Использование openMosixcollector

- •4. 6.4 Использование openMosixanalyzer

- •4. 6.4. 1 Окно load-overview. Здесь отображается хронология нагрузки openMosix.

- •4. 6.4. 2 Статистическая информация об узле

- •4.5.4.3 Окно memory-overview. Здесь представляется обзор использования памяти (Memory-overview) в openMosixanalyzer.

- •4. 6.4.4 Окно openMosixhistory

- •4. 6.5 Использование openMosixmigmon

- •4.6 Список условных сокращений

- •Перечень ссылок

- •Общие сведения

- •2. Создание Windows-кластера

- •Суперкомпьютерная Программа "скиф"

- •Описание технических решений

- •Направления работ

- •Основные результаты

- •Кластер мгиу

- •Содержание

- •Понятие о кластере

- •Аппаратное обеспечение

- •Пропускная способность и латентность

- •1. Определение распределенной системы

- •2.1. Соединение пользователей с ресурсами

- •2.2. Прозрачность

- •Прозрачность в распределенных системах

- •2.3. Открытость

- •2.4. Масштабируемость

- •3.1. Мультипроцессоры

- •3.2. Гомогенные мультикомпьютерные системы

- •3.3. Гетерогенные мультикомпьютерные системы

- •4. Концепции программных решений рс

- •4.1. Распределенные операционные системы

- •4.2. Сетевые операционные системы

- •4.3. Программное обеспечение промежуточного уровня

- •5. Модель клиент-сервер рс

- •5.1. Клиенты и серверы

- •5.2. Разделение приложений по уровням

- •5.3. Варианты архитектуры клиент-сервер

- •Формы метакомпьютера

- •Настольный суперкомпьютер.

- •2. Интеллектуальный инструментальный комплекс.

- •Сетевой суперкомпьютер.

- •Проблемы создания метакомпьютера

- •Сегодняшняя архитектура метакомпьютерной среды

- •Взаимосвязь метакомпьютинга с общими проблемами развития системного по

- •5. Модель клиент-сервер рс

- •5.1. Клиенты и серверы

- •5.2. Разделение приложений по уровням

- •5.3. Варианты архитектуры клиент-сервер

- •Symmetrix десять лет спустя

- •Матричная архитектура

- •Средства защиты данных

- •Ревизионизм и фон-неймановская архитектура

- •Однородные вычислительные среды

- •Однокристальный ассоциативный процессор сам2000

- •Модели нейронных сетей

- •Модели инс

- •Оптимизационные системы.

- •Неуправляемые системы распознавания образов.

- •Системы feed forward.

- •Элементы нейрологики с позиции аппаратной реализации

- •Реализация нейронных сетей

- •Программные нейрокомпьютеры

- •Программно-аппаратные нейрокомпьютеры

- •Практическое использование инс

§ 3.9. Обслуживание заявок в групповом режиме

Если управляющая программа включается в работу каждый раз, когда закончено обслуживание очередной заявки, то говорят, что обслуживание выполняется в одиночном режиме. В этом режиме на обслуживание выбирается всегда только одна заявка; управляющая программа исполняется процессором многократно, что приводит к большим затратам процессорного времени на диспетчирование. Непроизводительные затраты процессорного времени можно уменьшить, если назначать на обслуживание сразу группу заявок, стоящих в очереди и имеющих максимальный в данной ситуации приоритет. Такой режим обслуживания заявок называется групповым.

Циклическое обслуживание. При групповом режиме может использоваться бесприоритетное обслуживание заявок, называемое циклическим. При циклическом обслуживании для заявок типа 1, ..., М выделяются очереди O1, ..., ОM (рис. 3.25). Сначала обслуживаются все заявки из очереди O1 затем из очереди O2 и т. д. После обслуживания очереди ОM процесс обслуживания вновь возвращается к заявкам из очереди О1. Такой порядок обслуживания характеризуется минимальными затратами на диспетчирование.

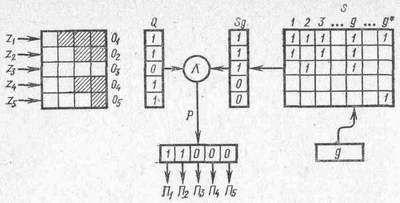

Рис. 3.25. Циклическое обслуживание заявок

Аналитическое исследование циклического обслуживания заявок в групповом режиме при произвольном количестве входных потоков весьма сложно и приводит к громоздким результатам. Однако при М=2 известны выражения для средних значений времени ожидания в очереди заявок каждого потока при условии, что время обслуживания заявок имеет произвольное распределение:

Анализируя выражения (3.20), можно сделать вывод, что выражения для времени ожидания симметричны относительно индексов входящих потоков. Среднее время ожидания в очереди любой заявки из суммарного потока одинаково и равно

где =1+2.

Дисциплина обслуживания с чередующимися приоритетами. При групповом обслуживании очередям заявок могут присваиваться относительные приоритеты. Тогда по окончании обслуживания всех заявок из очереди Oi управляющая программа последовательно проверяет состояние очередей O1, ..., ОM. Если первой непустой является очередь Оj, то система начинает обслуживать эту очередь, пока она не будет исчерпана. Дисциплина обслуживания в групповом режиме с относительными приоритетами заявок называется дисциплиной с чередующимися приоритетами.

Дисциплина обслуживания по расписанию. В цифровых управляющих системах (ЦУС) для групповой обработки заявок широко используется обслуживание по расписанию, которое организуется следующим образом. Расписание задается в виде (i1, i2, ..., iG), где ig(g=1, ..., G) — номер очереди, равный 1, ..., H, и G — длина цикла. Например, если число очередей H=4, то расписание может иметь следующий вид: (1, 2, 1, 3, 1, 2, 1, 4, 1, 2, 1, 3). Здесь длина цикла G=12. Расписание задает порядок обращения к очередям заявок. Так из приведенного расписания следует, что цикл обслуживания начинается с очереди 1, затем обслуживается очередь 2, затем вновь очередь 1 и т. д. Цикл заканчивается обслуживанием очереди 3, после чего ЦУС повторяет цикл обслуживания. За один цикл обслуживания производится шесть обращений к очереди 1, три обращения к очереди 2, два обращения к очереди 3 и одно — к очереди 4. Таким образом, очередь 1 обслуживается наиболее интенсивно и среднее время ожидания заявок типа 1 уменьшается по сравнению с заявками других типов.

Обслуживание по расписанию отличается гибкостью, позволяющей широко варьировать приоритетами заявок. Расписание строится следующим образом. Заявки, поступающие в систему, разделяются на классы. В один класс объединяются разнотипные заявки, для хранения которых выделяется одна очередь. За счет этого уменьшается количество очередей и сокращаются непроизводительные затраты времени на диспетчирование. Число очередей (классов) заявок ЗНМ, где М — число типов заявок, обслуживаемых системой. Число классов Н не может быть меньше трех, поскольку при Н=1 расписание вырождается в бесприоритетную дисциплину обслуживания, при Н=2 имеет место диспиплина циклического обслуживания.

Обозначим через gh — число обращений к h-и очереди в одном цикле. Тогда величину

можно трактовать как вероятность обращения к h-й очереди. Очевидно, что

Определим понятие подцикла, которое в дальнейшем понадобится для построения расписания. Пусть h* — номер очереди, для которой число обращений в цикле максимально, т. е. gh*=max (g1, ...,gH). Подциклом называют обращения к очередям, заключенные между двумя последовательными обращениями к очереди h*, включая также одно обращение к этой очереди. Значение gh* определяет количество подциклов в расписании.

Например, для расписания

(1, 2, 1, 3, 1, 2, 1, 4, 1, 2, 1, 3, 1, 2, 1, 5, 1, 2, 1, 3, 1, 2, 1, 4, 1, 2, 1, 3, 1, 2) (3.21)

число обращений gh к очередям h=1, ..., 5 равно соответственно 15, 8, 4, 2, 1 и длина цикла G=g1+...+g5=30. В таком случае вероятности обращения к очередям 1=15/30; ...; 5=1/30. Отсюда следует, что h*=1 и количество подциклов для данного расписания будет 15.

Поскольку нумерация очередей производится таким образом, что g1>g2>...>gH;, то max (gl ..., gH)=g1 и, следовательно, h* = 1.

К расписанию предъявляют следующие требования: 1) в цикле два последовательных обращения к одной очереди не должны быть расположены рядом, так как в противном случае второе обращение всегда будет осуществляться к пустой очереди; 2) обращения к одной и той же очереди должны быть равномерно распределены по всему циклу, чтобы при каждом обращении к одной и той же очереди число заявок в ней было приблизительно постоянным.

Каноническое расписание. Каноническое расписание — расписание, для которого число обращений к очередям определяется следующим образом:

(3.22)

(3.22)

Тогда количество обращений к каждой последующей очереди в два раза меньше, чем к предыдущей, и к последней очереди с номером Н производится одно обращение за цикл. Длина цикла канонического расписания

Для расписаний с параметрами (3.22) указанные требования всегда могут быть выполнены. Расписание (3.21) — пример канонического расписания.

Расписание целесообразно представлять в виде матрицы S=[sij]. Число строк в матрице равно количеству подциклов в расписании, а число столбцов — количеству классов заявок. Элементы матрицы 0 или 1. Если в подцикле i=l, ..., gh* должно производиться обращение к классу (очереди) h=1, ..., Н, то элемент sih=l, в противном случае элемент sih=0. Расписанию (3.21) соответствует следующая матрица:

Здесь количество единиц в каждом столбце матрицы соответствует количеству обращений gh к классу заявок h за один цикл работы системы.

Получение точных аналитических зависимостей, связывающих время ожидания заявок с числом обращений, — сложная задача, которая не может быть решена классическими методами теории массового обслуживания. Однако, если и удалось бы получить точные аналитические зависимости, то по аналогии с циклическим обслуживанием вычисления по этим формулам были бы весьма громоздкими и трудоемкими и были бы' связаны с использованием ЭВМ. При этом практически полностью терялись бы основные преимущества аналитического исследования по сравнению со статистическим моделированием. Поэтому более целесообразно проводить исследование таких систем в два этапа. Первый этап связан с получением приближенных аналитических зависимостей, на основе которых могут быть оценены основные характеристики обслуживания и выбрано конкретное расписание. На втором этапе проводится исследование системы на статистической модели при различных предположениях о характере потоков и обслуживания заявок. В отношении времени ожидания можно предположить, что его значение для каждого класса заявок h будет обратно пропорционально вероятности обращения к очереди данного класса: h~1/h, т. е. с уменьшением вероятности h время ожидания заявок класса h увеличивается. Однако это совсем не означает, что заявки класса с меньшей вероятностью обращения всегда будут иметь большее время ожидания. Исследования показали, что время ожидания заявок различных классов в большей степени зависит от соотношений между параметрами потоков и механизма обслуживания разнотипных заявок, т. е. заявки, принадлежащие классу с большей вероятностью обращения, в некоторых случаях могут иметь среднее время ожидания, превышающее время ожидания заявок класса с меньшей вероятностью обращения.

Рис. 3.26. Организация обслуживания заявок на основе расписания

Реализация обслуживания по расписанию. Обслуживание заявок на основе расписания организуется по схеме, показанной на рис. 3.26. Заявки z1, ..., z5, относящиеся к классам 1, ..., 5, ожидают обслуживания в очередях О1, ..., О5. С целью сокращения непроизводительных затрат на просмотр пустых очередей используется слово состояния очередей Q. Разряды ql, ..., q5 слова Q принимают значения qi=0, если очередь Oi пуста; qi=1, если очередь Oi не пуста. Расписание представляется булевой матрицей S. В данном случае строки матрицы соответствуют классам h=l,...,5 заявок, а столбцы — подциклам расписания. Подцикл, управляющий обслуживанием заявок, выделяется счетчиком g. В начальном состоянии g=l и затем значение g изменяется в циклическом порядке: g=l,2,..., g*, 1, 2, ..., g*, 1, 2, ... .

Управляющая программа функционирует следующим образом.

1. Из матрицы расписания S выбирается столбец Sg, выделяемый текущим значением счетчика g. Столбец Sg представляется двоичным словом.

2. Слова Q и Sg умножаются поразрядно. В результате формируется слово P=Q^Sg, разряды которого определяют не пустые очереди, обрабатываемые в подцикле g.

3. Управляющая программа последовательно просматривает разряды i=l, 2, ..., 5 слова Р. Если i-й разряд слова равен 1, то инициируется программа Пi, которая начинает обрабатывать все заявки из очереди Oi, после чего управление вновь передается управляющей программе и просматривается очередной разряд слова Р.

4. После просмотра всех разрядов слова Р значение счетчика циклически увеличивается на единицу и выполняется переход к пункту 1.

Управление по расписанию целесообразно применять в системах с большой интенсивностью потока заявок — порядка 1·102 с-1 и более — и широким диапазоном ограничений на времена ожидания заявок. В этом случае затраты процессорного времени на диспетчирование вполне измеримы и многочисленность вариантов распределения единиц в матрице расписания позволяет подобрать такое управление порядком обслуживания, при котором фактические времена ожидания хорошо приближаются к требуемым.