- •1 Задачи анализа;

- •2 Задачи синтеза;

- •3 Задачи идентификации.

- •Основные задачи теории кс

- •1. Задачи анализа;

- •2. Задачи синтеза;

- •3. Задачи идентификации.

- •2. Высокой интенсивностью взаимодействия и вытекающим отсюда требованием уменьшения времени ответа.

- •Функционирование кс

- •Основные задачи теории вычислительных систем

- •Общая характеристика методов теории вычислительных систем

- •3. Классификация вычислительных систем

- •Характеристики производительности и надежности кс

- •Характеристики надежности кс

- •1 Холодное резервирование. Работает только основной канал.

- •2 Нагруженный резерв. Включены оба канала (резервный канал занимается посторонними задачами). Время перехода на основную задачу меньше чем в холодном резерве.

- •Общая характеристика методов теории вычислительных систем

- •Характеристики производительности кс

- •1. Номинальная производительность ;

- •2. Комплексная производительность ;

- •3. Пакеты тестовых программ spec XX

- •Характеристики надежности кс

- •1 Холодное резервирование. Работает только основной канал.

- •2 Нагруженный резерв. Включены оба канала (резервный канал занимается посторонними задачами). Время перехода на основную задачу меньше чем в холодном резерве.

- •4) Указывается начальное состояние системы;

- •8) Находятся показатели качества вс на основе найденных вероятностей состояния системы.

- •Анализ надежности кс со сложной структурой

- •2.Расчет надежности кс

- •2. Для каждой вершины можно вычислить среднее количество попаданий вычислительного процесса в эту вершину по формуле

- •1. Разбить множество операторов на классы:

- •Модели вычислительных систем как систем массового обслуживания

- •1 Общие понятия и определения

- •Например m/m/1

- •2 Параметры систем массового обслуживания

- •Модели массового обслуживания вычислительных систем|

- •1. Представление вычислительной системы в виде стохастической сети

- •2. Потоки заявок

- •3. Длительность обслуживания заявок

- •Характеристики одноканальных смо

- •Многопроцессорные системы

- •5. Характеристики бесприоритетных дисциплин обслуживания

- •1) В порядке поступления (первой обслуживается заявка, поступившая раньше других);

- •2) В порядке, обратном порядку поступления заявок (первой обслуживается заявка, поступившая позже других);

- •3) Наугад, т. Е. Путем случайного выбора из очереди.

- •6. Характеристики дисциплины обслуживания с относительными приоритетами заявок

- •3.8. Характеристики дисциплин обслуживания со смешанными приоритетами

- •§ 3.9. Обслуживание заявок в групповом режиме

- •§ 3.10. Смешанный режим обслуживания заявок

- •§ 3.11. Диспетчирование на основе динамических приоритетов

- •§ 3.12. Оценка затрат на диспетчирование

- •1.Определяется интенсивность потока заявок I в смо Si из системы алгебраических уравнений

- •2.Вычисляются коэффициенты передач для каждой смо

- •3.Определяется среднее время обслуживания Ui заявки в смо Si :

- •6.Для моделирующей сети в целом характеристики п.5 определяются как

- •2.Расчет характеристик мультипроцессорной системы

- •1) Имеет доступ к общей памяти;

- •1.Средняя длина очереди заявок, ожидающих обслуживания в системе:

- •3. Среднее время пребывания заявок в системе :

- •Основные задачи теории кс

- •1. Задачи анализа;

- •2. Задачи синтеза;

- •3. Задачи идентификации.

- •1) С неограниченным временем пребывания заявок;

- •2) С относительными ограничениями на время пребывания заявок;

- •3) С абсолютными ограничениями на время пребывания заявок;

- •2.4. Контроллеры и сетевые комплексы ge Fanuc

- •Модели 311,313/323, 331

- •Коммуникационные возможности серии 90-30

- •2.4.3. Контроллеры VersaMax

- •2.4.4. Программное обеспечение

- •Общая характеристика протоколов и интерфейсов асу тп

- •2. Протоколы и интерфейсы нижнего уровня.

- •2. Основные технические характеристики контроллеров и программно-технических комплексов

- •Требования к корпоративной сети

- •2) Одновременное решение различных задач или частей одной задачи;

- •3) Конвейерная обработка информации.

- •1. Суть проблемы и основные понятия

- •1.1 Главные этапы распараллеливания задач

- •1.2 Сведения о вычислительных процессах

- •1.3 Распределенная обработка данных

- •1. Классификации архитектур параллельных вычислительных систем

- •1.1 Классификация Флинна

- •1. Процессоры

- •Память компьютерных систем

- •Простые коммутаторы

- •Простые коммутаторы с пространственным разделением

- •Составные коммутаторы

- •Коммутатор Клоза

- •Баньян-сети

- •Распределенные составные коммутаторы

- •Коммутация

- •Алгоритмы выбора маршрута

- •Граф межмодульных связей Convex Exemplar spp1000

- •Граф межмодульных связей мвс-100

- •3. Граф межмодульных связей мвс-1000

- •1. Построения коммуникационных сред на основе масштабируемого когерентного интерфейса sci

- •2. Коммуникационная среда myrinet

- •3. Коммуникационная среда Raceway

- •4. Коммуникационные среды на базе транспьютероподобных процессоров

- •1. Структура узла

- •2. Пакеты и свободные символы

- •3. Прием пакетов

- •4. Передача пакетов

- •5. Управление потоком

- •1. Структура адресного пространства

- •2. Регистры управления и состояния

- •3. Форматы пакетов

- •Когерентность кэш-памятей

- •1. Организация распределенной директории

- •2. Протокол когерентности

- •3. Алгоритм кэширования.

- •1 . Основные характеристики

- •1.2. Происхождение

- •1.3. Механизм когерентности

- •1. 4. Предназначение

- •1. 5. Структура коммуникационных сред на базе sci

- •1. 6. Физическая реализация

- •1. 7. Обозначение каналов

- •2. Реализация коммуникационной среды

- •2.1. На структурном уровне коммуникационная среда состоит из трех компонентов, как показано на рис. 2.1:

- •Масштабируемый когерентный интерфейс sci

- •Сетевая технология Myrinet

- •Коммуникационная среда Raceway

- •Коммуникационные среды на базе транспьютероподобных процессоров

- •1.Информационные модели

- •1.2. Мультипроцессоры

- •1.3. Мультикомпьютеры

- •Сравнительный анализ архитектур кс параллельного действия.

- •Архитектура вычислительных систем

- •Smp архитектура

- •Симметричные мультипроцессорные системы (smp)

- •Mpp архитектура

- •Массивно-параллельные системы (mpp)

- •Гибридная архитектура (numa)

- •Системы с неоднородным доступом к памяти (numa)

- •Pvp архитектура

- •Параллельные векторные системы (pvp)

- •1. Системы с конвейерной обработкой информации

- •1.2 Мультипроцессоры uma с много- ступенчатыми сетями

- •Мультипроцессоры numa

- •Мультипроцессор Sequent numa-q

- •Мультикомпьютеры с передачей сообщений

- •1. Общая характеристика кластерных систем.

- •2.Особенности построения кластерных систем.

- •Планирование работ в cow.

- •Без блокировки начала очереди (б); заполнение прямоугольника «процессоры-время» (в). Серым цветом показаны свободные процессоры

- •Общие сведения

- •Общие сведения

- •Логическая структура кластера

- •Логические функции физического узла.

- •Устройства памяти

- •Программное обеспечение

- •Элементы кластерных систем

- •1.1. Характеристики процессоров

- •Рассмотрим в начале процессор amd Opteron/Athlon 64.

- •Примеры промышленых разработок

- •Кластерные решения компании ibm

- •Диаграмма большого Linux-кластера.

- •Аппаратное обеспечение

- •Вычислительные узлы, выполняющие основные вычислительные задачи, для которых спроектирована система.

- •Программное обеспечение

- •Кластерные решения компании hp

- •Кластерные решения компании sgi

- •Производительность операций с плавающей точкой

- •Производительность памяти

- •Производительность системы ввода/вывода Linux

- •Масштабируемость технических приложений

- •Системное программное обеспечение

- •Архитектура san

- •Компоненты san

- •Примеры решений на основе san

- •San начального уровня

- •San между основным и резервным центром

- •Практические рекомендации

- •Построение san

- •Заключение

- •Принципы построения кластерных архитектур.

- •Оценки производительности параллельных систем

- •1) Имеет доступ к общей памяти;

- •2) Имеет общий доступ к устройствам ввода-вывода;

- •3) Управляется общей операционной системой, которая обеспечивает требуемое взаимодействие между процессорами и выполняемыми им программами как на аппаратном, так и на программном уровне.

- •4 Вероятность того, что в момент поступления очередной заявки все n процессоров заняты обслуживанием

- •Выбор коммутационного компонента.

- •Проблема сетевой перегрузки.

- •1. Обзор современных сетевых решении для построения кластеров.

- •1000-Мега битный вариант Ethernet

- •Организация внешней памяти

- •Эффективные кластерные решения

- •Концепция кластерных систем

- •Разделение на High Avalibility и High Performance системы

- •3. Проблематика High Performance кластеров

- •Проблематика High Availability кластерных систем

- •Смешанные архитектуры

- •6.Средства реализации High Performance кластеров

- •7.Средства распараллеливания

- •8.Средства реализации High Availability кластеров

- •9.Примеры проверенных решений

- •Архитектура san

- •Компоненты san

- •Примеры решений на основе san

- •San начального уровня

- •San между основным и резервным центром

- •Практические рекомендации

- •Построение san

- •Заключение

- •Symmetrix десять лет спустя

- •Матричная архитектура

- •Средства защиты данных

- •Ревизионизм и фон-неймановская архитектура

- •Литература

- •Связное программное обеспечение для мультикомпьютеров

- •1. Синхронная передача сообщений.

- •2. Буферная передача сообщений.

- •Планирование работ в cow

- •Средства распараллеливания

- •7.Средства распараллеливания

- •2. Кластерн ый вычислительн ый комплекс на основе интерфейса передачи сообщений

- •2.2 Программная реализация интерфейса передачи сообщений

- •2.3 Структура каталога mpich

- •2.4 «Устройства» mpich

- •2.5 Выполнение параллельной программы

- •2.6 Особенности выполнения программ на кластерах рабочих станций

- •2.7 Тестирование кластерного комплекса

- •Параллельная виртуальная машина

- •3 Кластерн ый вычислительн ый комплекс на основе пАраллельной виртуальной машины

- •3.1 Параллельная виртуальная машина

- •3.1.1 Общая характеристика

- •3.1.2 Гетерогенные вычислительные системы

- •3.1.3 Архитектура параллельной виртуальной машины

- •3.2 Настройка и запуск параллельной виртуальной машины

- •3.3 Структура каталога pvm

- •3.4 Тестирование параллельной виртуальной машины

- •На рисунке 3.2 представлена диаграмма, отображающая сравнение производительности коммуникационных библиотек mpi и pvm.

- •3.5 Сходства и различия pvm и mpi

- •4 . Кластерн ый вычислительн ый комплекса на основе программного пакета openMosix

- •4.1 Роль openMosix

- •4.2 Компоненты openMosix

- •4.2.1 Миграция процессов

- •4.2.2 Файловая система openMosix (oMfs)

- •4.3 Планирование кластера

- •4.4 Простая конфигурация

- •4.4.1 Синтаксис файла /etc/openmosix.Map

- •4.4.2 Автообнаружение

- •4. 5. Пользовательские утилиты администрирования openMosix

- •4. 6. Графические средства администрирования openMosix

- •4. 6.1 Использование openMosixView

- •4. 6.1.2 Окно конфигурации. Это окно появится после нажатия кнопки “cluster-node”.

- •4. 6.1.3 Окно advanced-execution. Если нужно запустить задания в кластере, то диалог "advanced execution" может сильно упростить эту задачу.

- •4.6.1.4 Командная строка. Можно указать дополнительные аргументы командной строки в поле ввода вверху окна. Аргументы приведены в таблице 9.2.

- •4. 6.2.2 Окно migrator. Этот диалог появляется, если кликнуть на каком-либо процессе из окна списка процессов.

- •4. 6.2.3 Управление удалёнными процессами. Этот диалог появляется при нажатии кнопки “manage procs from remote”

- •4.5.3 Использование openMosixcollector

- •4. 6.4 Использование openMosixanalyzer

- •4. 6.4. 1 Окно load-overview. Здесь отображается хронология нагрузки openMosix.

- •4. 6.4. 2 Статистическая информация об узле

- •4.5.4.3 Окно memory-overview. Здесь представляется обзор использования памяти (Memory-overview) в openMosixanalyzer.

- •4. 6.4.4 Окно openMosixhistory

- •4. 6.5 Использование openMosixmigmon

- •4.6 Список условных сокращений

- •Перечень ссылок

- •Общие сведения

- •2. Создание Windows-кластера

- •Суперкомпьютерная Программа "скиф"

- •Описание технических решений

- •Направления работ

- •Основные результаты

- •Кластер мгиу

- •Содержание

- •Понятие о кластере

- •Аппаратное обеспечение

- •Пропускная способность и латентность

- •1. Определение распределенной системы

- •2.1. Соединение пользователей с ресурсами

- •2.2. Прозрачность

- •Прозрачность в распределенных системах

- •2.3. Открытость

- •2.4. Масштабируемость

- •3.1. Мультипроцессоры

- •3.2. Гомогенные мультикомпьютерные системы

- •3.3. Гетерогенные мультикомпьютерные системы

- •4. Концепции программных решений рс

- •4.1. Распределенные операционные системы

- •4.2. Сетевые операционные системы

- •4.3. Программное обеспечение промежуточного уровня

- •5. Модель клиент-сервер рс

- •5.1. Клиенты и серверы

- •5.2. Разделение приложений по уровням

- •5.3. Варианты архитектуры клиент-сервер

- •Формы метакомпьютера

- •Настольный суперкомпьютер.

- •2. Интеллектуальный инструментальный комплекс.

- •Сетевой суперкомпьютер.

- •Проблемы создания метакомпьютера

- •Сегодняшняя архитектура метакомпьютерной среды

- •Взаимосвязь метакомпьютинга с общими проблемами развития системного по

- •5. Модель клиент-сервер рс

- •5.1. Клиенты и серверы

- •5.2. Разделение приложений по уровням

- •5.3. Варианты архитектуры клиент-сервер

- •Symmetrix десять лет спустя

- •Матричная архитектура

- •Средства защиты данных

- •Ревизионизм и фон-неймановская архитектура

- •Однородные вычислительные среды

- •Однокристальный ассоциативный процессор сам2000

- •Модели нейронных сетей

- •Модели инс

- •Оптимизационные системы.

- •Неуправляемые системы распознавания образов.

- •Системы feed forward.

- •Элементы нейрологики с позиции аппаратной реализации

- •Реализация нейронных сетей

- •Программные нейрокомпьютеры

- •Программно-аппаратные нейрокомпьютеры

- •Практическое использование инс

Однородные вычислительные среды

В разное время было предложено достаточно много проектов однородных вычислительных сред [1-5].

В начале 60-х годов Э. В. Евреинов и Ю. Г. Косарев предложили несколько другой подход к построению систем, в основе которого три принципа: параллельность операций; переменность логической структуры; конструктивная однородность элементов и связей между ними.

Первый принцип базируется на аксиоме параллельности задач и алгоритмов: всякая сложная задача может быть представлена в виде связанных между собой простых подзадач и для любой сложной задачи может быть предложен параллельный алгоритм, допускающий ее эффективное решение. Аксиома параллельности, таким образом, обеспечивает достижение высокой производительности за счет параллельной работы большого числа обрабатывающих устройств или элементов.

Второй принцип базируется на аксиоме переменности логической структуры: процесс решения сложной задачи может быть представлен некоторой структурной моделью, включающей в себя подзадачи и связи между ними. Это означает, что для каждой сложной задачи можно предложить соответствующую структуру из обрабатывающих элементов, связанных между собой определенным образом.

Третий принцип базируется на аксиоме конструктивной однородности элементов и связей: все простые задачи получаются путем деления сложной задачи на части, а поэтому все эти простые задачи примерно одинаковы по объему вычислений и связаны между собой одинаковыми схемами обмена. Это означает, что система для решения сложной задачи может быть построена из одинаковых обрабатывающих элементов, связанных между собой одинаковым образом.

Таким образом, при соблюдении трех принципов вычислительная система может быть представлена как совокупность неограниченного числа одинаковых обрабатывающих устройств, однотипно связанных между собой. Эта совокупность перед решением задачи настраивается соответствующим образом. Такая однородная вычислительная система должна решать задачи неограниченной сложности и объема при высокой надежности и готовности, что обеспечивается избыточностью обрабатывающих устройств, унифицированностью связей между ними и легкостью перестройки системы.

В рассмотренных выше комплексах и системах в той или иной степени используются указанные выше три принципа: почти везде возможна параллельная обработка задач; во многих случаях, в первую очередь в МПВК, возможна реконфигурация и иногда прямая настройка системы на решение определенной задачи; наблюдается стремление унифицировать обрабатывающие средства, т. е. создавать по возможности однородные системы,

Описываемый подход к созданию вычислительных систем в виде однородных перестраиваемых структур отличается тем, что используются все три принципа, что, по мнению авторов, и должно обеспечить максимальный эффект.

Хотя эти идеи были выдвинуты более двадцати лет назад, достаточно активная их реализация началась сравнительно недавно. Это и понятно, так как создание однородных систем из большого числа ЭВМ или процессоров второго и даже третьего поколения было вовсе не простой задачей: слишком громоздкими получались такие системы. Ясно, что эффективная реализация возможна лишь при весьма эффективной элементной базе. С развитием микропроцессоров и микро-ЭВМ на их основе такая база создана, и стала возможной реализация этих идей. В качестве иллюстрации можно рассмотреть систему МИНИМАКС [5].

Эта система относится к классу однородных и имеет программируемую макроструктуру. Число элементарных машин (ЭМ) в системе не фиксировано и может определяться классом решаемых задач. Структурную единицу системы составляет ЭМ, которая включает в себя вычислительный модуль (ВМ) и модуль межмашинной связи (ММС). Состав каждой ЭМ также достаточно произвольный — может выбираться из числа типовых спецификаций

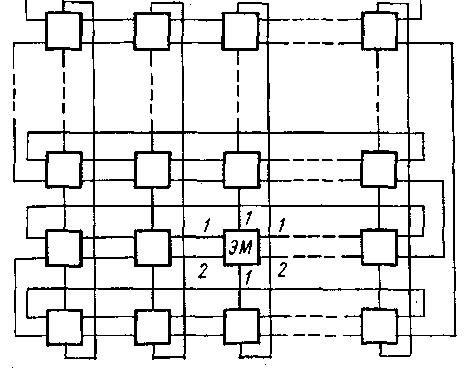

Рис. 1. Связи между ЭМ в системе МИНИМАКС

семейств АСВТ или СМ ЭВМ. В качестве ВМ использовались ЭВМ, построенные на основе процессоров М-6000, М-7000, СМ ЭВМ. Модули МС, предназначенные для организации взаимодействия ЭМ, выполнены как автономные устройства, обеспечивают передачу данных, адресов и управляющей информации между соседними ВМ.

Рис. 2. Однородная вычислительная среда

Из рис. 1. видно, что каждая элементарная машина связана с четырьмя соседними и взаимодействуют они с помощью двух типов связи: 1 и 2, обеспечивающих полудуплексную работу. Связи типа 1 используются для пересылки данных между ОЗУ передающего ВМ и одного или нескольких принимающих ВМ, передачи адресов между передающими и принимающими ВМ и обмена логическими переменными между элементарными машинами.

Связи типа 2 являются вспомогательными: они используются для программирования соединений между элементарными машинами по линиям связи типа 1, а также для передачи управляющей информации, обеспечивающей использование общих ресурсов — периферийных устройств, файлов, программ и др. Связи типа 3 между вычислительным модулем и модулем машинной связи в пределах одной элементарной машины — дуплексные и используются для обмена информацией с периферийными устройствами.

Важным аспектом работы однородной системы является программирование ее структуры — настройка, которая осуществляется с помощью специальных регистров настройки, входящих в состав модулей машинной связи. Содержимое этих регистров может быть изменено либо собственным вычислительным модулем, либо вычислительным модулем любой другой элементарной машины.

Система МИНИМАКС — общего назначения и может работать в автоматизированных системах управления технологическими процессами.

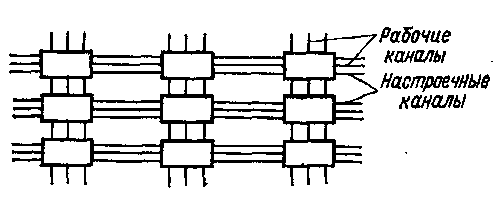

Развитием однородных вычислительных систем являются однородные вычислительные среды, которые представляют собой в общем случае n-мерную решетчатую структуру. В частном случае это двухмерная структура из квадратных клеток, заполняющих плоскость. Каждая клетка в двухмерной структуре соединяется с четырьмя соседними. Между двумя соседними клетками проходят два канала настройки и один канал передачи рабочей информации (рис. 2). Каждый элемент однородной вычислительной среды состоит из коммутационных и функциональных компонентов.

Функциональный

компонент реализует

полную систему логических функций,

например: ИЛИ—НЕ — f

(x1,

х2)

= или И—НЕ — f(x1,

x2)

=

.

Коммутационные

и функциональные компоненты позволяют

путем соответствующей настройки при

достаточном их числе реализовать любую

структуру.

или И—НЕ — f(x1,

x2)

=

.

Коммутационные

и функциональные компоненты позволяют

путем соответствующей настройки при

достаточном их числе реализовать любую

структуру.

Пока еще нет достаточного опыта, который позволил бы оценить перспективность этих идей, однако можно отметить, что реализация однородных систем— непростая проблема, а эффективность таких систем не является безусловной. Надо иметь в виду, что связи между отдельными элементами достаточно сложны, аппаратные затраты на реализацию связей велики, причем чем элементарнее функции вычислительного модуля, тем больший удельный вес приобретают затраты на связи. Кроме того, программирование связей для настройки системы является достаточно сложной задачей. Вместе с тем не вызывает сомнения, что однородные вычислительные системы представляют значительный интерес и, по-видимому, будут активно развиваться.

На Рис3. изображена структура ячейки гипотетической однородной среды. Ячейки находятся в узлах прямоугольной решетки и связаны двунаправленными информационными каналами. Кроме этого, ячейки связаны сетью для ввода программы в ячейку, задания режима ее функционирования «настройка/работа», тактирования.

В режиме «настройка» каждая ячейка получает программу, возможно, состоящую из одной команды.

Рис.3 Структура ячейки гипотетической однородной среды

В режиме «работа» ячейка выполняет команды над операндами, поступающими из информационных каналов или из внутренней, как правило, однобитной памяти.

То, какие операнды использовать, и какую операцию выполнять над ними определяется дешифратором команды, который управляет АЛУ и коммутатором ячейки. Эта же команда определяет, на какие информационные выходы, и что надо выдавать из ячейки. Ячейка, как правило, выполняет следующие команды: транзит данных через ячейку с ее входов с записью или без записи в память ячейки; нет операции; суммирование с учетом или без учета переноса; логическая операция (суммирование по модулю 2, или, и, не-и); генерирование константы.

Настройка ячеек может быть статической или динамической. В первом случае команды в регистр программы записываются извне. Во втором случае должен предусматриваться способ, как будет выполняться конфигурирование ячеек (т.е. выполняться загрузка регистров программы ячеек). Ячейки могут двояко воспринимать входную информацию. Когда ячейка формирует выходные сигналы сообразно с конфигурацией, она работает в «комбинационном» режиме или режиме обработки данных, как комбинационный логический блок.

Может быть введен дополнительный режим работы ячейки, называемый «режимом модификации», позволяющий интерпретировать входные данные как новое содержимое регистра программы. Ячейки входят в этот режим и выходят из него через скоординированный обмен с соседними ячейками. Во время этого скоординированного обмена соседняя ячейка предоставляет новую программу (таблицу истинности) для модифицируемой ячейки. Конфигурирование ячейки является чисто локальной операцией, в которой участвуют только две ячейки — та, которая имеет новое содержимое, и та, в которую это содержимое записывается.

Благодаря локальности, операции конфигурирования могут производиться одновременно во множестве различных областей матрицы ячеек.

Любая из ячеек матрицы может работать в любом из данных режимов. Не существует ячеек с заранее предопределенным режимом работы, он определяется данными от соседних ячеек на входах этой ячейки. В типовой сложной схеме матрица содержит ячейки, которые обрабатывают данные, и ячейки, которые участвуют в реконфигурации других ячеек.

Функционирование системы включает тесную кооперацию, взаимодействие, обмен между комбинационными узлами и узлами модификации. Можно не только обрабатывать данные на наборе ячеек, но и заставлять ячейки считывать и записывать конфигурацию других ячеек, что позволяет создавать динамические самоконфигурируемые системы, чье поведение во время выполнения может изменяться в зависимости от локальных событий.

АССОЦИАТИВНЫЕ СИСТЕМЫ

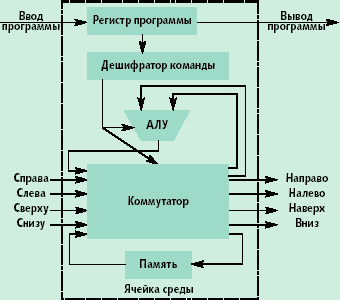

К числу систем класса ОКМД относятся ассоциативные системы. Эти системы, как и матричные, характеризуются большим числом операционных устройств, способных одновременно, по командам одного управляющего устройства вести обработку нескольких потоков данных. Но эти системы существенно отличаются от матричных способами формирования потоков данных. В матричных системах данные поступают на обработку от общих или раздельных запоминающих устройств с адресной выработкой информации либо непосредственно от устройств — источников данных. В ассоциативных системах информация на обработку поступает от ассоциативных запоминающих устройств (АЗУ), характеризующихся тем, что информация из них выбирается не по определенному адресу, а по ее содержанию. Принцип работы АЗУ поясняет схема, представленная на рис. 1. Запоминающий массив, как и в адресных ЗУ, разделен на m-разрядные ячейки, число которых п. Практически для любого типа АЗУ характерно наличие следующих элементов: запоминающего массива; регистра ассоциативных признаков (РгАП); регистра маски (РгМ); регистра индикаторов адреса со схемами сравнения на входе. В АЗУ могут быть и другие элементы, наличие и функции которых определяются способом использования АЗУ.

Рис.1 Ассоциативное запоминающее устройство

Выборка информации из АЗУ происходит следующим образом. В РгАП из устройства управления передается код признака искомой информации (иногда его называют компарандом). Код может иметь произвольное число разрядов — от 1 до т. Если код признаков используется полностью, то он без изменения поступает на схему сравнения, если же необходимо использовать только часть кода, Тогда ненужные разряды маскируются с помощью РгМ. Перед началом поиска информации в АЗУ все разряды регистра индикаторов адреса устанавливаются в состояние 1. После этого производится опрос первого разряда всех ячеек ЗМ и содержимое сравнивается с первым разрядом РгАП. Если содержимое первого разряда i-й ячейки не совпадает с содержимым первого разряда РгАП, то соответствующий этой ячейке разряд регистра индикаторов адреса Ti сбрасывается в состояние 0, если совпадает,— на Ti остается 1. Затем эта операция повторяется со вторым, третьим и последующими разрядами до тех пор, пока не будет произведено сравнение со всеми разрядами. РгАП. После поразрядного опроса и сравнения в состоянии 1 останься те разряды регистра индикаторов адреса, которые соответствуют ячейкам, содержащим информацию, совпадающую с записанной в РгАП. Эта информация может быть считана в той последовательности, которая определяется устройством управления.

Заметим, что время поиска информации в ЗМ по ассоциативному признаку зависит только от числа разрядов признака и от скорости опроса разрядов, но совершенно не зависит от числа ячеек ЗМ. Этим и определяется главное преимущество АЗУ перед адресными ЗУ: в адресных ЗУ при операций поиска необходим перебор всех ячеек запоминающего массива. Запись новой информации в ЗМ производится без указания номера ячейки. Обычно один из разрядов каждой ячейки используется для указания ее занятости, т. е. если ячейка свободна для записи, то в этом разряде записан 0, а если занята— 1. Тогда при записи в АЗУ новой информации устанавливается признак 0 в соответствующем разряде РгАП и определяются все ячейки ЗМ, которые свободны для записи. В одну из них устройство управления помещает новую информацию.

Нередко АЗУ строятся таким образом, что кроме ассоциативной допускается и прямая адресация данных, что представляет определенные удобства при работе с периферийными устройствами.

Необходимо отметить, что запоминающие элементы АЗУ в отличие от элементов адресуемых ЗУ должны не только хранить информацию, но и выполнять определенные логические функции, поэтому позволяют осуществить поиск не только по равенству содержимого ячейки заданному признаку, но и по другим условиям: содержимое ячейки больше (меньше) признака РгАП, а также больше или равно (меньше или равно).

Отмеченные выше свойства АЗУ характеризуют преимущества АЗУ для обработки информации. Формирование нескольких потоков идентичной информации с помощью АЗУ осуществляется быстро и просто, а с большим числом операционных элементов можно создавать высокопроизводительные. системы. Надо учитывать еще и то, что на основе ассоциативной памяти легко реализуется изменение места и порядка расположения информации. Благодаря этому АЗУ является эффективным средством формирования наборов данных.

Исследования показывают, что целый ряд задач, таких, как обработка радиолокационной информации, распознавание образов, обработка различных снимков и других задач с матричной структурой данных, эффективно решается ассоциативными системами. К тому же программирование таких задач для ассоциативных систем гораздо проще, чем для традиционных.

Наиболее характерным представителем группы ассоциативных вычислительных систем является система STARAN, разработанная в США. От матричных систем, описанных выше, она отличается не только наличием ассоциативной памяти, но и другими особенностями: ассоциативная память является памятью с многомерным доступом, т. е. в нее можно обратиться как поразрядно, так и пословно; операционные процессорные элементы предусмотрены для каждого слова памяти; имеется уникальная схема перестановок для перегруппировки данных в памяти.

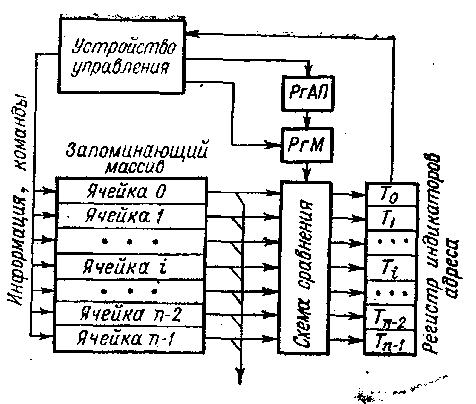

Основным элементом системы является многомерная ассоциативная матрица— ассоциативный модуль (AM), который представляет собой квадрат из 256 разрядов на 256 слов, т. е. содержит в общей сложности 65 536 бит данных. Для обработки информации имеется 256 процессорных элементов, которые последовательно, разряд за разрядом, обрабатывают слова (рис. 3.9). Все ПЭ работают одновременно, по одной команде, выдаваемой устройством управления. Таким образом, сразу по одной команде обрабатываются все выбранные по определенным признакам из памяти слова.

Схема перестановок позволяет сдвигать и перегруппировывав данные так, чтобы над словами хранящимися в памяти, можно было выполнять параллельно арифметические и логические операции.

Рис. 2. Процессорная обработка в системе STARAN

Большая часть операции выполняется в отношении каждого из 256-разрядных слов. Операции, в которых участвуют несколько слов, используются достаточно редко. Обычно 256-разрядное слово ассоциативной матрицы разбивается программистом на поля переменной длины, ив процессе обработки именно над этими полями производятся арифметические и логические действия.

Базовая конфигурация системы STARAN содержит один AM. Однако число этих модулей может варьироваться в системе от 1 до 32. Таким образом, при максимальной комплектации в системе может подвергаться ассоциативной обработке 256 кбайт информации. Скорость поиска и обработки информации 256 процессорными элементами высока, и остальные элементы системы спроектированы так, чтобы поддерживать эту скорость.

Устройство управления ассоциативными модулями организует выполнение операций над данными по командам, хранящимся в управляющей памяти. Оно может выбирать несколько рабочих подмножеств из общего множества данных, хранимых в AM, и выполнять над этими подсистемами операции, не затрагивая остальную информацию.

Управляющая память разделена на шесть секций: первая (емкостью 512 слов)—память библиотеки подпрограмм; вторая и третья (512 слов) — память команд; четвертая (512 слов)—быстродействующий буфер данных; пятая (16 384 слов)—основная память; шестая (10 720 слов) — область памяти для прямого доступа. Длина одного слова — 32 разряда. Первые четыре секции выполнены на интегральных схемах и имеют высокое быстродействие —длительность цикла памяти около 200 нс. Вторая и третья секции (память команд) работают попеременно: одна выдает команды в УУ, а другая в это время загружается от страничного устройства и наоборот. Пятая и шестая секции выполнены на ферритовых сердечниках, длительность цикла примерно 1 мкс. При необходимости емкость пятой секции может быть удвоена. Страничное устройство загружает первые три секции памяти информацией из быстродействующего буфера, основной памяти или памяти прямого доступа.

Последовательный контроллер ассоциативной системы является обычной однопроцессорной ЭВМ типа РДР-11 и обеспечивает: работу в режиме трансляции и отладки программ; первоначальную загрузку управляющей памяти; связь между оператором и системой; управление программами обработки прерываний по ошибкам, а также программами технической диагностики и обслуживания. Последовательный контроллер снабжен памятью (емкость 8 кслов), печатающим устройством, перфоленточным вводом — выводом и имеет интерфейс, обеспечивающий связь с другими элементами системы.

Подсистема ввода — вывода обеспечивает возможность подключения к системе STARAN других вычислительных устройств и разнообразного периферийного оборудования. Имеются четыре вида интерфейсов: прямой доступ к памяти; буферизованный ввод — вывод; параллельный ввод —вывод; логическое устройство внешних функций. Прямой доступ к памяти позволяет использовать память внешней (несистемной) ЭВМ как часть управляющей памяти системы. Эта память становится таким образом доступной как для внешней ЭВМ, так и для системы STARAN. При этом нет необходимости в буферизации передаваемой между ними информации.

Интерфейс прямого доступа может использоваться и для подключения внешней памяти. Буферизованный ввод — вывод используется для связи системы со стандартными периферийными устройствами, обмен производится блоками данных или программ. Этот интерфейс может использоваться и для связи с несистемной ЭВМ, однако прямой доступ там все-таки предпочтительнее, так как обмен производится быстрее и нет необходимости формирования информации в блоки перед передачей. Параллельный ввод — вывод, который включает в себя по 256 входов и 256 выходов для каждой матрицы, является важной составной частью подсистемы ввода — вывода. Он позволяет увеличить скорость передачи данных между матрицами, обеспечить связь системы с высокоскоростными средствами ввода — вывода и непосредственную связь любого устройства с ассоциативными модулями. С помощью параллельного' ввода — вывода можно, в частности, подключать к ассоциативным матрицам накопители на магнитных дисках, что позволяет быстро вводить и выводить большие объемы информации.

Совокупность всех перечисленных средств, входящих в систему STARAN, позволяет выполнять одновременно сотни и тысячи одинаковых операций при решении определенных классов задач.