- •1. Теория информации как наука. Информация, сообщения, сигналы (понятия).

- •2. Передача информации в информационной системе.

- •3. Случайные модели в задачах теории информации. Случайная величина.

- •4. Случайные модели в задачах теории информации. Случайное событие.

- •5. Измерение информации (меры информации)

- •6. Информационная мера Шеннона. Энтропия. Условная энтропия.

- •7. Свойства энтропии дискретного и непрерывного источников информации

- •4) Энтропия аддитивна

- •При одновременном наблюдении

- •8. Избыточность информации. Взаимная информация.

- •9. Обобщенные характеристики сигналов и каналов

- •10. Характеристика канала связи без помех. Теорема Шеннона для канала без помех.

- •11. Характеристика канала связи с помехами. Теорема Шеннона для канала с помехами.

- •I группа – основана на выборе метода передачи сообщений.

- •II группа – связана с построением помехоустойчивых приемников.

- •12. Значение результатов Шеннона.

- •13. Сжатие данных

- •14. Экономное кодирование

- •15. Процедуры Шеннона-Фано и Хаффмена

- •16. Помехоустойчивое кодирование. Основные принципы помехоустойчивого кодирования.

- •17. Помехоустойчивое кодирование. Помехоустойчивость кода. Корректирующие коды.

- •18. Помехоустойчивое кодирование. Методы помехоустойчивого кодирования.

- •19. Дискретизация информации. Теорема Котельникова.

- •20. Квантование по уровню. Дискретизация по времени.

8. Избыточность информации. Взаимная информация.

Избыточность информации Сообщения, энтропия которых максимальна, являются оптимальными с точки зрения символьного количества представляемой информации.

Мерой количественной оценки того, насколько данное реальное сообщение по своей энтропии отличается от соответствующего ему оптимального сообщения, является коэффициент сжатия.

![]() ;

;

где Н(ξ) – энтропия реального сообщения, max H(ξ) – энтропия соответствующего ему оптимального сообщения.

Если оптимальное и неоптимальное сообщение характеризуются одинаково общей энтропией, то

n*H(ξ) = n’*max H(ξ), где n – число элементов неоптимального сообщения, n’ – число элементов оптимального сообщения. Так как средняя на элемент оптимальная энтропия максимальна, то число элементов неоптимального сообщения больше числа элементов соответственного ему оптимального сообщения.

![]()

![]() ;

;

таким образом реальные сообщения при одинаковой информативности обладают определенной избыточностью в элементах по сравнению с оптимальными сообщениями.

Мерой количественной оценки избыточности является коэффициент избыточности.

![]() ;

;

смысл: это относительный избыток символов при передачи информации данным источником, которая потребуется по сравнению со случаем использования безызбыточного алфавита. Безызбыточный алфавит (ρ=0) характеризуется равными вероятностями появления символов. Избыточность приводит к повышению времени передачи сообщений, излишней загрузке канала связи. Однако, некоторая избыточность бывает полезной для обеспечения требуемой надежности систем, появления помехоустойчивости передачи сообщений.

Взаимной информацией

величин

![]() и

и![]() называется

называется![]()

Справедливы следующие соотношения:

![]()

![]()

![]()

![]()

![]()

![]()

![]()

Если

![]() и

и![]() независимы, то

независимы, то![]() =0.

=0.

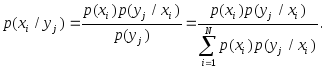

При расчетах условной энтропии и взаимной информации удобно пользоваться следующими соотношениями теории вероятностей:

1) теорема умножения

вероятностей

![]() ;

;

2) формула полной

вероятности

![]()

![]()

![]()

3) формула Байеса

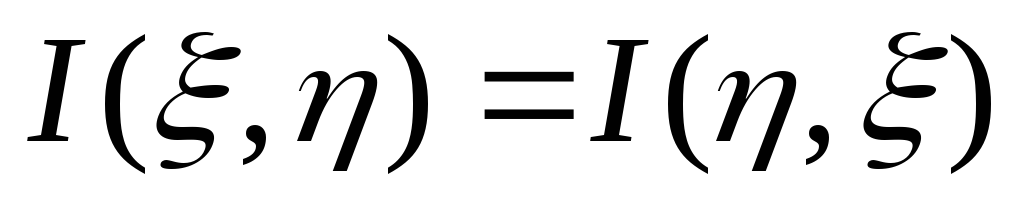

Свойства взаимной информации. Анализируя соотношение для взаимной информации можно установить следующие ее свойства (предлагаем провести доказательство самостоятельно):

,

т.е. наблюдая 7],

мы

получим о £ такое

же

количество информации, какое получим

о г),

наблюдая

£;

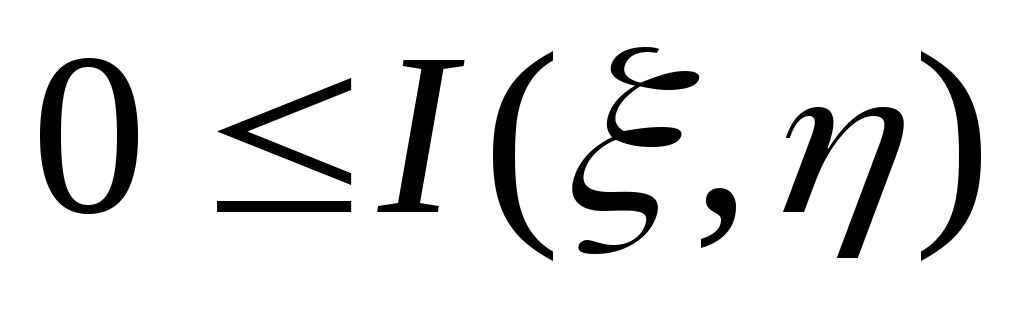

,

т.е. наблюдая 7],

мы

получим о £ такое

же

количество информации, какое получим

о г),

наблюдая

£; ,

причем равенство имеет место тогда и

только тогда,

когда £ и rj

статистически

независимы;

,

причем равенство имеет место тогда и

только тогда,

когда £ и rj

статистически

независимы;

3)

![]() ,

причем

равенство имеет место тогда и только

тогда, когда £ и п

взаимно

однозначны.

,

причем

равенство имеет место тогда и только

тогда, когда £ и п

взаимно

однозначны.

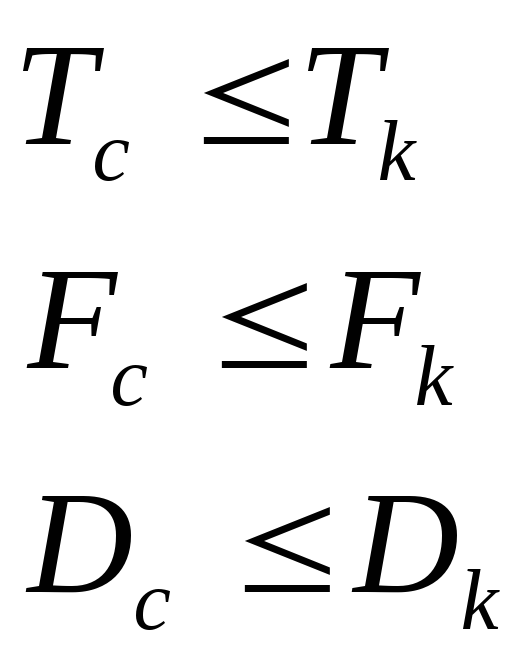

9. Обобщенные характеристики сигналов и каналов

Сигнал может быть охарактеризован различными параметрами. Таких параметров, вообще говоря, очень много, но для задач, которые приходится решать на практике, существенно лишь небольшое их число. Например, при выборе прибора для контроля технологического процесса может потребоваться знание дисперсии сигнала; если сигнал используется для управления, существенным является его мощность и так далее. Рассматривают три основных параметра сигнала, существенных для передачи информации по каналу. Первый важный параметр - это время передачи сигнала Tс. Второй характеристикой, которую приходится учитывать, является мощность Pс сигнала, передаваемого по каналу с определенным уровнем помех Pz . Чем больше значение Pс по сравнению с Pz, тем меньше вероятность ошибочного приема. Таким образом, представляет интерес отношение Pс /Pz. Удобно пользоваться логарифмом этого отношения, называемым превышением сигнала над помехой:

![]() Третьим

важным параметром

является спектр

частот Fc

.

Эти три

параметра позволяют представить любой

сигнал в трехмерном пространстве

с координатами L,

T,

F

в виде параллелепипеда с объемом Tc

Fc

Lc

. Это

произведение носит название объема

сигнала и обозначается через Vc

Третьим

важным параметром

является спектр

частот Fc

.

Эти три

параметра позволяют представить любой

сигнал в трехмерном пространстве

с координатами L,

T,

F

в виде параллелепипеда с объемом Tc

Fc

Lc

. Это

произведение носит название объема

сигнала и обозначается через Vc

![]() Информационный

канал можно характеризовать также тремя

соответствующими параметрами: временем

использования канала Тк

, шириной полосы частот, пропускаемых

каналом Fk,

и динамическим диапазоном канала Dk

характеризующим его способность

передавать различные уровни сигнала.

Информационный

канал можно характеризовать также тремя

соответствующими параметрами: временем

использования канала Тк

, шириной полосы частот, пропускаемых

каналом Fk,

и динамическим диапазоном канала Dk

характеризующим его способность

передавать различные уровни сигнала.

Величина![]() называется

емкостью канала.

называется

емкостью канала.

Неискаженная передача сигналов возможна только при условии, что сигнал по своему объему «вмещается» в емкость канала.

Следовательно,

общее условие согласования сигнала с

каналом передачи информации определяется

соотношением![]()

Однако соотношение выражает необходимое, но недостаточное условие согласования сигнала с каналом. Достаточным условием является согласование по всем параметрам:

Для информационного канала пользуются понятиями: скорость ввода информации, скорость передачи информации и пропускная способность канала.

Под скоростью ввода информации (потоком информации) V(A) понимают среднее количество информации, вводимое от источника сообщений в информационный канал в единицу времени. Эта характеристика источника сообщений и определяется только статистическими свойствами сообщений.

Скорость передачи информации V(X,Y) – среднее количество информации, передаваемое по каналу в единицу времени. Она зависит от статистических свойств передаваемого сигнала и от свойств канала.

Пропускная способность С – наибольшая теоретически достижимая для данного канала скорость передачи информации. Это характеристика канала и не зависит от статистики сигнала.

С целью наиболее эффективного использования информационного канала необходимо принимать меры к тому, чтобы скорость передачи информации была как можно ближе к пропускной способности канала. Вместе с тем скорость ввода информации не должна превышать пропускную способность канала, иначе не вся информация будет передана по каналу.

Это основное условие динамического согласования источника сообщений и информационного канала.

Одним из основных вопросов в теории передачи информации является определение зависимости скорости передачи информации и пропускной способности от параметров канала и характеристик сигналов и помех. Эти вопросы были впервые глубоко исследованы К. Шенноном.