§ 4. Классификация с частичным обучением. Параметрический случай

В области социально-экономических исследований сравнительно распространены ситуации, в которых исследователю неизвестно заранее сколько типов (классов, объектов) представлено в изучаемой выборке

![]() ,

,

однако, предварительные сведения или специальные экспертные оценки помогают выделить определенные, как правило, небольшие «порции» данных вида {Xj} из выборки {Xj} или помимо нее, о каждой из которых известно, что эта порция представляет лишь один какой-то класс.

Учитывая определение частичной обучающей выборки, данное в § 1 настоящей главы, естественно назвать подобные задачи классификацией при наличии частичного обучения. В этом параграфе мы рассмотрим процедуру классификации на неизвестное число классов при наличии частичного обучения и ее свойства применительно к одной частной схеме.

Предположим, что каждый из векторов наблюдений Xj исследуемой выборки извлечен из какой-то нормальной генеральной совокупности, принадлежащей семейству

![]() ,

,

где

вектор средних

значений, а

![]() - матрица ковариаций компонент исследуемых

случайных величинXi,

общая для всех рассматриваемых генеральных

совокупностей. Предположим также, что

- матрица ковариаций компонент исследуемых

случайных величинXi,

общая для всех рассматриваемых генеральных

совокупностей. Предположим также, что

![]() ,

где, как и прежде,m

- общее число наблюдений, составляющих

s

частичных обучающих выборок.

,

где, как и прежде,m

- общее число наблюдений, составляющих

s

частичных обучающих выборок.

Введем в рассмотрение априорные вероятности l (l = 1, 2, ....K) появления объекта l-го класса, или иначе l - это удельный вес l -го класса среди всех исследуемых классов. При этом, вообще говоря, al, , K и l (l = 1, 2, ....K) нам неизвестны, а K может быть и +. Будем для определенности предполагать, что наблюдения, участвующие в частичных обучающих выборках, не входят в состав исследуемой выборки {Xj}. Этого всегда можно добиться с помощью предварительного исключения этих наблюдений из состава выборки {Xj}.

1. Описание процедуры классификации

Следуя [9] и [15], определим понятие минимального дистанционного разбиения

![]()

относительно заданных центров

![]()

и заданного числа классов k. Выше и далее Zi - вектор в рассматриваемом нами р-мерном пространстве R(p) с заданной в нем метрикой . В соответствии с этим разбиением класс Si(Z) состоит из точек пространства R(p), ближайших в смысле метрики к Zi, причем точки, равноотстоящие от нескольких центров Zi, относятся к классу с наименьшим индексом. Так что, если ввести множества1

![]() ,

,

то

Пусть v - номер шага процедуры классификации, что в нашем случае совпадает с текущим номером последовательно извлекаемых из {Xj} наблюдений Хv.

Сущность описываемой процедуры в предварительном (по v) уточнении «центров тяжести» классов

![]()

и их числа k(v), а затем использование получаемой на последнем n-м шаге последовательности центров Z(n) для образования классов

![]()

с помощью

определенного выше минимального

дистанционного разбиения

![]() .

.

Введем в рассмотрение

![]() - расстояние махаланобисского типа

между случайными векторамиХ

и Y

в исследуемом p-мерном

пространстве R(p).

- расстояние махаланобисского типа

между случайными векторамиХ

и Y

в исследуемом p-мерном

пространстве R(p).

![]() ,

,

где - ковариационная матрица и для Х и для Y.

Пусть

![]() - оценка максимального правдоподобия

с устраненным смещением для,

построенная по совокупности частичных

обучающих ,выборок,

- оценка максимального правдоподобия

с устраненным смещением для,

построенная по совокупности частичных

обучающих ,выборок,

![]() ,

,

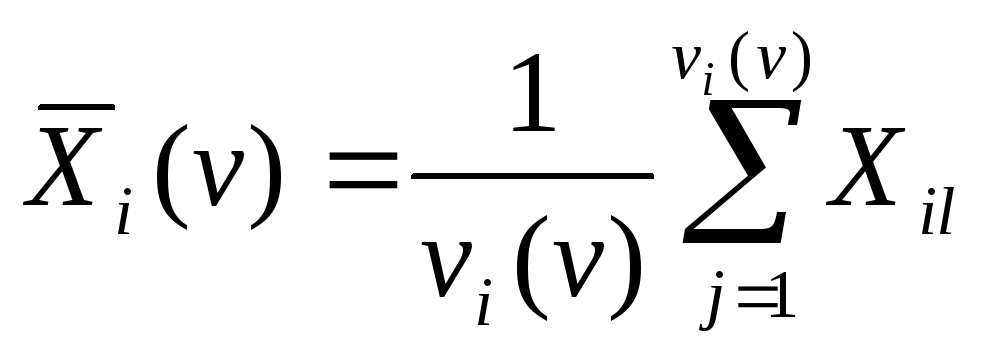

арифметическое

среднее vi(v)

наблюдений, выбранных некоторым образом

из v

первых членов последовательности {Xj},

причем, вообще говоря,

![]() ,

гдеаil

- какие-то векторы средних, возможно и

повторяющихся, из числа аj

(j

= 1, 2, ...,K),

ранее рассмотренных. И, наконец, обозначим

,

гдеаil

- какие-то векторы средних, возможно и

повторяющихся, из числа аj

(j

= 1, 2, ...,K),

ранее рассмотренных. И, наконец, обозначим

![]()

где vi(v)

- число точек из последовательности

![]() ,

участвующих в вычислении переменного

центра тяжестиi-го

класса Ziv

,

участвующих в вычислении переменного

центра тяжестиi-го

класса Ziv

![]() .

.

На первом шаге

процедуры из случайной последовательности

берется Xi

и принимается в качестве центра первого

класса, т. е. при v

= 1, k(1)

= 1 и

![]() .

.

На втором шаге процедуры (v = 2) извлекаем X2 и подсчитываем

![]() .

.

Если

![]() ,

где

,

где![]() - 100%-ная

точка центрального F-распределения

с числами степеней свободы числителя

и знаменателя соответственно q

и r,

то X2

принимается в качестве центра второго

класса, т. е. k(2)

= 2 и

- 100%-ная

точка центрального F-распределения

с числами степеней свободы числителя

и знаменателя соответственно q

и r,

то X2

принимается в качестве центра второго

класса, т. е. k(2)

= 2 и

![]() .

.

Если же

![]() ,

тоX2

присоединяется к первому классу, центр

которого пересчитывается

,

тоX2

присоединяется к первому классу, центр

которого пересчитывается

![]()

и, следовательно,

k(2)

= 1,

![]() .

.

На (v + 1)-м шаге процедуры вначале подсчитывается величина

![]() .

.

Если

![]() ,

,

то

![]()

![]()

и переходит к следующему шагу, т. е. к рассмотрению точки Xv+2.

Если же

![]() ,

то точка Xv+1

относится к i0-му

классу, центр которого пересчитывается

по формуле

,

то точка Xv+1

относится к i0-му

классу, центр которого пересчитывается

по формуле

![]() .

.

Этап А. Положив в остальных классах

![]() ,

,

подсчитываем

величины

![]() ,

j

= 1, 2, ...,k(v),

,

j

= 1, 2, ...,k(v),

![]() .

Если окажется, что

.

Если окажется, что

![]() , (1.13)

, (1.13)

то полагают

![]() ,

,

![]() (i

= 1, 2, …, k(v))

(i

= 1, 2, …, k(v))

и переходят к следующему шагу, т. е. к рассмотрению точки Xv+2. Если же

![]() ,

,

то центр тяжести класса с номером i = min (i0, j0) пересчитывается по формуле

![]() ,

,

а для

![]() и

и![]()

![]() причем классам с порядковыми номерами

причем классам с порядковыми номерами![]() присваиваются номера на единицу меньшие

(за счет «исчезновения» класса с

порядковым номером, равным

присваиваются номера на единицу меньшие

(за счет «исчезновения» класса с

порядковым номером, равным![]() ).

Далее повторяется процедураА

с заменой i0

на i

и

).

Далее повторяется процедураА

с заменой i0

на i

и

![]() на

на![]() до тех пор, пока не окажется выполненным

соотношение (1.13), либо не останется всего

лишь один класс.

до тех пор, пока не окажется выполненным

соотношение (1.13), либо не останется всего

лишь один класс.

Последним (n

+ 1)-м шагом процедуры является реализация

минимального дистанционного разбиения

![]() относительноk(n)

- точки Z(n),

полученной на предыдущем шаге.

относительноk(n)

- точки Z(n),

полученной на предыдущем шаге.

Замечание 1. При сравнительно небольших объемах исследуемых выборок n можно использовать один из двух, или оба сразу вспомогательных приема:

циклическое продолжение выборки, т. е. реализация описанной процедуры на искусственно удлиненных последовательностях вида