- •Глава 5 линейные разделяющие функции

- •5.1. Введение

- •5.2. Линейные разделяющие функции и поверхности решений

- •5.2.1. Случай двух классов

- •5.2.2. Случай многих классов

- •5.3. Обобщенные линейные разделяющие функции

- •5.4. Случай двух линейно разделимых классов

- •5.4.1. Геометрия и принятая терминология

- •5.4.2. Процедуры основанные на методе градиентного спуска

- •5.5. Минимизация персептронной функции критерия

- •5.5.1. Персептронная функция критерия

- •5.5.2. Доказательство сходимости для случая коррекции по одной выборке

- •5.5.3. Некоторые непосредственные обобщения

- •5.6. Процедуры релаксаций

- •5.6.1. Алгоритм спуска

- •5.6.2. Доказательство сходимости

- •5.7. Поведение процедур в случае неразделяемых множеств

- •5.8. Процедуры минимизации квадратичной ошибки

- •5.8.1. Минимальная квадратичная ошибка и псевдообращение

- •5.8.2. Связь с линейным дискриминантом Фишера

- •5.8.3. Асимптотическое приближение к оптимальному дискриминанту

- •5.8.4. Процедура Видроу - Хоффа

- •5.8.5. Методы стохастической аппроксимации

- •5.9. Процедуры Хо — Кашьяпа

- •5.9.1. Процедура спуска

- •5.9.2. Доказательство сходимости

- •5.9.3. Поведение в случае неразделяемых множеств

- •5.9.4. Некоторые связанные процедуры

- •5.10. Процедуры линейного программирования

- •5.10.1. Линейное программирование

- •5.10.2. Случай линейно разделяемых множеств

- •5.10.3. Минимизация персептронной функции критерия

- •5.10.4. Замечания

- •5.11. Метод потенциальных функций

- •5.12. Обобщения для случая многих классов

- •5.12.1. Метод Кеслера

- •5.12.2. Правило постоянных приращений

- •5.12.3. Обобщение метода наименьших квадратов

- •5.13. Библиографические и исторические сведения

5.5.2. Доказательство сходимости для случая коррекции по одной выборке

Исследование

сходимости алгоритма спуска удобно

начать с варианта, более легкого для

анализа. Вместо определения

![]() по всем выборкам и осуществления

коррекции по множеству классифицируемых

с ошибкой выборок Yk

выборки будут рассматриваться

последовательно, и весовой вектор будет

изменяться всякий раз, когда некоторая

выборка будет классифицироваться с

ошибкой. Для доказательства сходимости

подробная характеристика данной

последовательности неважна, коль скоро

каждая выборка появляется в

последовательности бесконечно большое

число раз. Наиболее просто убедиться

в этом, повторяя выборки циклически.

по всем выборкам и осуществления

коррекции по множеству классифицируемых

с ошибкой выборок Yk

выборки будут рассматриваться

последовательно, и весовой вектор будет

изменяться всякий раз, когда некоторая

выборка будет классифицироваться с

ошибкой. Для доказательства сходимости

подробная характеристика данной

последовательности неважна, коль скоро

каждая выборка появляется в

последовательности бесконечно большое

число раз. Наиболее просто убедиться

в этом, повторяя выборки циклически.

Два

последующих упрощения помогут лучшему

пониманию излагаемого материала.

Во-первых, временно ограничимся случаем,

когда

![]() является константой. Это так называемый

случай с постоянным

приращением.

Из соотношения

(13) следует,

что если

является константой. Это так называемый

случай с постоянным

приращением.

Из соотношения

(13) следует,

что если

![]() — величина

постоянная, то она служит лишь для

масштабирования выборок. Таким образом,

в случае с постоянным приращением

можно, без ущерба для общности, положить

— величина

постоянная, то она служит лишь для

масштабирования выборок. Таким образом,

в случае с постоянным приращением

можно, без ущерба для общности, положить

![]() =1.

Второе упрощение состоит лишь в

введении обозначений. Когда выборки

рассматриваются последовательно,

некоторые из них классифицируются с

ошибкой. Поскольку весовой вектор

изменяют лишь при наличии ошибки,

внимание фактически сосредоточивается

только на выборках, классифицируемых

с ошибкой. Таким образом, последовательность

выборок обозначается через y1,

у2,

. . . , уk,

. . . , где

каждый уk

является одной из n

выборок

y1,

. .

., yn

и каждая выборка

yk

классифицируется

с ошибкой. Например, при циклическом

повторении выборок

y1,

у2

и у3,

если отмеченные выборки

=1.

Второе упрощение состоит лишь в

введении обозначений. Когда выборки

рассматриваются последовательно,

некоторые из них классифицируются с

ошибкой. Поскольку весовой вектор

изменяют лишь при наличии ошибки,

внимание фактически сосредоточивается

только на выборках, классифицируемых

с ошибкой. Таким образом, последовательность

выборок обозначается через y1,

у2,

. . . , уk,

. . . , где

каждый уk

является одной из n

выборок

y1,

. .

., yn

и каждая выборка

yk

классифицируется

с ошибкой. Например, при циклическом

повторении выборок

y1,

у2

и у3,

если отмеченные выборки

![]() ,

,![]() ,

,![]() ,

,![]() ,

,![]() ,

,![]() ,

,![]() ,

,![]() ,…

,…

классифицируются с ошибкой, то последовательность y1, у2, у3, у4, у5, . . . обозначает последовательность y1, у3, y1, у2, у2,. . . . Исходя из данного объяснения, для образования последовательности весовых векторов может быть записано правило постоянного приращения:

(14)

(14)

где

![]() для всехk.

для всехk.

Правило постоянного приращения является простейшим из числа многих алгоритмов, которые предлагались для решения систем линейных неравенств. Впервые оно появилось при введении схемы обучения с подкреплением, предложенной Ф. Розенблаттом для его персептронной модели мозга и доказательства сходимости последней, известного под названием теоремы сходимости персептрона.

В

частности, можно дать ее геометрическую

интерпретацию в весовом пространстве.

Поскольку вектор

![]() классифицирует уk

с ошибкой, то

классифицирует уk

с ошибкой, то

![]() не будет находиться с положительной

стороны уk,

принадлежащего гиперплоскости

не будет находиться с положительной

стороны уk,

принадлежащего гиперплоскости

![]() .

Прибавление уk

к вектору

.

Прибавление уk

к вектору

![]() смещает весовой вектор непосредственно

в направлении к данной гиперплоскости

при возможности ее пересечения (рис.

5.10).

Независимо от того, пересечется ли

гиперплоскость или нет, новое скалярное

произведение

смещает весовой вектор непосредственно

в направлении к данной гиперплоскости

при возможности ее пересечения (рис.

5.10).

Независимо от того, пересечется ли

гиперплоскость или нет, новое скалярное

произведение

![]() будет больше прежнего

будет больше прежнего

Рис. 5.10.Шаг, соответствующий правилу постоянного приращения.

произведения

![]() на величину ||уk||2,

в результате получаем, что вследствие

коррекции весовой вектор смещается

в нужном направлении.

на величину ||уk||2,

в результате получаем, что вследствие

коррекции весовой вектор смещается

в нужном направлении.

Покажем

теперь, что, если выборки линейно

разделяемы, последовательность

весовых векторов будет ограничиваться

вектором решения. При доказательстве

необходимо отметить, что каждая процедура

коррекции сдвигает весовой вектор

ближе к области решения. То есть следует

показать, что если

![]() является любым вектором решения, то

значение ||ak+1—

является любым вектором решения, то

значение ||ak+1—![]() ||

меньше значения ||аk—

||

меньше значения ||аk—

![]() ||.

Хотя в общем случае данное утверждение

оказывается несправедливым, будет

показано, что оно выполняется для

векторов решения, имеющих достаточную

длину.

||.

Хотя в общем случае данное утверждение

оказывается несправедливым, будет

показано, что оно выполняется для

векторов решения, имеющих достаточную

длину.

Пусть

![]() —

вектор решения, так что величина

—

вектор решения, так что величина

![]() уi

строго положительна для всех i,

a

уi

строго положительна для всех i,

a

![]() — положительный

скалярный коэффициент. Из соотношения

(14) следует,

что

— положительный

скалярный коэффициент. Из соотношения

(14) следует,

что

![]()

тогда

![]()

Поскольку

уk

классифицировался с ошибкой, то

![]() ,

и, таким образом, можно записать следующее

выражение:

,

и, таким образом, можно записать следующее

выражение:

![]()

Так

как величина

![]() строго положительна, второй член будет

по модулю превосходить третий при

условии, что значение

строго положительна, второй член будет

по модулю превосходить третий при

условии, что значение

![]() ,

достаточно велико. В частности, если

положить

,

достаточно велико. В частности, если

положить

![]() (15)

(15)

и

![]() (16)

(16)

то

![]()

и если выбрать

![]() (17)

(17)

то получим следующее выражение:

![]()

Таким

образом, квадрат расстояния от

![]() до

до

![]()

![]() при каждой коррекции будет уменьшаться,

по крайней мере на величину

при каждой коррекции будет уменьшаться,

по крайней мере на величину

![]() ,

и послеk

коррекций

представится в следующем виде:

,

и послеk

коррекций

представится в следующем виде:

![]()

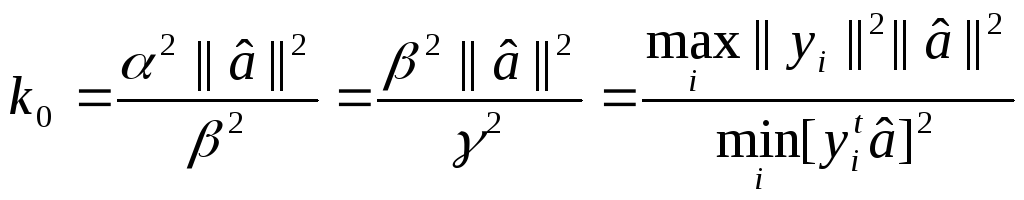

Поскольку величина квадрата расстояния не может быть отрицательной, из этого следует, что последовательность коррекций должна быть ограничена числом коррекций, не большим чем k0, где

![]() (18)

(18)

Поскольку коррекция осуществляется всякий раз, когда выборка классифицируется с ошибкой, и поскольку каждая выборка появляется бесконечно большое число раз в последовательности, отсюда следует, что после прекращения процесса коррекций полученный весовой вектор должен правильно осуществлять классификацию всех выборок.

Число k0 определяет предельное значение числа коррекций. Если a1=0, получается следующее достаточно простое выражение для k0:

(19)

(19)

Данное выражение показывает, что трудность задачи в основном определяется наличием выборок, наиболее близких к ортогональным по отношению к вектору решения. К сожалению, указанное выражение невозможно использовать при рассмотрении нерешенной задачи, поскольку в данном случае граница должна определяться исходя из неизвестного вектора решения. Очевидно, что в общем случае задачи с линейно разделяемыми множествами могут представлять известные трудности для определения решения в условиях компланарности выборок. Тем не менее, если выборки линейно разделяемы, правило постоянного приращения будет давать решение после конечного числа коррекций.