- •Максим Кульгин Технологии корпоративных сетей. Энциклопедия

- •Часть I основы корпоративных сетей.

- •1. Базовые сетевые технологии

- •Соединения и каналы

- •Технологии b-isdn и atm

- •Технология Frame Relay

- •Технология isdn

- •Плезиохронная и синхронная цифровые иерархии

- •Технология sonet

- •Технология smds

- •Технология Ethernet

- •Дальнейшее развитие технологии Ethernet

- •Технология 100vg-AnyLan

- •2. Методология построения корпоративной сети

- •Сравнение современных технологий передачи данных

- •Требования к сети

- •Архитектура сети

- •Магистраль на базе коммутации ячеек

- •Маршрутизация

- •Коммутация

- •Выделение маршрутов

- •Сетевые шаблоны

- •Сетевой шаблон глобальной сети

- •Сетевой шаблон городской сети

- •Шаблон городской сети с технологией sonet/sdh

- •Шаблон городской сети с передачей atm поверх sonet/sdh

- •Шаблон городской сети, как расширенной локальной сети

- •Сетевой шаблон центрального офиса

- •Реализация доступа и магистрали

- •Критерии выбора технологии

- •3. Качество обслуживания в современных сетях

- •Характеристики трафика

- •Трафик разных приложений

- •Качество обслуживания «на самоокупаемости»

- •Обзор технологий качества обслуживания

- •Обеспечение перекрывающей пропускной способности

- •Приоритетные очереди в маршрутизаторах

- •Протокол резервирования ресурсов

- •Установление приоритетов в виртуальных сетях

- •Качество обслуживания в сетях Frame Relay

- •Качество обслуживания в сетях atm

- •Рекомендации

- •4. Модель и уровни osi

- •Эталонная модель osi

- •Протоколы и интерфейсы

- •Уровни модели osi Физический уровень

- •Канальный уровень

- •Сетевой уровень

- •Транспортный уровень

- •Сеансовый уровень

- •Уровень представления

- •Прикладной уровень

- •Назначение уровней модели osi

- •5. Основные типы сетевых устройств

- •Витая пара

- •Коаксиальный кабель

- •Оптоволоконный кабель

- •Сетевые адаптеры

- •Концентраторы

- •Коммутаторы

- •Коммутация «на лету»

- •Коммутация с буферизацией

- •Бесфрагментная коммутация

- •Дополнительные функции коммутаторов

- •Протокол stp

- •Протокол stp и виртуальные сети

- •Протокол stp: заключение

- •Маршрутизаторы

- •Брандмауэры

- •Часть II стек протоколов тср/ip

- •6. Ip и другие протоколы нижнего уровня

- •Протокол ip

- •Протокол arp

- •Протокол 1смр

- •Протокол udp

- •Протокол rtp

- •Адресная схема протокола ip

- •7. Протокол tcp

- •Формат заголовка

- •Состояние системы

- •Блок управления передачей

- •Установление и закрытие соединений

- •Плавающее окно

- •Пропускная способность

- •Контроль за перегрузками

- •Управление потоком данных

- •Политики отправки и приема сегментов

- •Таймер повторной передачи

- •Адаптивный таймер повторной передачи

- •Узкие места в сети

- •Протокол tcp в сетях atm

- •8. Маршрутицазия протокола ip

- •Автономные системы

- •Подсети

- •Маска подсети

- •Протокол rip

- •Маска подсети переменной длины

- •9. Протоколы маршрутизации Протокол ospf

- •Протоколы igrp и eigrp

- •Протоколы политики маршрутизации egp и bgp

- •Протокол igmp

- •Алгоритмы построения дерева доставки

- •Магистраль mbone

- •Протоколы групповой маршрутизации Протокол dvmrp

- •Протокол mospf

- •Протокол рiм

- •Бесклассовая междоменная маршрутизация

- •Часть III Технология atm

- •10. Введение в технологию атм

- •Появление atm

- •Форум atm

- •Основные компоненты atm

- •Уровни atm

- •Уровень адаптации atm

- •Уровень atm

- •Физический уровень

- •Прямая передача ячеек

- •Использование транспортных кадров

- •Использование plcp

- •Интерфейсы atm

- •Мультиплексирование в сетях atm

- •Инверсное мультиплексирование

- •Безопасность в сетях atm

- •Сигнализация atm

- •11. Основы технологии атм Соединения atm

- •Сети без установления соединения

- •Сети с установлением соединения

- •Виртуальные соединения в сетях atm

- •Типы виртуальных соединений

- •Виртуальные пути и виртуальные каналы

- •Установление соединений atm

- •Ячейки atm

- •Сети с передачей ячеек

- •Формат ячеек atm

- •Ячейки формата uni

- •Ячейки формата nn1

- •Подготовка ячеек к передаче

- •Уровень адаптации aal1

- •Уровень адаптации aal3/4

- •Уровень адаптации aal5

- •Адресация atm

- •Адрес dcc aesa

- •Адреса icd и е.164 aesa

- •Управление адресами

- •12. Коммутация и маршрутизация в атм Коммутаторы atm

- •Архитектура коммутаторов atm

- •Интеграционные функции коммутаторов

- •Управляемость

- •Маршрутизация в atm

- •Протокол маршрутизации запросов pnni

- •Протокол сигнализации pnni

- •Качество обслуживания

- •Протокол tcp

- •Протокол udp

- •Резервирование ресурсов и протоколы управления потоком данных

- •Организация очередей в маршрутизаторе

- •Метод явного контроля скорости

- •14. Интегрированные и дифференцированные услуги Качество обслуживания

- •Интегрированные услуги

- •Сервисные уровни обслуживания

- •Сервисное управление нагрузкой

- •Гарантируемое обслуживание

- •Протокол резервирования ресурсов rsvp

- •Стили резервирования

- •Развитие сетей с is

- •Дифференцированные услуги

- •Архитектура системы с предоставлением ds

- •Граничные устройства домена ds

- •Внутренние устройства домена ds

- •Выходные домены

- •Использование протокола rsvp в сетях с ds

- •15. Управление трафиком в атм

- •Трафик-контракт

- •Параметры трафика

- •Категории сервиса

- •Связь механизмов управления трафиком

- •Контроль за установлением соединения

- •Контроль за использованием полосы пропускания

- •Формирование трафика

- •Контроль потока abr

- •Контроль приоритетов

- •Организация очередей в коммутаторах

- •Реализация очередей для службы ubr

- •Реализация очередей для службы abr

- •Методы отбрасывания пакетов

- •Адаптивное управление буферами в коммутаторах

- •16. Интеграция с атм

- •Протокол ip поверх atm

- •Передача ip-Дейтаграмм по сети atm

- •Взаимодействие устройств в одной логической подсети

- •Групповая доставка информации в сети atm

- •Взаимодействие устройств в разных логических подсетях

- •Протокол nhrp

- •Оценка потерь при работе протокола ip поверх atm

- •Передача ip-дейтаграмм в кадрах sonet

- •Технология эмуляции локальной сети — lane

- •Концепция lane

- •Технология мроа

- •Клиент мроа

- •Сервер мроа

- •Взаимодействие технологий мроа и nhrp

- •Масштабируемость в глобальных сетях

- •Технология Tag Switching фирмы Cisco

- •Технология aris фирмы ibm

- •Технология mpls комитета ietf

- •Перспективные разработки. Рекомендации

- •Взаимодействие технологий atm и Frame Relay

- •17. Интеграция маршрутизации и коммуникации

- •Общие вопросы выбора технологий

- •Коммутирующие маршрутизаторы

- •Коммутация третьего уровня в atm

- •Технологии фирм Ipsilon и Toshiba

- •Технология FastIp фирмы 3Com

- •Технология NetFlow фирмы Cisco

- •Технология SecureFast фирмы Cabletron

- •Технология Multiprotocol Switched Services фирмы ibm

- •18. Мультимедиа в сети

- •Передача видеоинформации

- •Технические требования к передаче видеоинформации в сетях atm

- •Некоторые рекомендации по созданию сетей atm с видео

- •Передача голоса

- •Часть V Приложения

- •1. Стандарты стека протоколов tcp/ip

- •2. Порты протоколов tcp и udp

- •3. Выделение ip - подсетей

- •4. Теория очередей и расчет параметров сети

- •5. Организации по стандартизации

- •6 Список фирм - членов Форума атм

- •7. Спецификации Форума атм

- •8. Список терминов

- •9. Список литературы Основная литература

- •Дополнительная литература Технология atm и протокол ip поверх atm

- •Технология качества обслуживания

- •Система ip-адресаиии

- •Некоторые ресурсы Internet

- •Алфавитный указатель

- •Оглавление

- •Часть I 3

- •Часть II 109

- •Часть III Технология atm 207

- •Часть IV 269

- •Часть V Приложения 402

Контроль приоритетов

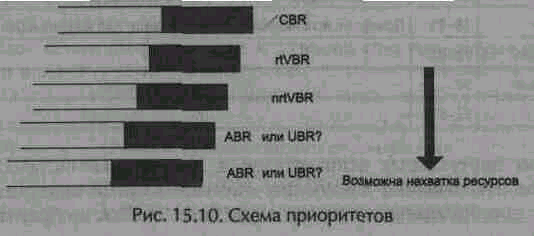

Одной из задач, решаемых коммутатором ATM, является выбор ячейки, которая должна быть послана следующей. Наиболее простым методом выбора является строгое следование схеме приоритетов. Например, если в буфере находятся ячейки, относящиеся к трафику с постоянной скоростью (CBR), они должны быть отправлены в первую очередь. Если же таких нет, то нужно передавать ячейки, относящиеся к службе rtVBR. Если такие ячейки также отсутствуют, то передаются ячейки службы nrtVBR и т. д., до тех пор, пока не будут обслужены все категории трафика (рис. 15.10)

К сожалению, описанная методика наталкивается на проблему нехватки ресурсов. Можно допустить, чтобы трафик CBR имел приоритет перед любыми другими категориями, поскольку он не порождает внезапных всплесков и всегда оставляет часть полосы пропускания доступной для остальных служб. Однако если наивысший приоритет получит трафик VBR, не исключено, что многочисленные виртуальные соединения данного типа одновременно начнут передачу на максимальной скорости. В результате общий объем передаваемых данных может превысить имеющуюся полосу пропускания, и тогда менее приоритетные службы могут быть полностью приостановлены. При этом возможно возникновение временного тайм-аута для пользовательских приложений, которые обязаны провести повторную передачу данных, что может привести к перегрузке сети. Данная проблема еще более усугубляется, если дать приоритетные права службам UBR или ABR. Дело в том, что данные службы рассчитаны на использование всей имеющейся полосы пропускания, так что ячейки с более низким приоритетом будут постоянно дискриминироваться.

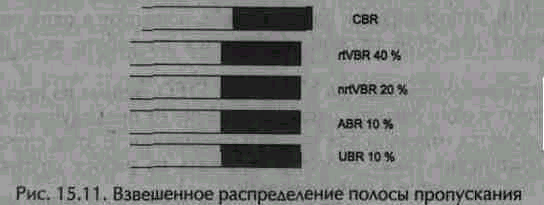

Более сложная, но менее проблематичная схема выбора ячеек для передачи сводится к тому, чтобы при наиболее высоком приоритете службы CBR (необходимом для достижения высокого качества сервиса), поддерживалось некоторое взвешенное распределение полосы пропускания между остальными службами (рис. 15.11).

На практике значения, указанные на рис. 15.11, приходится рассчитывать заново при установлении или разрыве очередного виртуального соединения.

Организация очередей в коммутаторах

Эффективность использования свободной полосы пропускания напрямую связана с организацией очередей в коммутаторах ATM. В табл. 15.8 приведено краткое описание различных алгоритмов организации очередей.

Поступающие в коммутатор ATM данные не могут быть обработаны мгновенно. Необходимо какое-то время для принятия решения о том, что с ними делать. Для их промежуточного хранения необходима буферная память. Механизм управления буфером является одним из основным механизмов управления трафиком. Буферная память должна динамически выделяться тому или иному потоку в зависимости от требуемого качества обслуживания. Для организации отдельных очередей для каждого виртуального соединения можно разделить общую буферную память на несколько частей, каждая из которых будет предназначаться для трафика с определенным качеством обслуживания. При этом объем выделяемой части буфера и алгоритм работы с ней напрямую связан с типом трафика. Каждый буфер обслуживает свои очереди; на один порт может приходиться несколько очередей. При выборе объема буфера следует учитывать следующее обстоятельство: чем больше объем буфера, тем, в общем случае, выше цена оборудования. С другой стороны, достаточно емкий буфер способен обеспечить защиту от перегрузок.

Таблица 15.8. Алгоритмы организации очередей

Алгоритм очереди

|

Описание

|

Очередь FIFO

|

Все виртуальные соединения, относящиеся к одной категории сервиса, помещаются в одну очередь и одинаково страдают от перегрузок

|

Очередь FIFO с раздельным определением перегрузки

|

Все виртуальные соединения, относящиеся к одной категории сервиса, помещаются в одну очередь. При этом состояние перегрузки определяется для каждого соединения, но перегрузка одного соединения все еще влияет на другие, так как они используют одну очередь

|

Раздельные очереди для каждого виртуального соединения

|

Каждое виртуальное соединение имеет свою собственную очередь. Перегрузки в одном соединении не влияют на другие

|

При формировании очередей по принципу FIFO ячейки из всех виртуальных соединений, относящихся к одной службе, попадают в одну очередь, и нехватка ресурсов для этой службы сказывается на работе всех виртуальных соединений.

При раздельном учете каналов в очередях FIFO данные из всех соединений также попадают в одну очередь, однако в отличие от предыдущего метода перегрузка определяется отдельно для каждого соединения. В этом случае перегрузка любого соединения также способна повлиять на работу других, поскольку данные для них находятся в одной очереди.

В случае, если коммутатор ATM поддерживает отдельные очереди для каждого виртуального соединения, перегрузка одного соединения никак не повлияет на остальные.