Нейронные сети (ИПОВС) / 4 курс - Рычагов М.Н. / Лекции / Lektsiya_1_Neyronnyie_seti_i_mashinnoe_obuchenie

.pdf

Нейронные сети и машинное обучение.

Основные исторические сведения

Лекция 1

Рычагов М.Н., профессор, д.ф.-м.н.

Содержание курса

© 2019 МИЭТ, Нейронные сети |

2 |

|

2 |

Программа курса: лекции

Л.1. Введение. НС как инструментарий интеллектуальных систем. Машинное обучение

Л.2. Модели нейрона. Однослойный перцептрон. Логические НС операции.

Л.3. Многослойный перцептрон. Реализация операции «Исключающее ИЛИ».

Л.4. Обучение НС. Алгоритм обратного распространения.

Л.5. Нейронные сети с обратными связями. Ассоциативная память. НС Хопфилда.

Л.6. Свёрточные НС. Глубинное обучение.

© 2019 МИЭТ, Нейронные сети |

3 |

|

3 |

Программа курса: лабораторные работы

Л.р.1. Трудоемкость алгоритма обработки данных. Моделирование функций активации нейрона.

Л.р.1. Нейрон Мак-Каллока-Питтса. Правило обучения Хэбба. Логические НС операции.

Л.р.3. Создание однонаправленной НС с помощью НС инструментария MATLAB.

Л.р.4. Изучение свойств многослойного персептрона. Алгоритм обратного распространения ошибки.

Л.р.5. НС распознавание изображений (символов).

Л.р.6. Изучение нейронной сети Хопфилда. Информационная емкость ассоциативной памяти

© 2019 МИЭТ, Нейронные сети |

4 |

|

4 |

Место НС в интеллектуальных системах

© 2019 МИЭТ, Нейронные сети |

5 |

|

5 |

Математические алгоритмы в ИС

•Обработка данных по входу и по выходу

Машинное обучение |

•Группировка и интерпретация данных только по входу

Обучение с учителем |

(управляемое обучение) |

Обучение без учителя |

Классификация |

Регрессия |

Кластеризация |

Логистическая |

Линейная регрессия |

Метод k - средних |

|

классификация |

|||

|

|

||

Метод опорных векторов |

Нелинейная регрессия |

Иерархическая |

|

кластеризация |

|||

|

|

||

Байесовский клас-тор |

Дерево принятия |

Рекуррентные НС |

|

решений |

(сети Хопфилда) |

||

|

|||

Многослойный |

Ансамбли |

Скрытые марковские |

|

перцептрон |

модели (СММ) |

||

|

© 2019 МИЭТ, Нейронные сети |

6 |

|

6 |

Нейронные сети и компьютерные системы

Быстродействие БН на 5 - 6 порядков ниже, чем быстродействие элементов современных ИС:

ИС - 10-9 с (наносекунды); БН - 10-3 с (милисекунды)

Нейронная сеть головного мозга: 1010 нейронов , 60х1012

синаптических связей (Shepperd & Koch, 1990)

Энергетическая эффективность современной ЭВМ,

осуществляющей операции на основе бинарной логики: 10-6 Дж на операцию в секунду

Энергетическая эффективность НС головного мозга:

10-16 Дж на операцию в секунду (Faggin, 1991)

© 2019 МИЭТ, Нейронные сети |

7 |

|

7 |

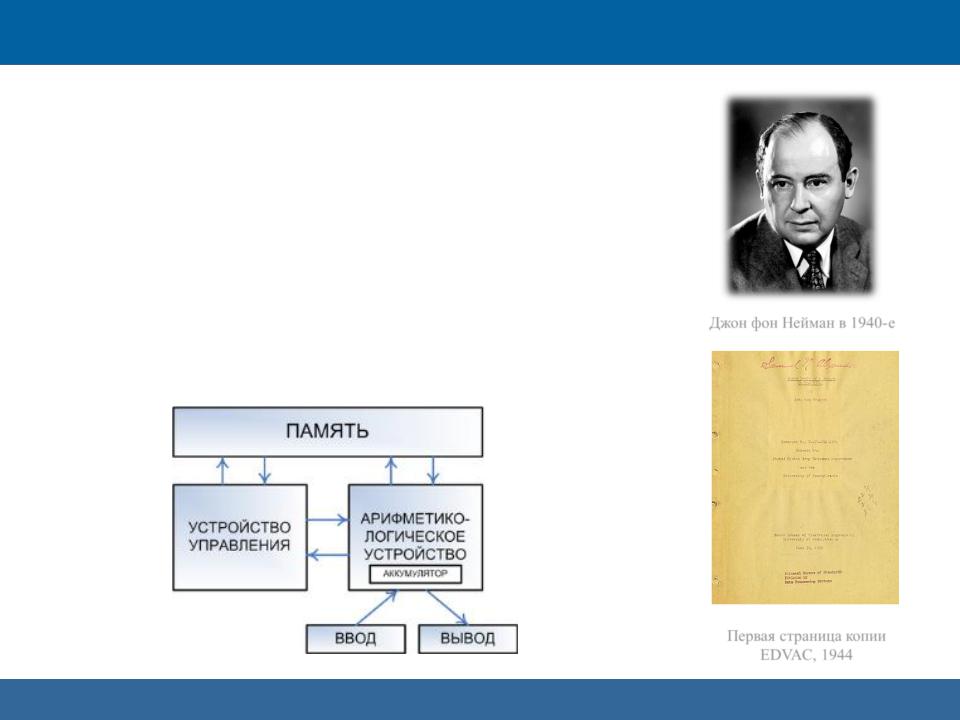

Архитектура ВМ фон Неймана

Джон фон Нейман (1903 - 1957)

Архитектура вычислительных машин фон Неймана

Принцип совместного хранения

команд и данных в памяти компьютераподразумевается принцип хранения данных и инструкций в одной памяти

© 2019 МИЭТ, Нейронные сети

Джон фон Нейман в 1940-е

Первая страница копии

EDVAC, 1944

8

8

Принципы фон Неймана (1/4)

Двоичное кодирование

▪Вся информация, как данные, так и команды,

кодируются двоичными цифрами 0 и 1

▪Каждый тип информации представляется двоичной последовательностью и имеет свой формат

▪Последовательность битов в формате, имеющая определенный смысл, называется полем

▪В числовой информации обычно выделяют поле знака и поле значащих разрядов

▪В формате команды в простейшем случае можно выделить два поля: поле кода операции и поле адресов

© 2019 МИЭТ, Нейронные сети |

9 |

|

9 |

Принципы фон Неймана (2/4)

Принцип однородности памяти

▪Команды и данные хранятся в одной и той же памяти и внешне в памяти неразличимы

▪Распознать их можно только по способу использования

▪Над командами можно производить те же операции, что и над числами

▪Команды одной программы могут быть получены как результат исполнения другой программы

▪Эта возможность лежит в основе трансляции — перевода текста программы с языка высокого уровня на язык конкретной вычислительной машины

© 2019 МИЭТ, Нейронные сети |

10 |

|

10 |